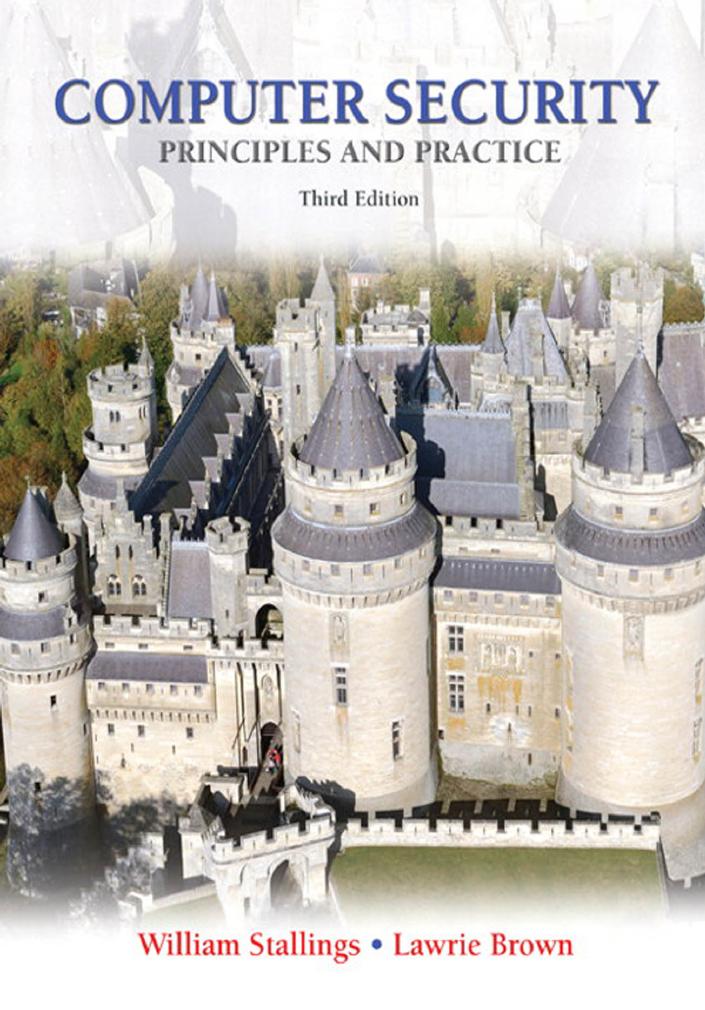

C

omputer

S

eCurity

P

rinciPles

and

P

ractice

Third Edition

William Stallings

Lawrie Brown

UNSW Canberra at the Australian Defence Force Academy

Boston Columbus Indianapolis New York San Francisco Upper Saddle River

Amsterdam Cape Town Dubai London Madrid Milan Munich Paris Montreal Toronto

Delhi Mexico City São Paulo Sydney Hong Kong Seoul Singapore Taipei Tokyo

Library of Congress Cataloging-in-Publication Data

Stallings, William, author.

Computer security : principles and practice / William Stallings, Lawrie Brown, University of New South Wales,

Australian Defence Force Academy. — Third edition.

pages cm

ISBN 978-0-13-377392-7 — ISBN 0-13-377392-2

1. Computer security. 2. Computer security—Examinations—Study guides. 3. Computer networks—Security

measures—Examinations—Study guides. 4. Electronic data processing personnel—Certification—Study guides.

I. Brown, Lawrie, author. II. Title.

QA76.9.A25S685 2014

005.8—dc23

2014012092

10 9 8 7 6 5 4 3 2 1

ISBN-10: 0-13-377392-2

ISBN-13: 978-0-13-377392-7

Editorial Director, ECS: Marcia Horton

Executive Editor: Tracy Johnson (Dunkelberger)

Editorial Assistant: Kelsey Loanes

Director of Marketing: Christy Lesko

Marketing Manager: Yez Alayan

Marketing Assistant: Jon Bryant

Director of Program Management: Erin Gregg

Program Management – Team Lead: Scott Disanno

Program Manager: Carole Snyder

Project Manager: Robert Engelhardt

Procurement Specialist: Linda Sager

Cover Designer: Marta Samsel

Managing Project Editor: Dr. Priyadharshini

Dhanagopal

Production Project Manager: Jennifer Sargunar

Permissions Supervisor: Rachel Youdelman

Permissions Administrator: William Opaluch

Cover Art: © Arnaud Chicurel/Hemis/Corbis

Associate Web Developer: Barry Offringa

Full-Service Project Management:

Mahalatchoumy Saravanan, Jouve India

Credits and acknowledgments borrowed from other sources and reproduced, with permission, in this textbook

appear on page 815.

Copyright © 2015, 2012, 2008 by Pearson Education, Inc. All rights reserved. Printed in the United States of

America. This publication is protected by copyright, and permission should be obtained from the publisher

prior to any prohibited reproduction, storage in a retrieval system, or transmission in any form or by any means,

electronic, mechanical, photocopying, recording, or likewise. To obtain permission(s) to use material from this

work, please submit a written request to Pearson Education, Inc., Permissions Department, One Lake Street,

Upper Saddle River, New Jersey 07458, or you may fax your request to 201-236-3290.

Many of the designations by manufacturers and sellers to distinguish their products are claimed as trademarks.

Where those designations appear in this book, and the publisher was aware of a trademark claim, the designations

have been printed in initial caps or all caps.

For my loving wife, Tricia

—WS

To my extended family, who helped

make this all possible

—LB

C

ontentS

v

Chapter 0 Reader’s and Instructor’s Guide 1

A Roadmap for Readers and Instructors 2

Support for CISSP Certification 3

Support for NSA/DHS Certification 5

Support for ACM/IEEE Computer Society Computer Science Curricula 2013 6

Threats, Attacks, and Assets 19

Security Functional Requirements 25

Fundamental Security Design Principles 27

Attack Surfaces and Attack Trees 31

Key Terms, Review Questions, and Problems 37

Part One COmPuter SeCurity teChnOlOgy and PrinCiPleS 40

Chapter 2 Cryptographic Tools 40

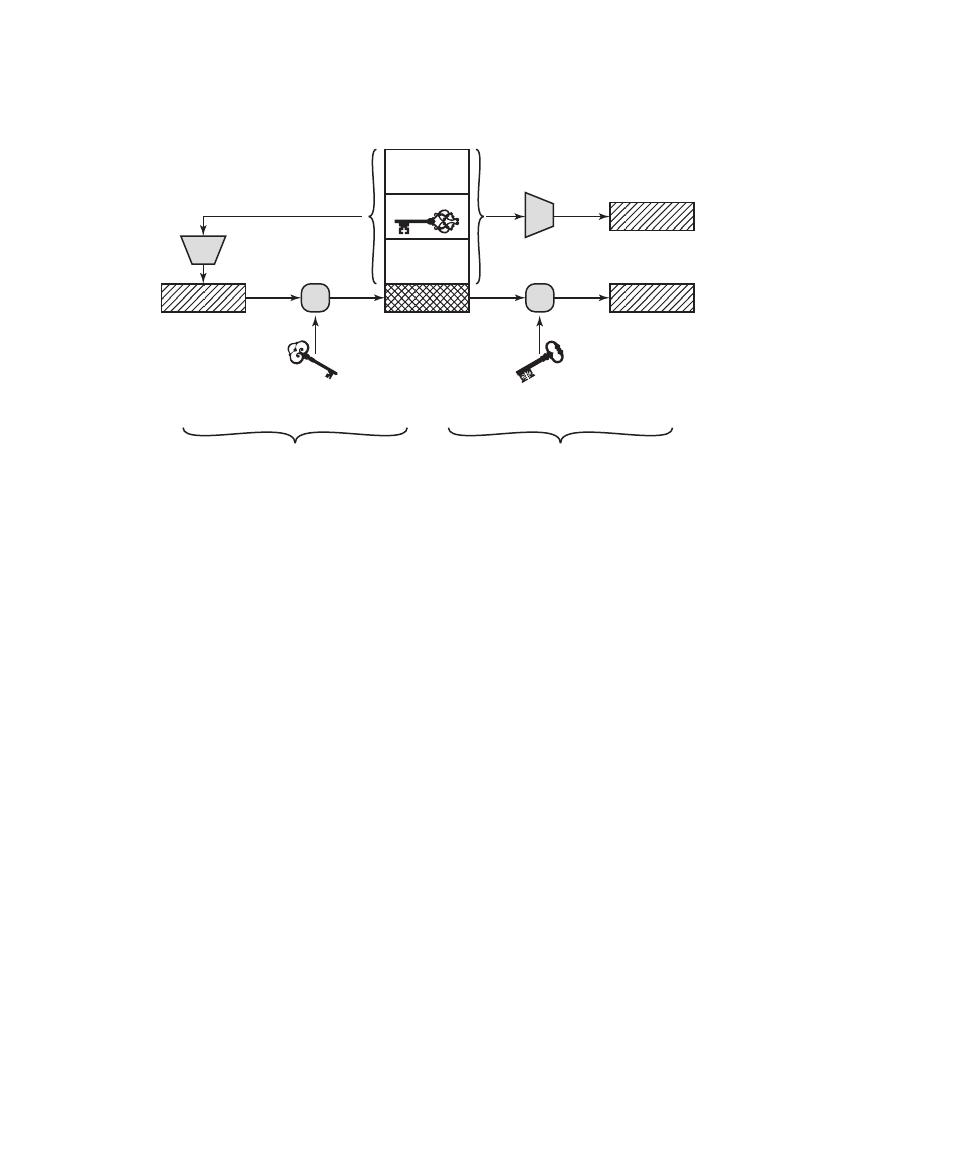

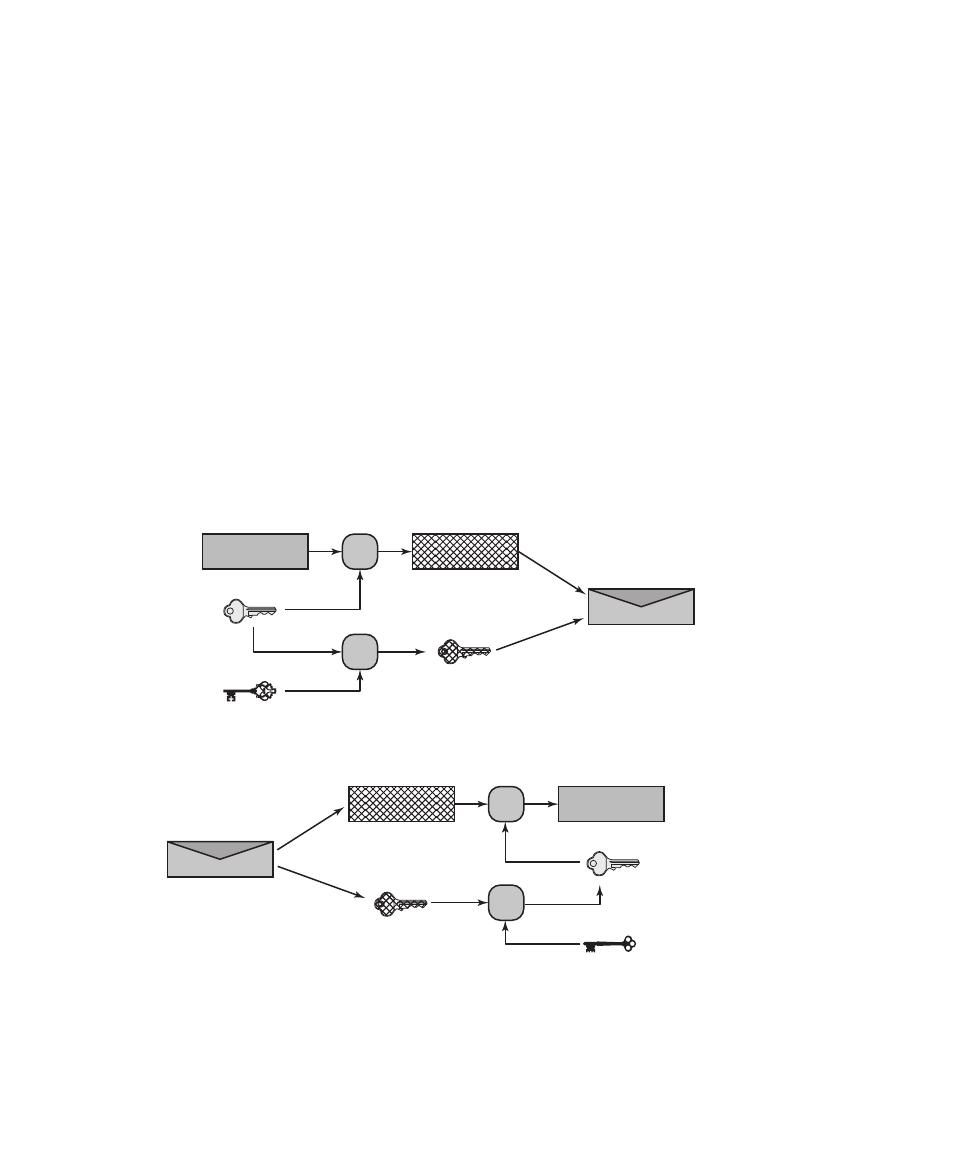

Confidentiality with Symmetric Encryption 41

Message Authentication and Hash Functions 47

Digital Signatures and Key Management 60

Random and Pseudorandom Numbers 64

Practical Application: Encryption of Stored Data 66

Key Terms, Review Questions, and Problems 68

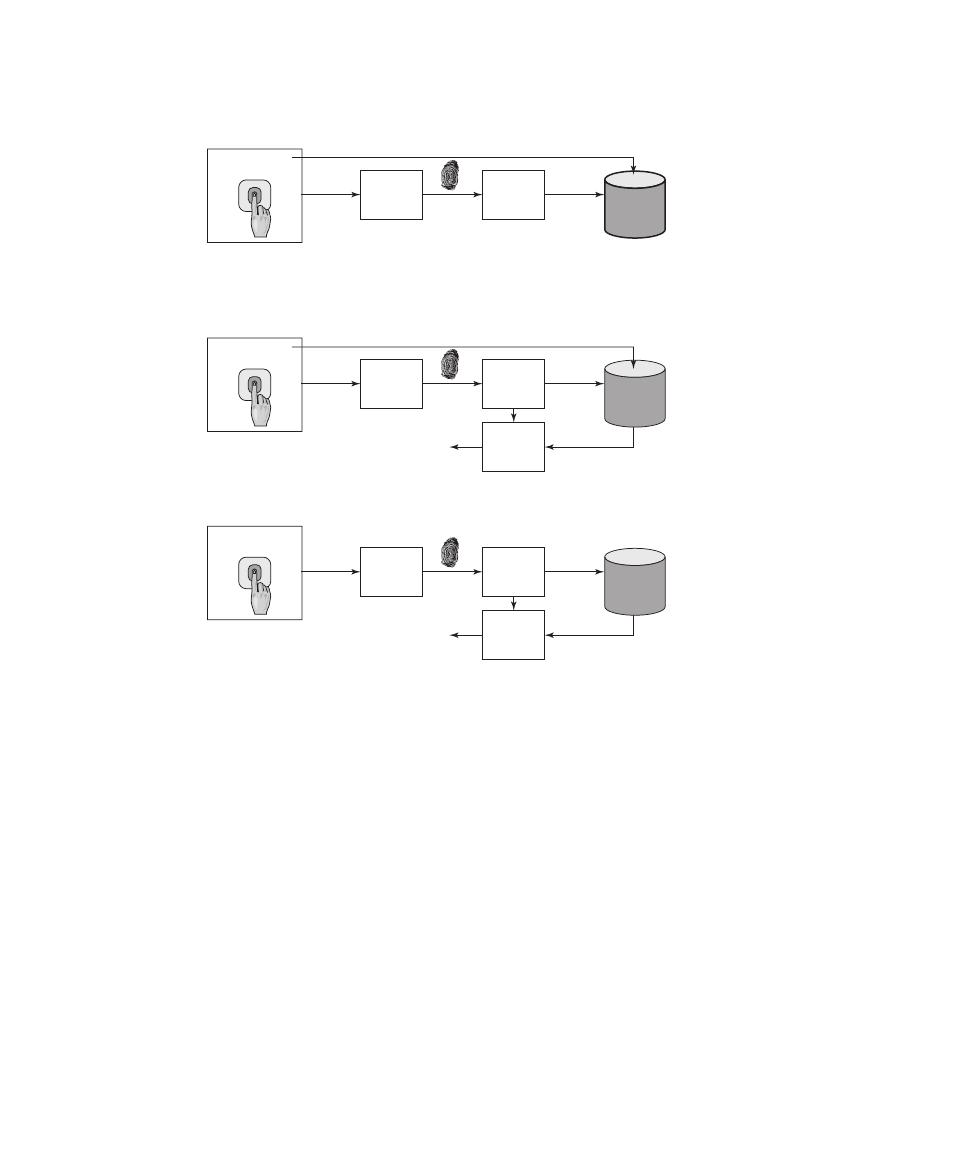

Chapter 3 User Authentication 72

Electronic User Authentication Principles 74

Password-Based Authentication 78

vi

Contents

Security Issues for User Authentication 103

Practical Application: An Iris Biometric System 105

Case Study: Security Problems for ATM Systems 107

Key Terms, Review Questions, and Problems 110

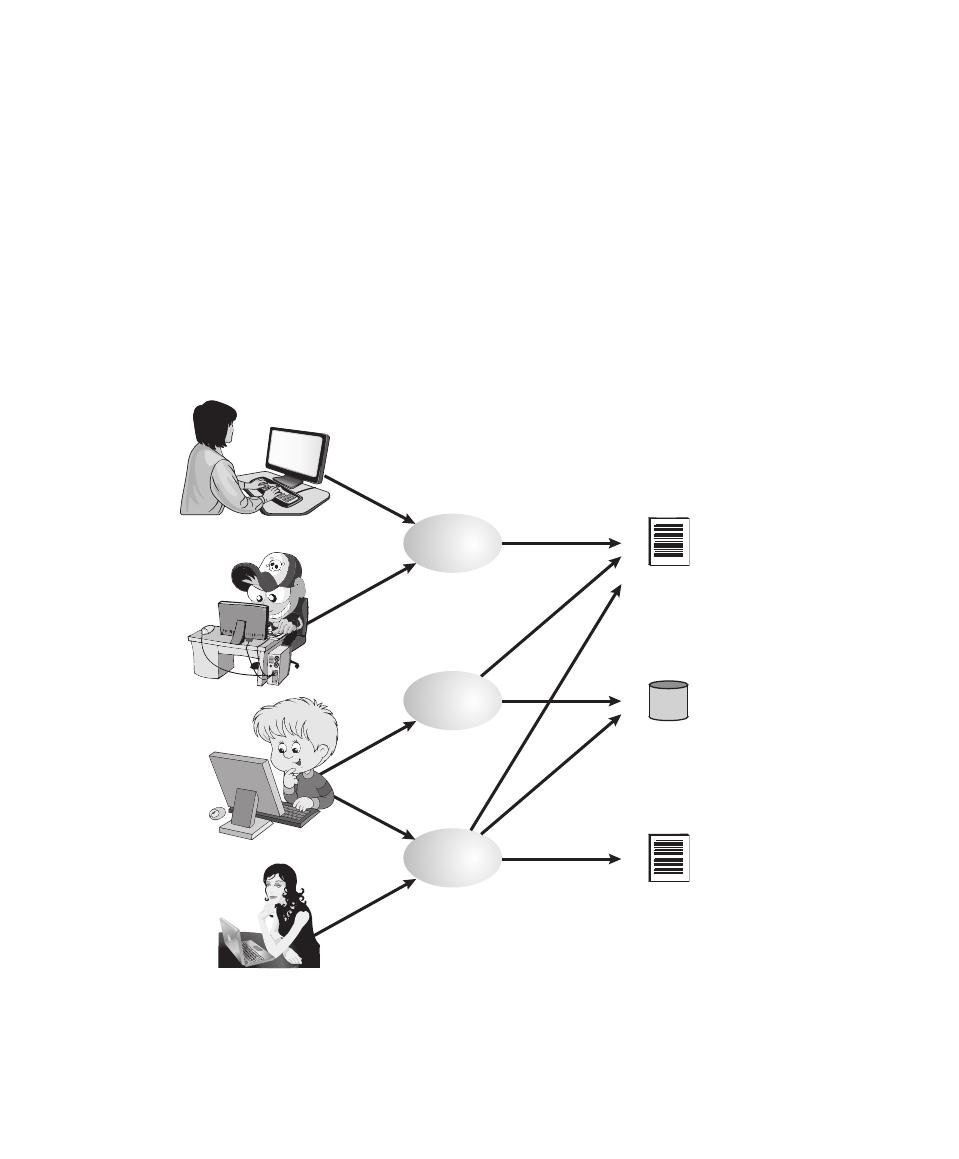

Subjects, Objects, and Access Rights 117

Discretionary Access Control 118

Example: UNIX File Access Control 124

Attribute-Based Access Control 133

Identity, Credential, and Access Management 139

Case Study: RBAC System for a Bank 147

Key Terms, Review Questions, and Problems 151

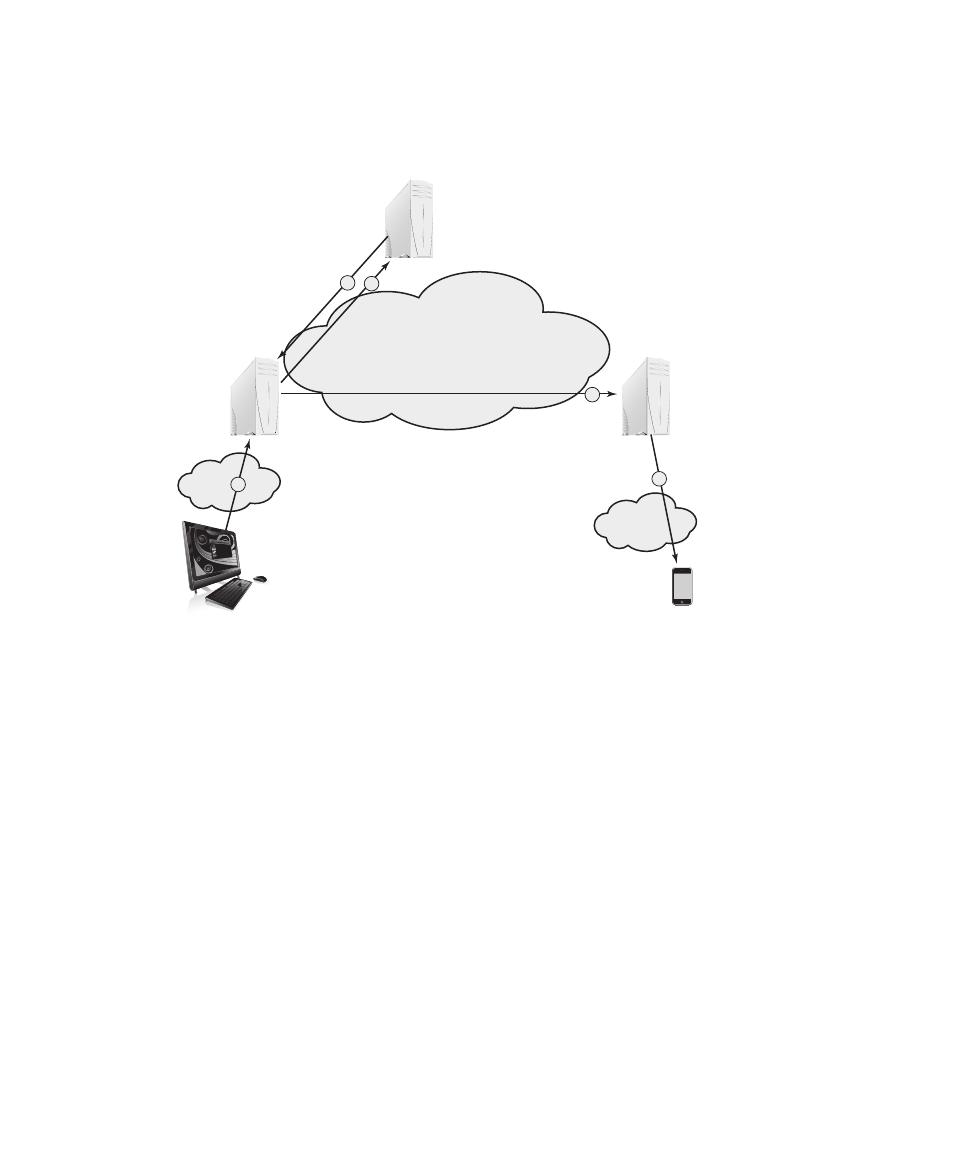

Chapter 5 Database and Cloud Security 155

The Need for Database Security 156

Database Management Systems 157

Cloud Security Risks and Countermeasures 187

Data Protection in the Cloud 189

Cloud Security as a Service 189

Key Terms, Review Questions, and Problems 194

Chapter 6 Malicious Software 199

Types of Malicious Software (Malware) 200

Advanced Persistent Threat 203

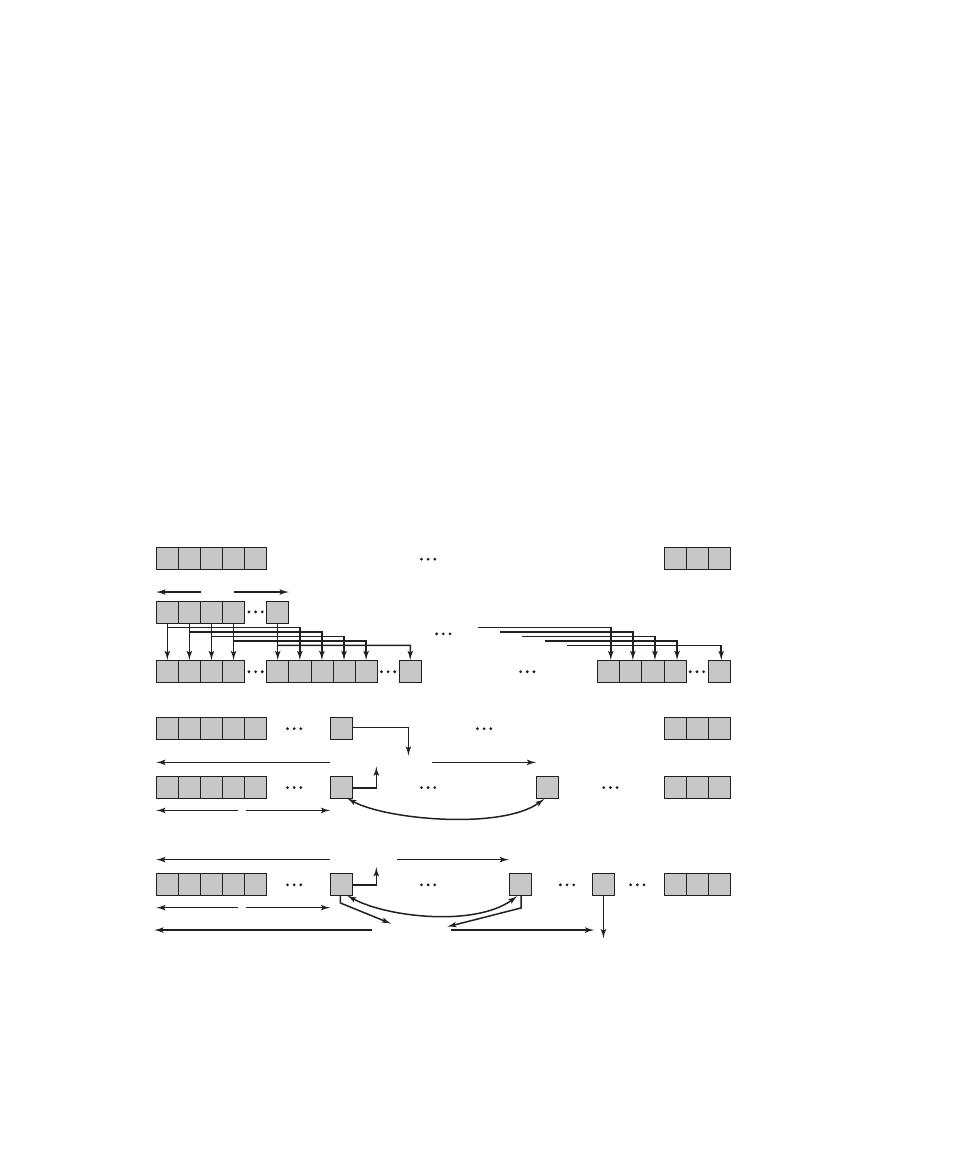

Propagation—Infected Content—Viruses 204

Propagation—Vulnerability Exploit—Worms 210

Propagation—Social Engineering—Spam E-Mail, Trojans 218

Payload—Attack Agent—Zombie, Bots 222

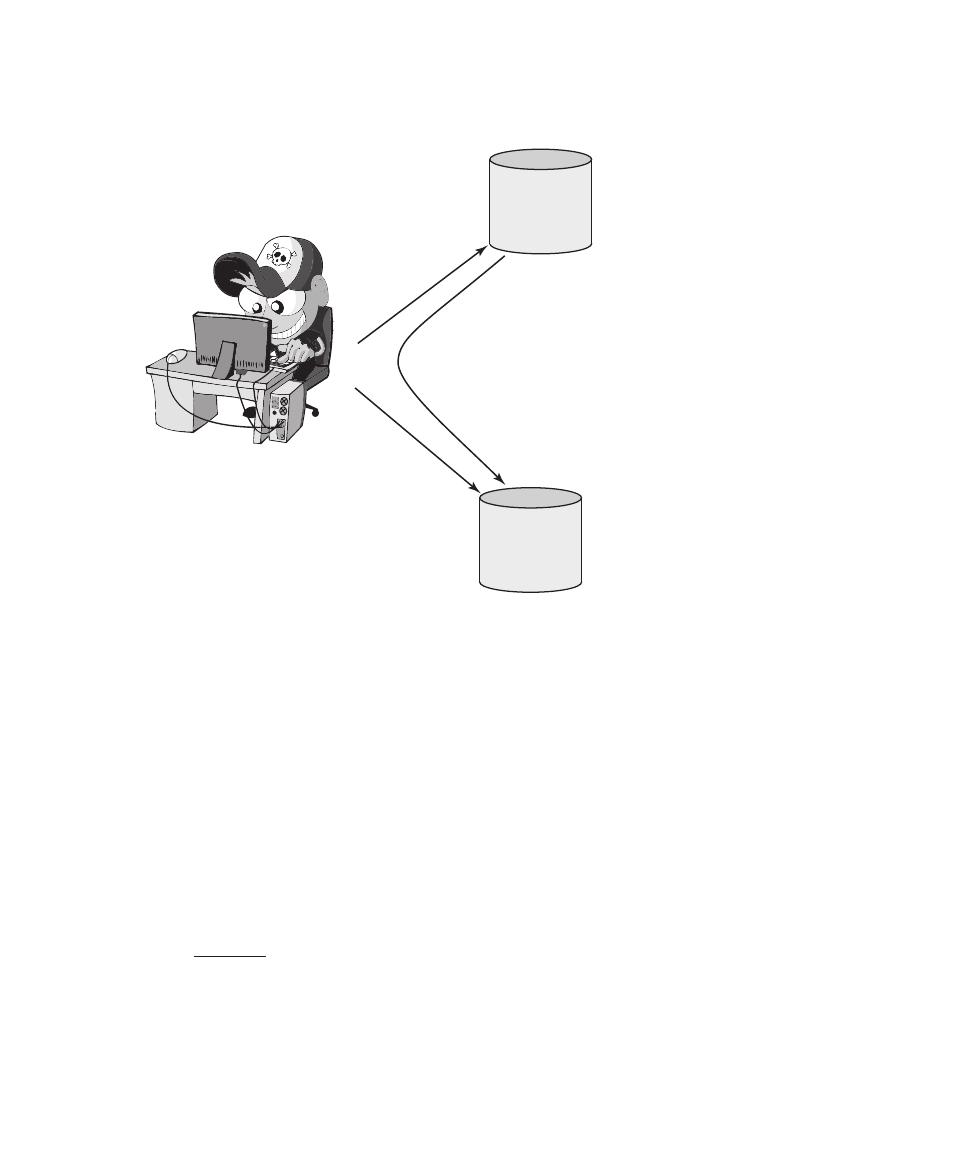

Payload—Information Theft—Keyloggers, Phishing, Spyware 224

Payload—Stealthing—Backdoors, Rootkits 226

Contents

vii

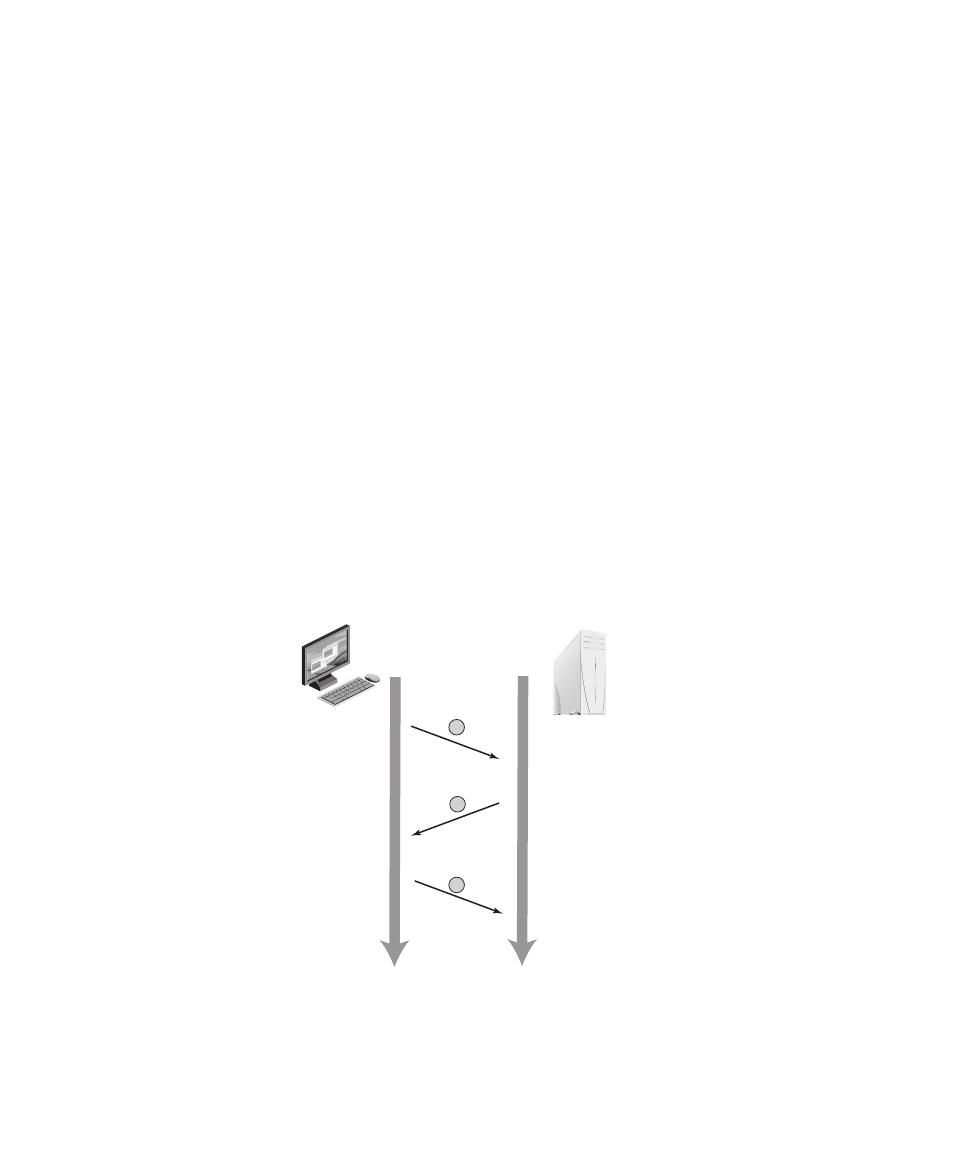

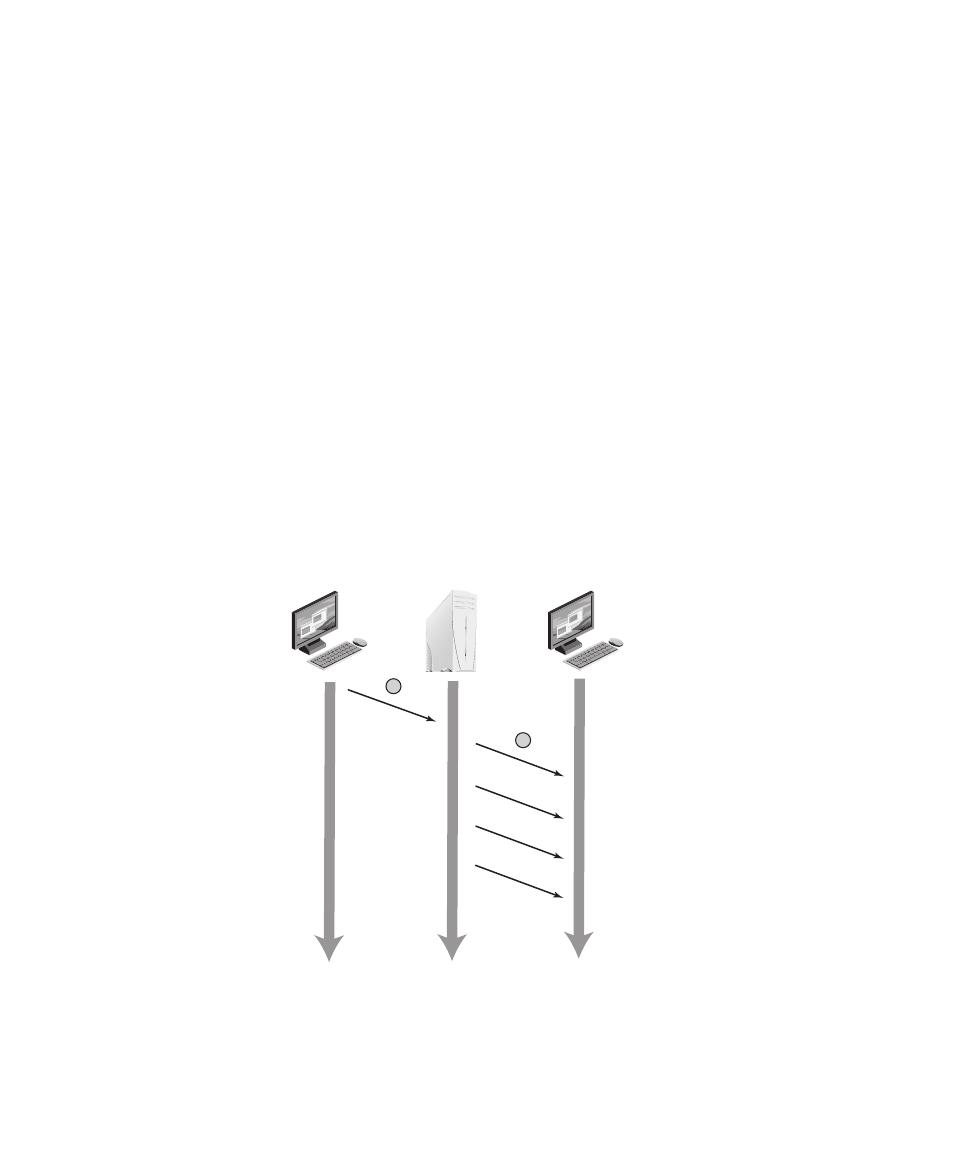

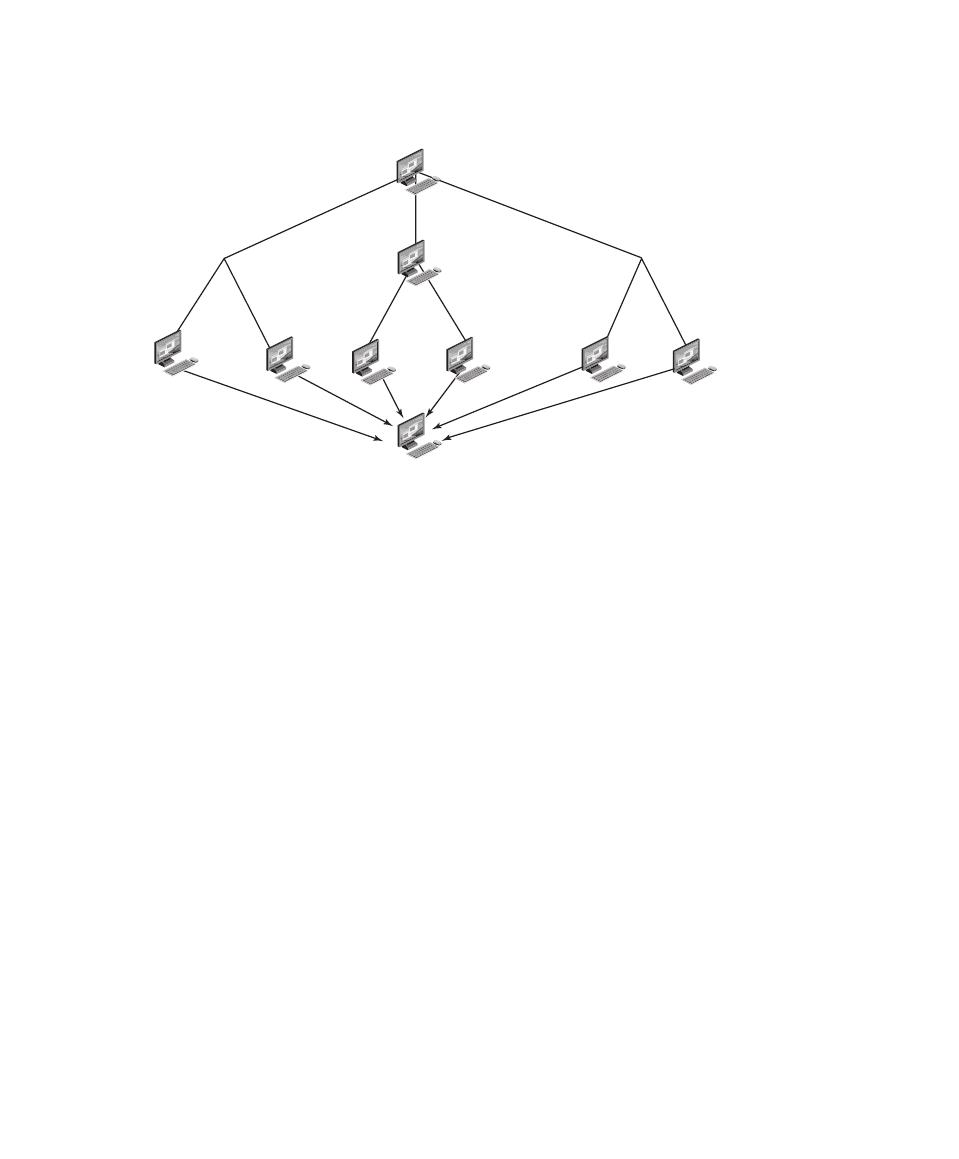

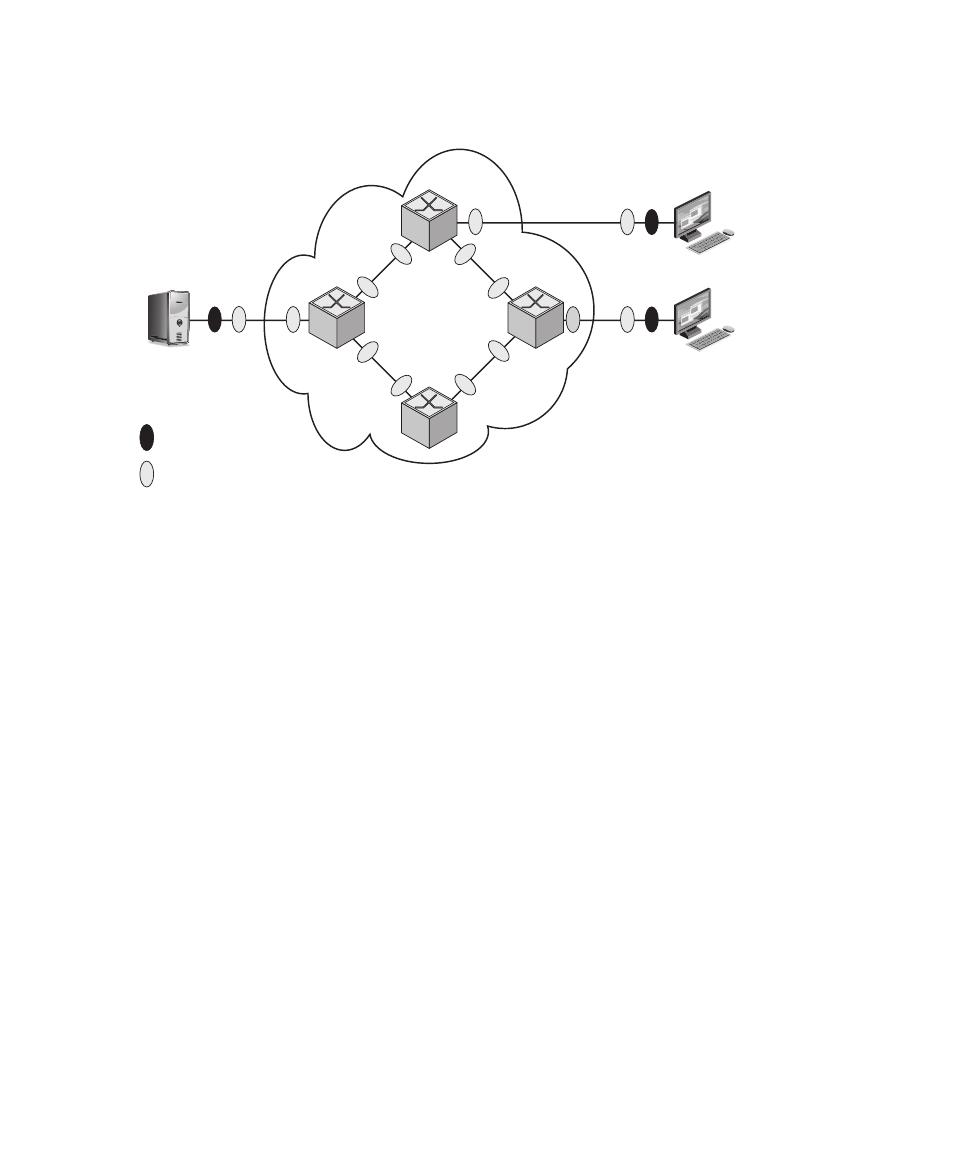

Chapter 7 Denial-of-Service Attacks 240

Distributed Denial-of-Service Attacks 250

Application-Based Bandwidth Attacks 252

Reflector and Amplifier Attacks 254

Defenses Against Denial-of-Service Attacks 259

Responding to a Denial-of-Service Attack 263

Key Terms, Review Questions, and Problems 264

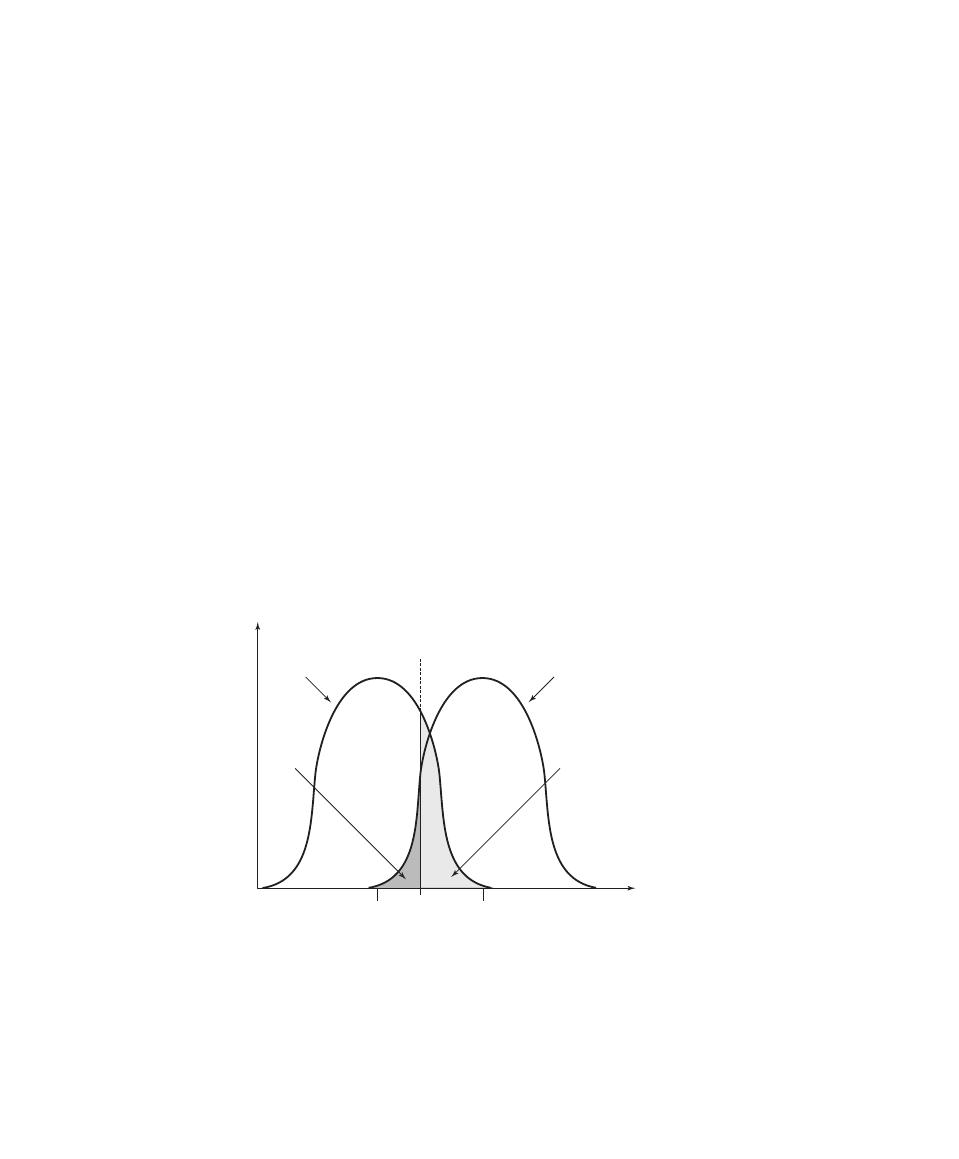

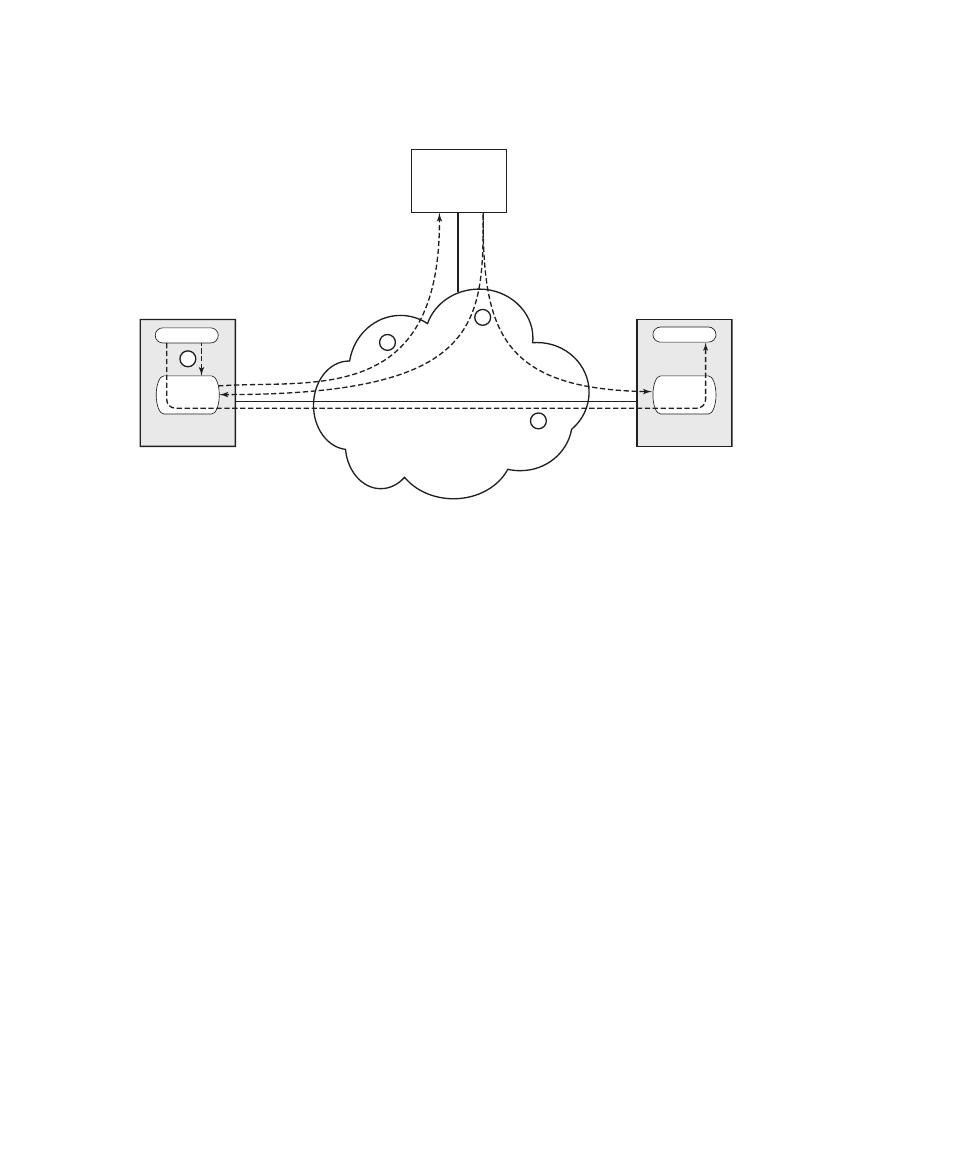

Chapter 8 Intrusion Detection 267

Host-Based Intrusion Detection 278

Network-Based Intrusion Detection 283

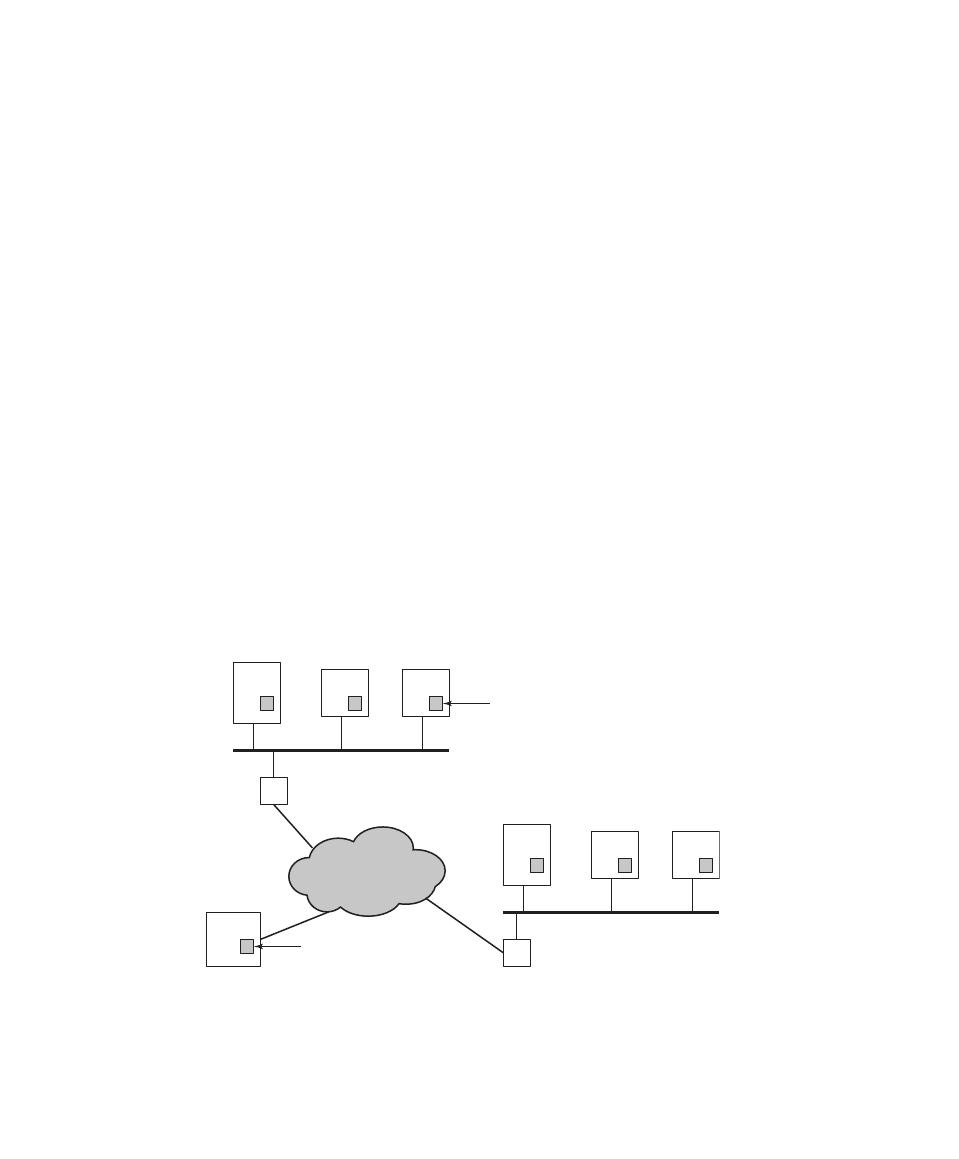

Distributed or Hybrid Intrusion Detection 289

Intrusion Detection Exchange Format 291

Key Terms, Review Questions, and Problems 300

Chapter 9 Firewalls and Intrusion Prevention Systems 304

Firewall Characteristics and Access Policy 306

Firewall Location and Configurations 317

Intrusion Prevention Systems 322

Example: Unified Threat Management Products 326

Key Terms, Review Questions, and Problems 331

Part twO SOftware SeCurity and truSted SyStemS 336

Chapter 10 Buffer Overflow 336

Defending Against Buffer Overflows 359

Other Forms of Overflow Attacks 365

Key Terms, Review Questions, and Problems 372

Chapter 11 Software Security 375

viii

Contents

Interacting with the Operating System and Other Programs 396

Key Terms, Review Questions, and Problems 412

Chapter 12 Operating System Security 416

Introduction to Operating System Security 418

Operating Systems Hardening 419

Key Terms, Review Questions, and Problems 437

Chapter 13 Trusted Computing and Multilevel Security 439

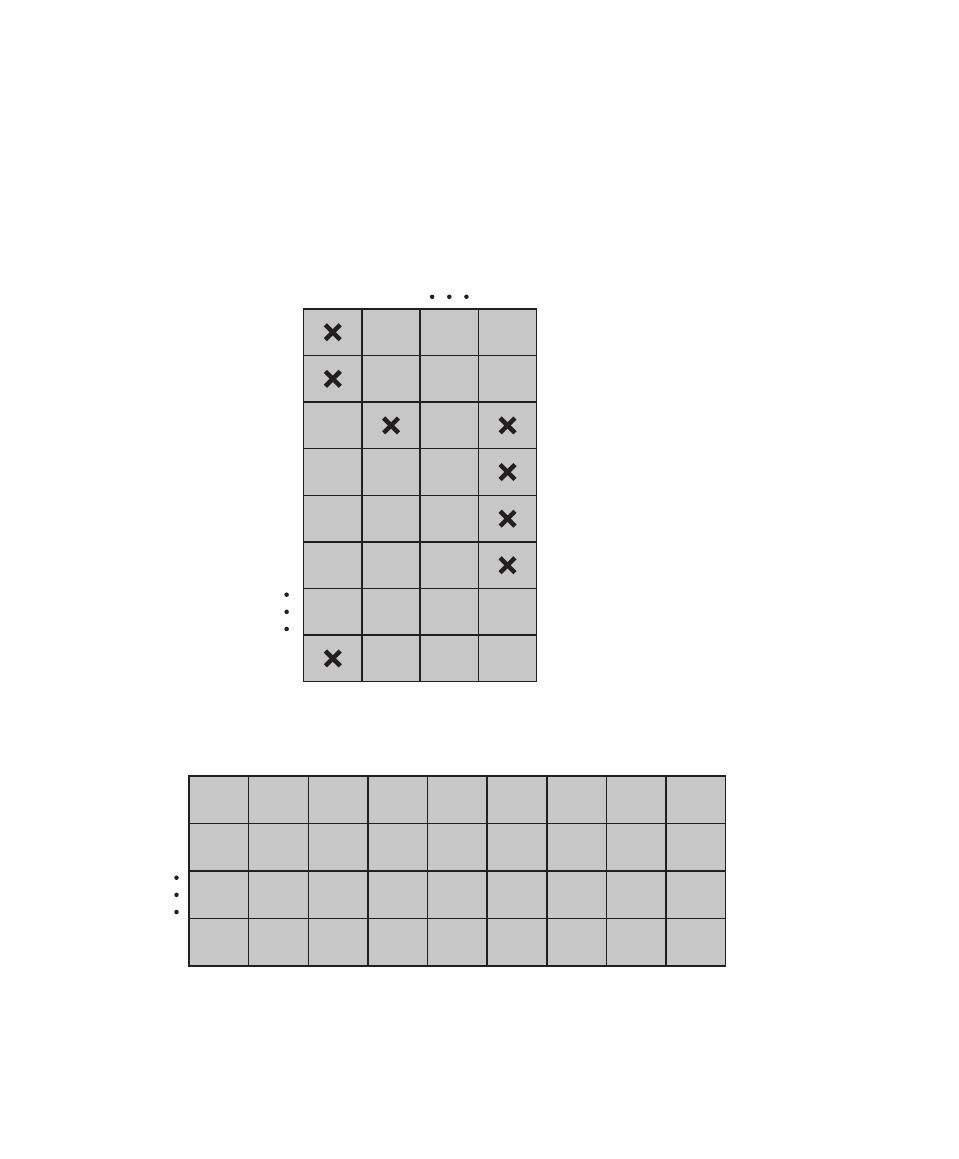

The Bell-LaPadula Model for Computer Security 440

Other Formal Models for Computer Security 450

The Concept of Trusted Systems 456

Application of Multilevel Security 459

Trusted Computing and the Trusted Platform Module 465

Common Criteria for Information Technology Security Evaluation 469

Key Terms, Review Questions, and Problems 481

Part three management iSSueS 485

Chapter 14 IT Security Management and Risk Assessment 485

Organizational Context and Security Policy 489

Detailed Security Risk Analysis 495

Case Study: Silver Star Mines 507

Key Terms, Review Questions, and Problems 513

Chapter 15 IT Security Controls, Plans, and Procedures 515

IT Security Management Implementation 516

Security Controls or Safeguards 516

Implementation of Controls 525

Case Study: Silver Star Mines 529

Contents

ix

Chapter 16 Physical and Infrastructure Security 534

Physical Security Prevention and Mitigation Measures 543

Recovery From Physical Security Breaches 546

Example: A Corporate Physical Security Policy 546

Integration of Physical and Logical Security 547

Key Terms, Review Questions, and Problems 554

Chapter 17 Human Resources Security 556

Security Awareness, Training, and Education 557

Employment Practices and Policies 563

E-Mail and Internet Use Policies 566

Computer Security Incident Response Teams 567

Key Terms, Review Questions, and Problems 575

Chapter 18 Security Auditing 577

Security Auditing Architecture 579

Implementing the Logging Function 588

Example: An Integrated Approach 604

Key Terms, Review Questions, and Problems 608

Chapter 19 Legal and Ethical Aspects 610

Cybercrime and Computer Crime 611

Key Terms, Review Questions, and Problems 634

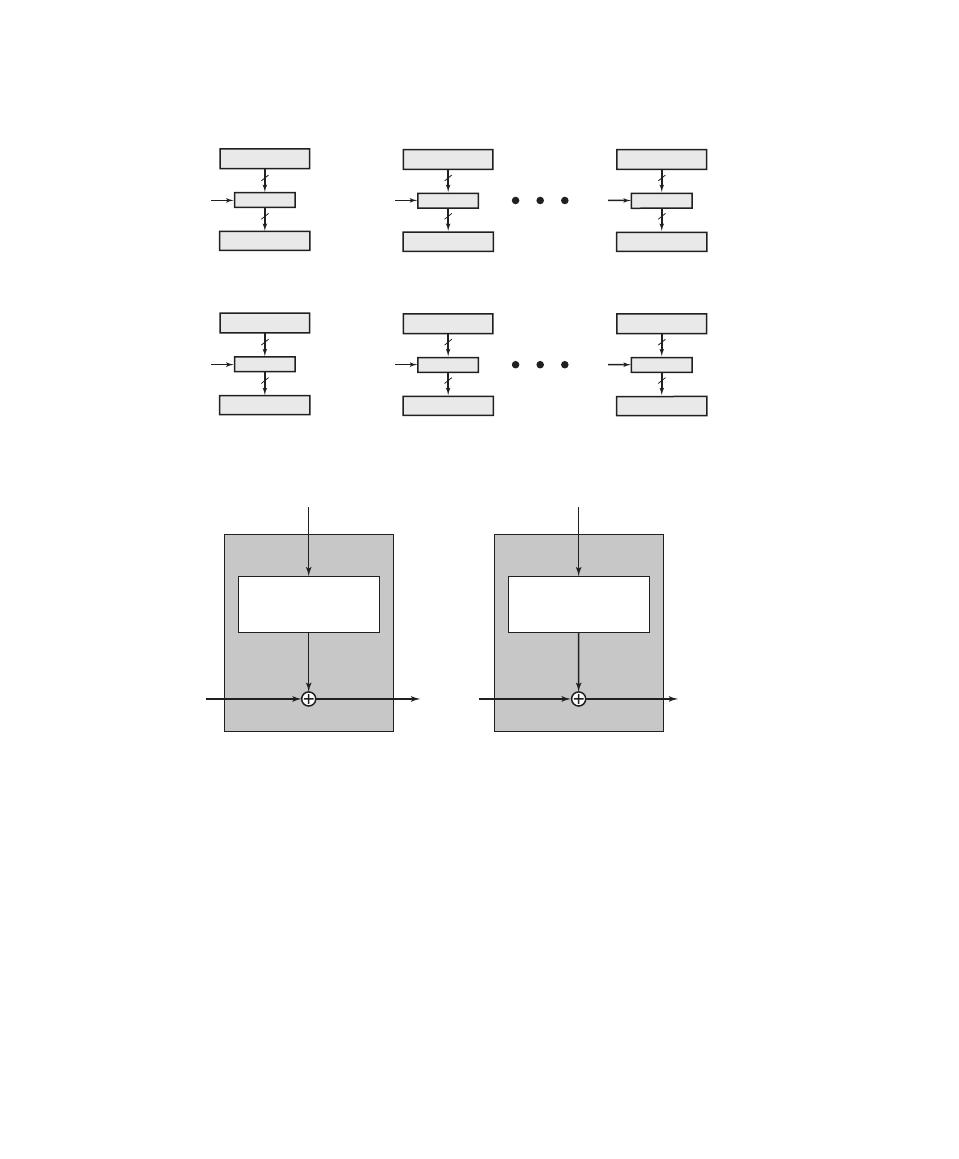

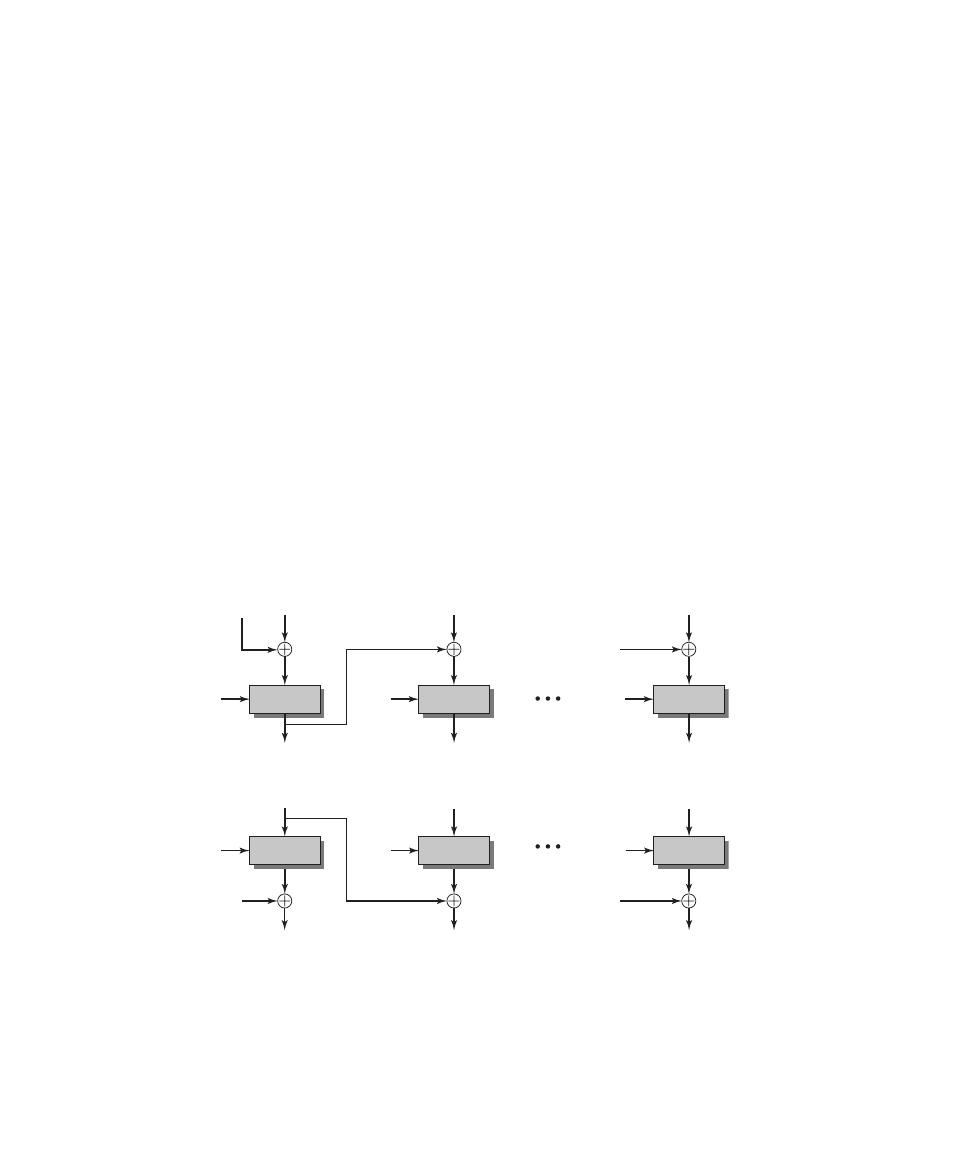

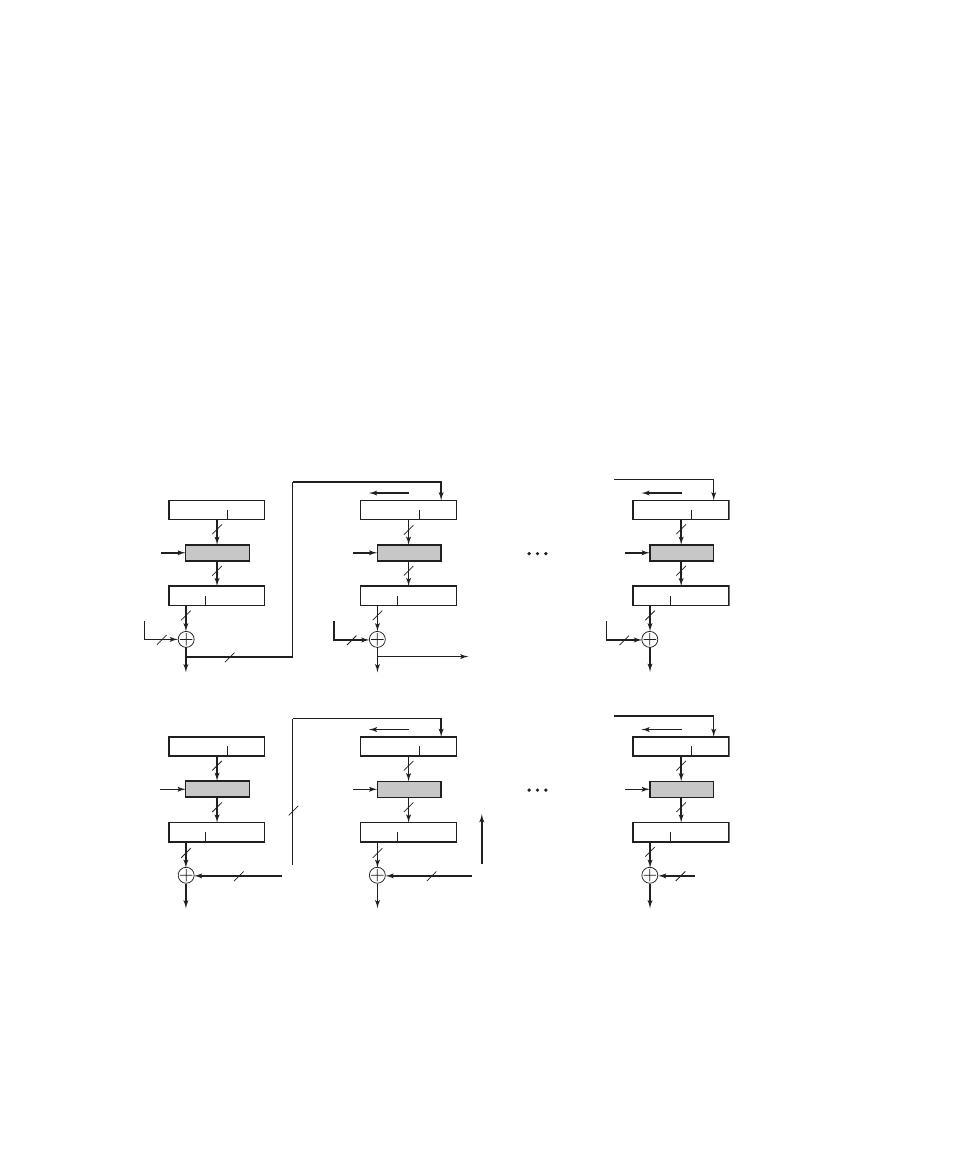

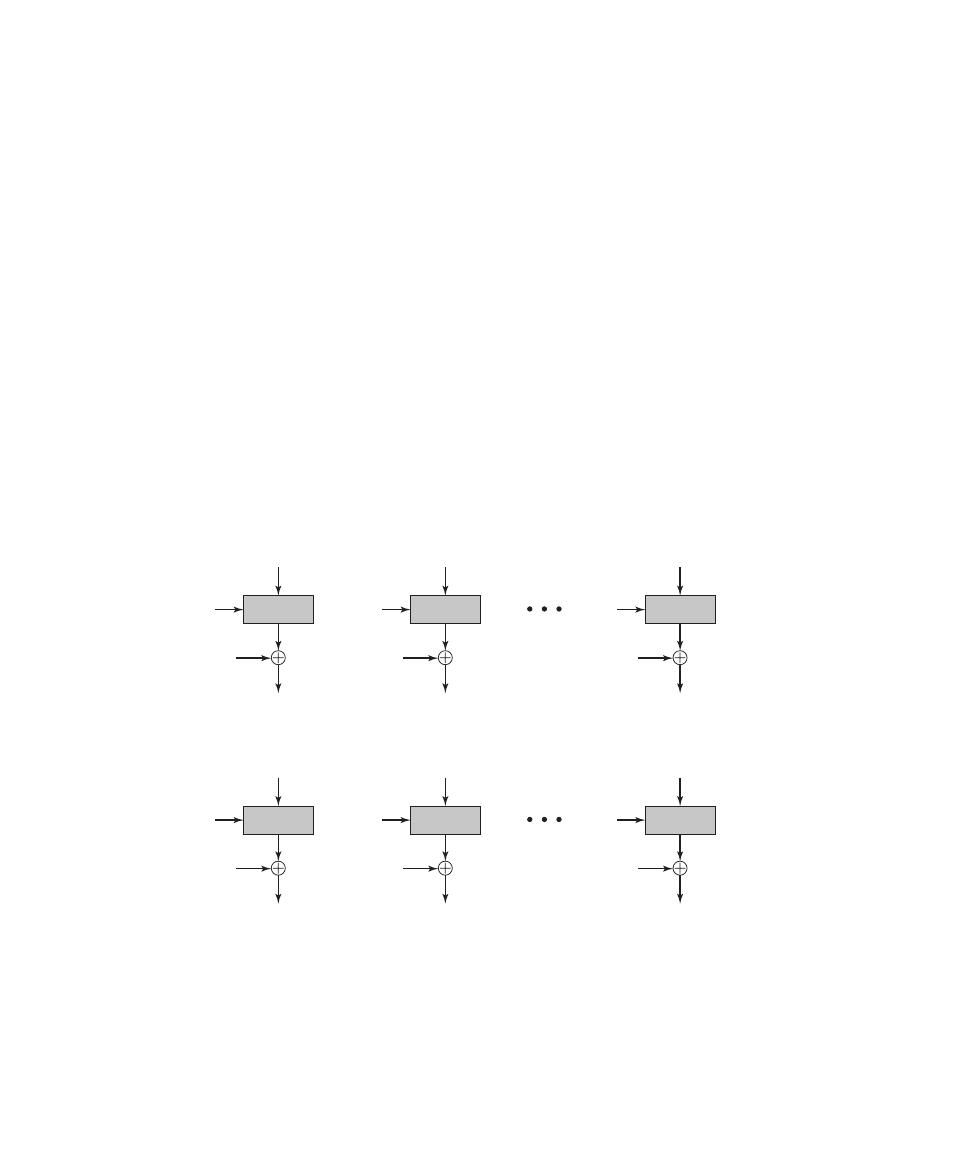

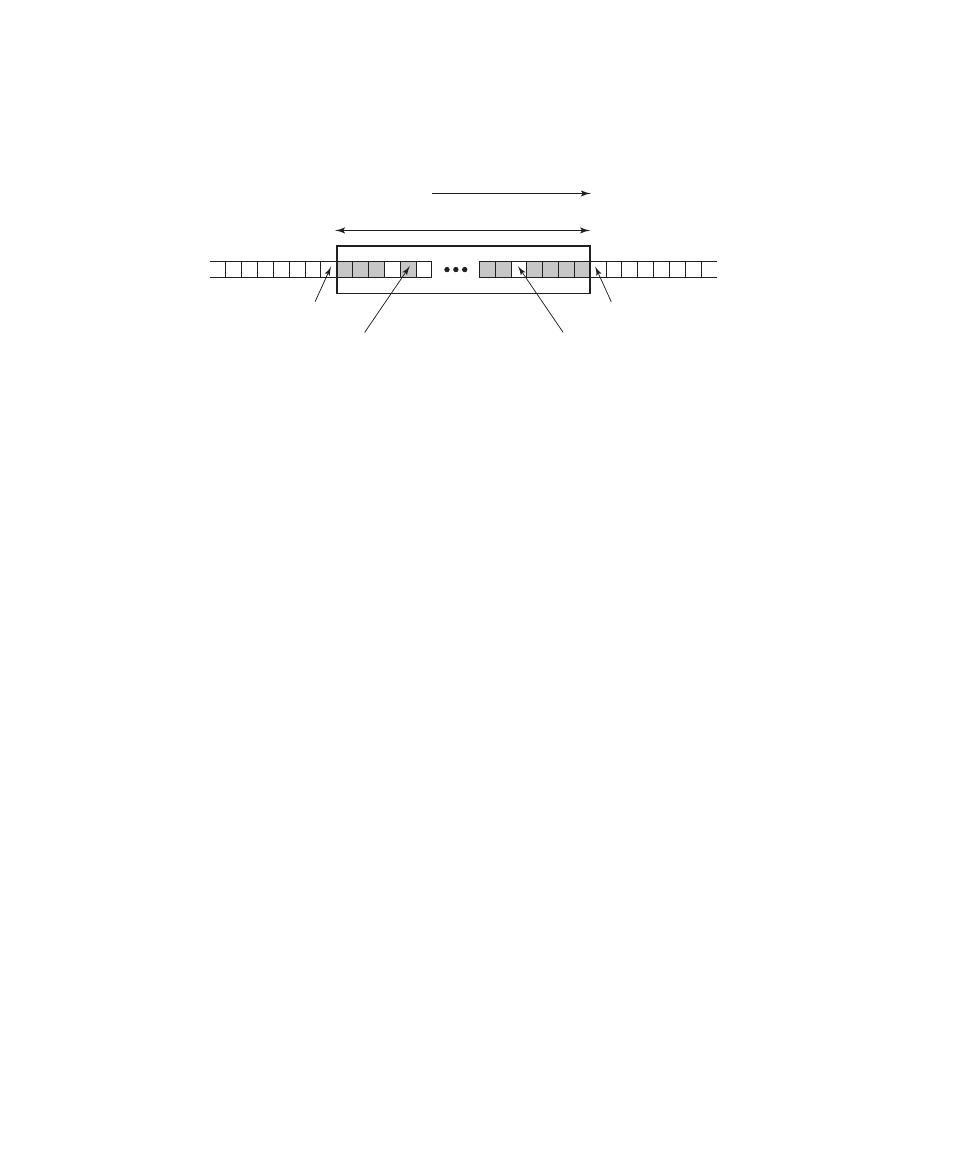

Symmetric Encryption Principles 638

Advanced Encryption Standard 645

Cipher Block Modes of Operation 655

Location of Symmetric Encryption Devices 660

x

Contents

Chapter 21 Public-Key Cryptography and Message Authentication 669

The RSA Public-Key Encryption Algorithm 679

Diffie-Hellman and Other Asymmetric Algorithms 684

Key Terms, Review Questions, and Problems 689

Part five netwOrk SeCurity 693

Chapter 22 Internet Security Protocols and Standards 693

DomainKeys Identified Mail 697

Secure Sockets Layer (SSL) and Transport Layer Security (TLS) 700

Key Terms, Review Questions, and Problems 714

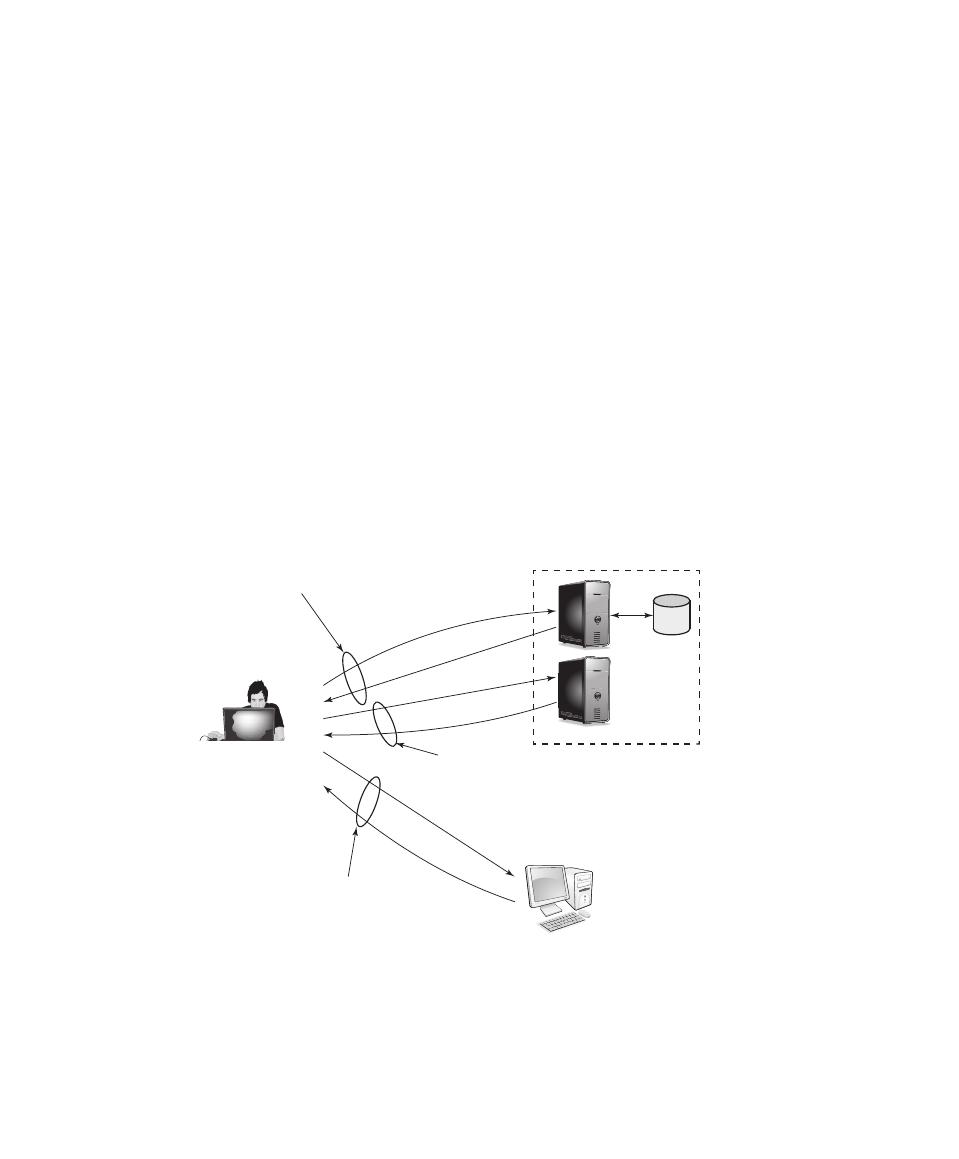

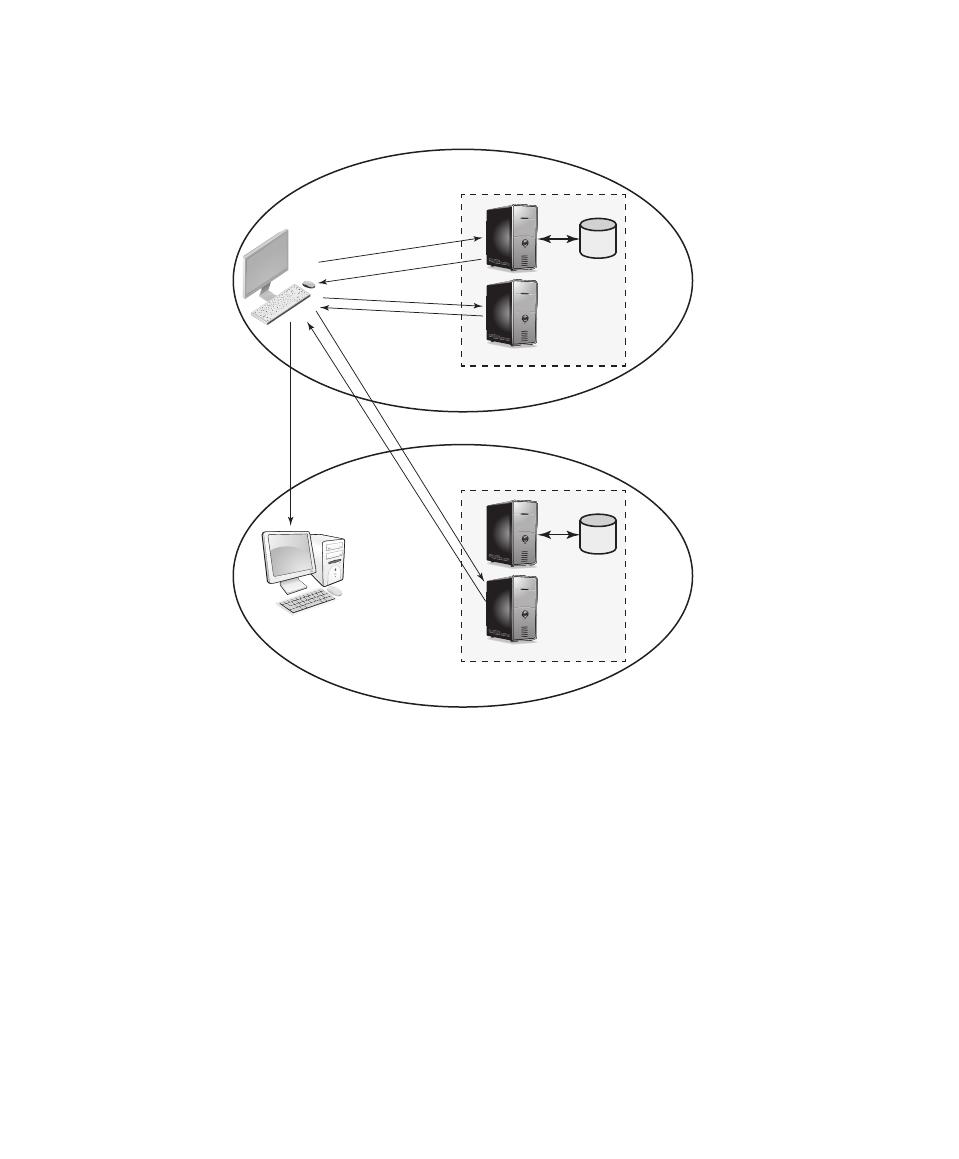

Chapter 23 Internet Authentication Applications 717

Key Terms, Review Questions, and Problems 730

Chapter 24 Wireless Network Security 733

IEEE 802.11 Wireless LAN Overview 741

IEEE 802.11i Wireless LAN Security 747

Key Terms, Review Questions, and Problems 763

Appendix A Projects and Other Student Exercises for Teaching Computer Security 765

Security Education (SEED) Projects 766

Practical Security Assessments 769

Reading/Report Assignments 770

Online ChaPterS and aPPendiCeS

1

Chapter 25 Linux Security

25.1

Introduction

25.2

Linux’s Security Model

25.3

The Linux DAC in Depth: Filesystem Security

25.4

Linux Vulnerabilities

25.5

Linux System Hardening

25.6

Application Security

25.7

Mandatory Access Controls

25.8

Recommended Reading

25.9

Key Terms, Review Questions, and Problems

Chapter 26 Windows and Windows Vista Security

26.1

Windows Security Architecture

26.2

Windows Vulnerabilities

26.3

Windows Security Defenses

26.4

Browser Defenses

26.5

Cryptographic Services

26.6

Common Criteria

26.7

Recommended Reading

26.8

Key Terms, Review Questions, Problems, and Projects

Appendix B Some Aspects of Number Theory

Appendix C Standards and Standard-Setting Organizations

Appendix D Random and Pseudorandom Number Generation

Appendix E Message Authentication Codes Based on Block Ciphers

Appendix F TCP/IP Protocol Architecture

Appendix G Radix-64 Conversion

Appendix H Security Policy-Related Documents

Appendix I The Domain Name System

Appendix J The Base-Rate Fallacy

Appendix K SHA-3

Appendix L Glossary

1

Online chapters, appendices, and other documents are Premium Content, available via the access card at

the front of this book.

Contents

xi

what’S new in the third editiOn

Since the second edition of this book was published, the field has seen continued innovations

and improvements. In this new edition, we try to capture these changes while maintaining a

broad and comprehensive coverage of the entire field. To begin the process of revision, the

second edition of this book was extensively reviewed by a number of professors who teach

the subject and by professionals working in the field. The result is that in many places the

narrative has been clarified and tightened, and illustrations have been improved.

Beyond these refinements to improve pedagogy and user-friendliness, there have

been major substantive changes throughout the book. The most noteworthy changes are as

follows:

•

Fundamental security design principles: Chapter 1 includes a new section discussing the

security design principles listed as fundamental by the National Centers of Academic

Excellence in Information Assurance/Cyber Defense, which is jointly sponsored by the

U.S. National Security Agency and the U.S. Department of Homeland Security.

•

Attack surfaces and attack trees: Chapter 1 includes a new section describing these two

concepts, which are useful in evaluating and classifying security threats.

•

User authentication model: Chapter 3 includes a new description of a general model

for user authentication, which helps to unify the discussion of the various approaches

to user authentication.

•

Attribute-based access control (ABAC): Chapter 4 has a new section devoted to

ABAC, which is becoming increasingly widespread.

•

Identity, credential, and access management (ICAM): Chapter 4 includes a new sec-

tion on ICAM, which is a comprehensive approach to managing and implementing

digital identities (and associated attributes), credentials, and access control.

•

Trust frameworks: Chapter 4 includes a new section on the Open Identity Trust

Framework, which is an open, standardized approach to trustworthy identity and attri-

bute exchange that is becoming increasingly widespread.

•

SQL injection attacks: Chapter 5 includes a new section on the SQL injection attack,

which is one of the most prevalent and dangerous network-based security threats.

•

Cloud security: The material on cloud security in Chapter 5 has been updated and

expanded to reflect its importance and recent developments.

•

Malware: The material on Malware, and on categories of intruders, has been revised to

reflect the latest developments, including details of Advanced Persistent Threats, which

are most likely due to nation state actors.

•

Intrusion detection/intrusion prevention systems: The material on IDS/IPS has been

updated to reflect new developments in the field, including the latest developments in

Host-Based Intrusion Detection Systems that assist in implementing a defense-in-depth

strategy.

xii

PrefaCe

xiii

•

Human resources: Security lapses due to human factors and social engineering are of

increasing concern, including several recent cases of massive data exfiltration by insid-

ers. Addressing such lapses requires a complex mix of procedural and technical con-

trols, which we review in several significantly revised sections.

•

Mobile device security: Mobile device security has become an essential aspect of enter-

prise network security, especially for devices in the category known as bring your own

device (BYOD). A new section in Chapter 24 covers this important topic.

•

SHA-3: This recently adopted cryptographic hash standard is covered in a new

appendix.

BaCkgrOund

Interest in education in computer security and related topics has been growing at a dramatic rate

in recent years. This interest has been spurred by a number of factors, two of which stand out:

1. As information systems, databases, and Internet-based distributed systems and commu-

nication have become pervasive in the commercial world, coupled with the increased

intensity and sophistication of security-related attacks, organizations now recognize

the need for a comprehensive security strategy. This strategy encompasses the use of

specialized hardware and software and trained personnel to meet that need.

2. Computer security education, often termed information security education or informa-

tion assurance

education, has emerged as a national goal in the United States and other

countries, with national defense and homeland security implications. The NSA/DHS

National Center of Academic Excellence in Information Assurance/Cyber Defense is

spearheading a government role in the development of standards for computer secu-

rity education.

Accordingly, the number of courses in universities, community colleges, and other insti-

tutions in computer security and related areas is growing.

OBjeCtiveS

The objective of this book is to provide an up-to-date survey of developments in computer

security. Central problems that confront security designers and security administrators

include defining the threats to computer and network systems, evaluating the relative risks

of these threats, and developing cost-effective and user friendly countermeasures.

The following basic themes unify the discussion:

•

Principles: Although the scope of this book is broad, there are a number of basic prin-

ciples that appear repeatedly as themes and that unify this field. Examples are issues

relating to authentication and access control. The book highlights these principles and

examines their application in specific areas of computer security.

•

Design approaches: The book examines alternative approaches to meeting specific

computer security requirements.

•

Standards: Standards have come to assume an increasingly important, indeed domi-

nant, role in this field. An understanding of the current status and future direction of

technology requires a comprehensive discussion of the related standards.

xiv

PrefaCe

•

Real-world examples: A number of chapters include a section that shows the practical

application of that chapter’s principles in a real-world environment.

SuPPOrt Of aCm/ieee COmPuter SCienCe CurriCula 2013

The book is intended for both an academic and a professional audience. As a textbook, it is

intended as a one- or two-semester undergraduate course for computer science, computer

engineering, and electrical engineering majors. This edition is designed to support the rec-

ommendations of the ACM/IEEE Computer Science Curricula 2013 (CS2013). The CS2013

curriculum recommendation includes, for the first time, Information Assurance and Security

(IAS) as one of the Knowledge Areas in the Computer Science Body of Knowledge. CS2013

divides all course work into three categories: Core-Tier 1 (all topics should be included in the

curriculum), Core-Tier 2 (all or almost all topics should be included), and Elective (desirable

to provide breadth and depth). In the IAS area, CS2013 includes three Tier 1 topics, five Tier

2 topics, and numerous Elective topics, each of which has a number of subtopics. This text

covers all of the Tier 1 and Tier 2 topics and subtopics listed by CS2013, as well as many of

the elective topics.

See Chapter 0 for details of this book’s coverage of CS2013.

COverage Of CiSSP SuBjeCt areaS

This book provides coverage of all the subject areas specified for CISSP (Certified

Information Systems Security Professional) certification. The CISSP designation from

the International Information Systems Security Certification Consortium (ISC)

2

is often

referred to as the ‘gold standard’ when it comes to information security certification. It is

the only universally recognized certification in the security industry. Many organizations,

including the U.S. Department of Defense and many financial institutions, now require that

cyber security personnel have the CISSP certification. In 2004, CISSP became the first IT

program to earn accreditation under the international standard ISO/IEC 17024 (General

Requirements for Bodies Operating Certification of Persons

).

The CISSP examination is based on the Common Body of Knowledge (CBK), a com-

pendium of information security best practices developed and maintained by (ISC)

2

, a

nonprofit organization. The CBK is made up of 10 domains that comprise the body of knowl-

edge that is required for CISSP certification. See Chapter 0 for details of this book’s coverage

of CBK.

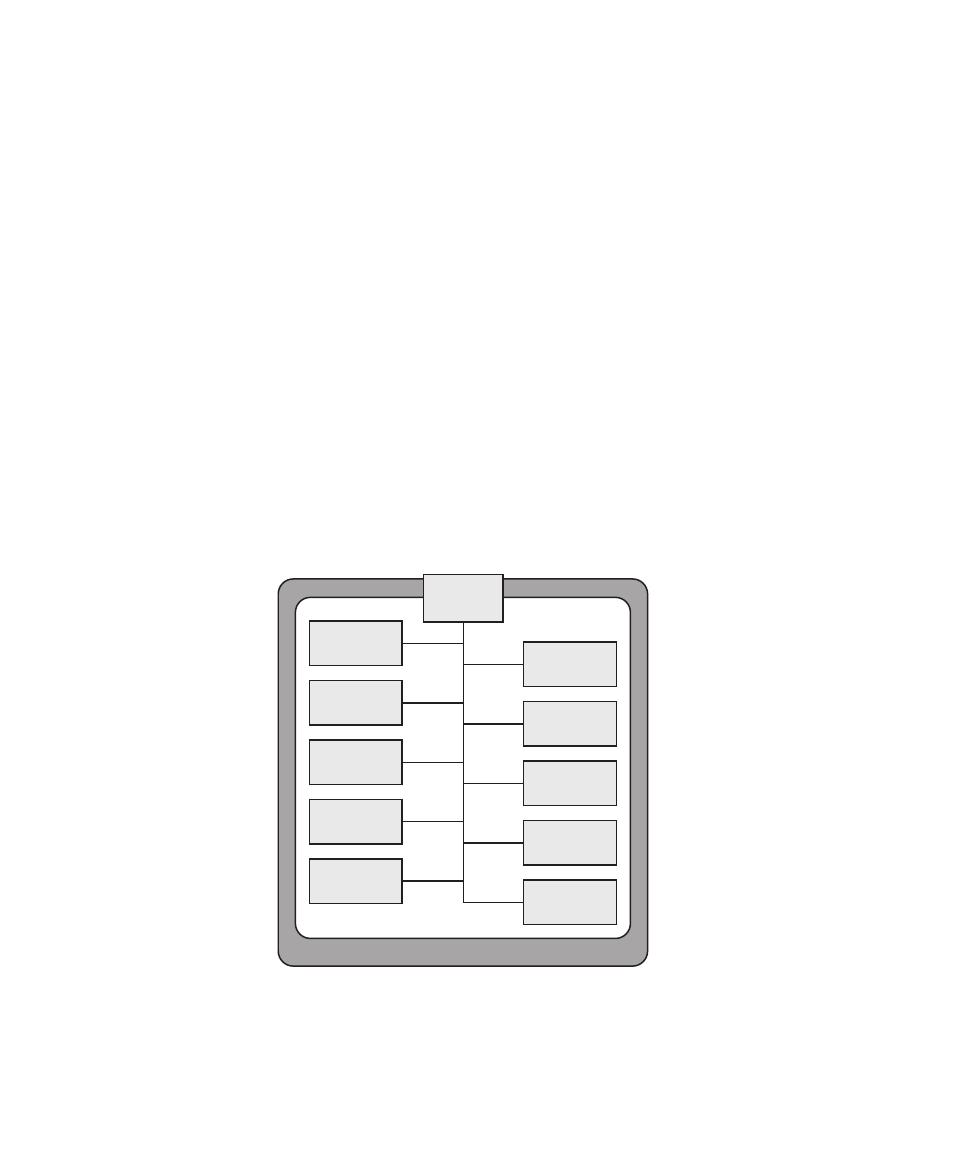

Plan Of the text

The book is divided into five parts (see Chapter 0):

•

Computer Security Technology and Principles

•

Software Security and Trusted Systems

•

Management Issues

•

Cryptographic Algorithms

•

Network Security

The book is also accompanied by a number of online chapters and appendices that

provide more detail on selected topics.

The book includes an extensive glossary, a list of frequently used acronyms, and a bib-

liography. Each chapter includes homework problems, review questions, a list of key words,

and suggestions for further reading.

inStruCtOr SuPPOrt materialS

The major goal of this text is to make it as effective a teaching tool for this exciting and fast-moving

subject as possible. This goal is reflected both in the structure of the book and in the supporting

material. The text is accompanied by the following supplementary material to aid the instructor:

•

Projects manual: Project resources including documents and portable software, plus sug-

gested project assignments for all of the project categories listed in the following section.

•

Solutions manual: Solutions to end-of-chapter Review Questions and Problems.

•

PowerPoint slides: A set of slides covering all chapters, suitable for use in lecturing.

•

PDF files: Reproductions of all figures and tables from the book.

•

Test bank: A chapter-by-chapter set of questions.

•

Sample syllabuses: The text contains more material than can be conveniently covered

in one semester. Accordingly, instructors are provided with several sample syllabuses

that guide the use of the text within limited time. These samples are based on real-

world experience by professors with the first edition.

All of these support materials are available at the Instructor Resource Center (IRC) for

this textbook, which can be reached through the publisher’s Web site www.pearsonhighered

.com/stallings or by clicking on the link labeled Pearson Resources for Instructors at this book’s

Companion Web site at WilliamStallings.com/ComputerSecurity. To gain access to the IRC,

please contact your local Pearson sales representative via pearsonhighered.com/educator/

replocator/requestSalesRep.page or call Pearson Faculty Services at 1-800-526-0485.

The Companion Web Site, at WilliamStallings.com/ComputerSecurity (click on the

Instructor Resources link), includes the following:

•

Links to Web sites for other courses being taught using this book.

•

Sign-up information for an Internet mailing list for instructors using this book to

exchange information, suggestions, and questions with each other and with the author.

Student reSOurCeS

For this new edition, a tremendous amount of original supporting

material for students has been made available online, at two Web

locations. The Companion Web Site, at WilliamStallings.com/

ComputerSecurity (click on the Student Resources link), includes

a list of relevant links organized by chapter and an errata sheet

for the book.

PrefaCe

xv

Purchasing this textbook now grants the reader 12-months of

access to the Premium Content Site, which includes the following

materials:

•

Online chapters: To limit the size and cost of the book, two

chapters of the book are provided in PDF format. The chapters

are listed in this book’s table of contents.

•

Online appendices: There are numerous interesting topics that

support material found in the text but whose inclusion is not

warranted in the printed text. A total of nine appendices cover

these topics for the interested student. The appendices are listed in this book’s table of

contents.

•

Homework problems and solutions: To aid the student in understanding the material,

a separate set of homework problems with solutions is available. These enable the stu-

dents to test their understanding of the text.

To access the Premium Content site, click on the Premium Content link at the

Companion Web site or at pearsonhighered.com/stallings and enter the student access code

found on the card in the front of the book.

PrOjeCtS and Other Student exerCiSeS

For many instructors, an important component of a computer security course is a project

or set of projects by which the student gets hands-on experience to reinforce concepts from

the text. This book provides an unparalleled degree of support for including a projects com-

ponent in the course. The instructor’s support materials available through Pearson not only

include guidance on how to assign and structure the projects but also include a set of user’s

manuals for various project types plus specific assignments, all written especially for this

book. Instructors can assign work in the following areas:

•

Hacking exercises: Two projects that enable students to gain an understanding of the

issues in intrusion detection and prevention.

•

Laboratory exercises: A series of projects that involve programming and experiment-

ing with concepts from the book.

•

Security education (SEED) projects: The SEED projects are a set of hands-on exer-

cises, or labs, covering a wide range of security topics.

•

Research projects: A series of research assignments that instruct the student to research

a particular topic on the Internet and write a report.

•

Programming projects: A series of programming projects that cover a broad range of

topics and that can be implemented in any suitable language on any platform.

•

Practical security assessments: A set of exercises to examine current infrastructure and

practices of an existing organization.

•

Firewall projects: A portable network firewall visualization simulator is provided,

together with exercises for teaching the fundamentals of firewalls.

•

Case studies: A set of real-world case studies, including learning objectives, case

description, and a series of case discussion questions.

xvi

PrefaCe

•

Reading/report assignments: A list of papers that can be assigned for reading and writ-

ing a report, plus suggested assignment wording.

•

Writing assignments: A list of writing assignments to facilitate learning the material.

•

Webcasts for teaching computer security: A catalog of webcast sites that can be used to

enhance the course. An effective way of using this catalog is to select, or allow the student

to select, one or a few videos to watch, and then to write a report/analysis of the video.

This diverse set of projects and other student exercises enables the instructor to use the

book as one component in a rich and varied learning experience and to tailor a course plan to

meet the specific needs of the instructor and students. See Appendix A in this book for details.

aCknOwledgmentS

This new edition has benefited from review by a number of people, who gave generously of

their time and expertise. The following professors and instructors reviewed all or a large part

of the manuscript: Stefan Robila (Montclair State University), Weichao Wang (University

of North Carolina, Charlotte), Bob Brown (Southern Polytechnic State University), Leming

Zhou (University of Pittsburgh), Yosef Sherif (Mihaylo College of Business and Economics),

Nazrul Islam (Farmingdale State University), Qinghai Gao (Farmingdale State University),

Wei Li (Nova Southeastern University), Jeffrey Kane (Nova Southeastern University), Philip

John Lunsford II (East Carolina University), Jeffrey H. Peden (Longwood University), Ratan

Guha (University of Central Florida), Sven Dietrich (Stevens Institute of Technology), and

David Liu (Purdue University, Fort Wayne).

Thanks also to the many people who provided detailed technical reviews of one or

more chapters: Umair Manzoor (UmZ), Adewumi Olatunji (FAGOSI Systems, Nigeria),

Rob Meijer, Robin Goodchil, Greg Barnes (Inviolate Security LLC), Arturo Busleiman

(Buanzo Consulting), Ryan M. Speers (Dartmouth College), Wynand van Staden (School

of Computing, University of South Africa), Oh Sieng Chye, Michael Gromek, Samuel

Weisberger, Brian Smithson (Ricoh Americas Corp, CISSP), Josef B. Weiss (CISSP),

Robbert-Frank Ludwig (Veenendaal, ActStamp Information Security), William Perry,

Daniela Zamfiroiu (CISSP), Rodrigo Ristow Branco, George Chetcuti (Technical Editor,

TechGenix), Thomas Johnson (Director of Information Security at a banking holding com-

pany in Chicago, CISSP), Robert Yanus (CISSP), Rajiv Dasmohapatra (Wipro Ltd), Dirk

Kotze, Ya’akov Yehudi, and Stanley Wine (Adjunct Lecturer, Computer Information Systems

Department, Zicklin School of Business, Baruch College).

Dr. Lawrie Brown would first like to thank Bill Stallings for the pleasure of work-

ing with him to produce this text. I would also like to thank my colleagues in the School of

Engineering and Information Technology, UNSW Canberra at the Australian Defence Force

Academy for their encouragement and support.

Finally, we would like to thank the many people responsible for the publication of the

book, all of whom did their usual excellent job. This includes the staff at Pearson, particularly

our editor Tracy Dunkelberger, program manager Carole Snyder, and production manager

Bob Engelhardt. We also thank the production staff at Jouve India for another excellent and

rapid job. Thanks also to the marketing and sales staff at Pearson, without whose efforts this

book would not be in your hands.

PrefaCe

xvii

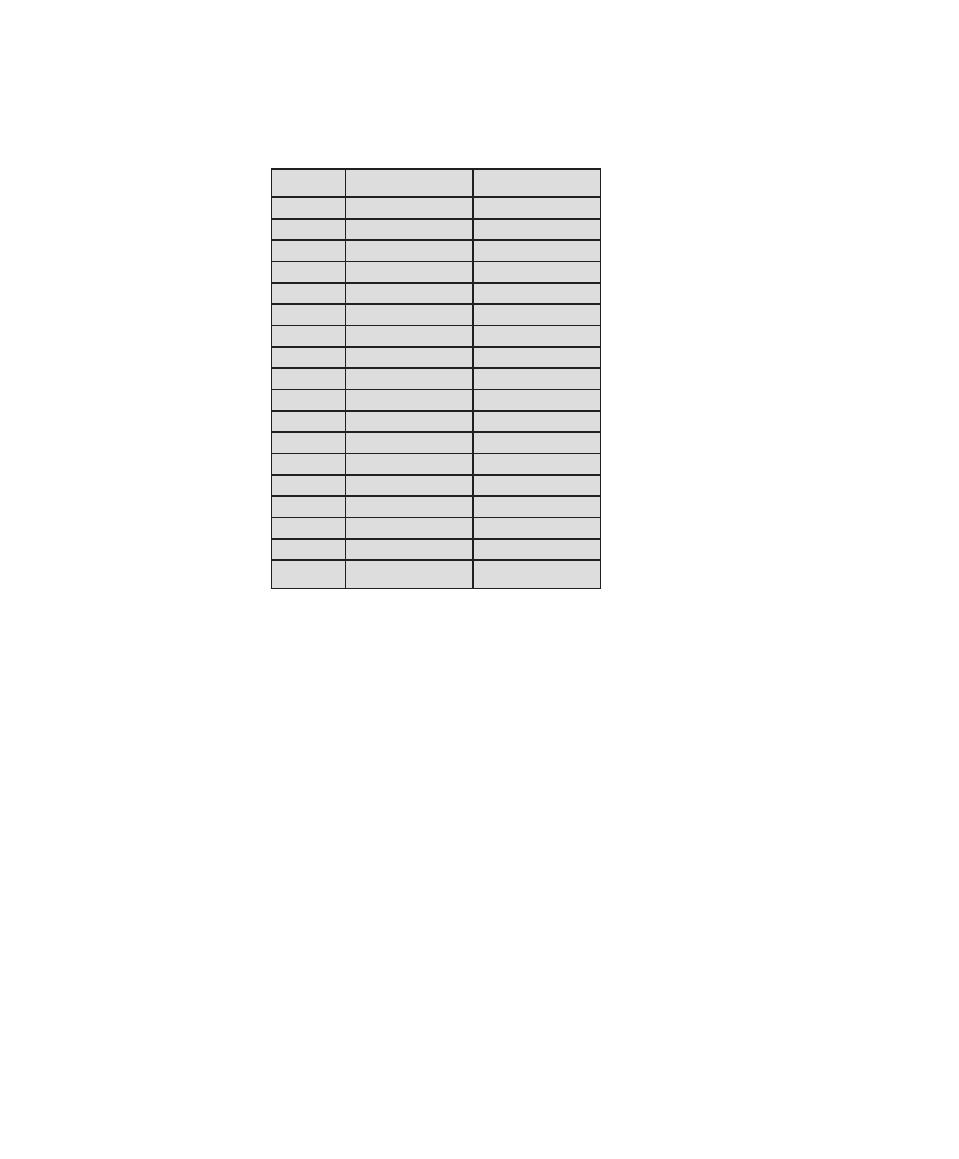

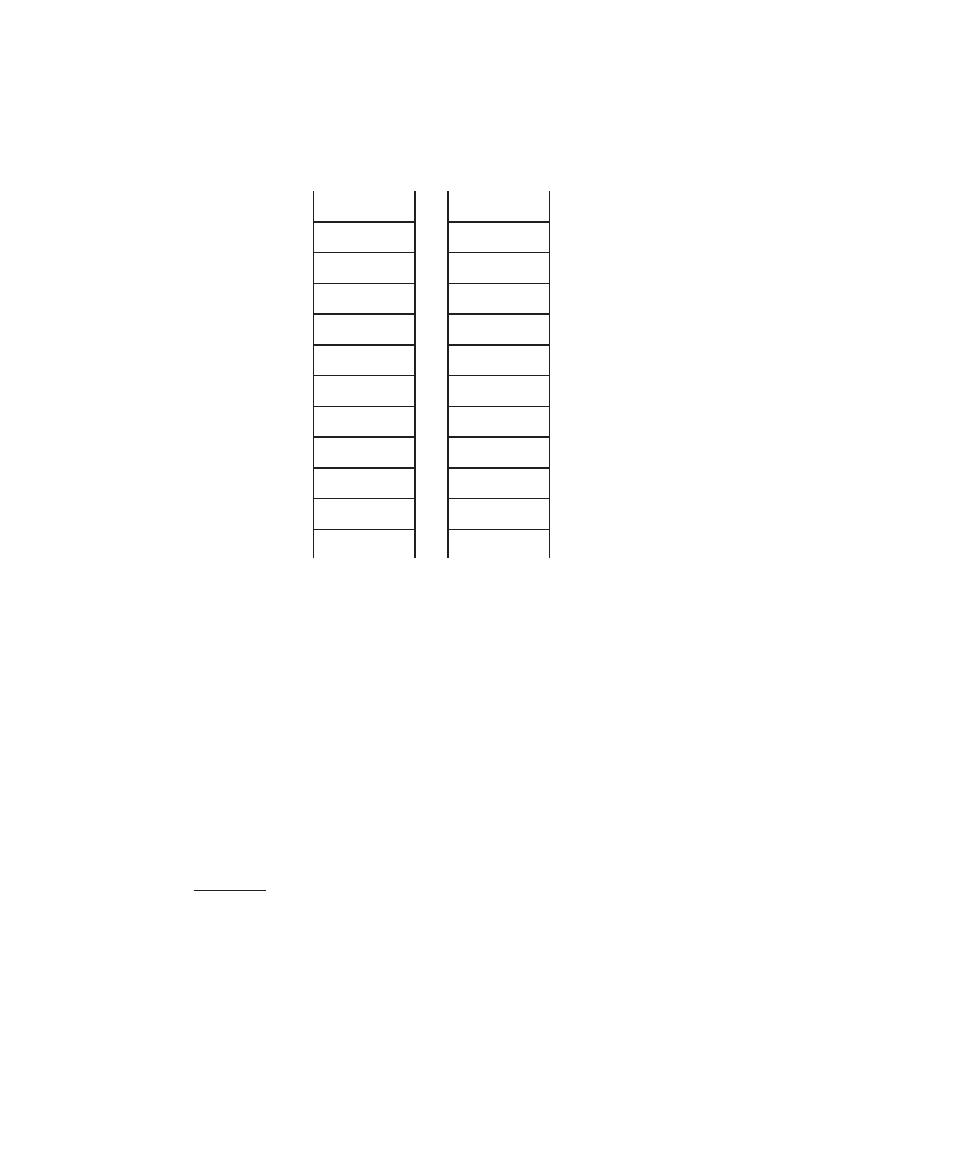

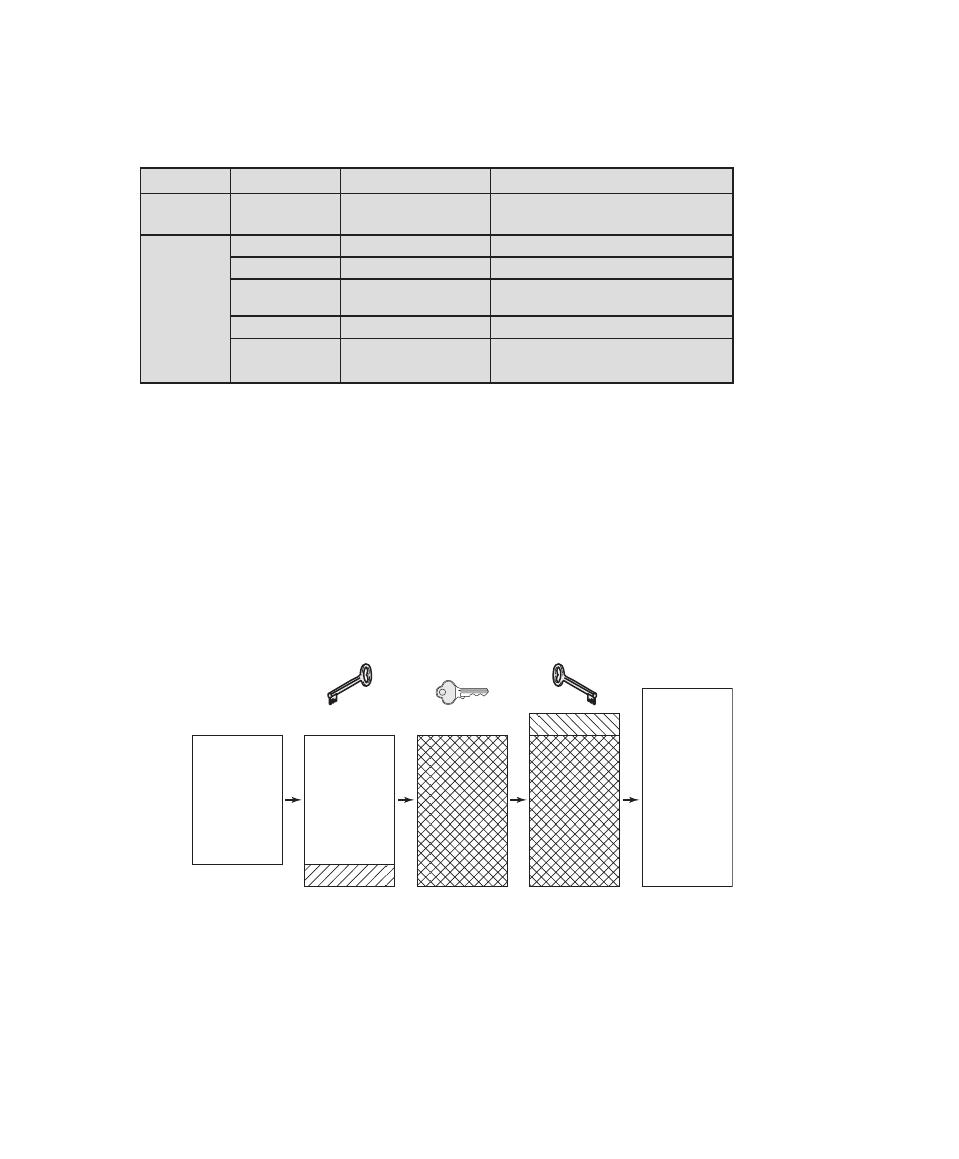

Symbol

Expression

Meaning

D, K

D(K, Y )

Symmetric decryption of ciphertext Y using secret key K

D, PR

a

D(PR

a

, Y )

Asymmetric decryption of ciphertext Y using A’s private key PR

a

D, PU

a

D(PU

a

, Y )

Asymmetric decryption of ciphertext Y using A’s public key PU

a

E, K

E(K, X )

Symmetric encryption of plaintext X using secret key K

E, PR

a

E(PR

a

, X )

Asymmetric encryption of plaintext X using A’s private key PR

a

E, PU

a

E(PU

a

, X )

Asymmetric encryption of plaintext X using A’s public key PU

a

K

Secret key

PR

a

Private key of user A

PU

a

Public key of user A

H

H(X )

Hash function of message X

+

x

+ y

Logical OR: x OR y

•

x

• y

Logical AND: x AND y

~

~ x

Logical NOT: NOT x

C

A characteristic formula, consisting of a logical formula over the

values of attributes in a database

X

X

(C )

Query set of C, the set of records satisfying C

, X

X(C)

Magnitude of X(C ): the number of records in X(C )

¨

X

(C)

¨ X(D)

Set intersection: the number of records in both X(C) and X(D)

x

y

x

concatenated with y

xviii

Dr. William Stallings authored 18 textbooks, and, counting revised

editions, a total of 70 books on various aspects of these subjects.

His writings have appeared in numerous ACM and IEEE

publications, including the Proceedings of the IEEE and ACM

Computing Reviews

. He has 11 times received the award for the

best Computer Science textbook of the year from the Text and

Academic Authors Association.

In over 30 years in the field, he has been a technical

contributor, technical manager, and an executive with several

high-technology firms. He has designed and implemented both

TCP/IP-based and OSI-based protocol suites on a variety of computers and operating

systems, ranging from microcomputers to mainframes. Currently he is an independent

consultant whose clients have included computer and networking manufacturers and

customers, software development firms, and leading-edge government research institutions.

He created and maintains the Computer Science Student Resource Site at Computer

ScienceStudent.com. This site provides documents and links on a variety of subjects of

general interest to computer science students (and professionals). He is a member of the

editorial board of Cryptologia, a scholarly journal devoted to all aspects of cryptology. His

articles appear regularly at http://www.networking.answers.com, where he is the Networking

Category Expert Writer.

Dr. Lawrie Brown is a senior lecturer in the School of Engineering

and Information Technology, UNSW Canberra at the Australian

Defence Force Academy.

His professional interests include communications and

computer systems security and cryptography, including research

on client authentication using proxy certificates, trust and security

in eCommerce and Web environments, the design of secure remote

code execution environments using the functional language

Erlang, and on the design and implementation of the LOKI family

of block ciphers.

He currently teaches courses on cyber-security and data structures, and has previously

presented courses on cryptography, data communications, and programming in Java.

xix

This page intentionally left blank

1

0.1

Outline of This Book

0.2

A Roadmap for Readers and Instructors

0.3

Support for CISSp Certification

0.4

Support for NSA/DHS Certification

0.5

Support for ACM/IEEE Computer Society Computer Science Curricula 2013

0.6

Internet and Web Resources

Web Sites for This Book

Computer Science Student Resource Site

Other Web Sites

0.7

Standards

2

Chapter 0 / reader’s and InstruCtor’s GuIde

This book, with its accompanying Web site, covers a lot of material. Here we give

the reader an overview.

Following an introductory chapter, Chapter 1, the book is organized into five parts:

part One: Computer Security Technology and principles: This part covers tech-

nical areas that must underpin any effective security strategy. Chapter 2 lists

the key cryptographic algorithms, discusses their use, and discusses issues of

strength. The remaining chapters in this part look at specific technical areas of

computer security: authentication, access control, database and cloud security,

malicious software, denial of service, intrusion detection, and firewalls.

part Two: Software Security and Trusted Systems: This part covers issues

concerning software development and implementation, including operat-

ing systems, utilities, and applications. Chapter 10 covers the perennial issue

of buffer overflow, while Chapter 11 examines a number of other software

security issues. Chapter 12 takes an overall look at operating system security.

The final chapter in this part deals with trusted computing and multilevel

security, which are both software and hardware issues.

part Three: Management Issues: This part is concerned with management

aspects of information and computer security. Chapters 14 and 15 focus

specifically on management practices related to risk assessment, the setting up

of security controls, and plans and procedures for managing computer security.

Chapter 16 looks at physical security measures that must complement the

technical security measures of Part One. Chapter 17 examines a wide range of

human factors issues that relate to computer security. A vital management tool

is security auditing, examined in Chapter 18. Finally, Chapter 19 examines legal

and ethical aspects of computer security.

part Four: Cryptographic Algorithms: Many of the technical measures that

support computer security rely heavily on encryption and other types of cryp-

tographic algorithms. Part Four is a technical survey of such algorithms.

part Five: Internet Security: This part looks at the protocols and standards

used to provide security for communications across the Internet. Chapter 22

discusses some of the most important security protocols for use over the

Internet. Chapter 23 looks at various protocols and standards related to

authentication over the Internet. Chapter 24 examines important aspects of

wireless security.

A number of online appendices cover additional topics relevant to the book.

0.2 A ROAdmAp fOR ReAdeRs And instRuctORs

This book covers a lot of material. For the instructor or reader who wishes a shorter

treatment, there are a number of alternatives.

To thoroughly cover the material in the first two parts, the chapters should

be read in sequence. If a shorter treatment in part One is desired, the reader may

choose to skip Chapter 5 (Database Security).

Although part Two covers software security, it should be of interest to users

as well as system developers. However, it is more immediately relevant to the latter

category. Chapter 13 (Trusted Computing and Multilevel Security) may be consid-

ered optional.

The chapters in part Three are relatively independent of one another, with

the exception of Chapters 14 (IT Security Management and Risk Assessment)

and 15 (IT Security Controls, Plans, and Procedures). The chapters can be read

in any order and the reader or instructor may choose to select only some of the

chapters.

part Four provides technical detail on cryptographic algorithms for the inter-

ested reader.

part Five covers Internet security and can be read at any point after Part One.

0.3 suppORt fOR cissp ceRtificAtiOn

This book provides coverage of all the subject areas specified for CISSP (Certified

Information Systems Security Professional) certification.

As employers have come to depend on in-house staff to manage and develop

security policies and technologies, and to evaluate and manage outside security

services and products, there is a need for methods for evaluating candidates.

Increasingly, employers are turning to certification as a tool for guaranteeing that

a potential employee has the required level of knowledge in a range of security

areas.

The international standard ISO/IEC 17024 (General Requirements for Bodies

Operating Certification of Persons

) defines the following terms related to certification:

•

Certification process: All activities by which a certification body establishes

that a person fulfills specified competence requirements.

•

Certification scheme: Specific certification requirements related to specified

categories of persons to which the same particular standards and rules, and the

same procedures apply.

•

Competence: Demonstrated ability to apply knowledge and/or skills and,

where relevant, demonstrated personal attributes, as defined in the certifica-

tion scheme.

The CISSP designation from the International Information Systems Security

Certification Consortium (ISC)

2

, a nonprofit organization, is often referred to as

the “gold standard” when it comes to information security certification. It is the

only universally recognized certification in the security industry [SAVA03]. Many

organizations, including the U.S. Department of Defense and many financial insti-

tutions, now require that cyber security personnel have the CISSP certification

[DENN11]. In 2004, CISSP became the first IT (Information Technology) program

to earn accreditation under ISO/IEC 17024.

0.3 / support For CIssp CertIFICatIon

3

4

Chapter 0 / reader’s and InstruCtor’s GuIde

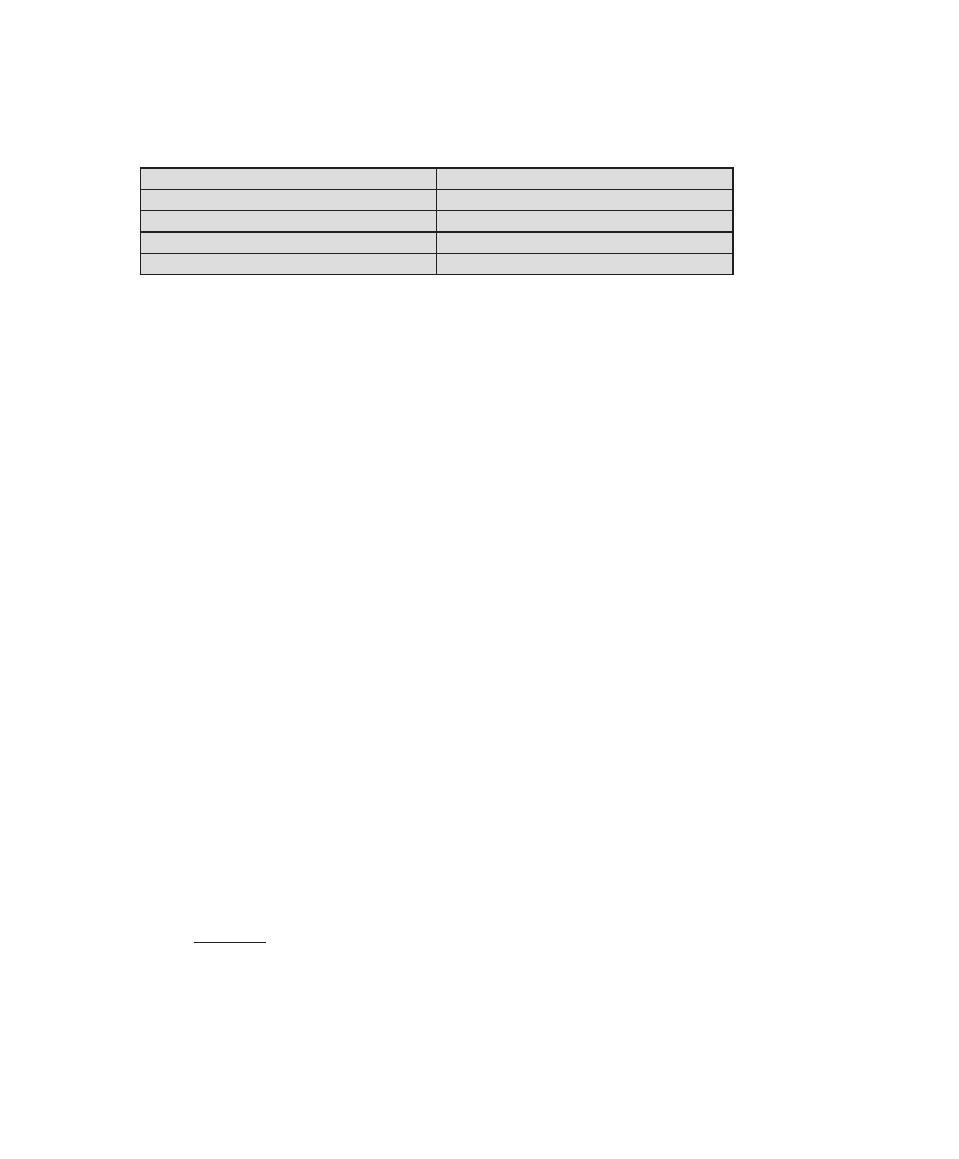

The CISSP examination is based on the Common Body of Knowledge (CBK),

a compendium of information security best practices developed and maintained by

(ISC)

2

. The CBK is made up of 10 domains that comprise the body of knowledge

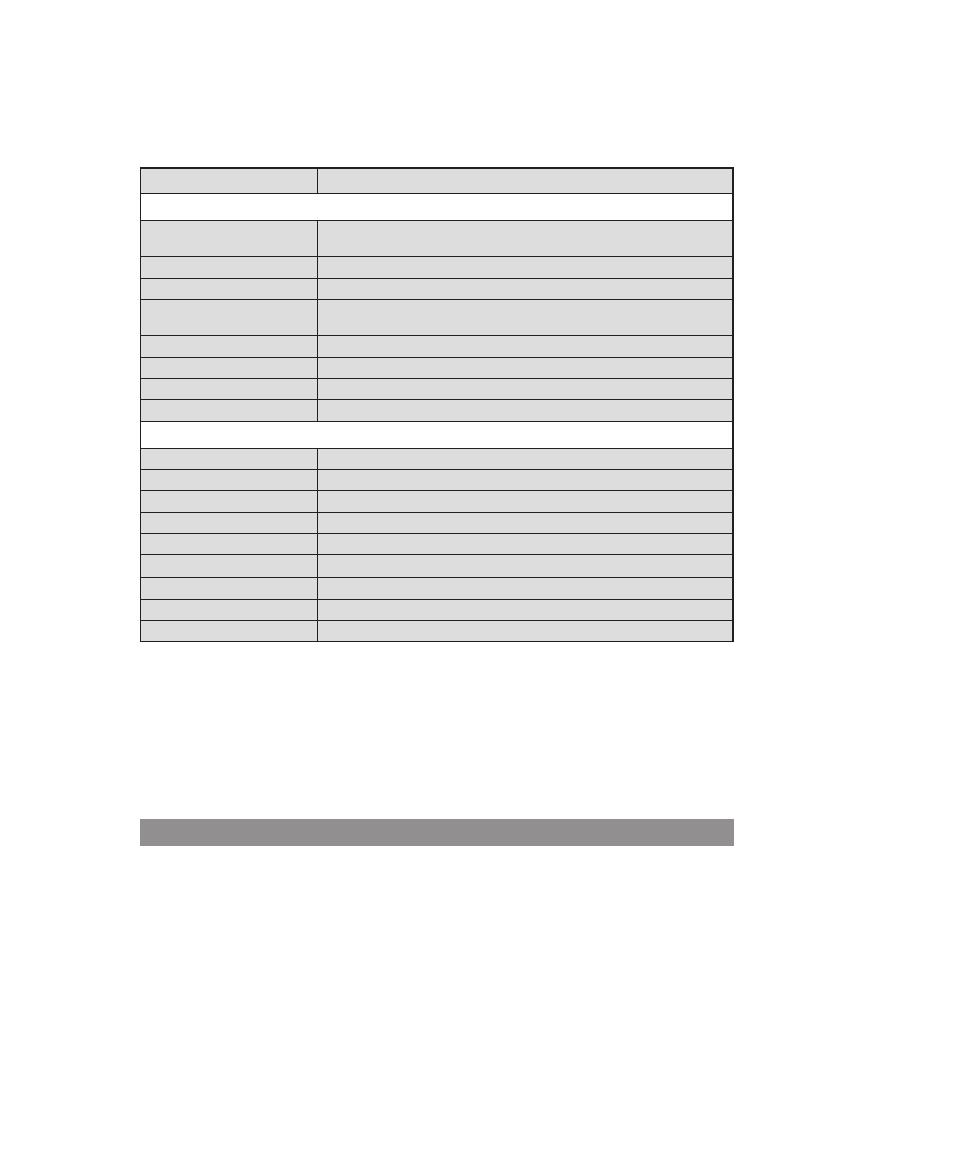

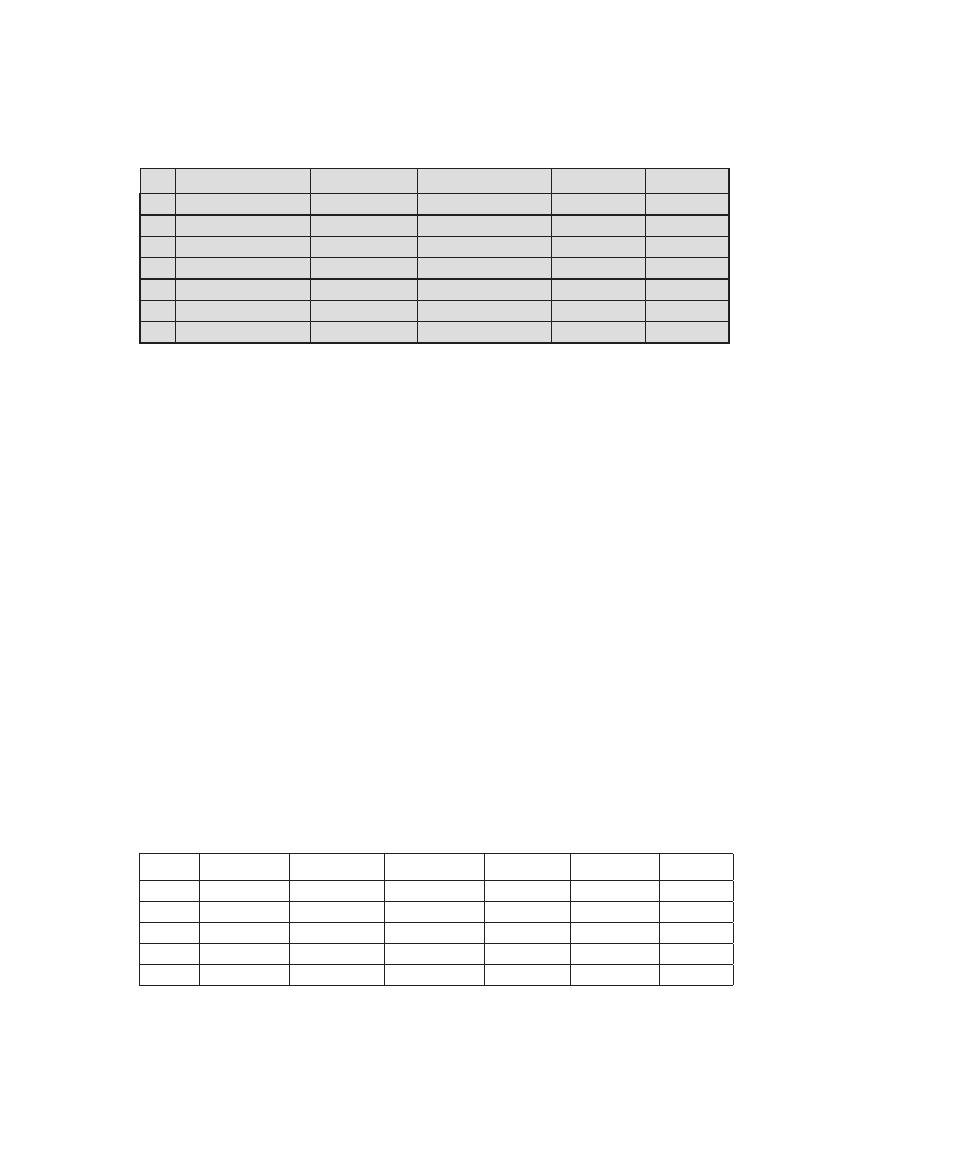

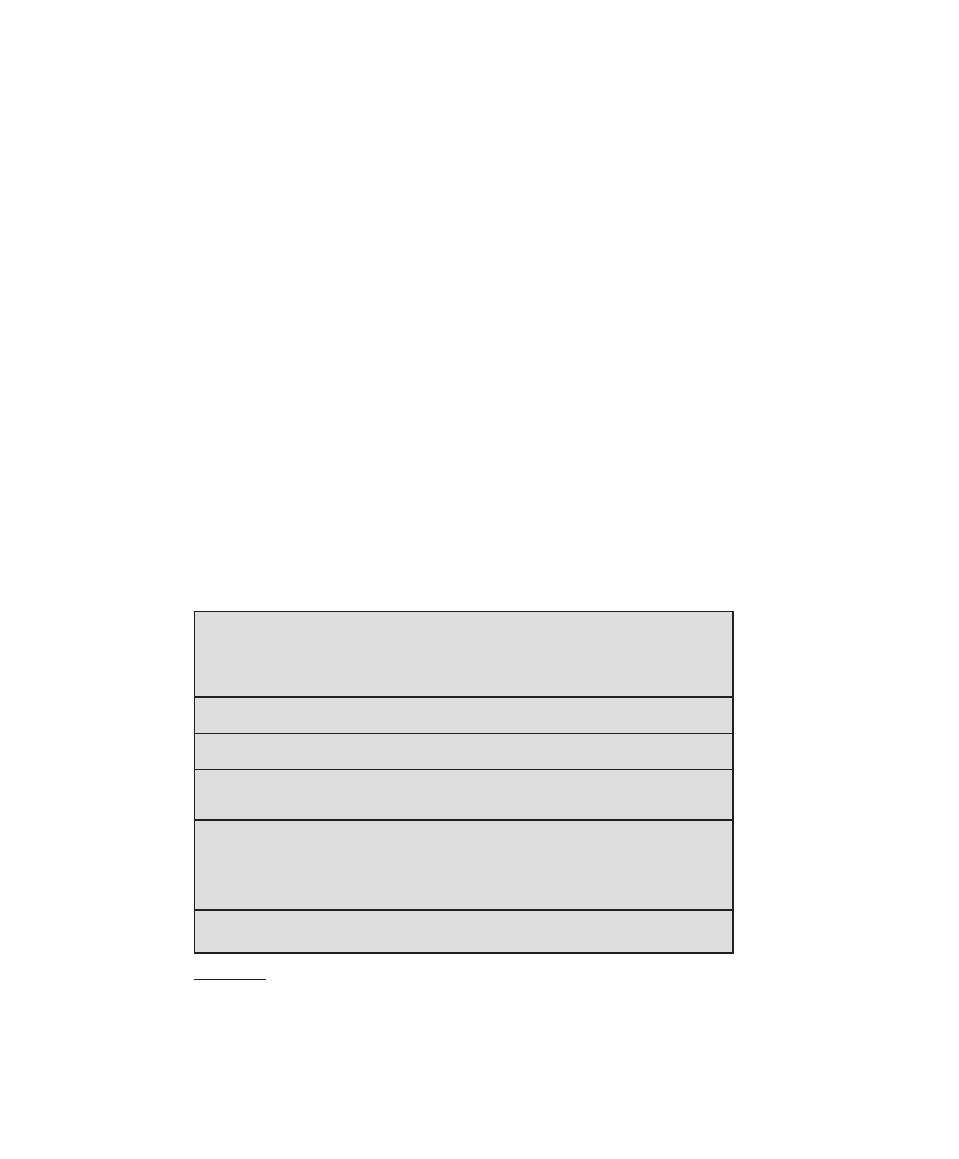

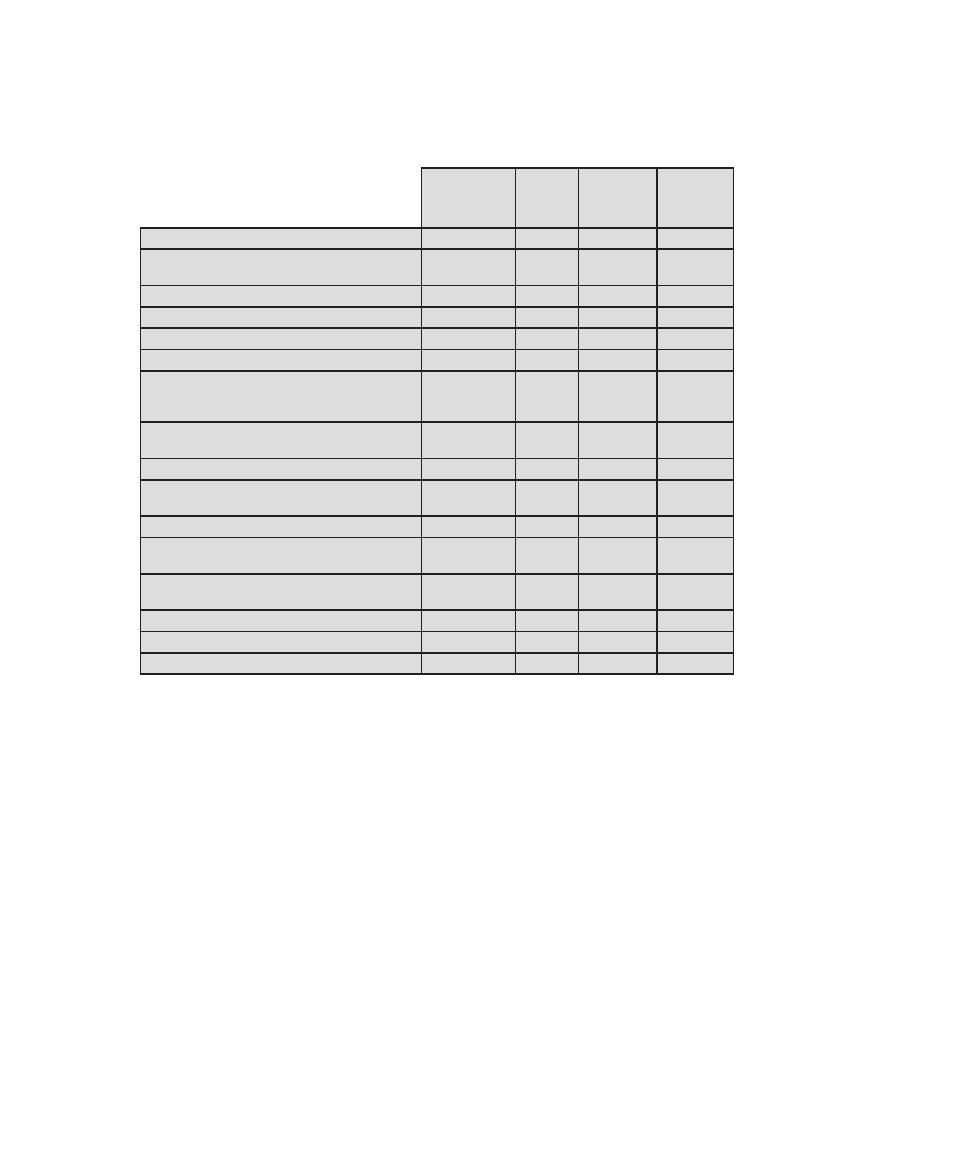

that is required for CISSP certification. Table 0.1 shows the support for the CISSP

body of knowledge provided in this textbook.

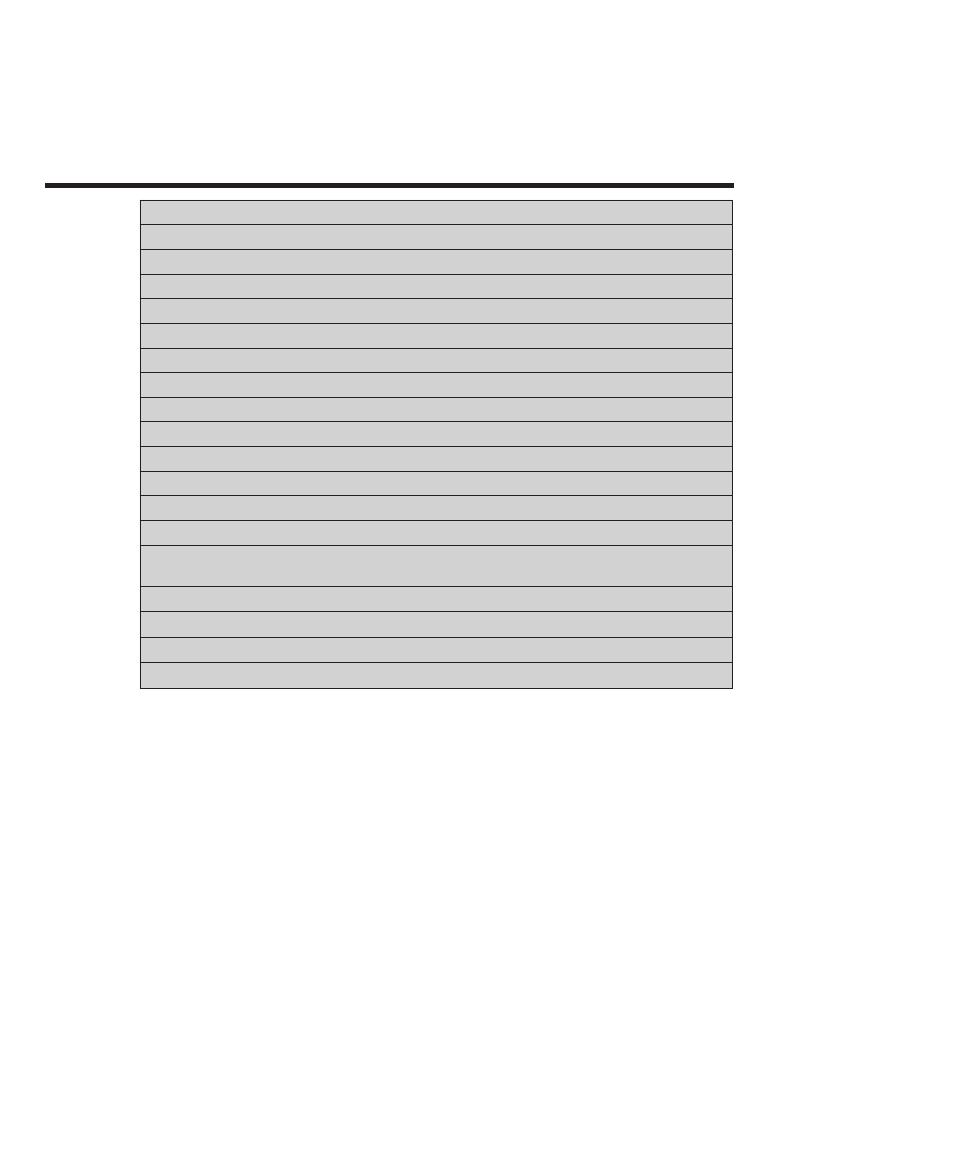

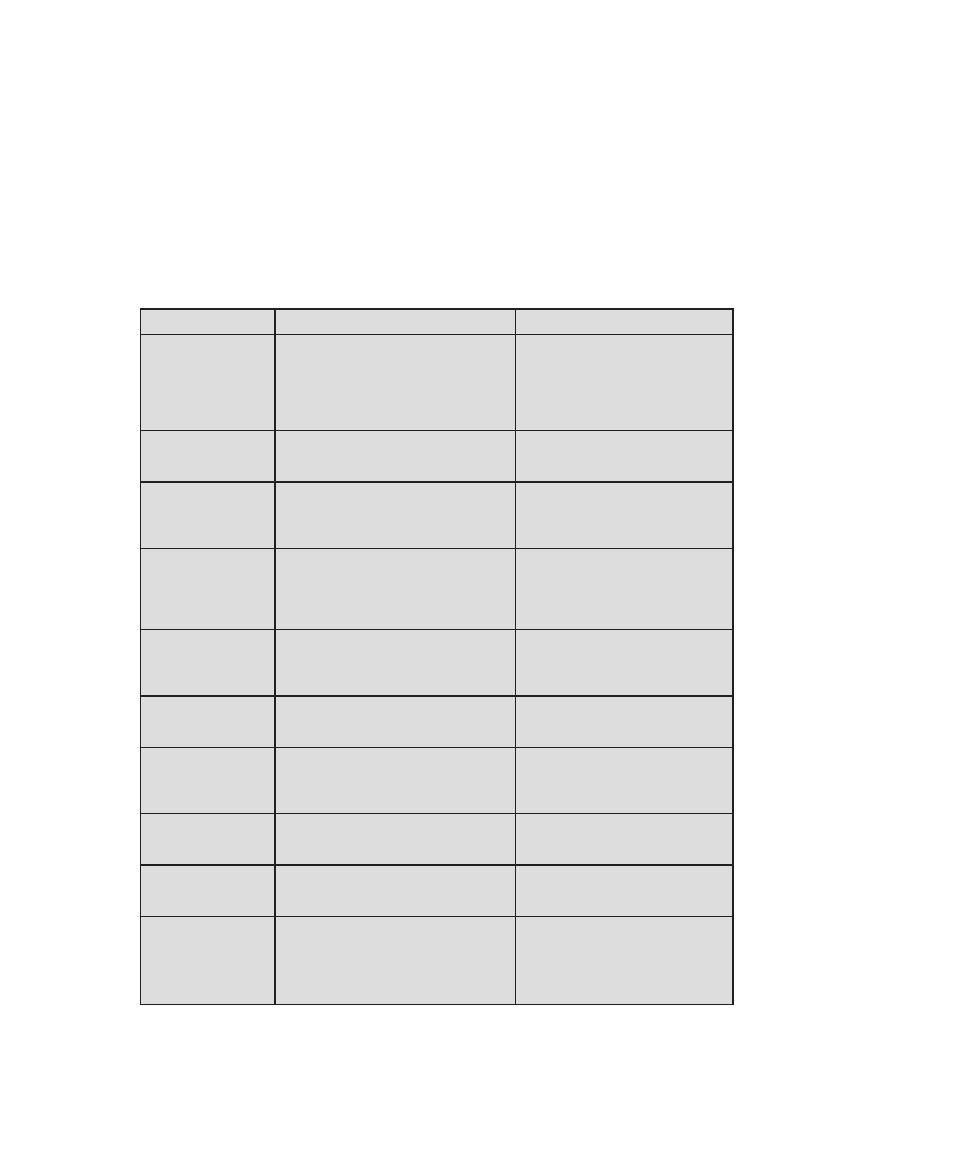

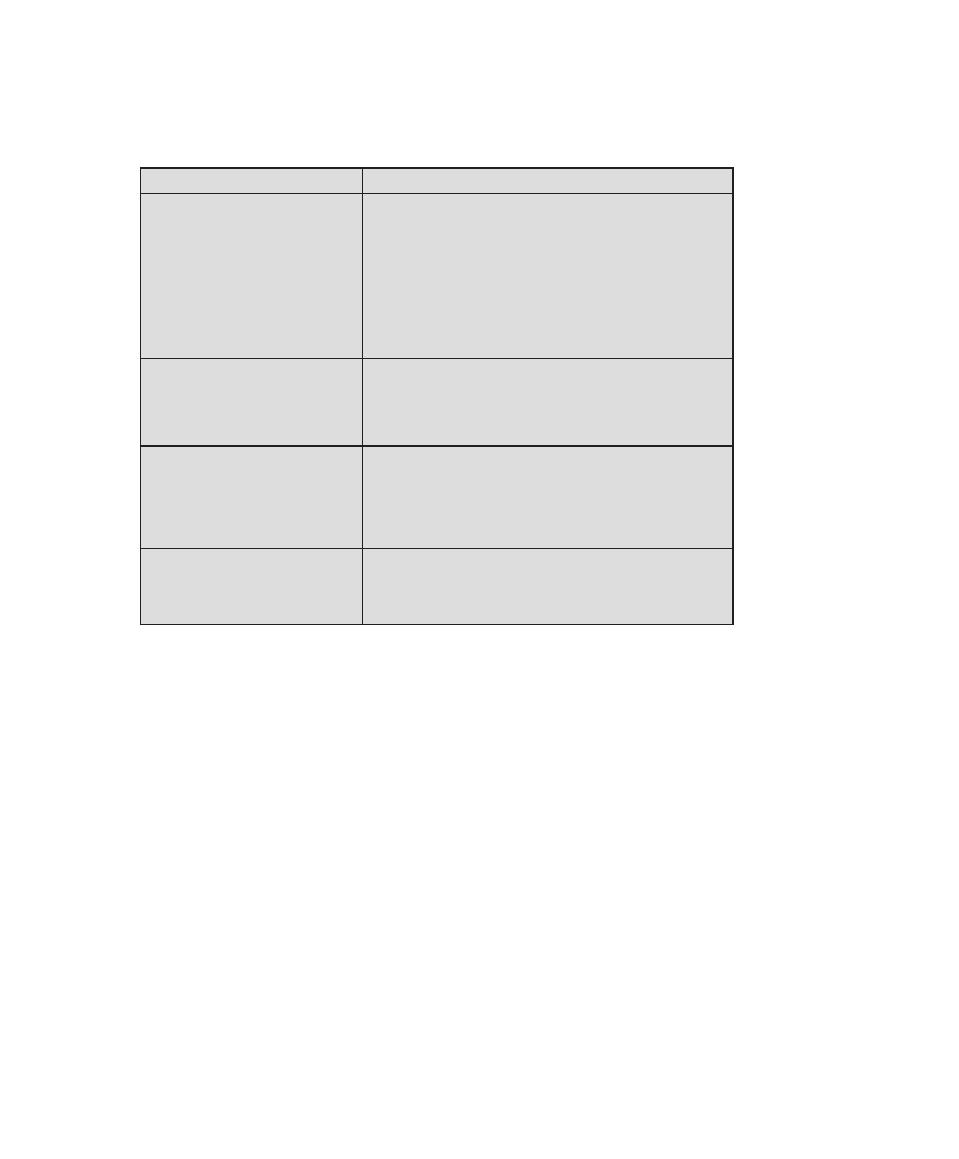

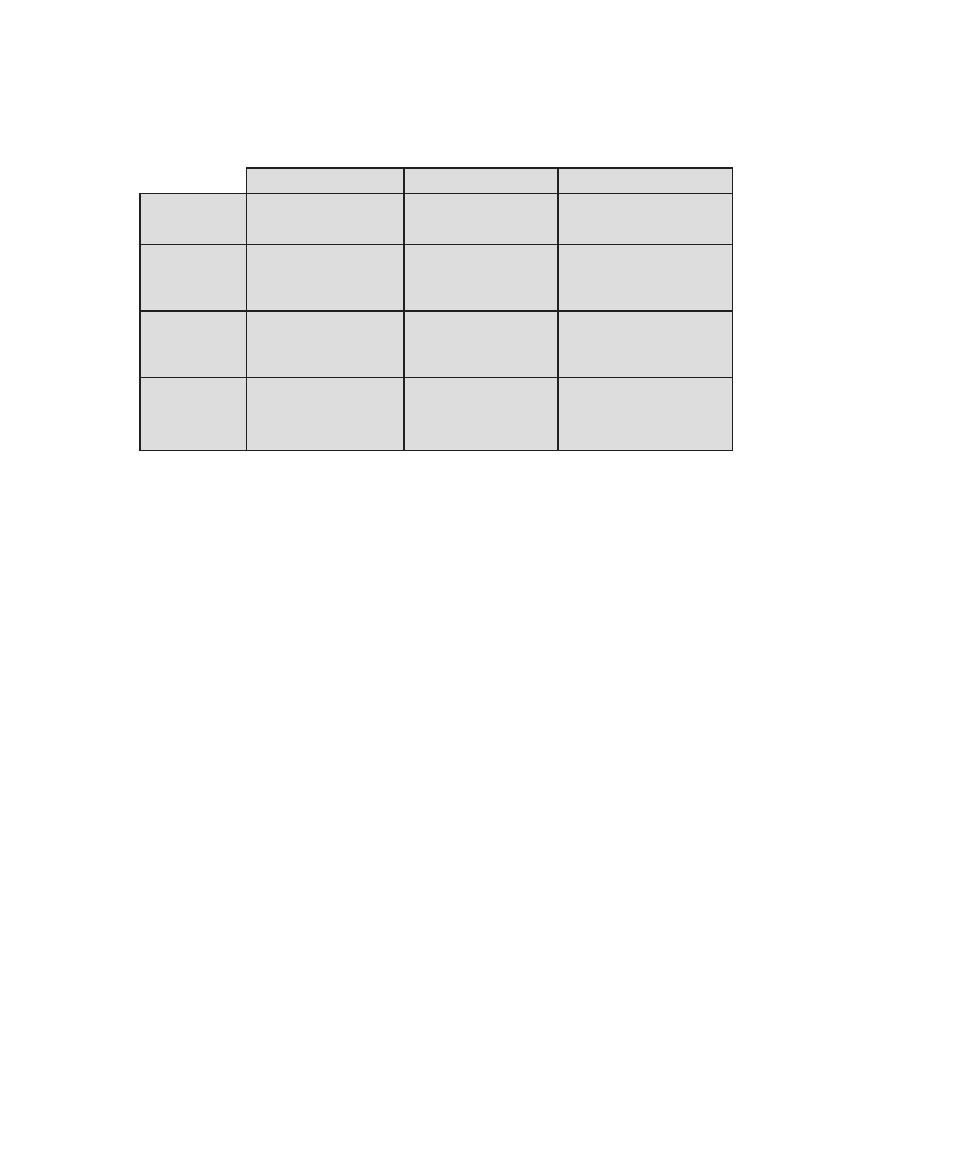

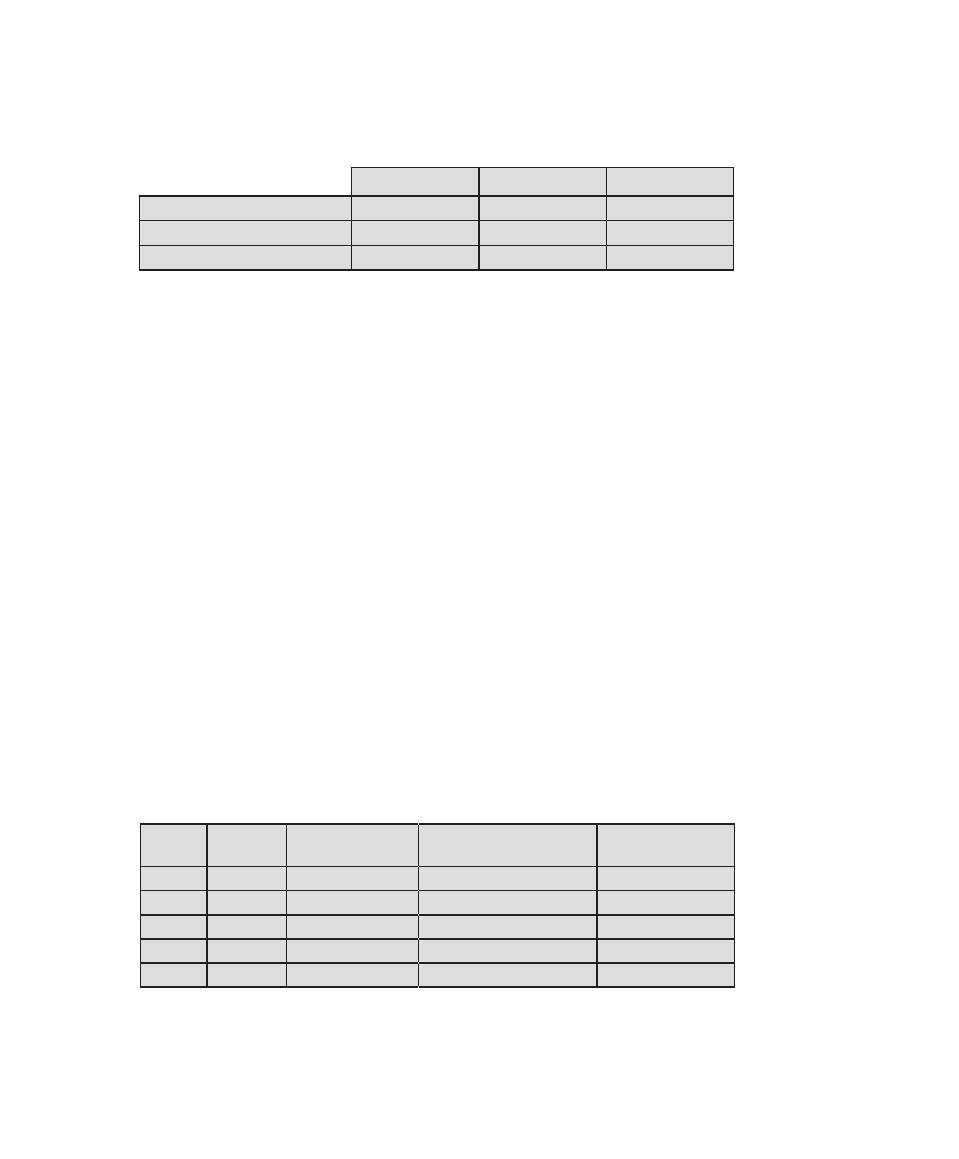

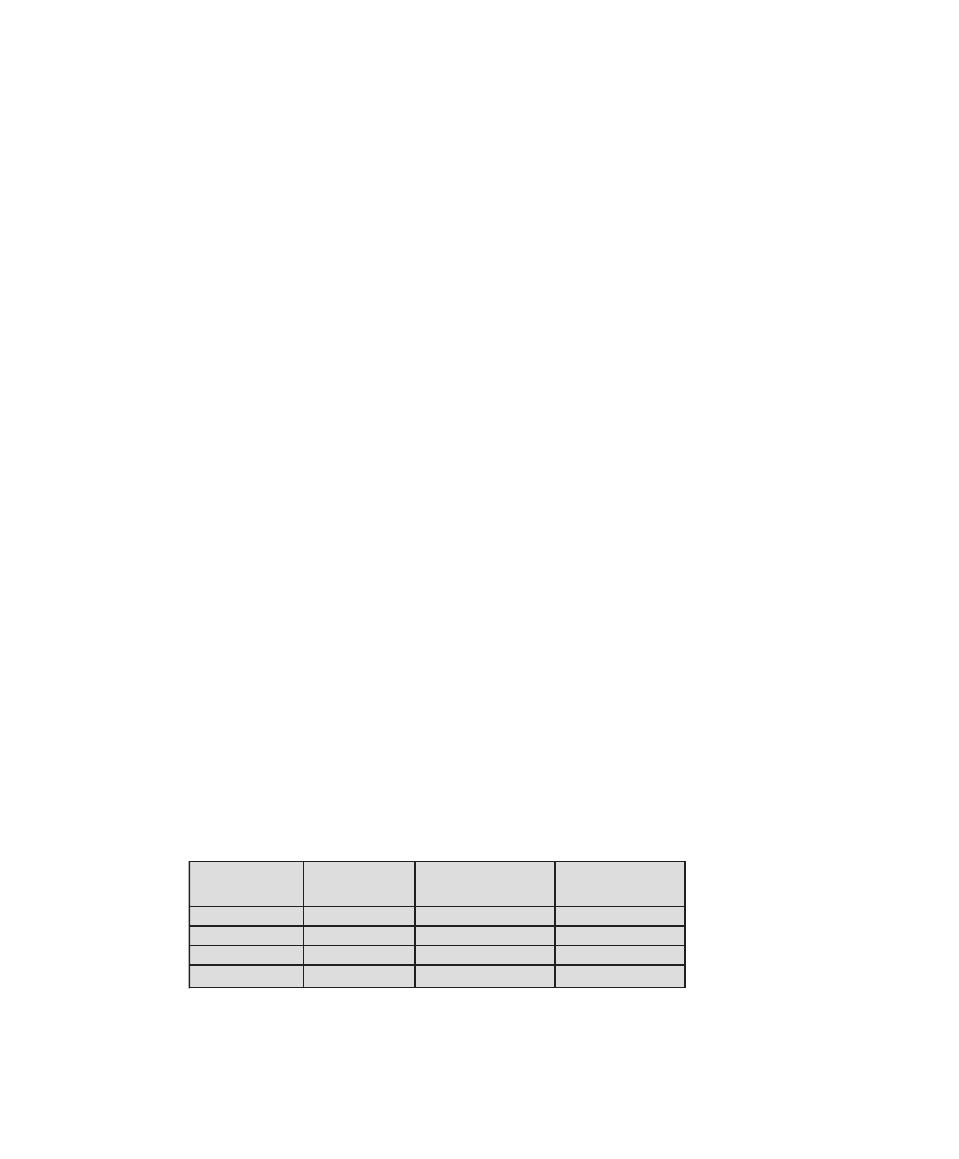

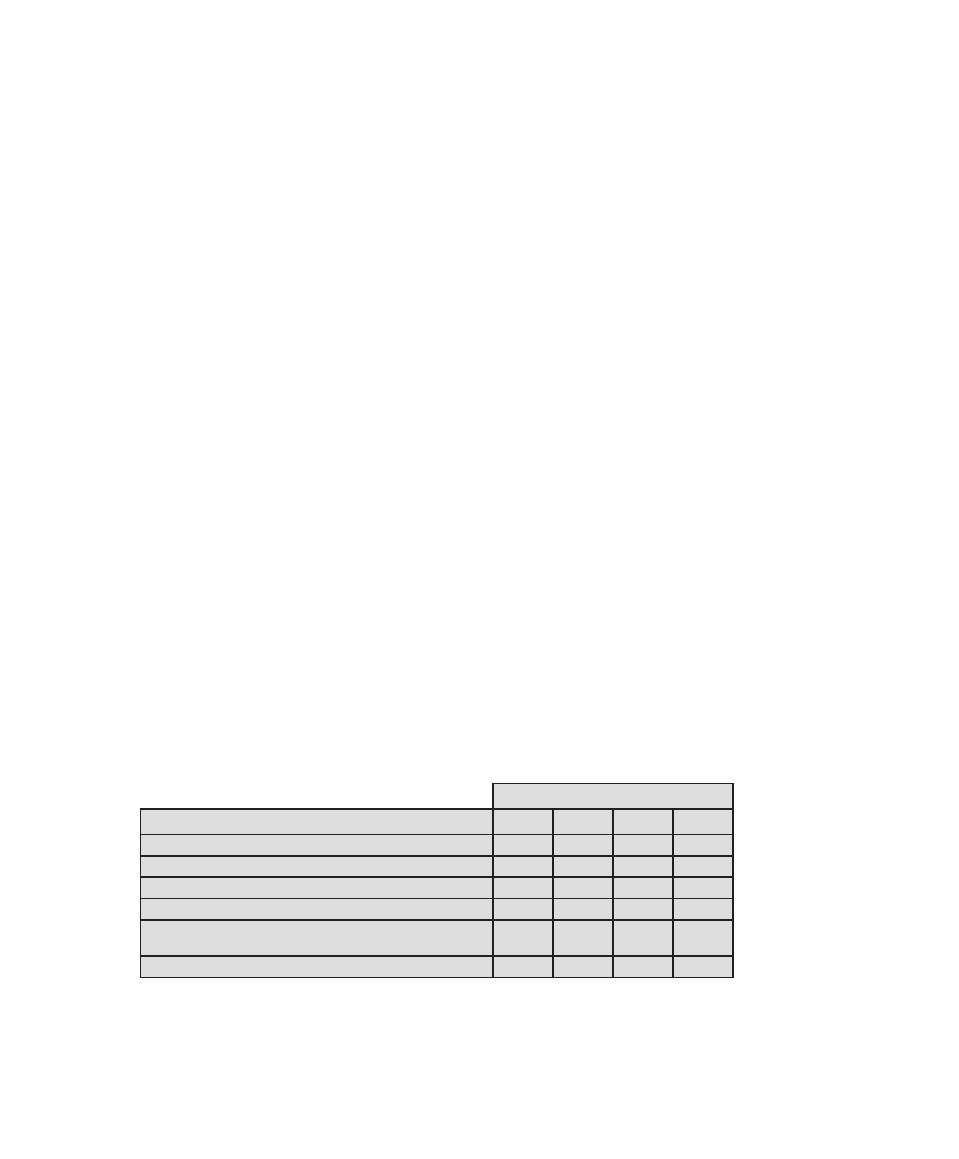

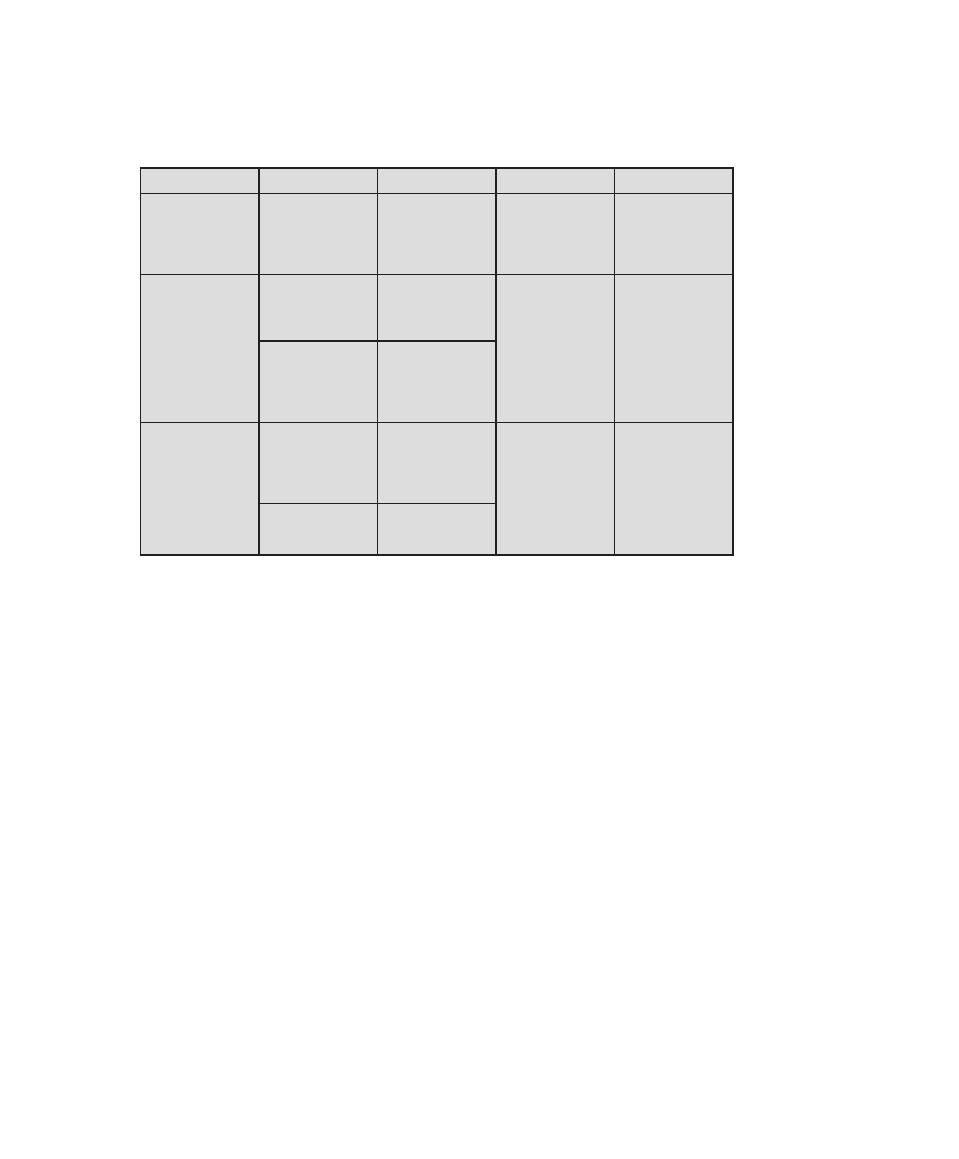

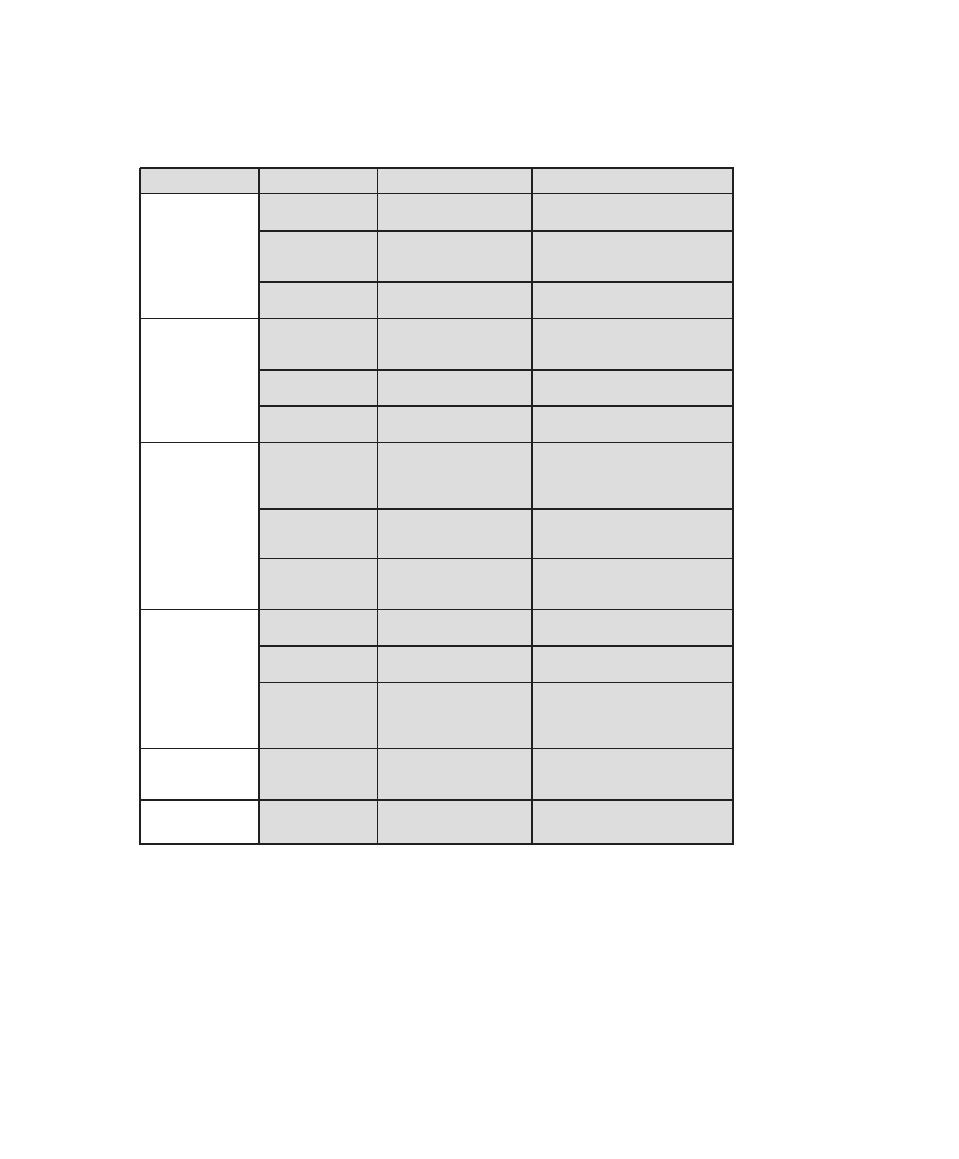

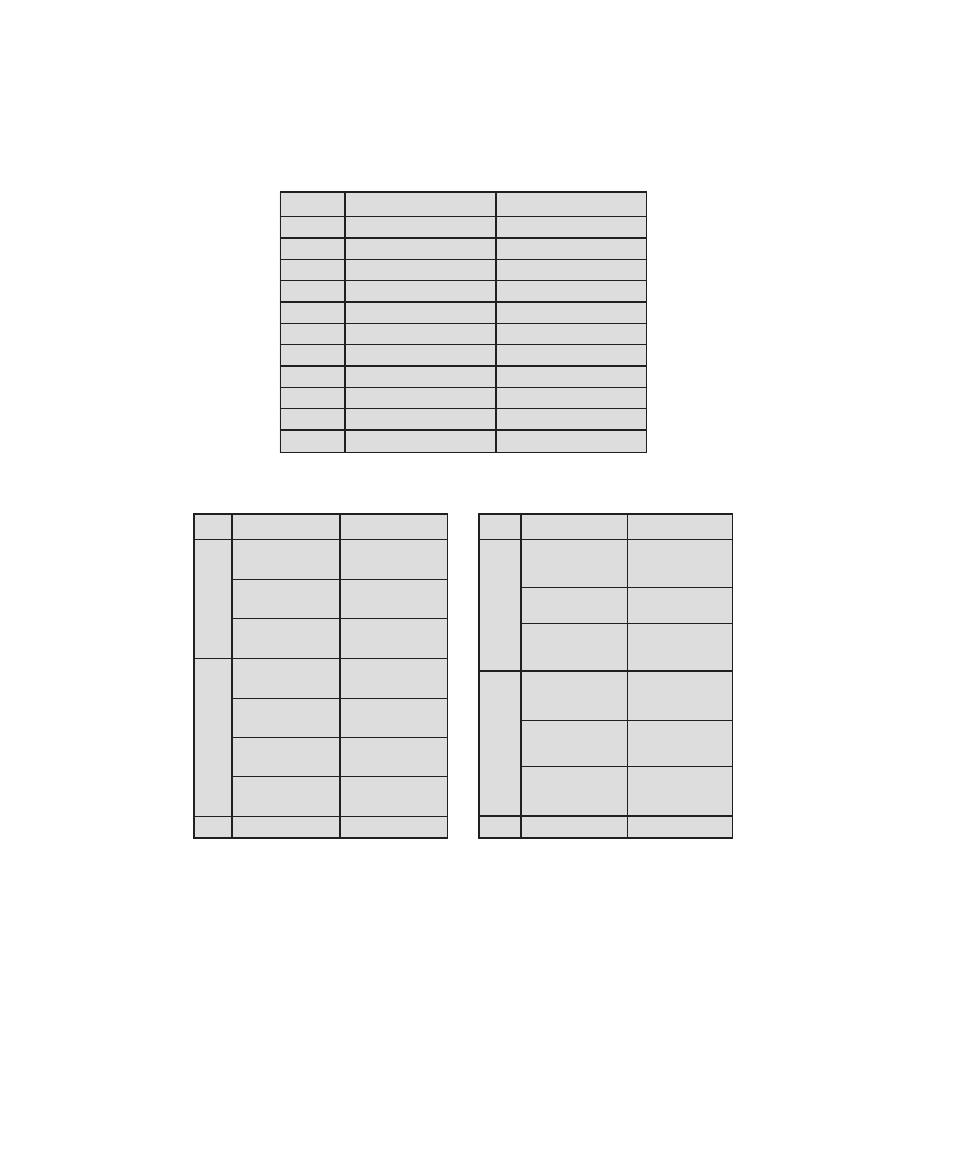

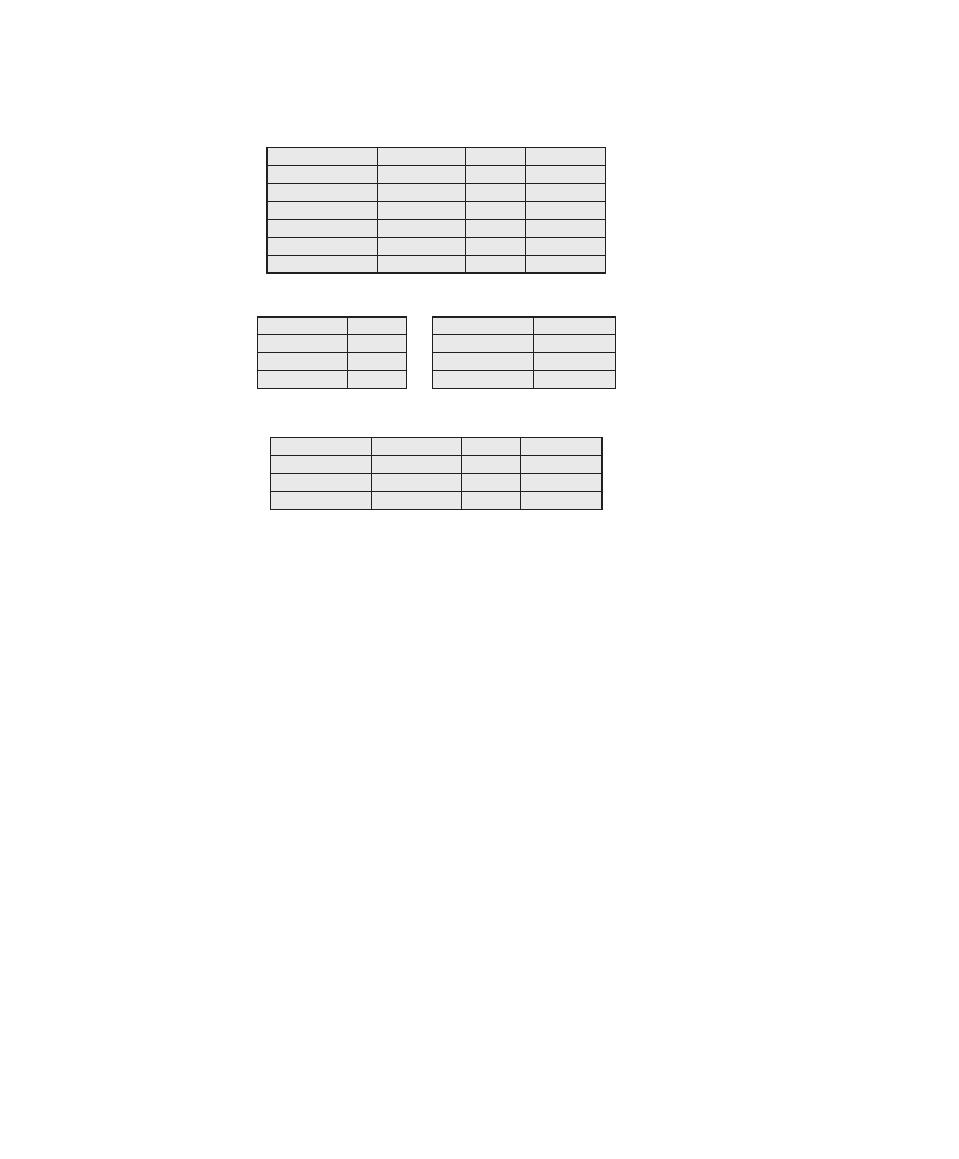

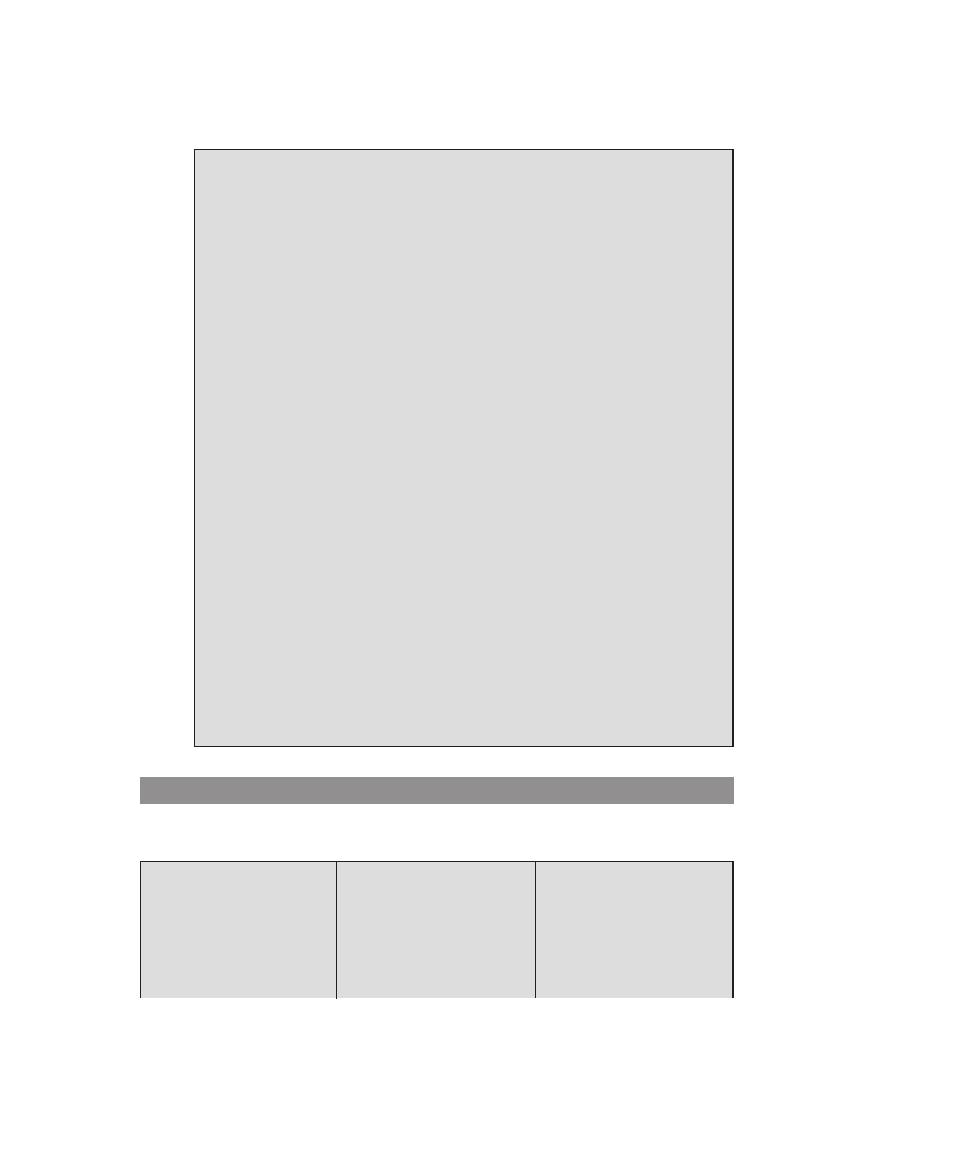

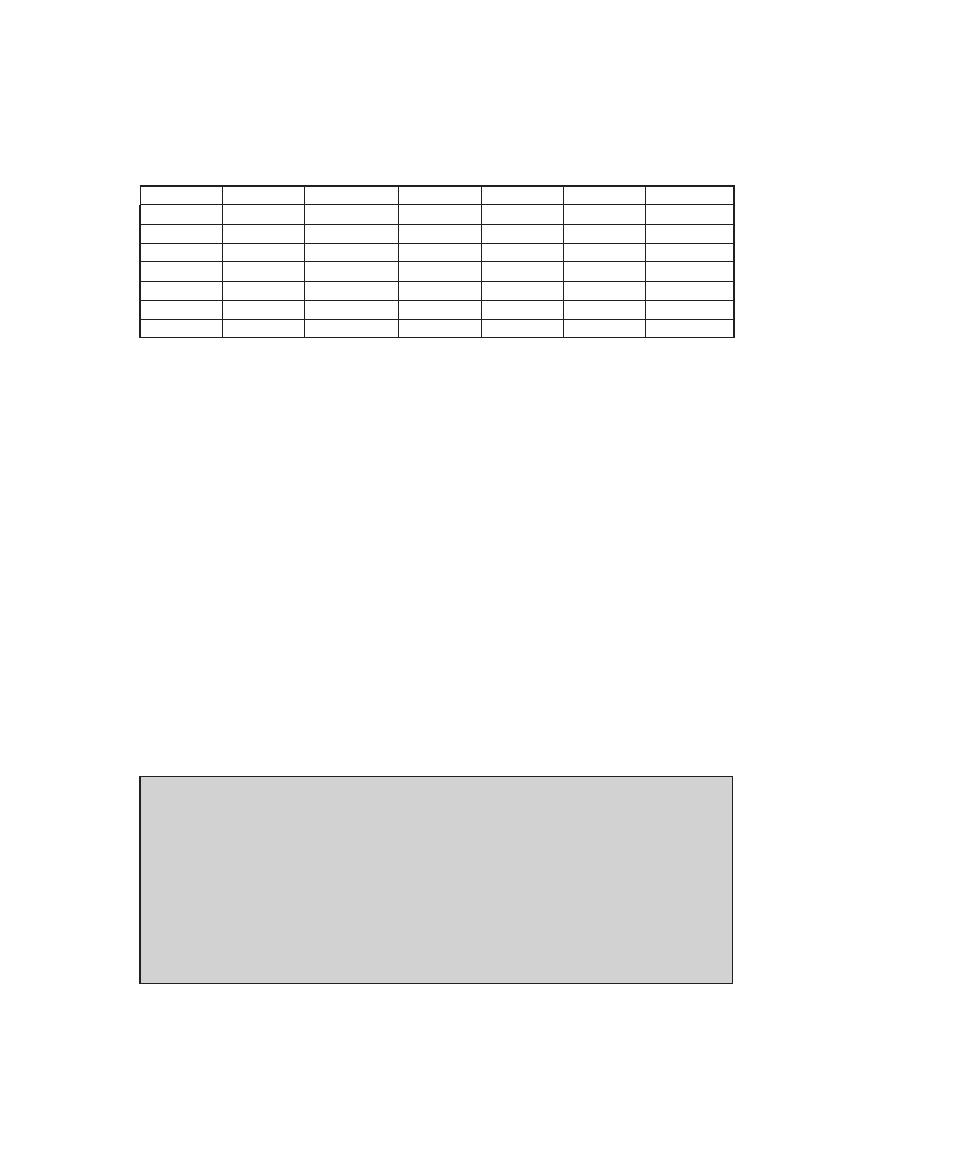

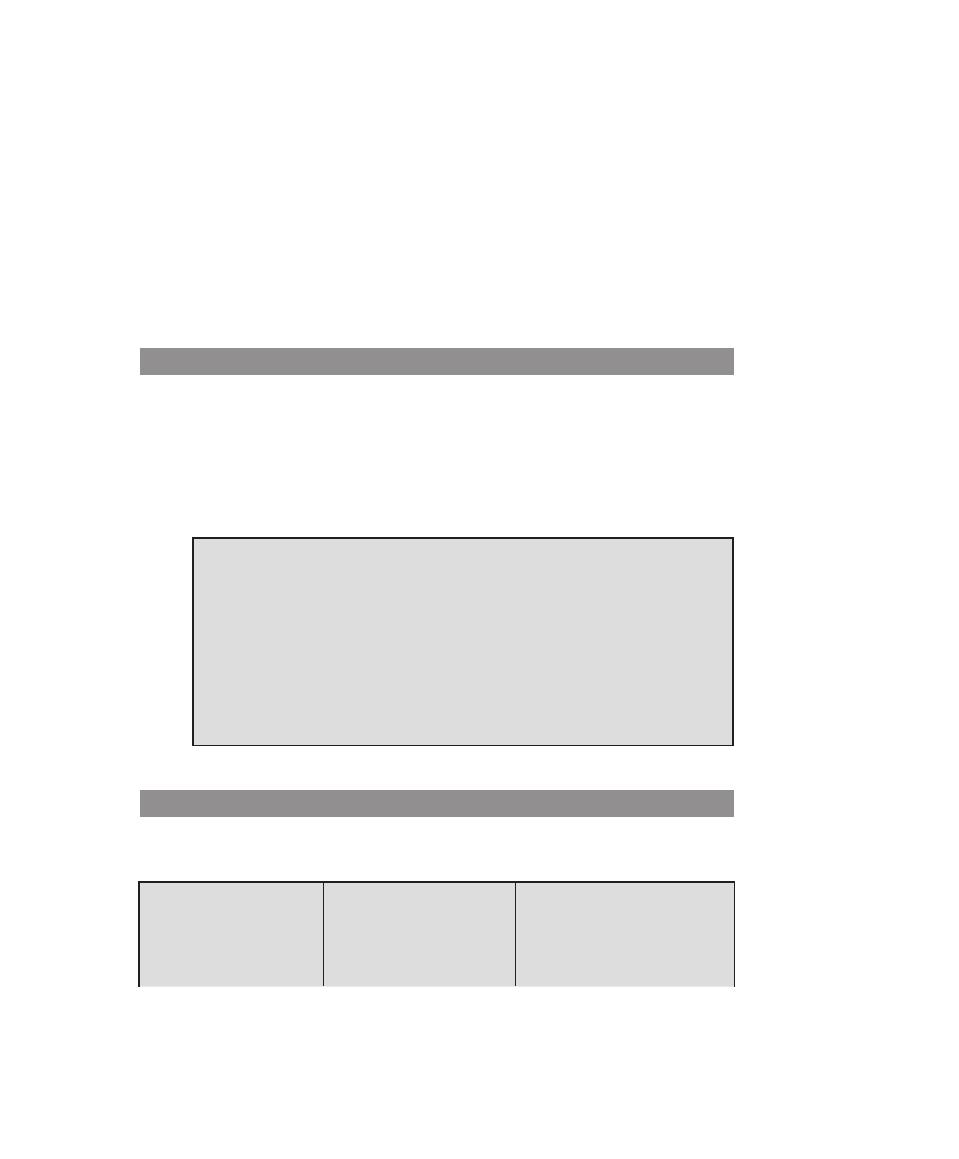

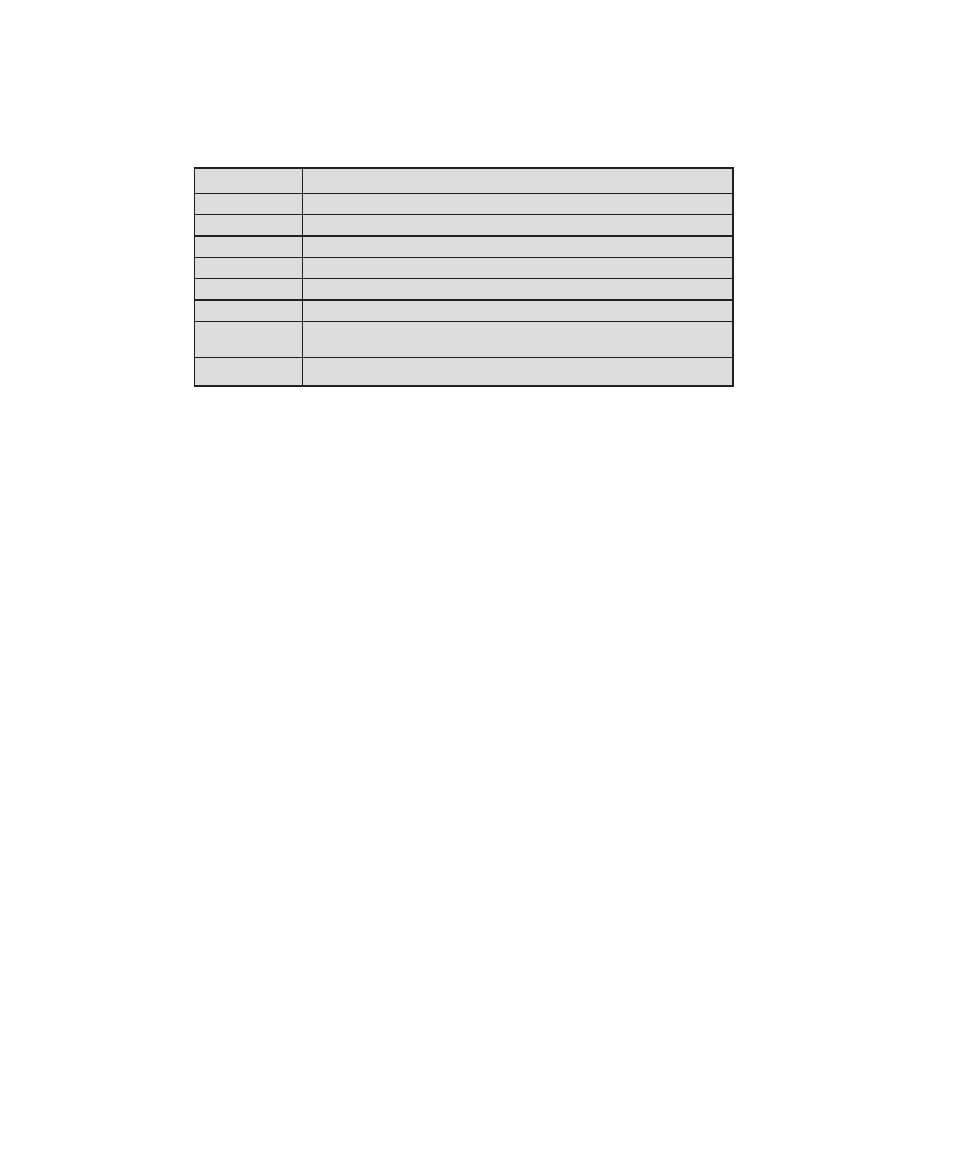

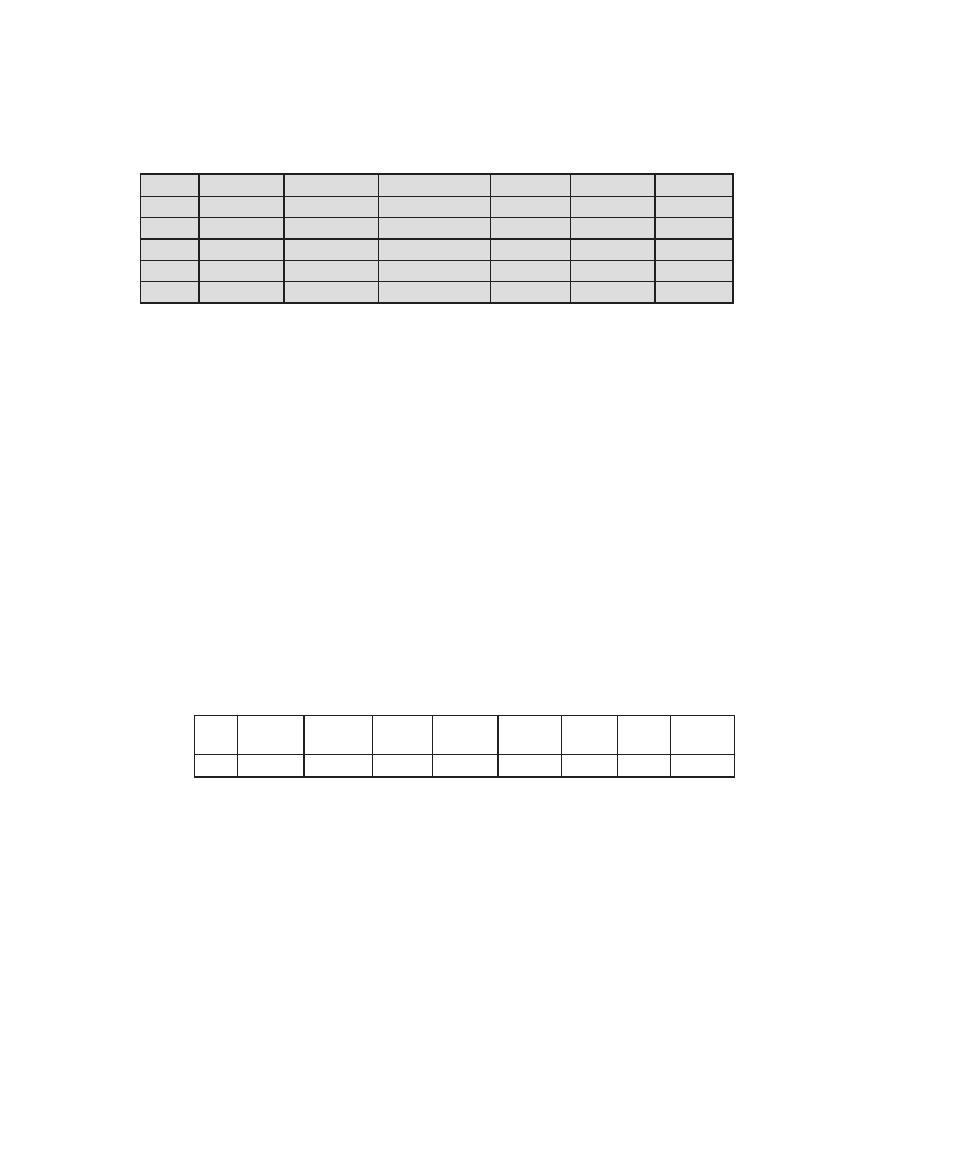

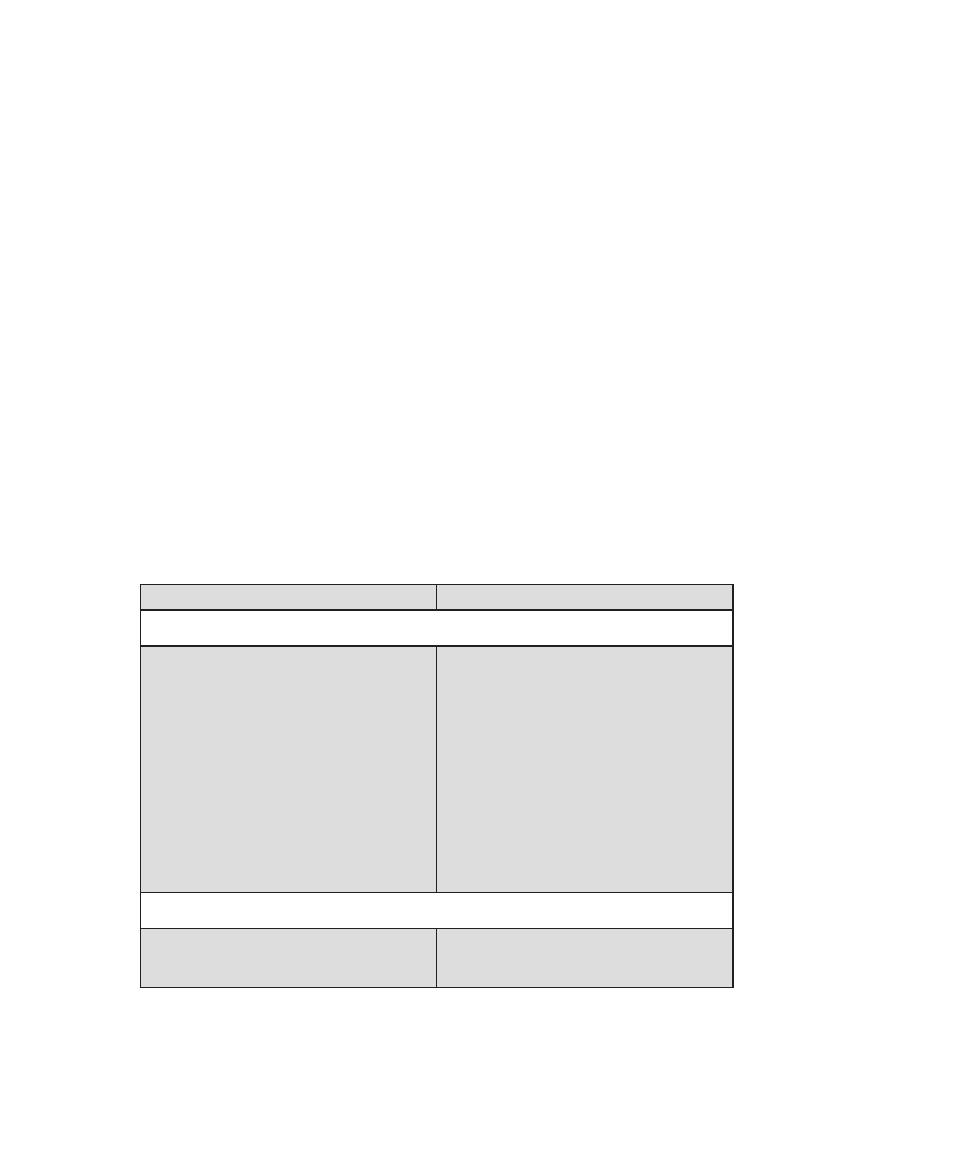

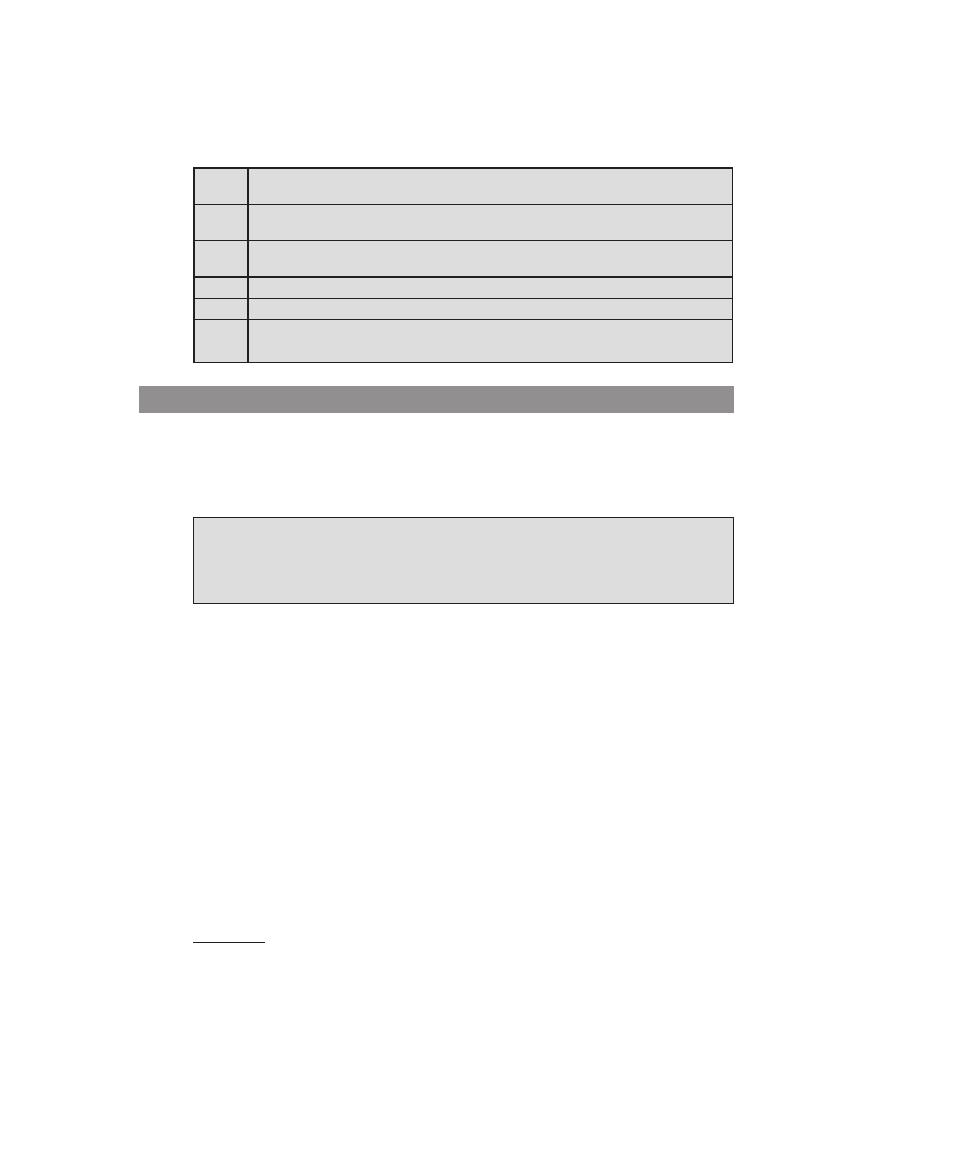

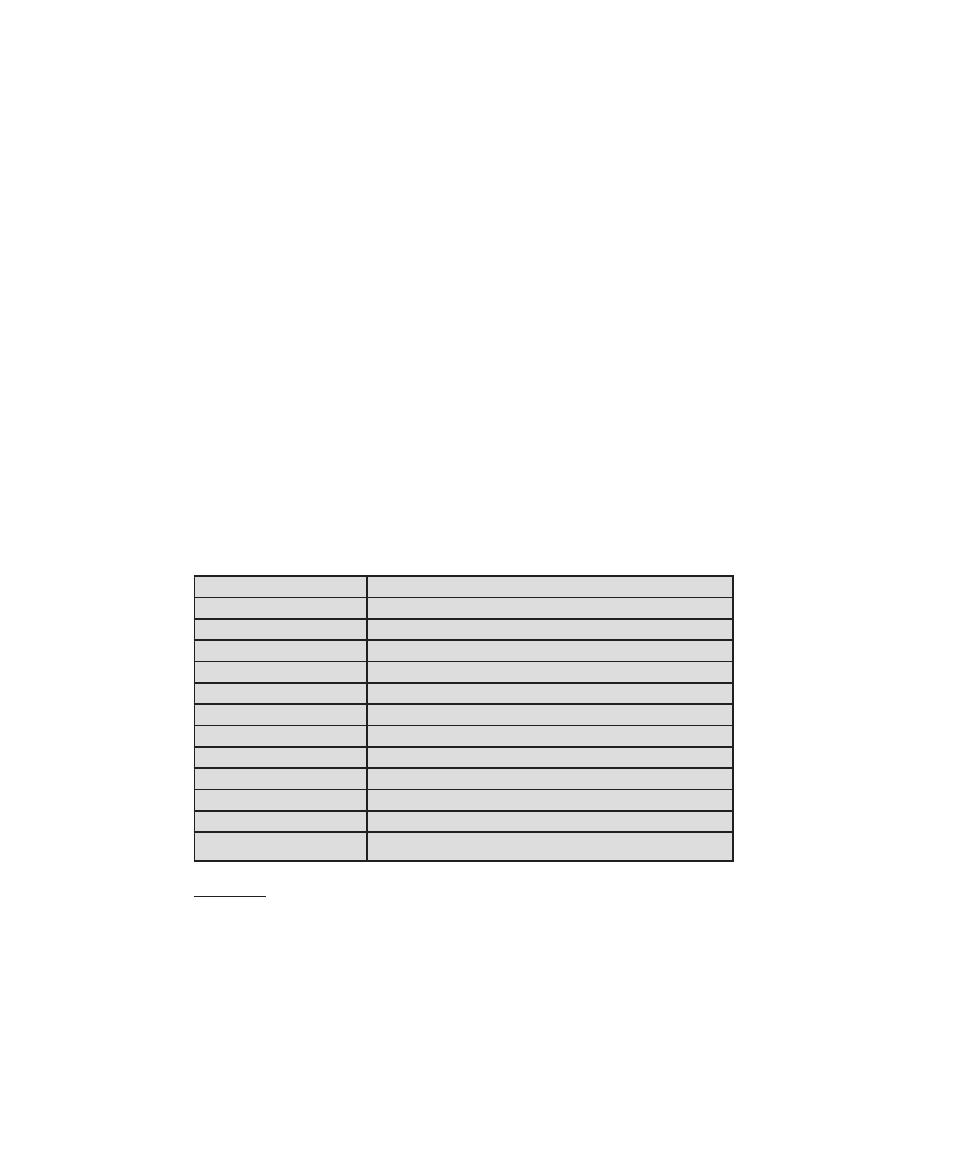

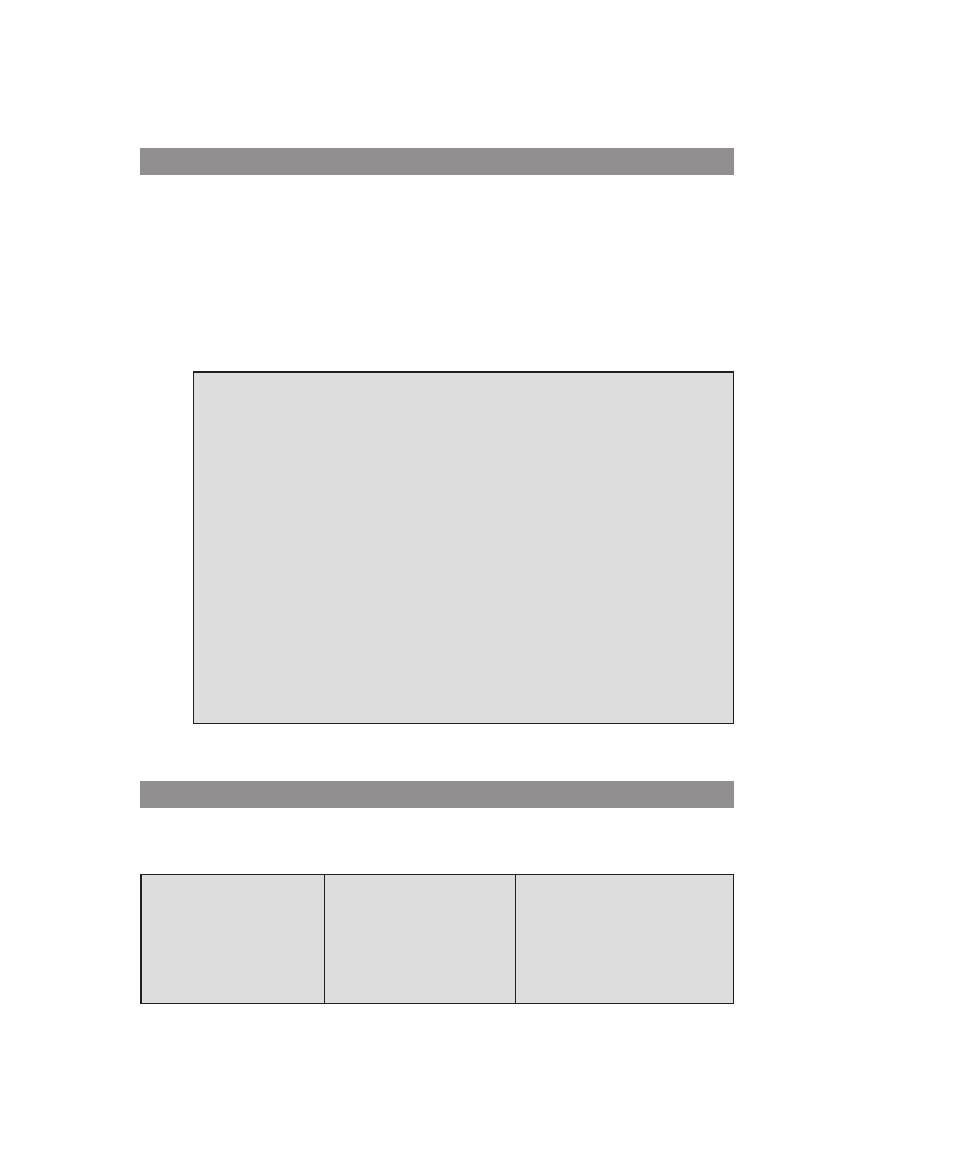

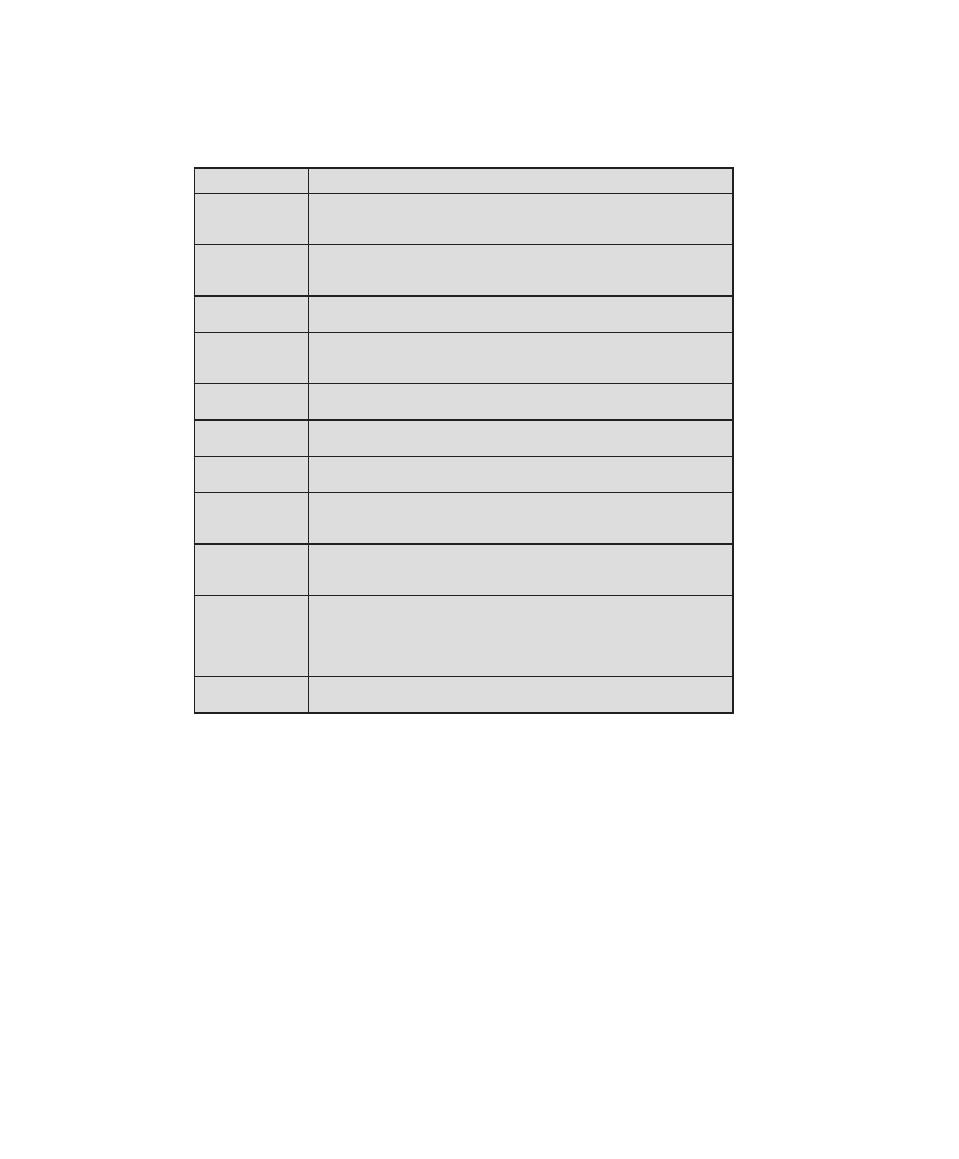

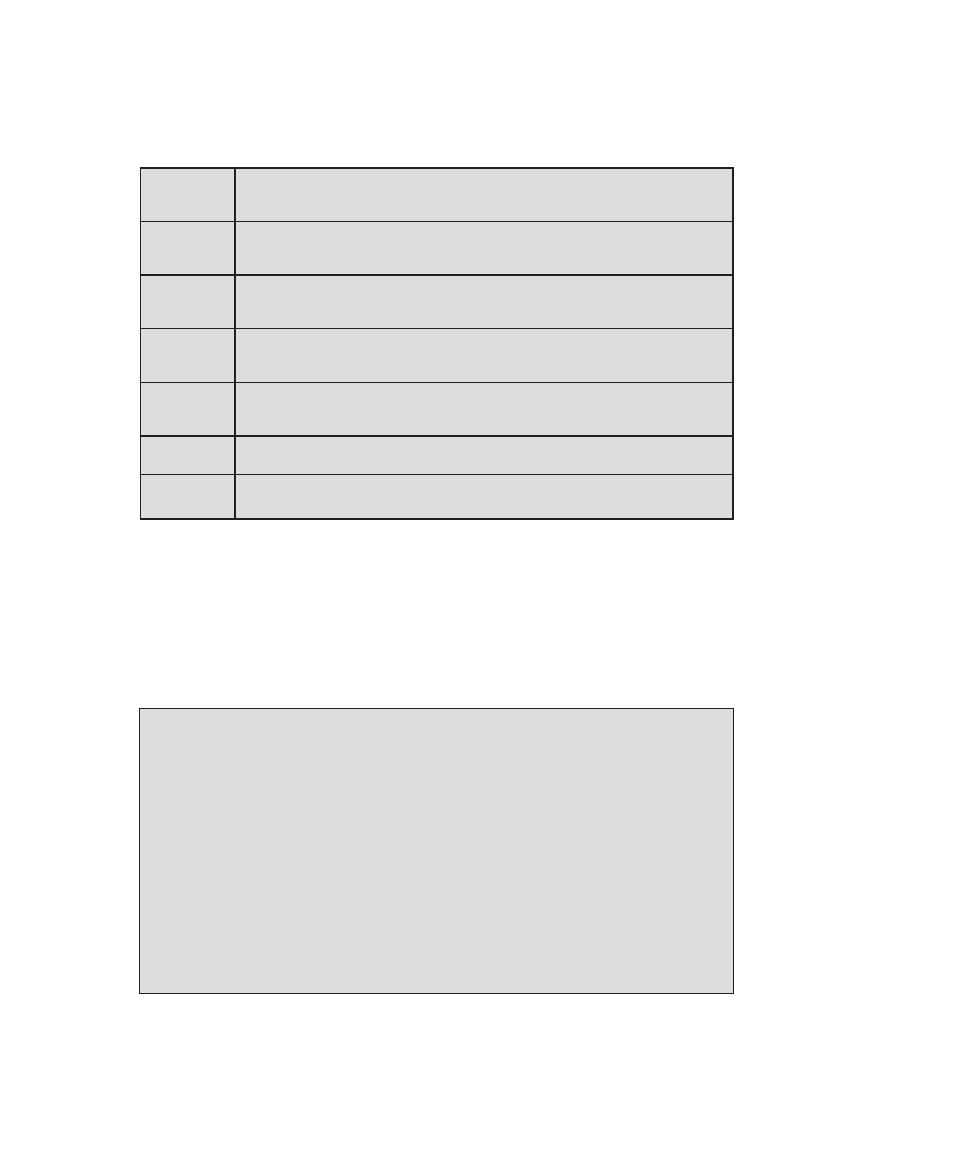

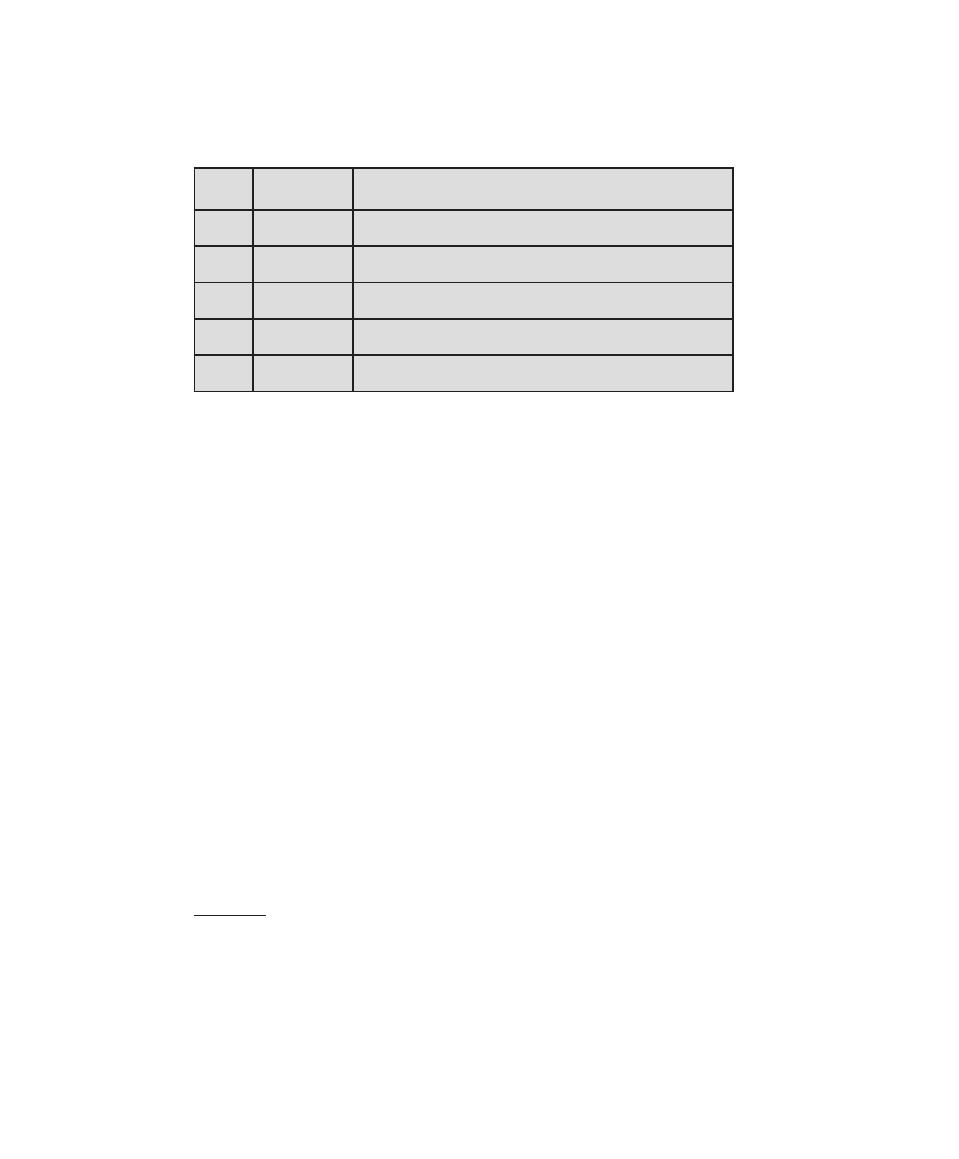

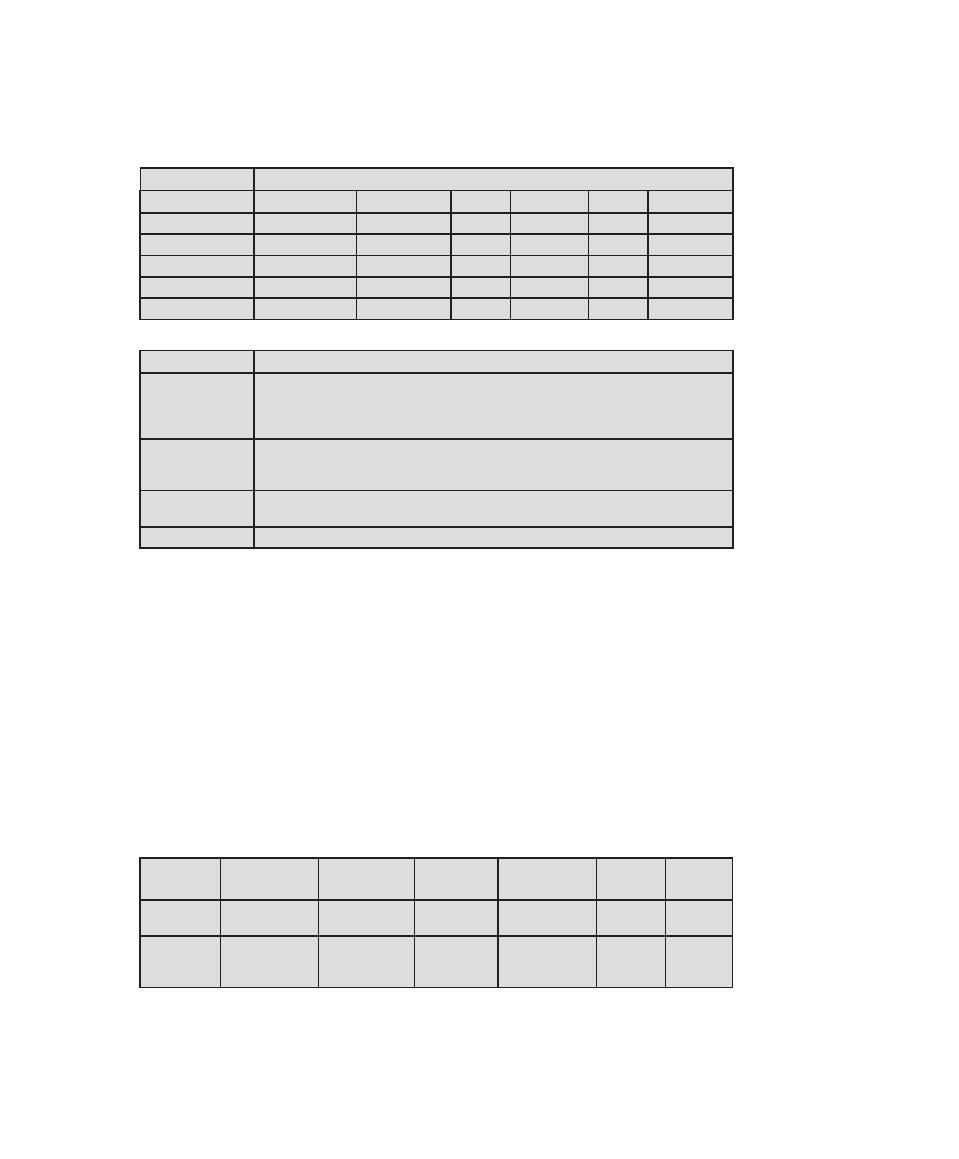

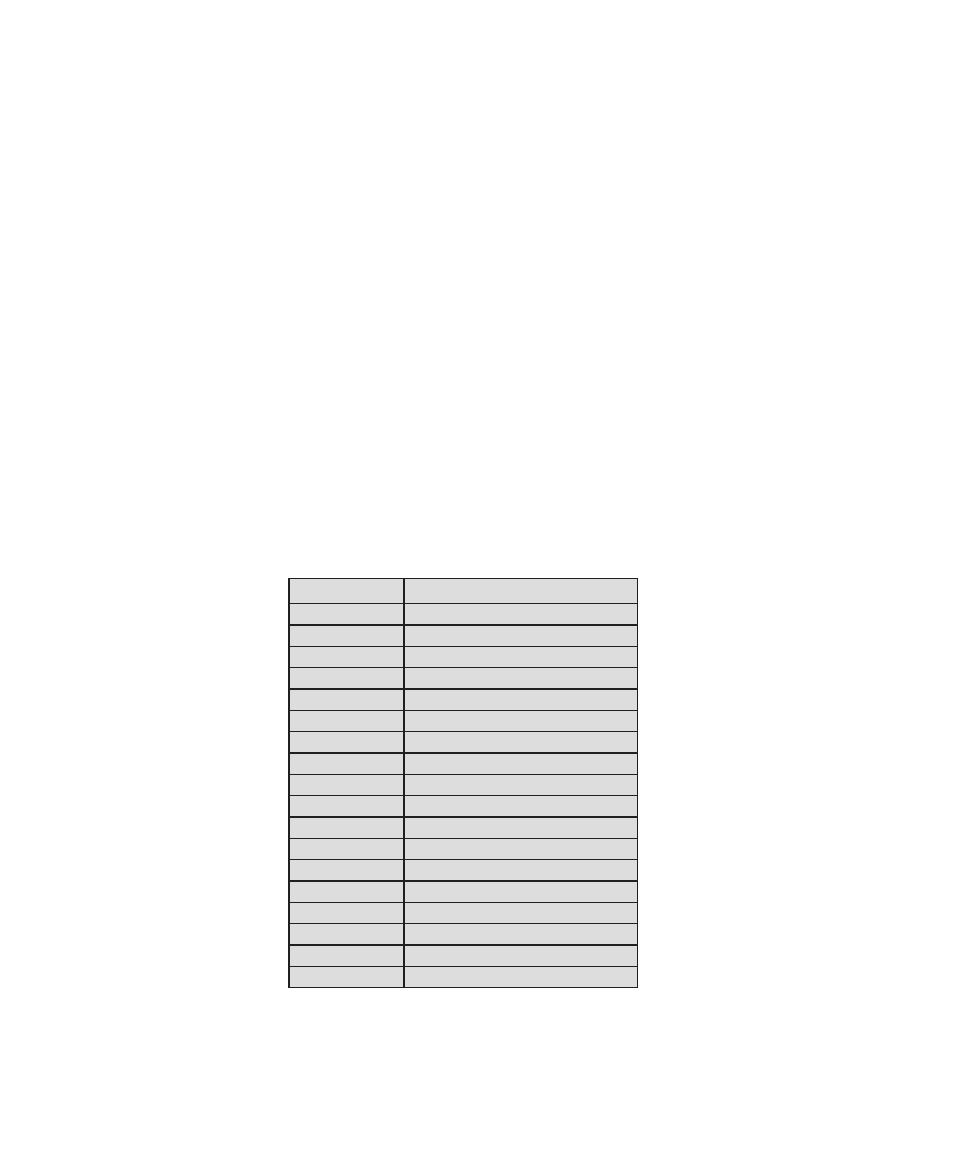

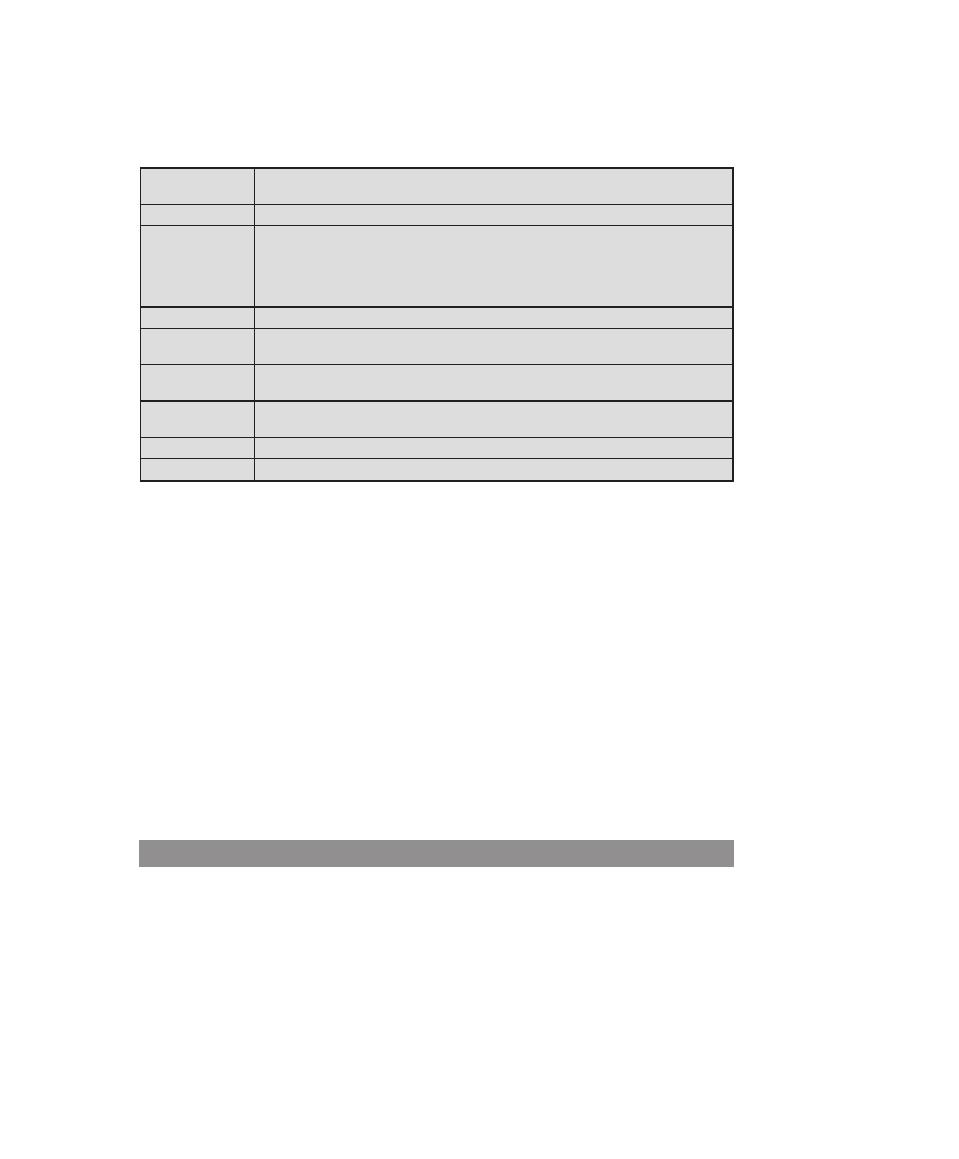

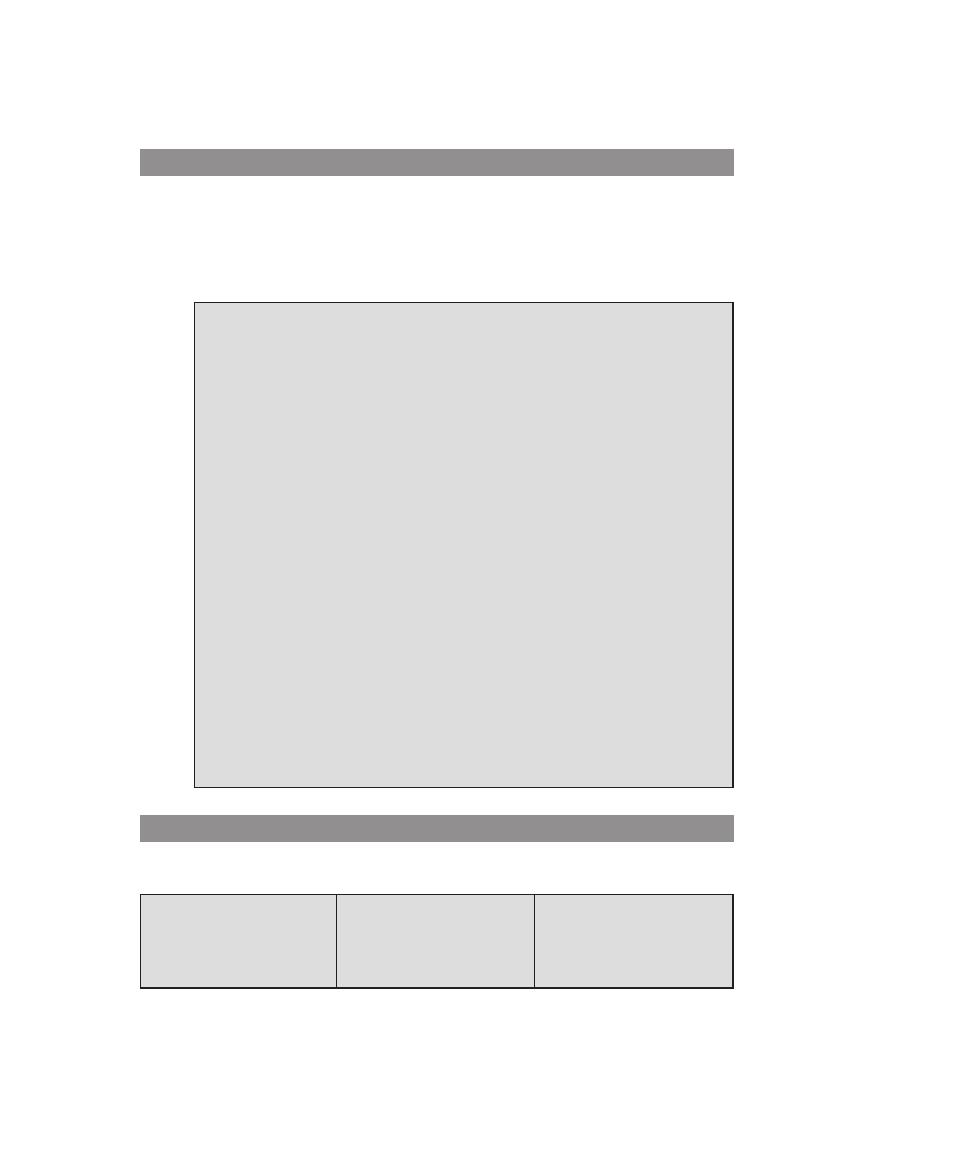

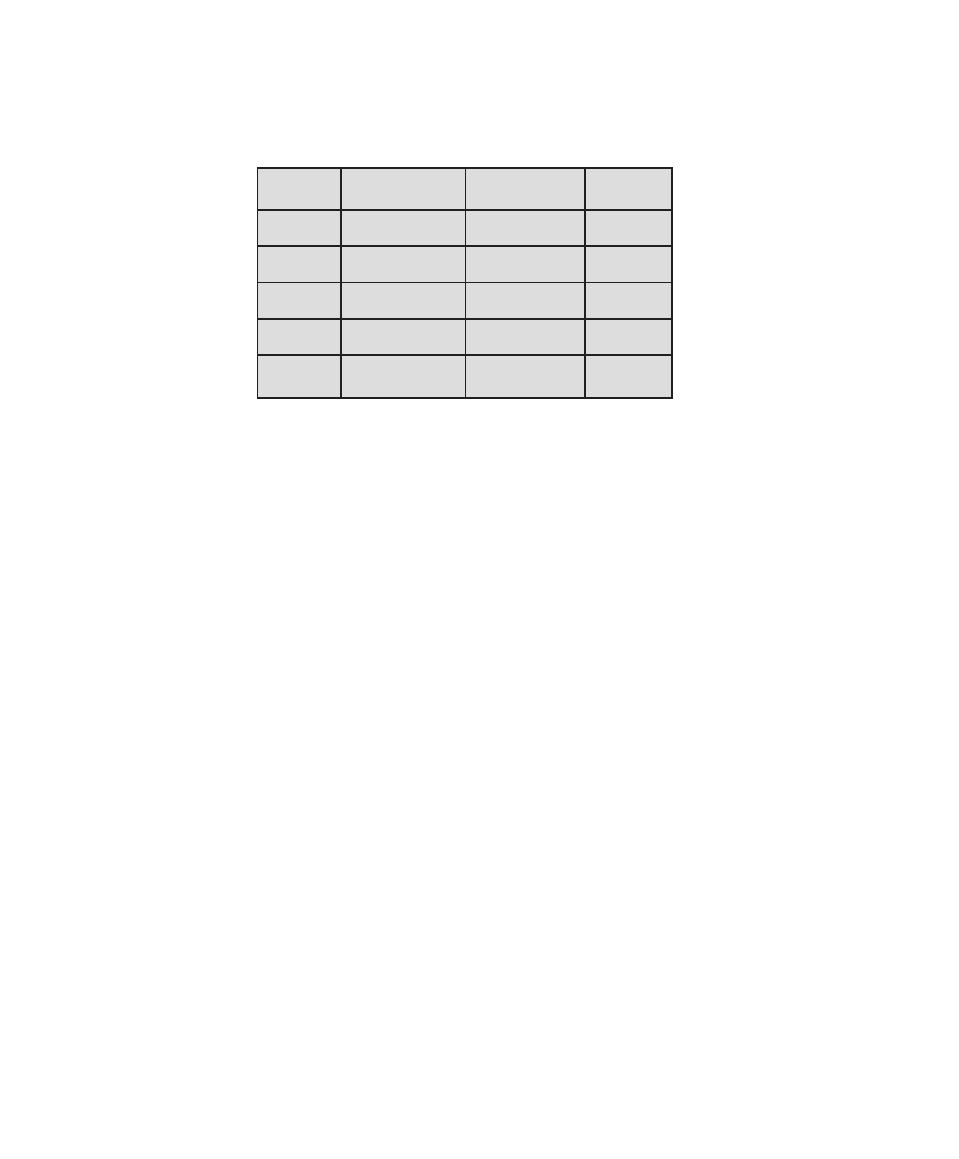

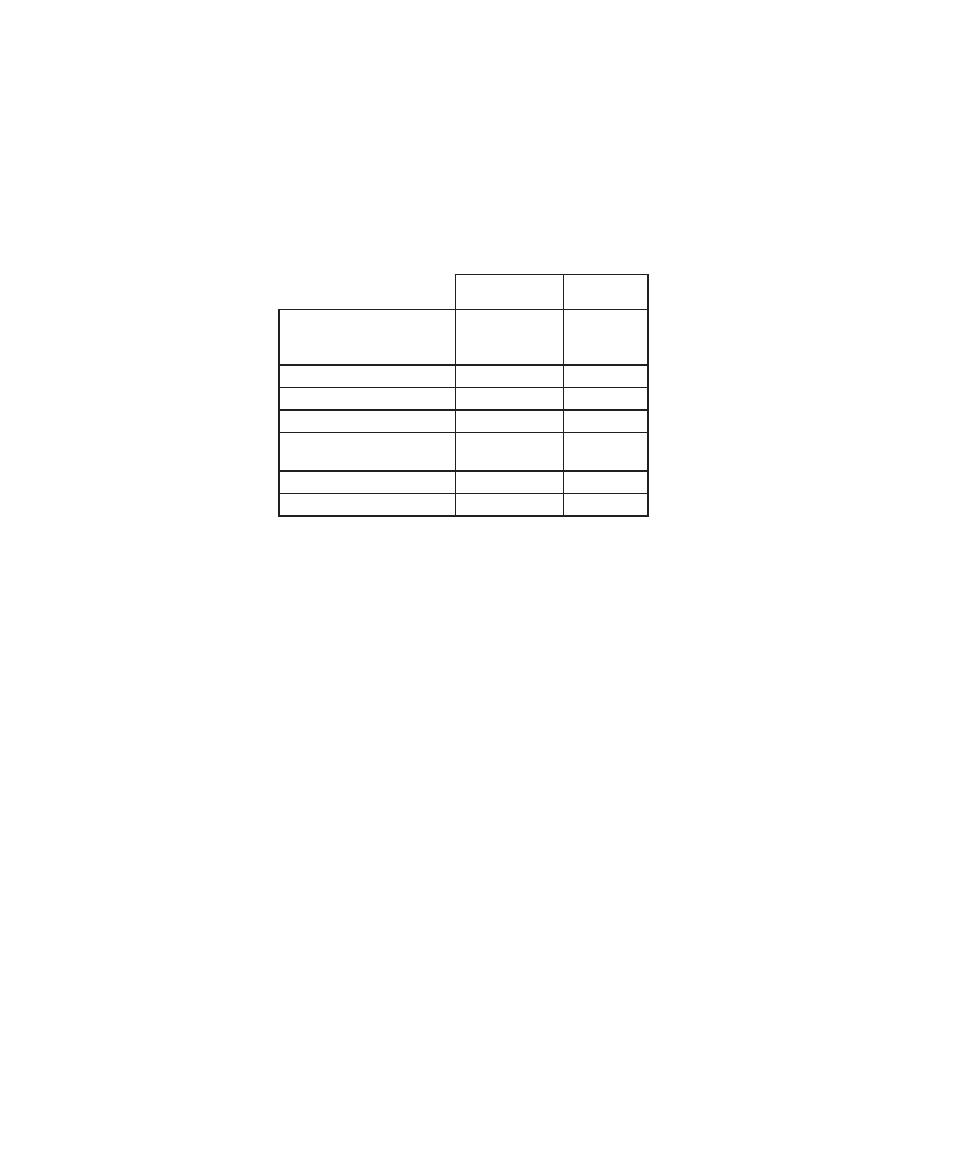

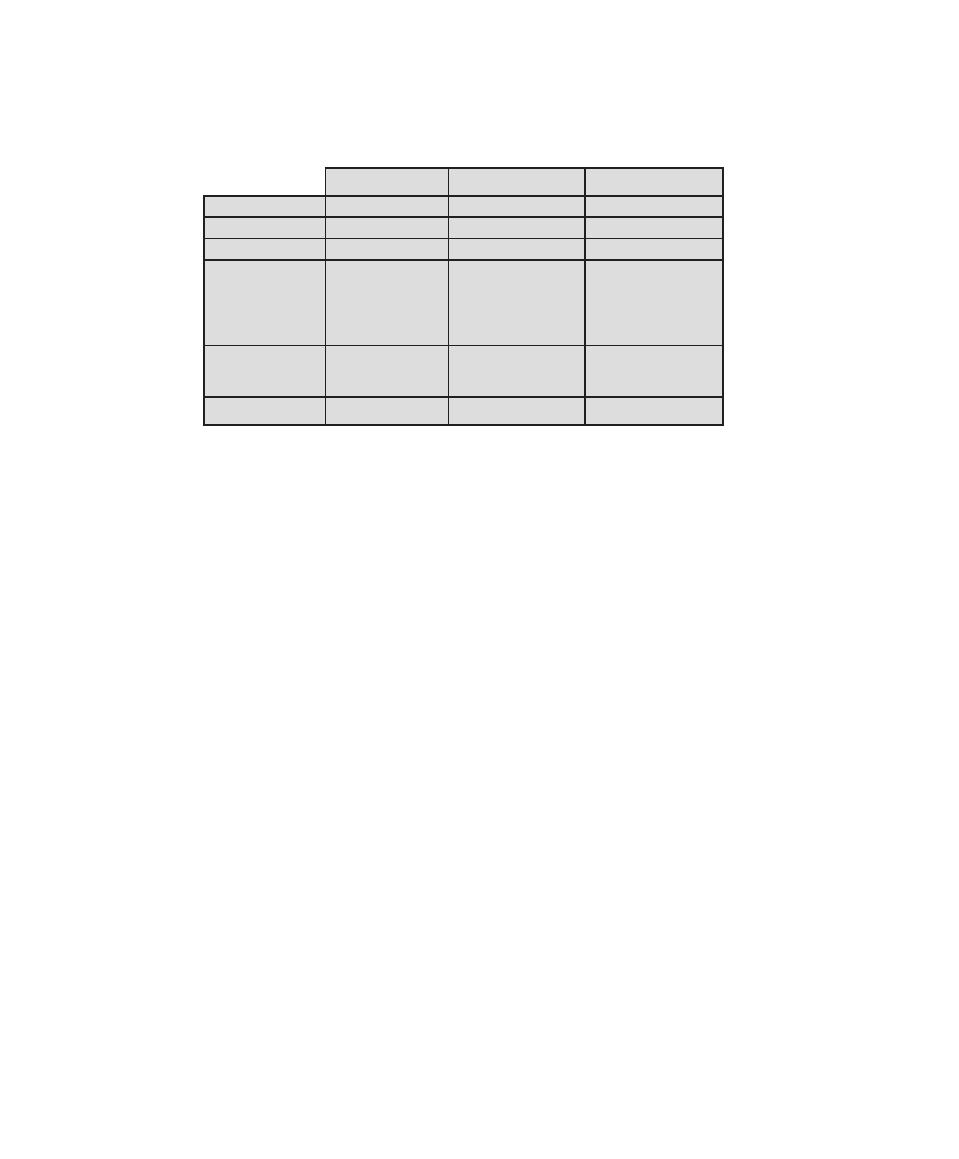

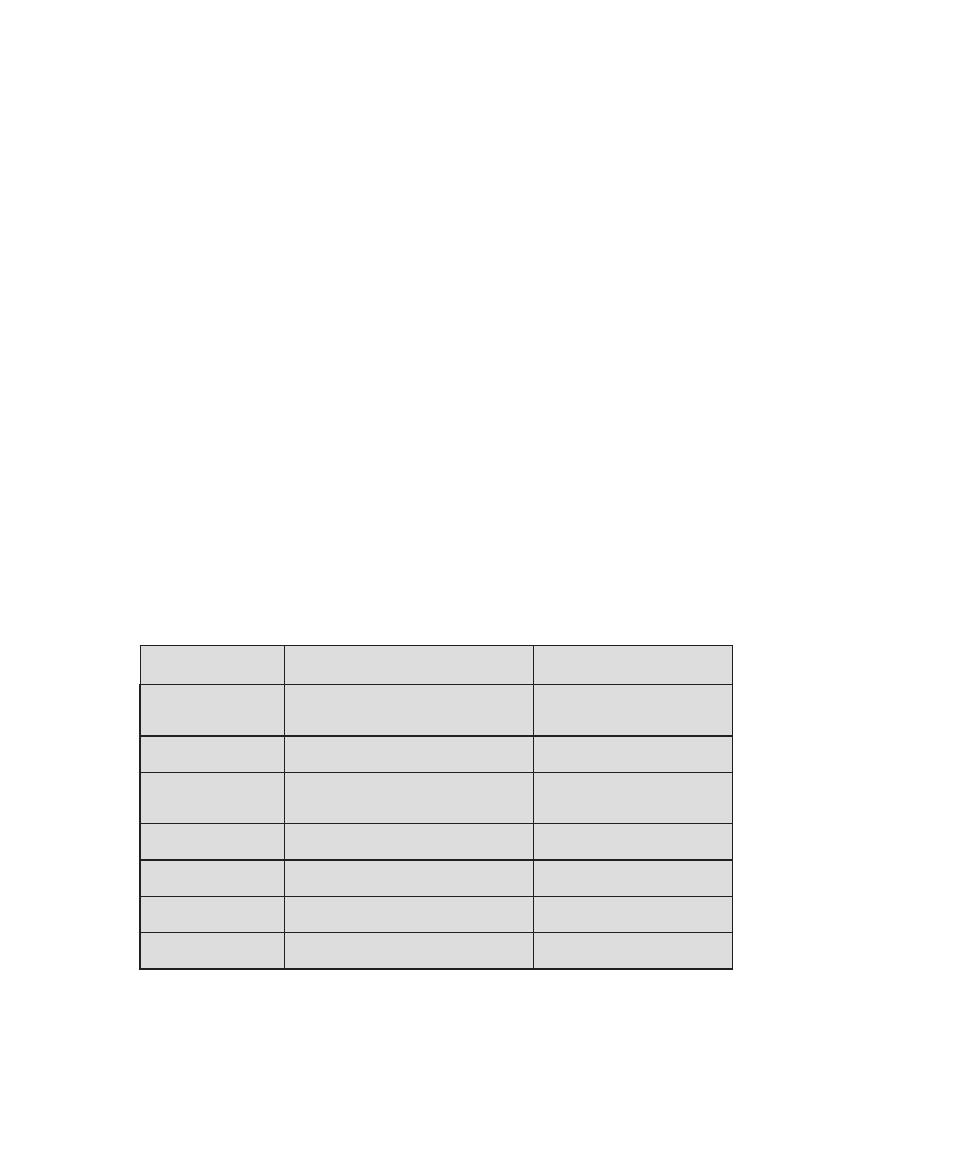

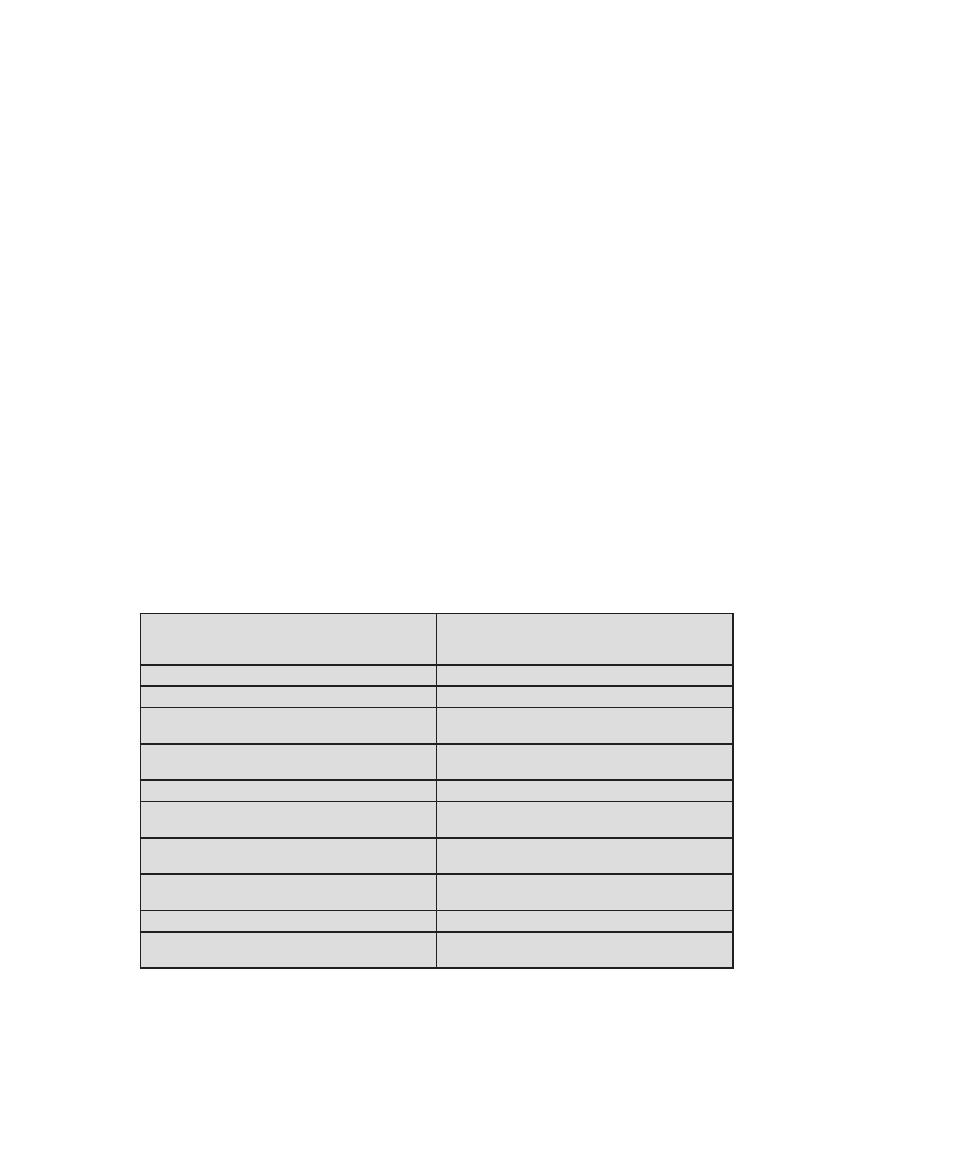

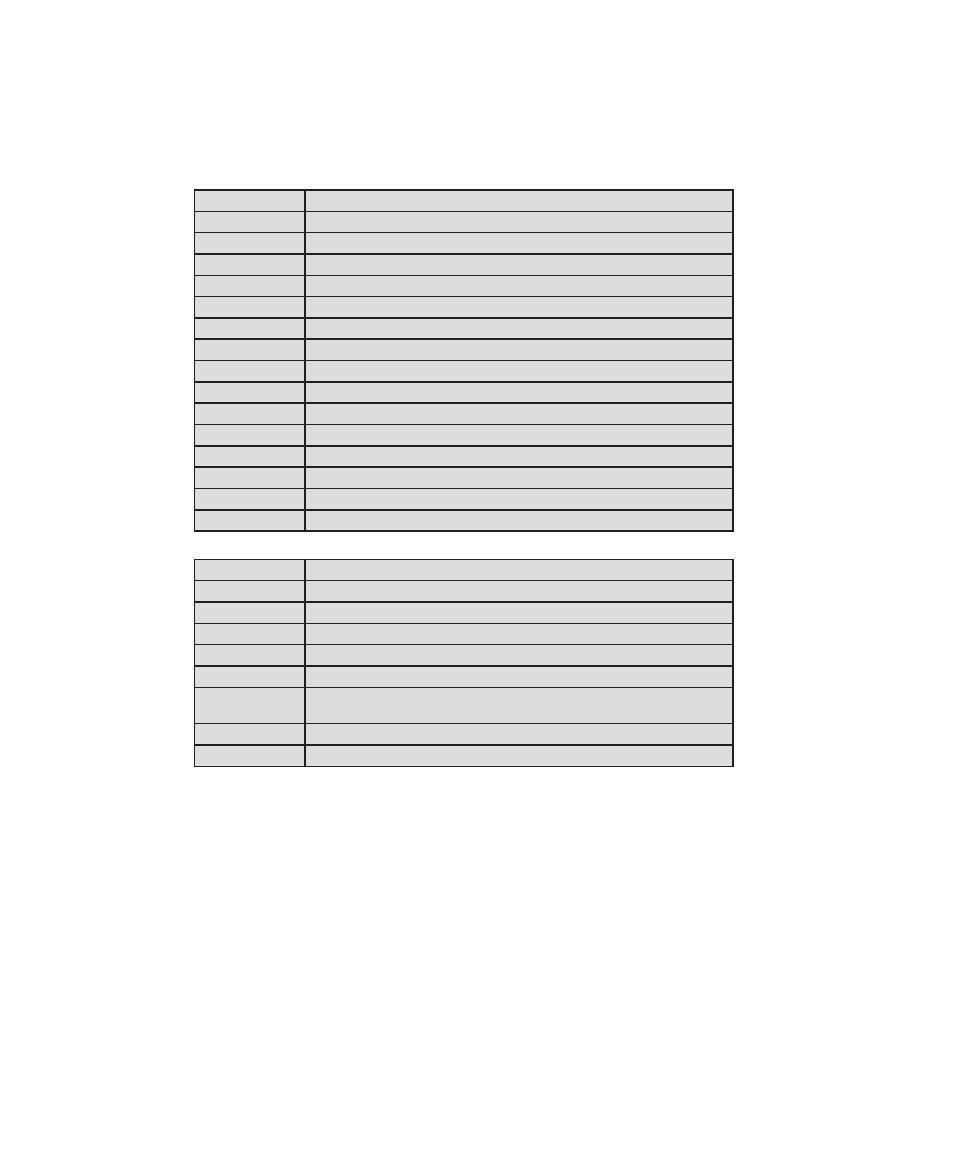

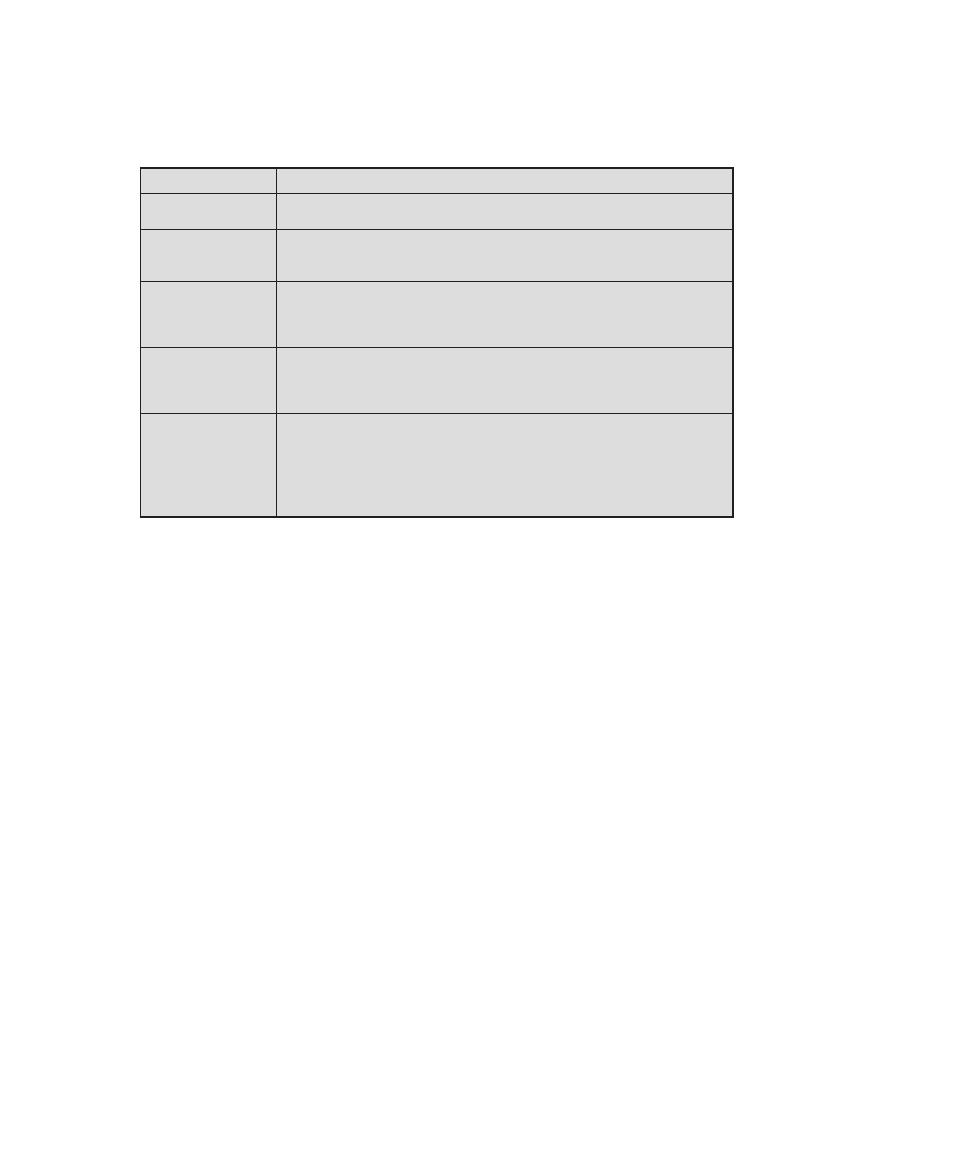

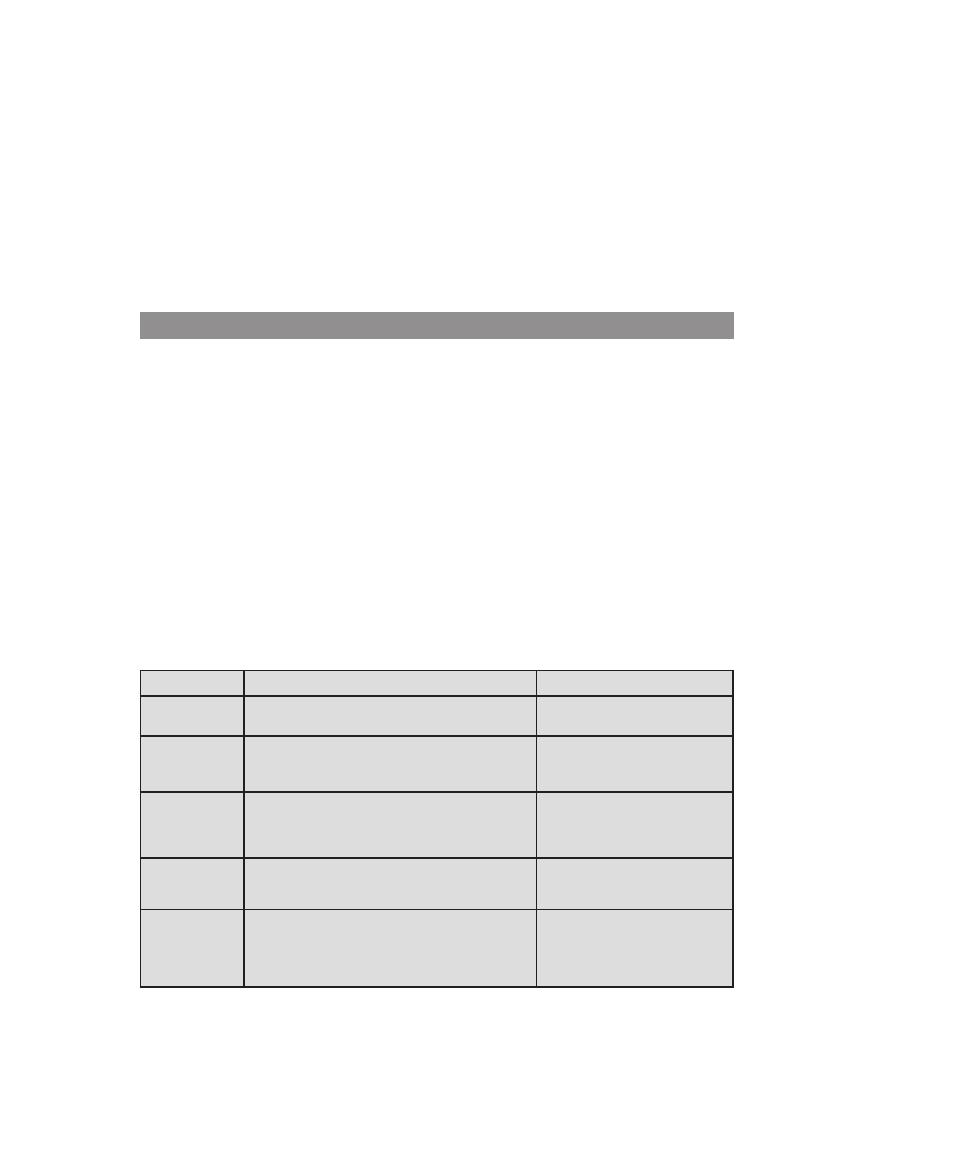

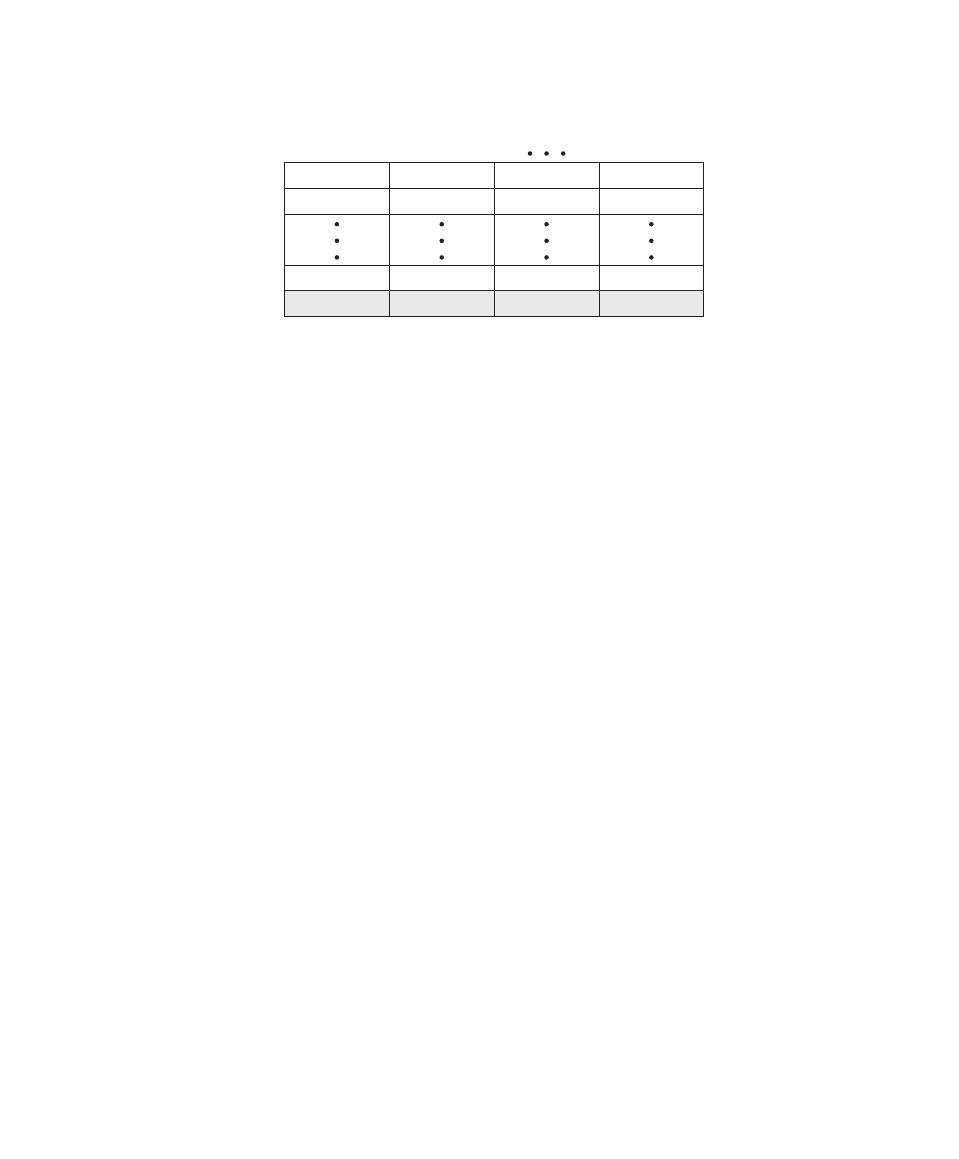

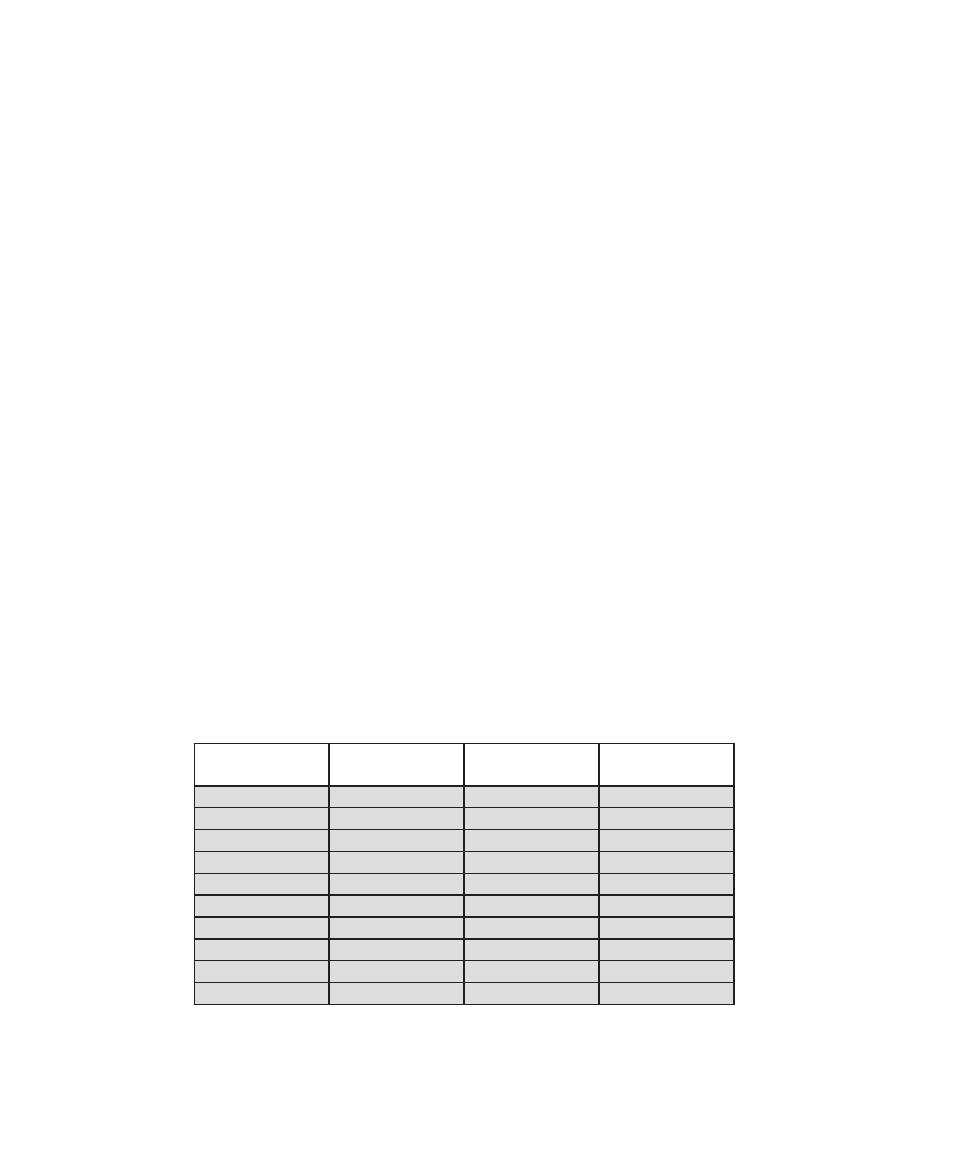

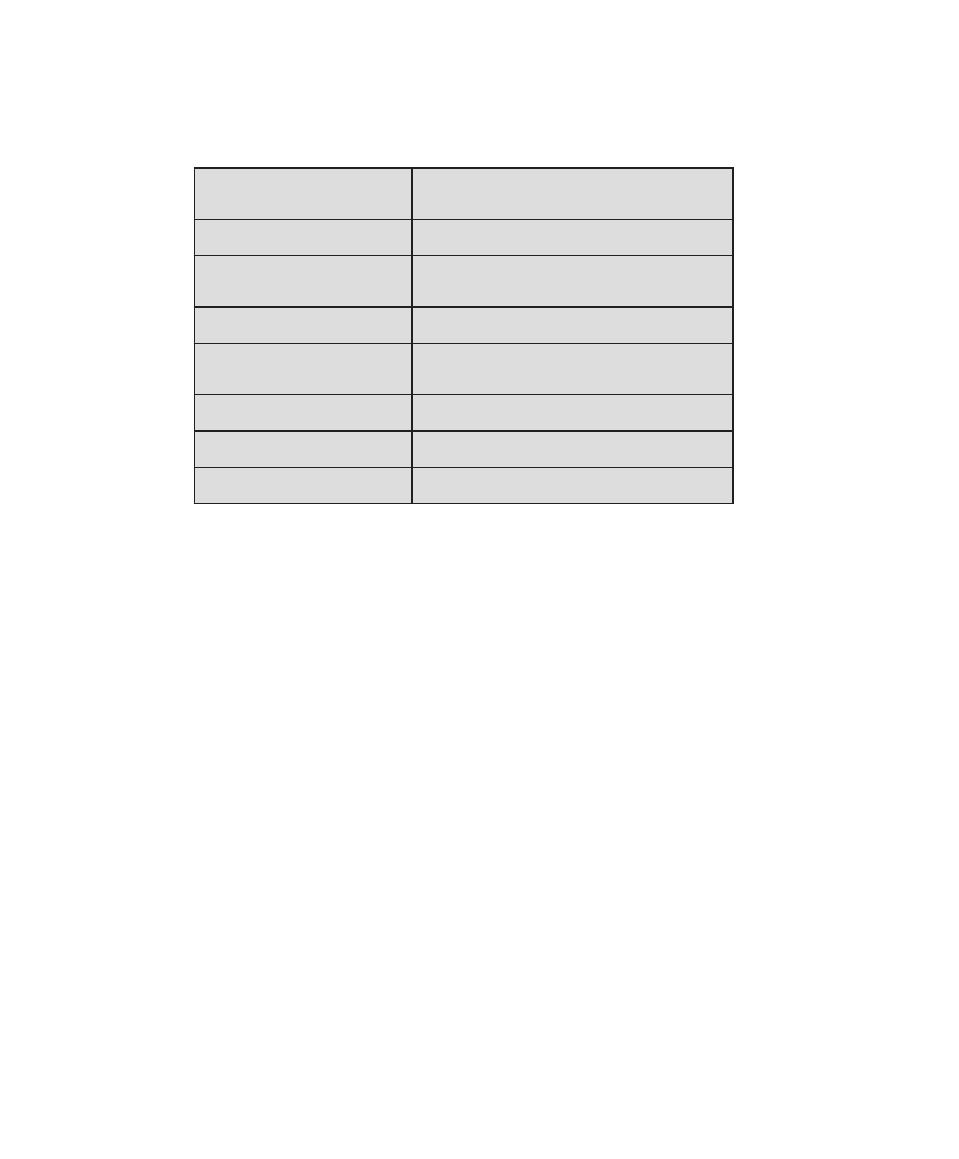

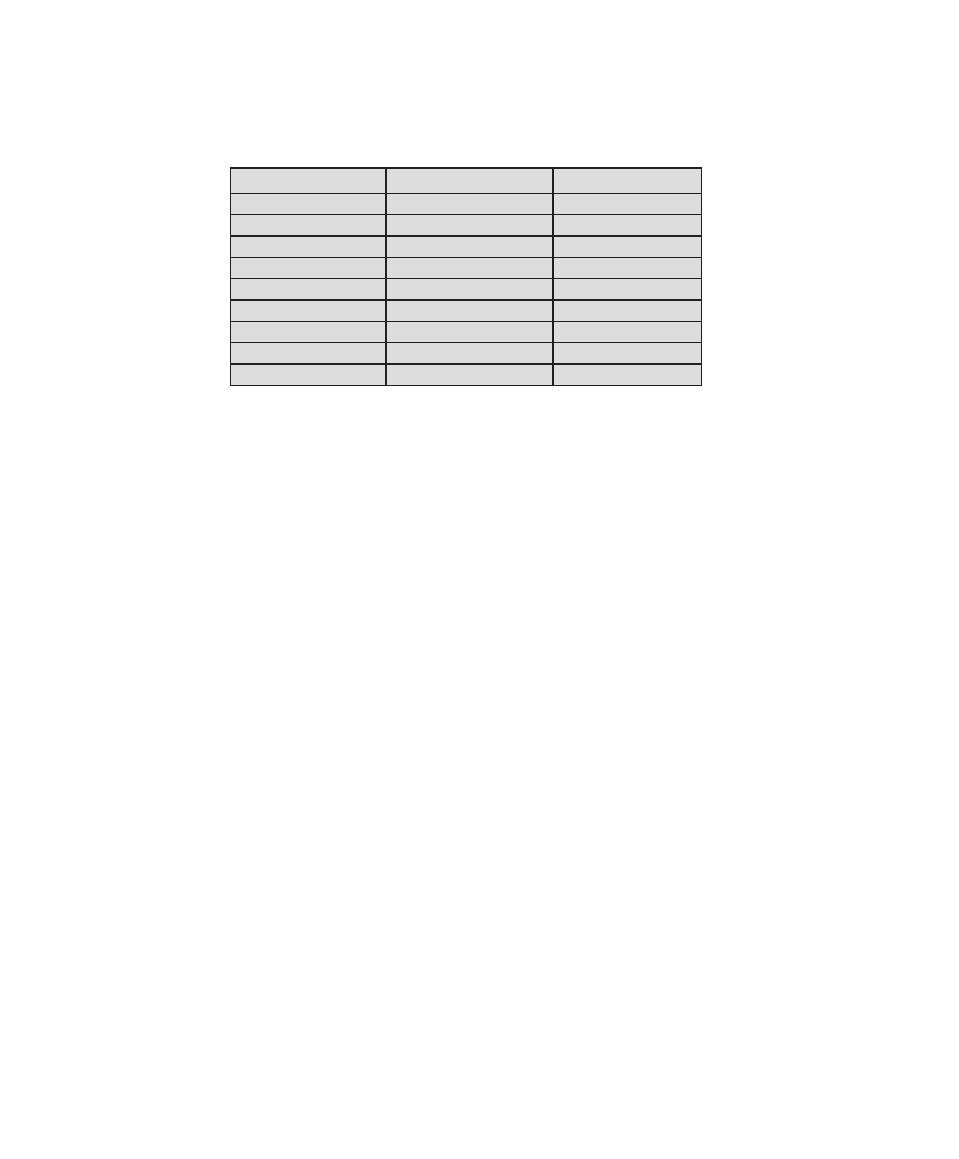

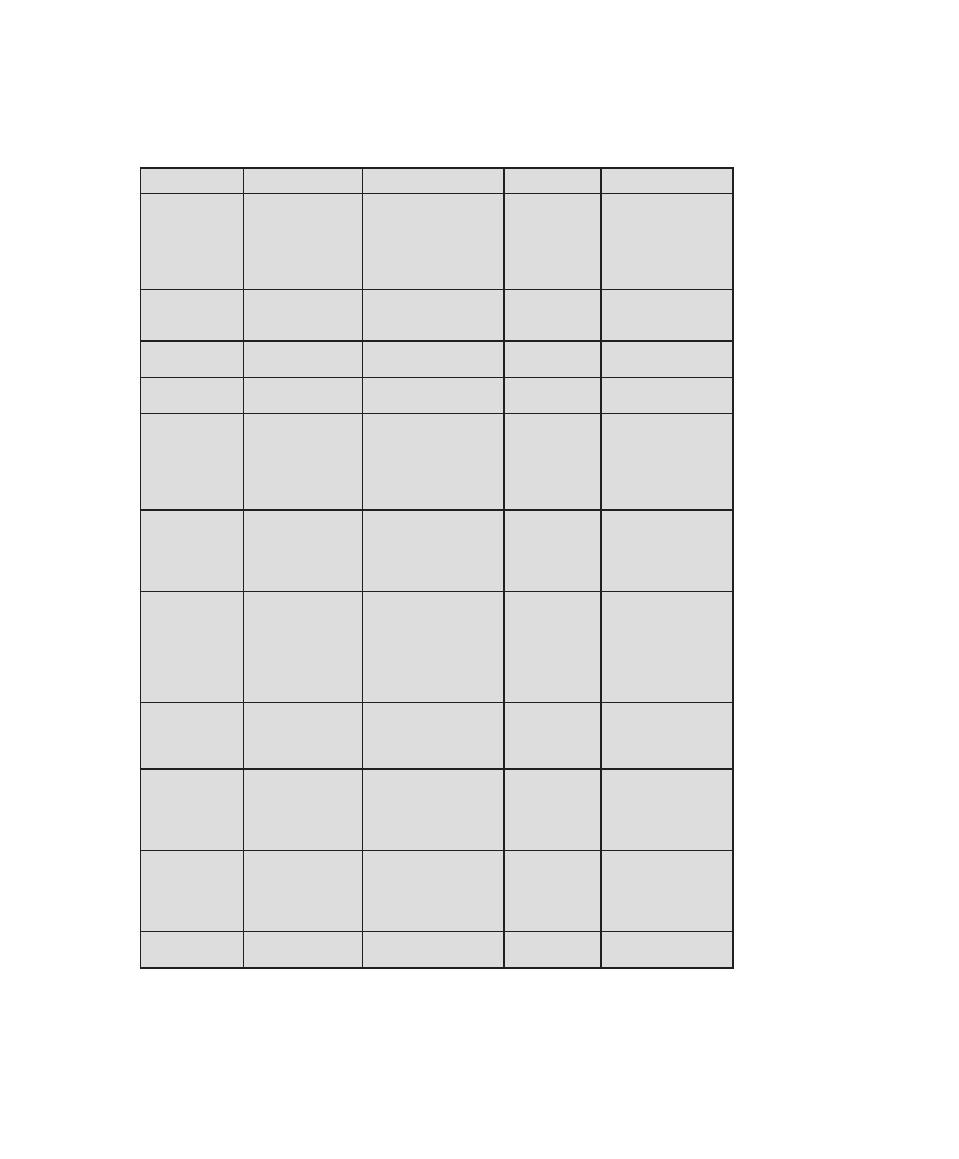

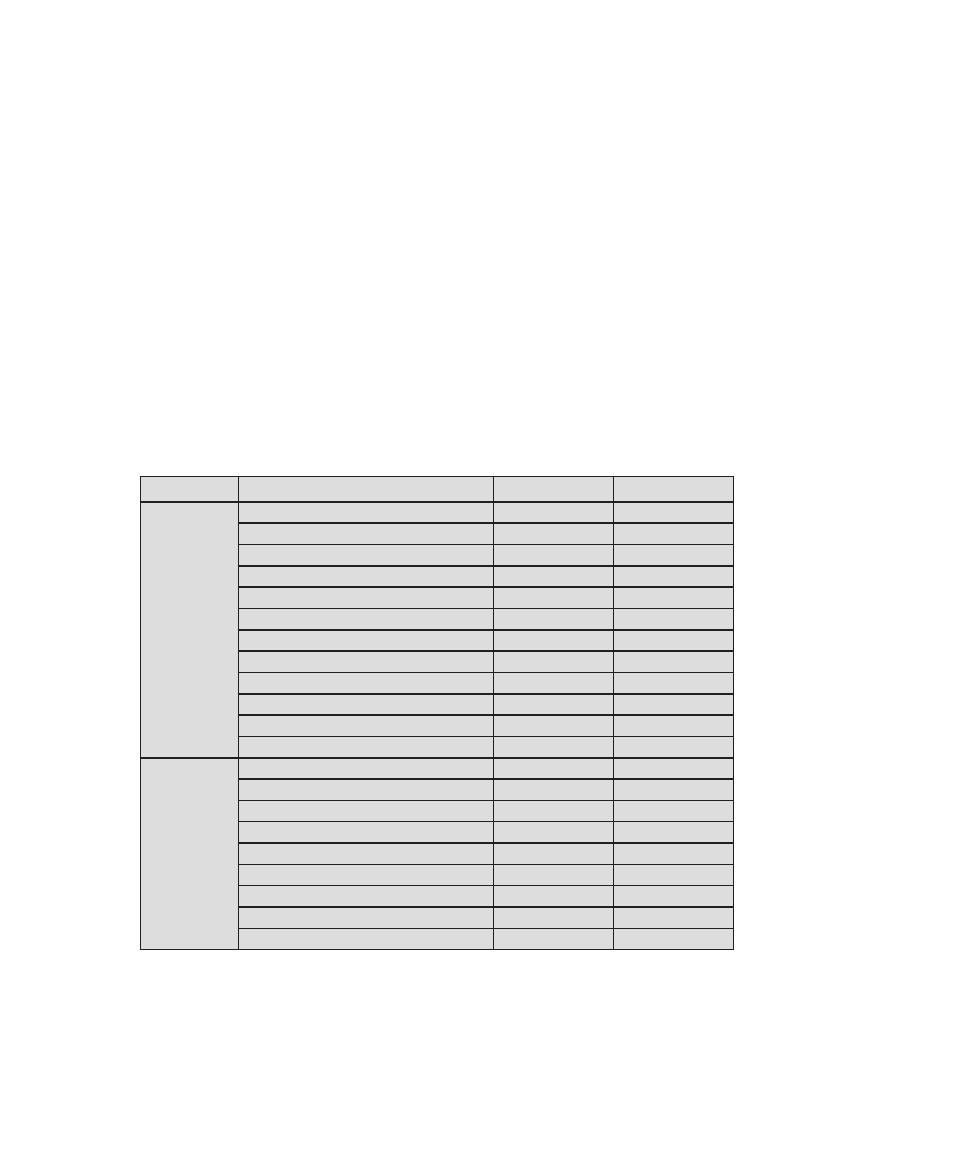

Table 0.1

Coverage of CISSp Domains

CISSp Domain

Key Topics in Domain

Textbook Coverage

Access Control

• Identification, authentication, and

authorization technologies

• Discretionary versus mandatory access

control models

• Rule-based and role-based access

control

4—Access Control

Application

Development

Security

• Software development models

• Database models

• Relational database components

5—Database Security

10—Buffer Overflow

11—Software Security

Business Continuity

and Disaster

Recovery Planning

• Planning

• Roles and responsibilities

• Liability and due care issues

• Business impact analysis

16—Physical and Infrastructure

Security

17—Human Resources Security

Cryptography

• Block and stream ciphers

• Explanation and uses of symmetric

algorithms

• Explanation and uses of asymmetric

algorithms

2—Cryptographic Tools

20—Symmetric Encryption and

Message Confidentiality

21—Public-Key Cryptography and

Message Authentication

Information Security

Governance and Risk

Management

• Types of security controls

• Security policies, standards, procedures,

and guidelines

• Risk management and analysis

14—IT Security Management and

Risk Assessment

15—IT Security Controls, Plans, and

Procedures

Legal, Regulations,

Investigations, and

Compliance

• Privacy laws and concerns

• Computer crime investigation

• Types of evidence

19—Legal and Ethical Aspects

Operations Security

• Operations department responsibilities

• Personnel and roles

• Media library and resource protection

15—IT Security Controls, Plans, and

Procedures

17—Human Resources Security

18—Security Auditing

Physical

(Environmental)

Security

• Facility location and construction issues

• Physical vulnerabilities and threats

• Perimeter protection

16—Physical and Infrastructure

Security

Security Architecture

and Design

• Critical components

• Access control models

• Certification and accreditation

13—Trusted Computing and

Multilevel Security

Telecommunications

and Network Security

• TCP/IP protocol suite

• LAN, MAN, and WAN technologies

• Firewall types and architectures

Appendix F—TCP/IP Protocol

Architecture

22—Internet Security Protocols and

Standards

24—Wireless Network Security

0.4 / support For nsa/dhs CertIFICatIon

5

The 10 domains are as follows:

•

Access control: A collection of mechanisms that work together to create a

security architecture to protect the assets of the information system.

•

Application development security: Addresses the important security concepts

that apply to application software development. It outlines the environment

where software is designed and developed and explains the critical role soft-

ware plays in providing information system security.

•

Business continuity and disaster recovery planning: For the preservation and

recovery of business operations in the event of outages.

•

Cryptography: The principles, means, and methods of disguising information

to ensure its integrity, confidentiality, and authenticity.

•

Information security governance and risk management: The identification

of an organization’s information assets and the development, documenta-

tion, and implementation of policies, standards, procedures, and guidelines.

Management tools such as data classification and risk assessment/analysis are

used to identify threats, classify assets, and to rate system vulnerabilities so

that effective controls can be implemented.

•

Legal, regulations, investigations, and compliance: The types of computer

crime laws and regulations. The measures and technologies used to investigate

computer crime incidents.

•

Operations security: Used to identify the controls over hardware, media,

and the operators and administrators with access privileges to any of these

resources. Audit and monitoring are the mechanisms, tools, and facilities that

permit the identification of security events and subsequent actions to identify

the key elements and report the pertinent information to the appropriate indi-

vidual, group, or process.

•

physical (environmental) security: Provides protection techniques for the

entire facility, from the outside perimeter to the inside office space, including

all of the information system resources.

•

Security architecture and design: Contains the concepts, principles, structures,

and standards used to design, monitor, and secure operating systems, equip-

ment, networks, applications, and those controls used to enforce various levels

of availability, integrity, and confidentiality.

•

Telecommunications and network security: Covers network structures; trans-

mission methods; transport formats; security measures used to provide avail-

ability, integrity, and confidentiality; and authentication for transmissions over

private and public communications networks and media.

In this book, we cover each of these domains in some depth.

0.4 suppORt fOR nsA/dhs ceRtificAtiOn

The U.S. National Security Agency (NSA) and the U.S. Department of Homeland

Security (DHS) jointly sponsor the National Centers of Academic Excellence in

Information Assurance/Cyber Defense (IA/CD). The goal of these programs is

6

Chapter 0 / reader’s and InstruCtor’s GuIde

to reduce vulnerability in our national information infrastructure by promoting

higher education and research in IA and producing a growing number of profes-

sionals with IA expertise in various disciplines. To achieve that purpose, NSA/DHS

have defined a set of Knowledge Units for 2- and 4-year institutions that must be

supported in the curriculum to gain a designation as a NSA/DHS National Center

of Academic Excellence in IA/CD. Each Knowledge Unit is composed of a mini-

mum list of required topics to be covered and one or more outcomes or learning

objectives. Designation is based on meeting a certain threshold number of core and

optional Knowledge Units.

In the area of computer security, the 2014 Knowledge Units document

[NCAE13] lists the following core Knowledge Units:

•

Cyber defense: Includes access control, cryptography, firewalls, intrusion de-

tection systems, malicious activity detection and countermeasures, trust rela-

tionships, and defense in depth.

•

Cyber threats: Includes types of attacks, legal issues, attack surfaces, attack

trees, insider problems, and threat information sources.

•

Fundamental security design principles: A list of 12 principles, all of which are

covered in Section 1.4 of this book.

•

Information assurance fundamentals: Includes threats and vulnerabilities,

intrusion detection and prevention systems, cryptography, access control

models, identification/authentication, and audit.

•

Introduction to cryptography: Includes symmetric cryptography, public-key

cryptography, hash functions, and digital signatures.

•

Databases: Includes an overview of databases, database access controls, and

security issues of inference.

This book provides extensive coverage in all of these areas. In addition, the

book partially covers a number of the optional Knowledge Units.

0.5 suppORt fOR Acm/ieee cOmputeR sOciety

cOmputeR science cuRRiculA 2013

Computer Science Curricula 2013

(CS2013) is a joint effort of the Association

for Computing Machinery (ACM) and the Computer Society of the Institute of

Electrical and Electronics Engineers (IEEE-CS). ACM and IEEE-CS have col-

laborated on developing recommended computer science curricula starting with

the publication of Curriculum 68. CS2013 is the first comprehensive revision of the

recommendation since 2001. Hundreds of computer science professors, department

chairs, and directors of undergraduate studies worldwide were involved in develop-

ing CS2013. There was a wide consensus that a strong need existed to add a new

Knowledge Area on Information Assurance and Security (IAS).

IAS as a domain is the set of controls and processes, both technical and policy,

intended to protect and defend information and information systems by ensuring

their availability, integrity, authentication, and confidentiality and providing for

non-repudiation. The concept of assurance also carries an attestation that current

0.5 / support For aCM/Ieee CoMputer soCIety

7

and past processes and data are valid. Both assurance and security concepts are

needed to ensure a complete perspective.

CS2013 divides all course work into three categories: Core-Tier 1 (all topics

should be included in the curriculum), Core-Tier-2 (all or almost all topics should

be included), and Elective (desirable to provide breadth and depth). In the IAS

area, CS2013 includes three Tier 1 topics, five Tier 2 topics, and numerous Elective

topics, each of which has a number of subtopics. This text covers all of the Tier 1

and Tier 2 topics and subtopics listed by CS2013, as well as many of the elective

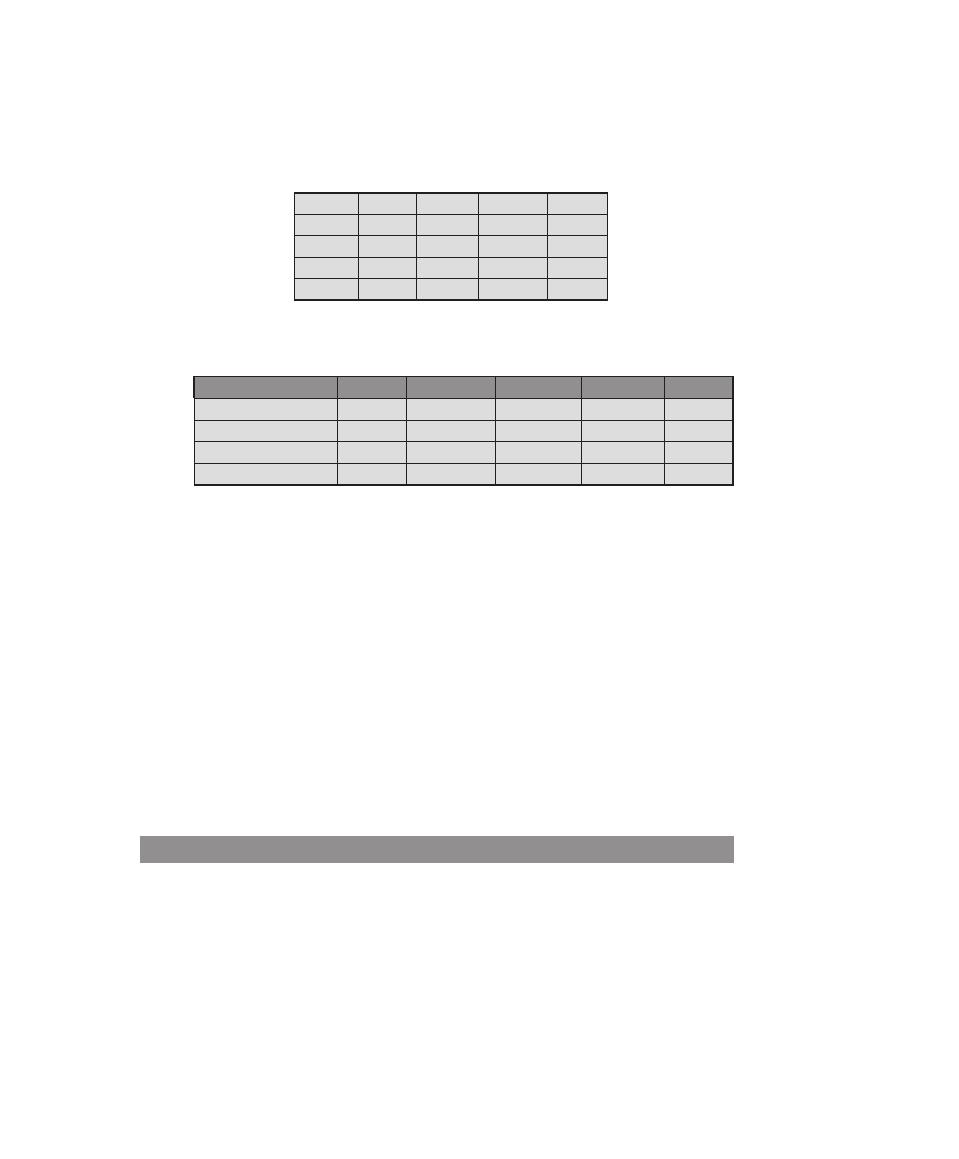

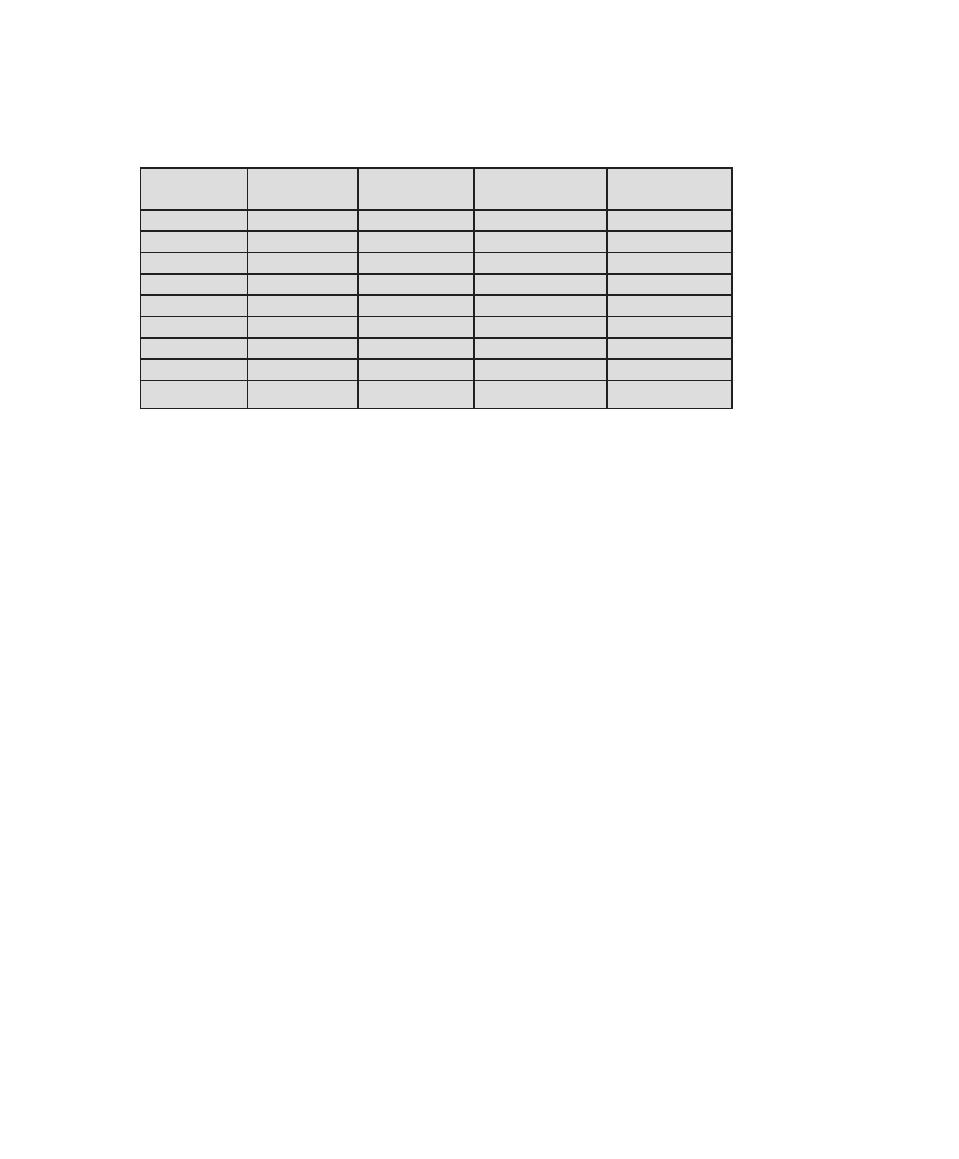

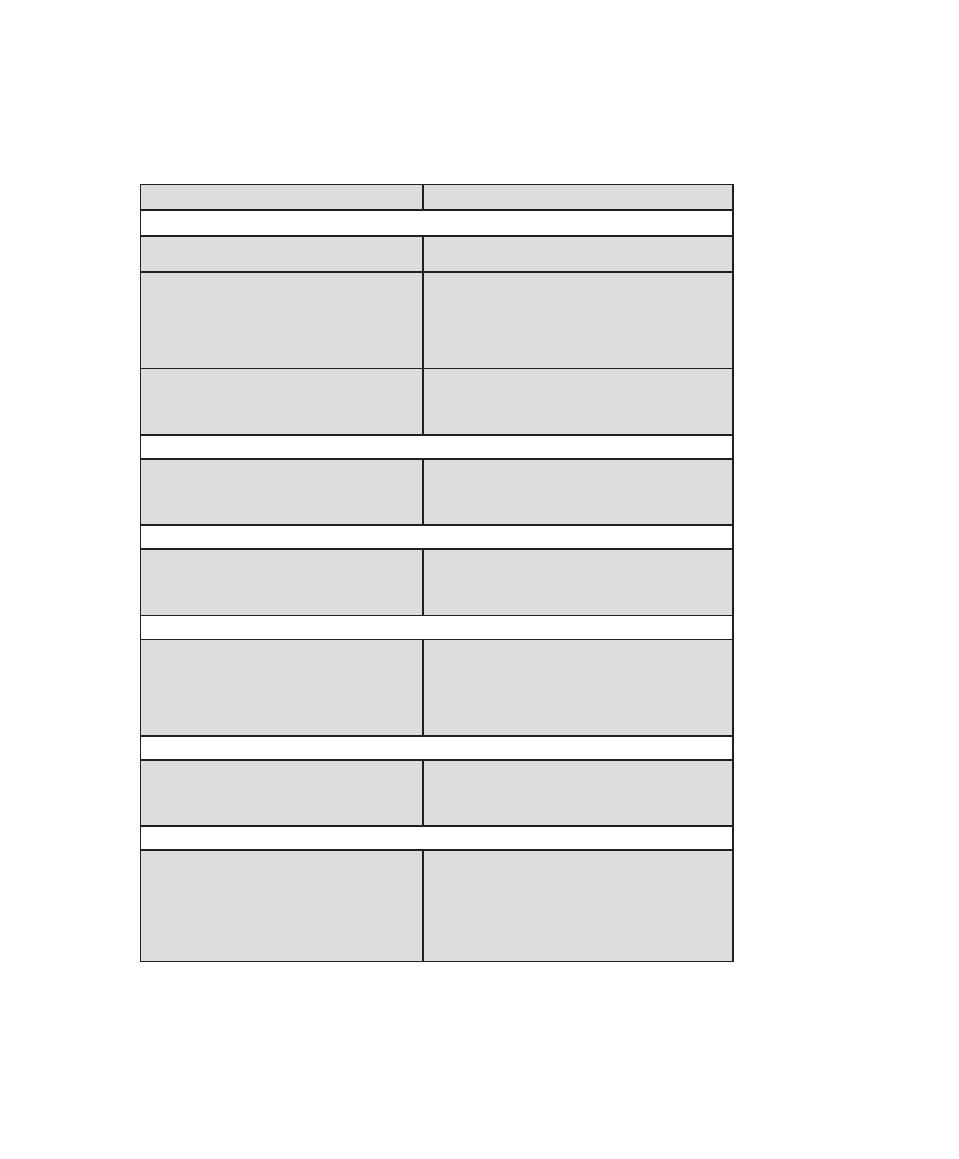

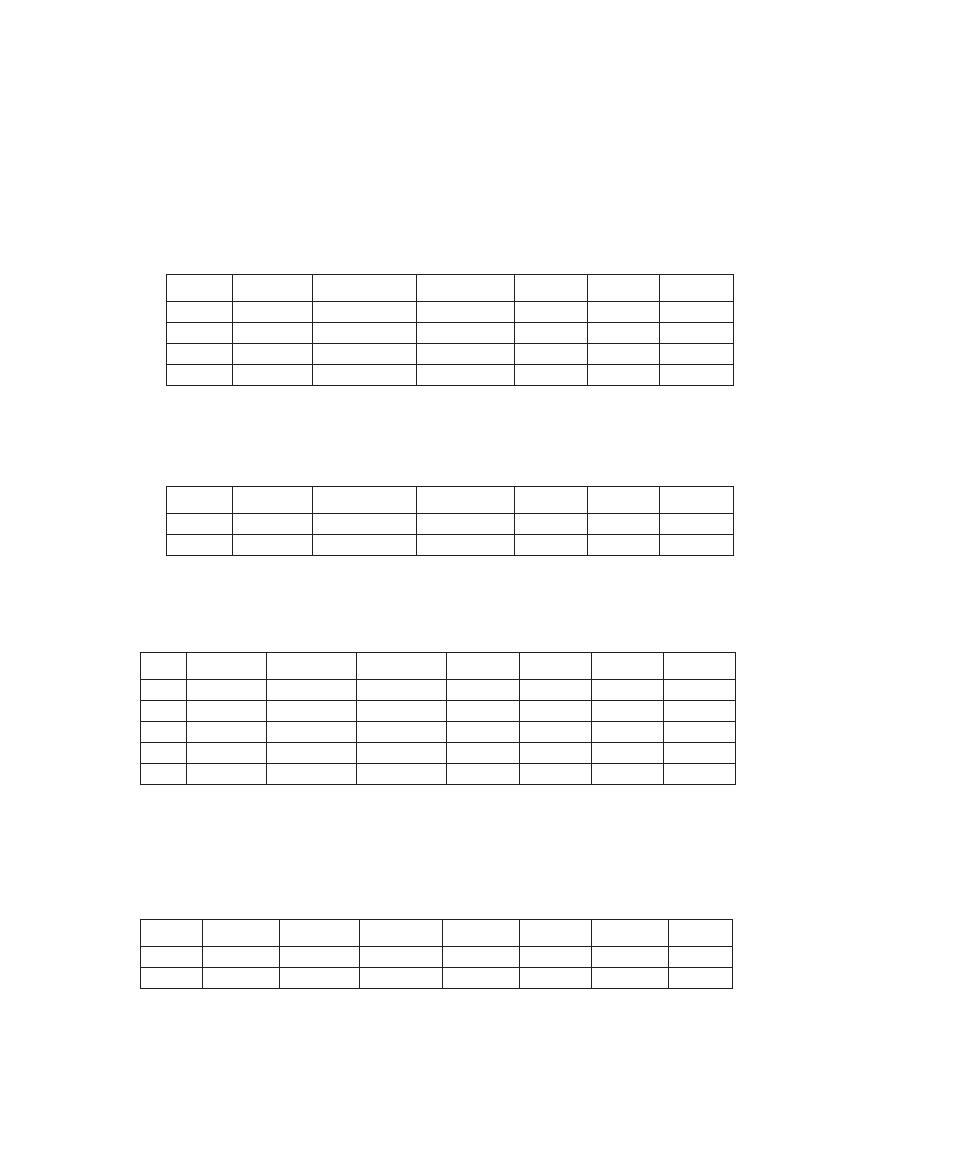

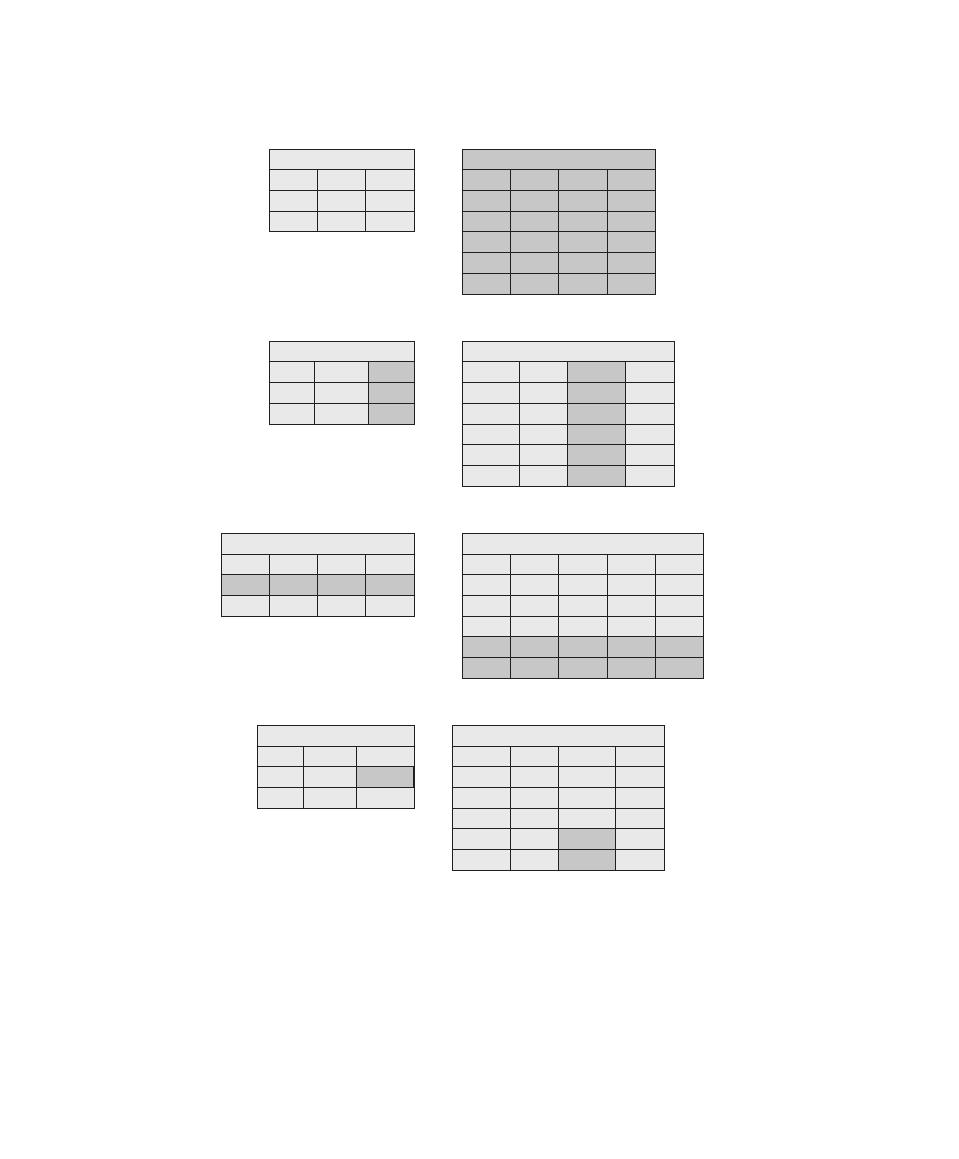

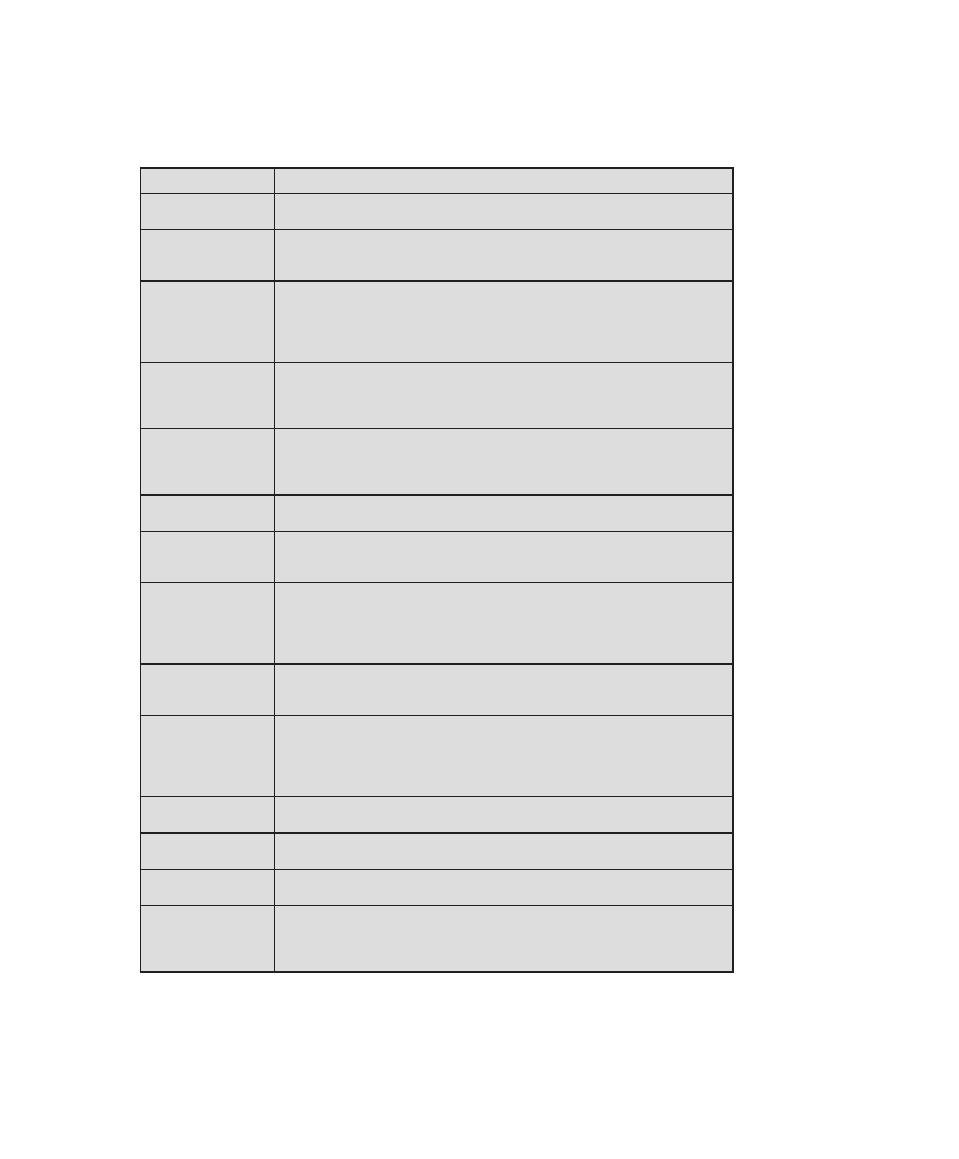

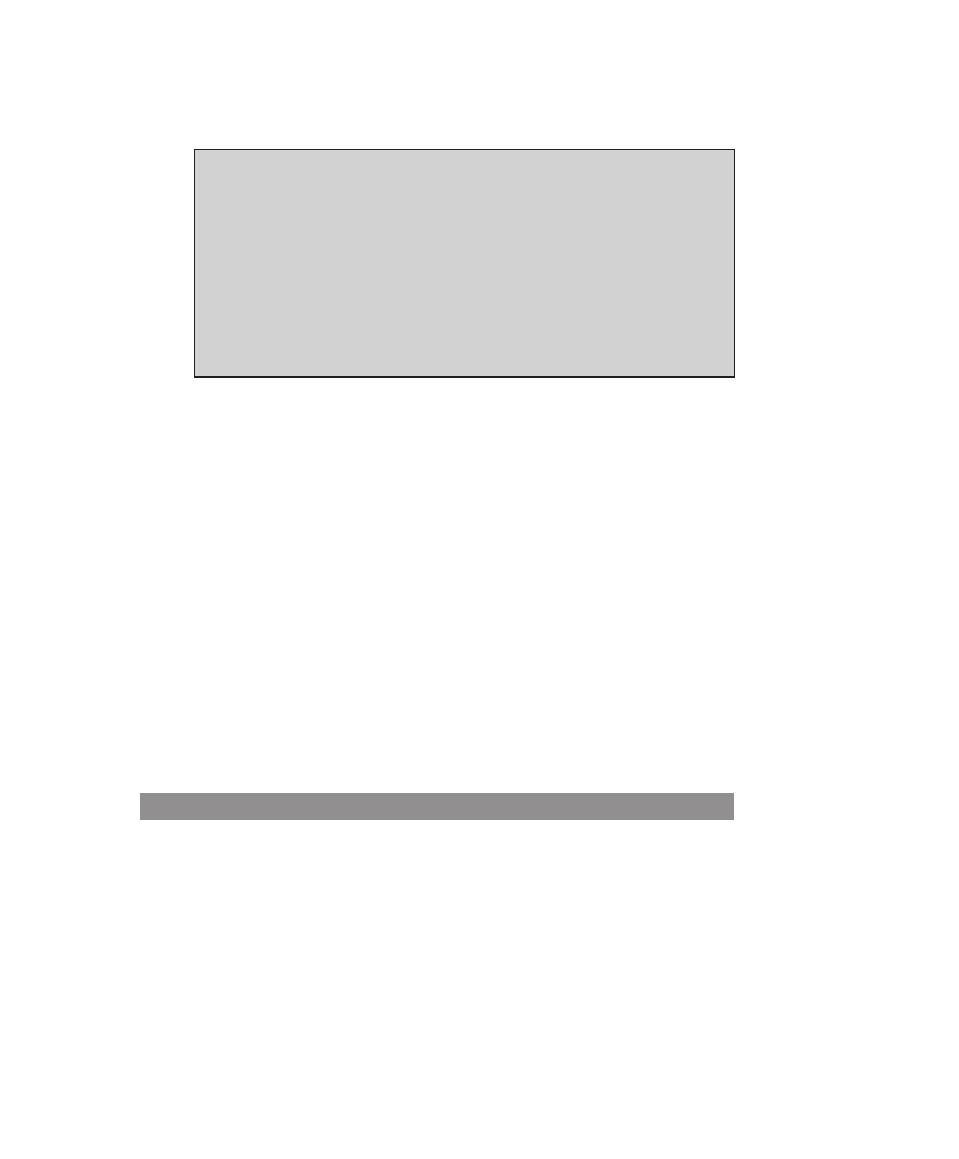

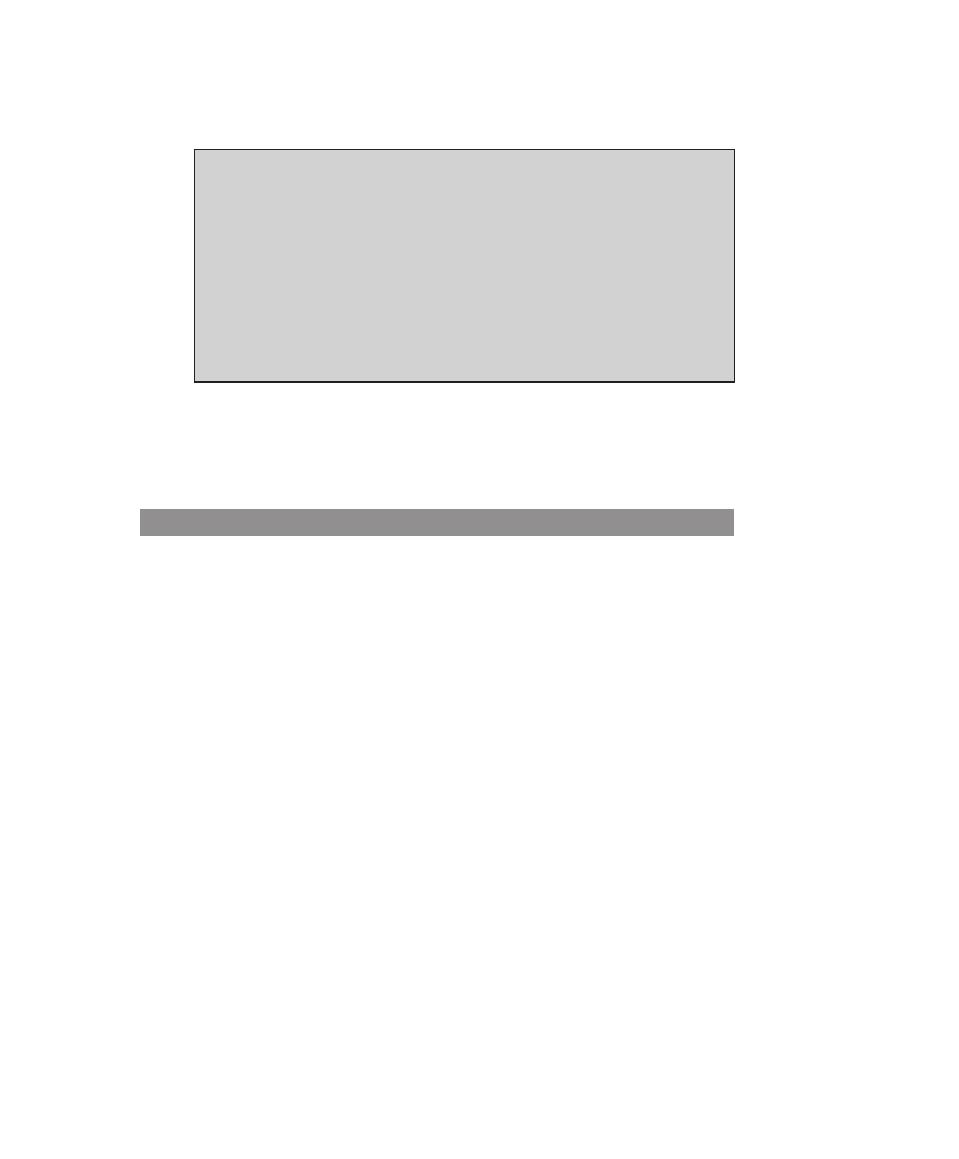

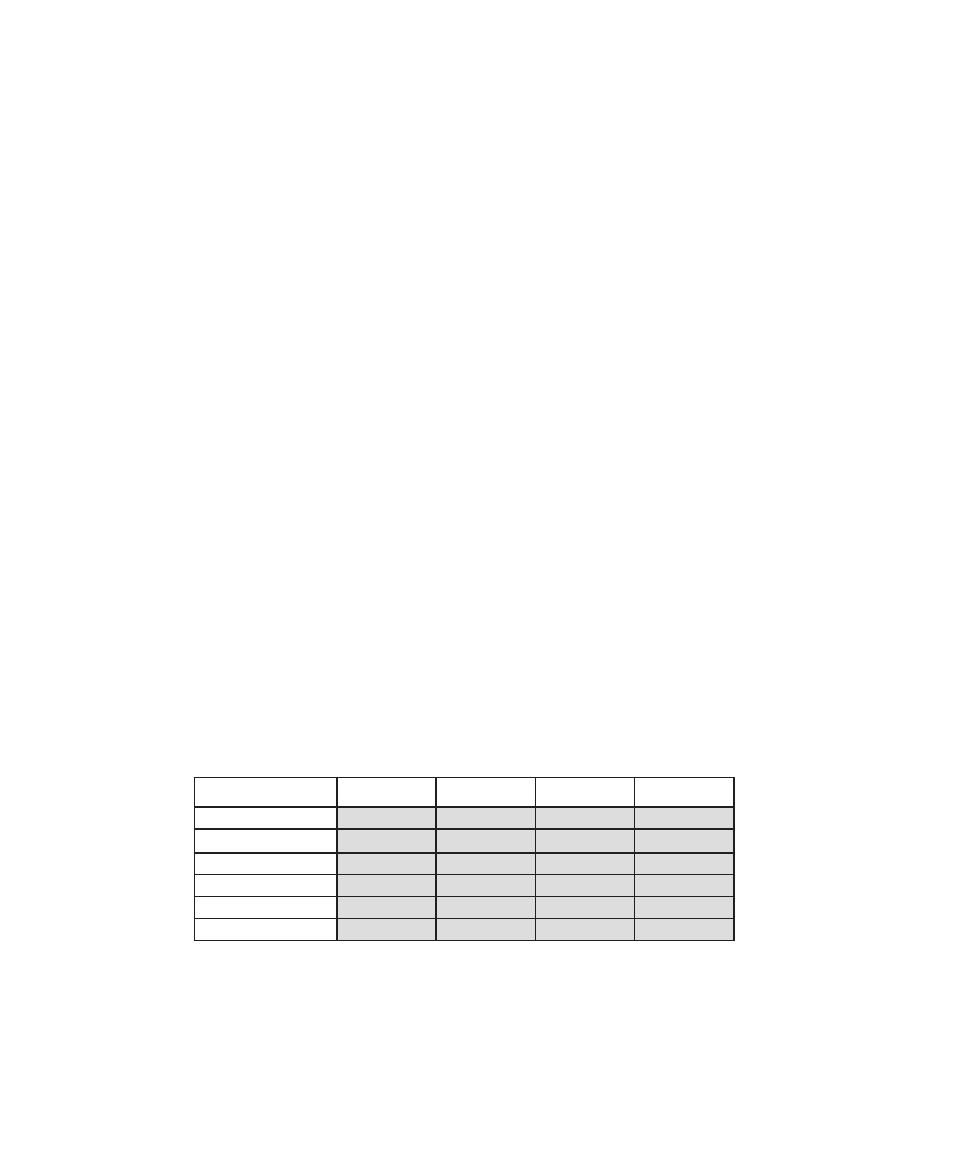

topics. Table 0.2 shows the support for the ISA Knowledge Area provided in this

textbook.

(Continued)

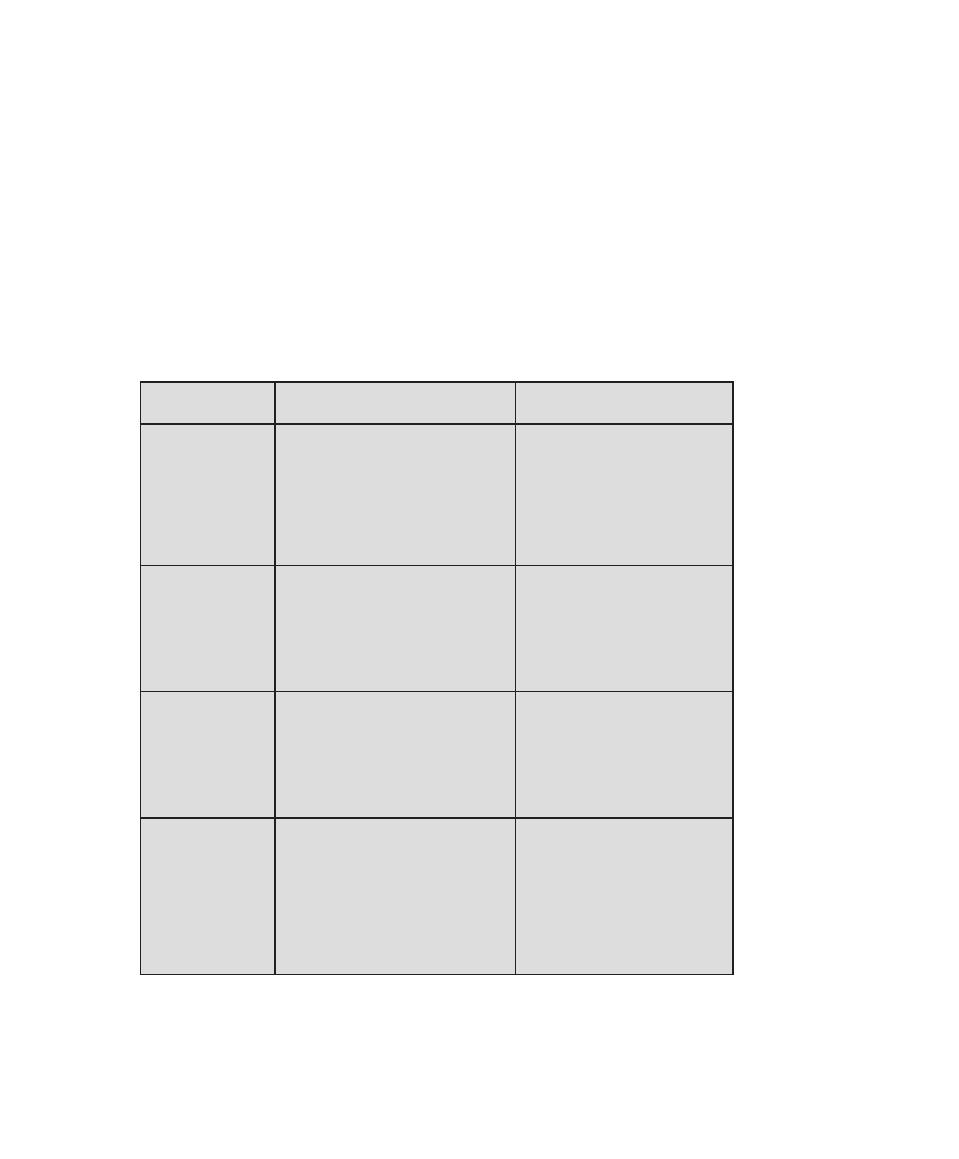

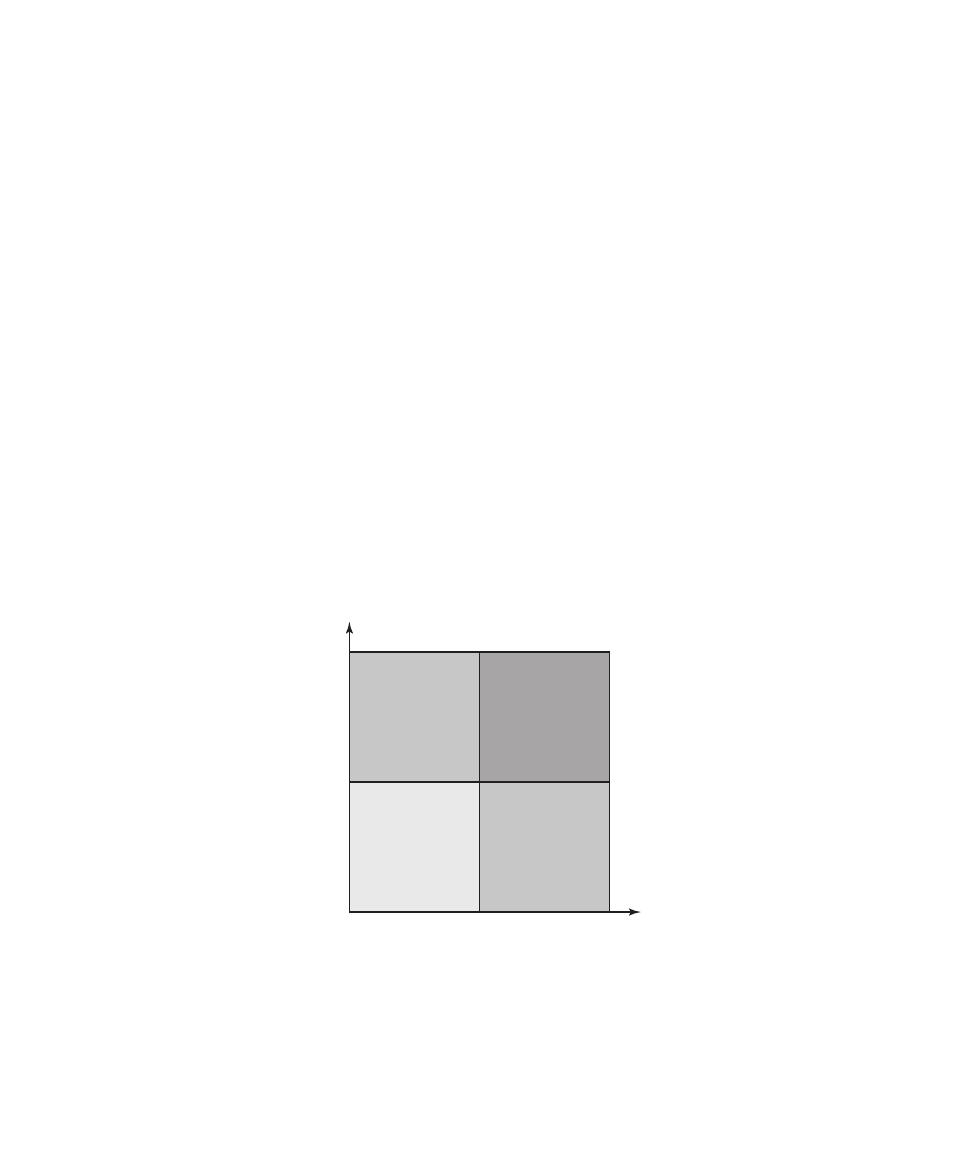

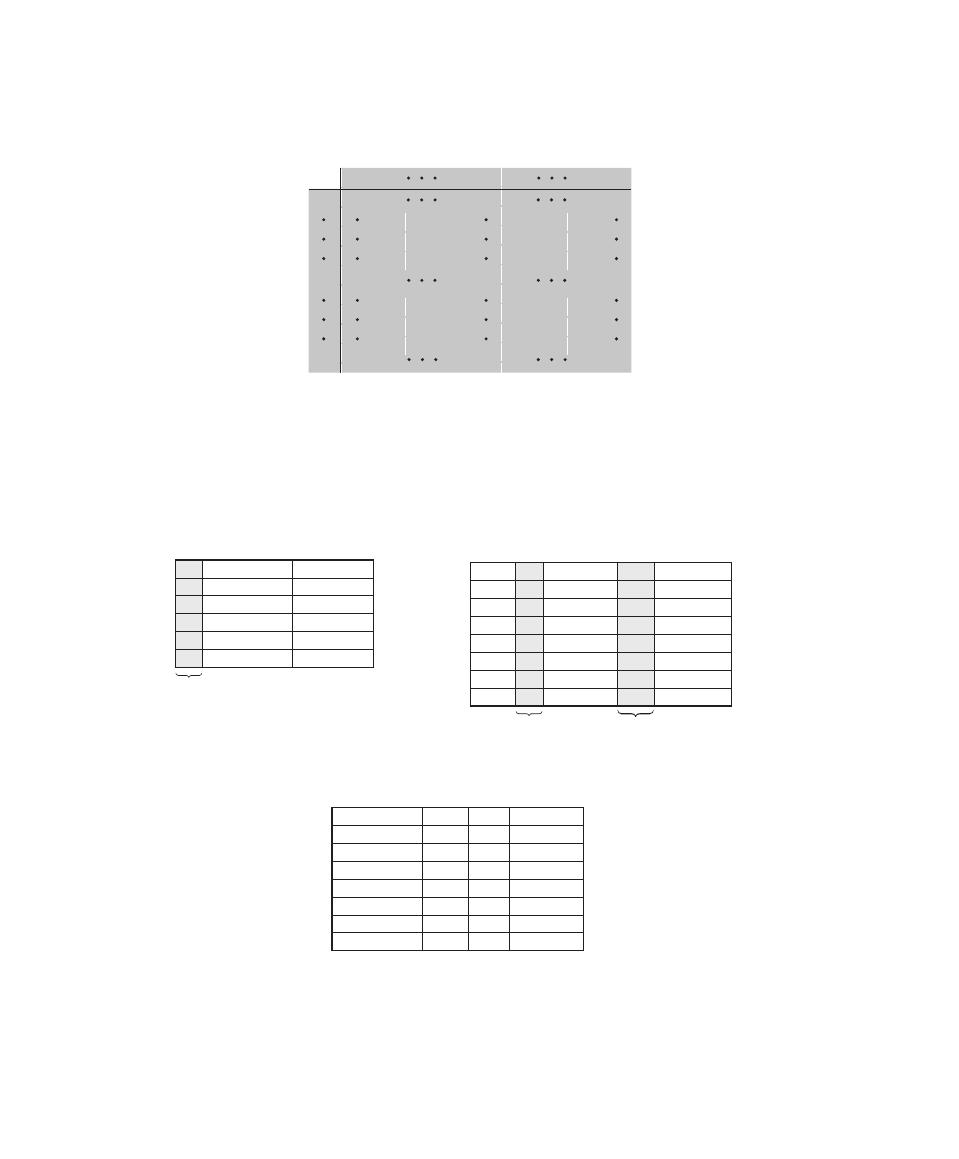

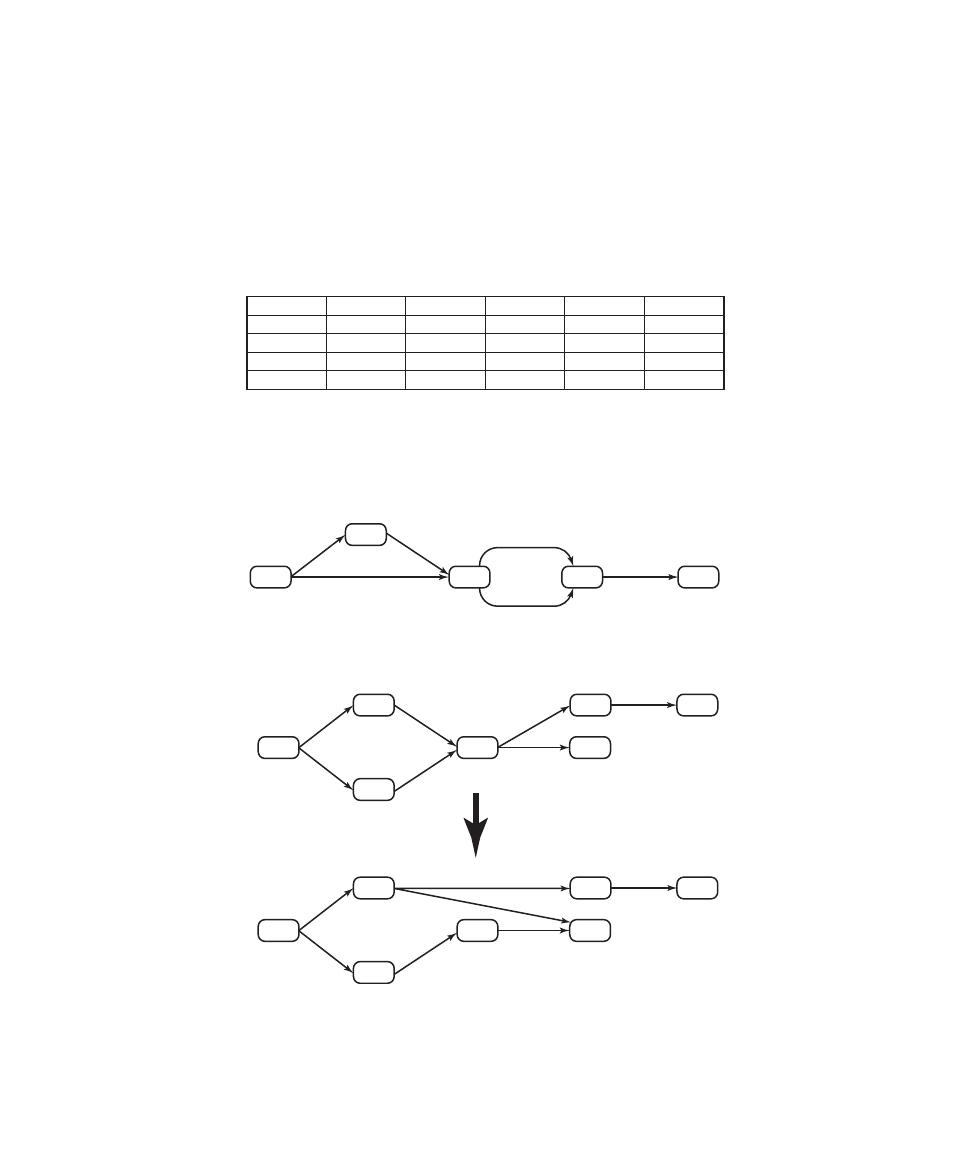

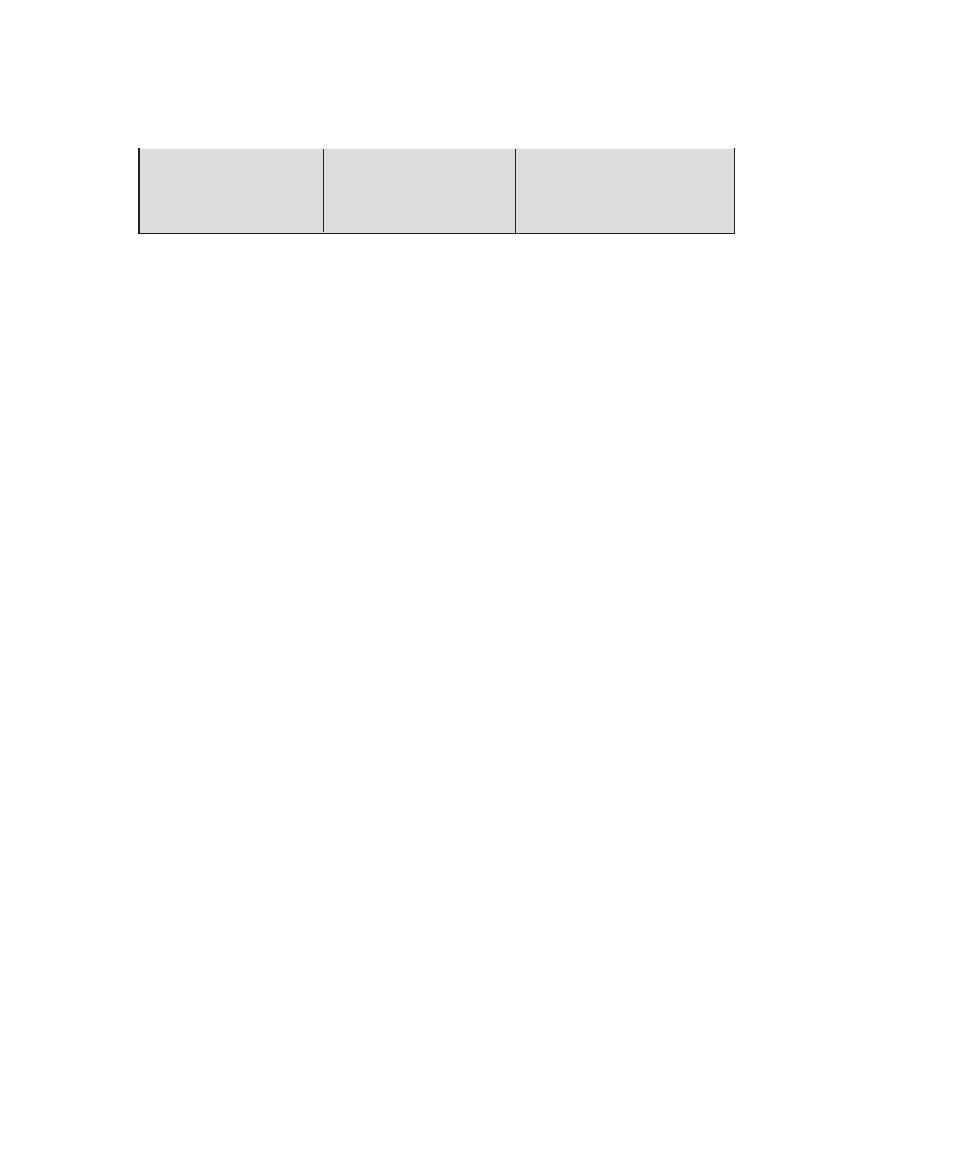

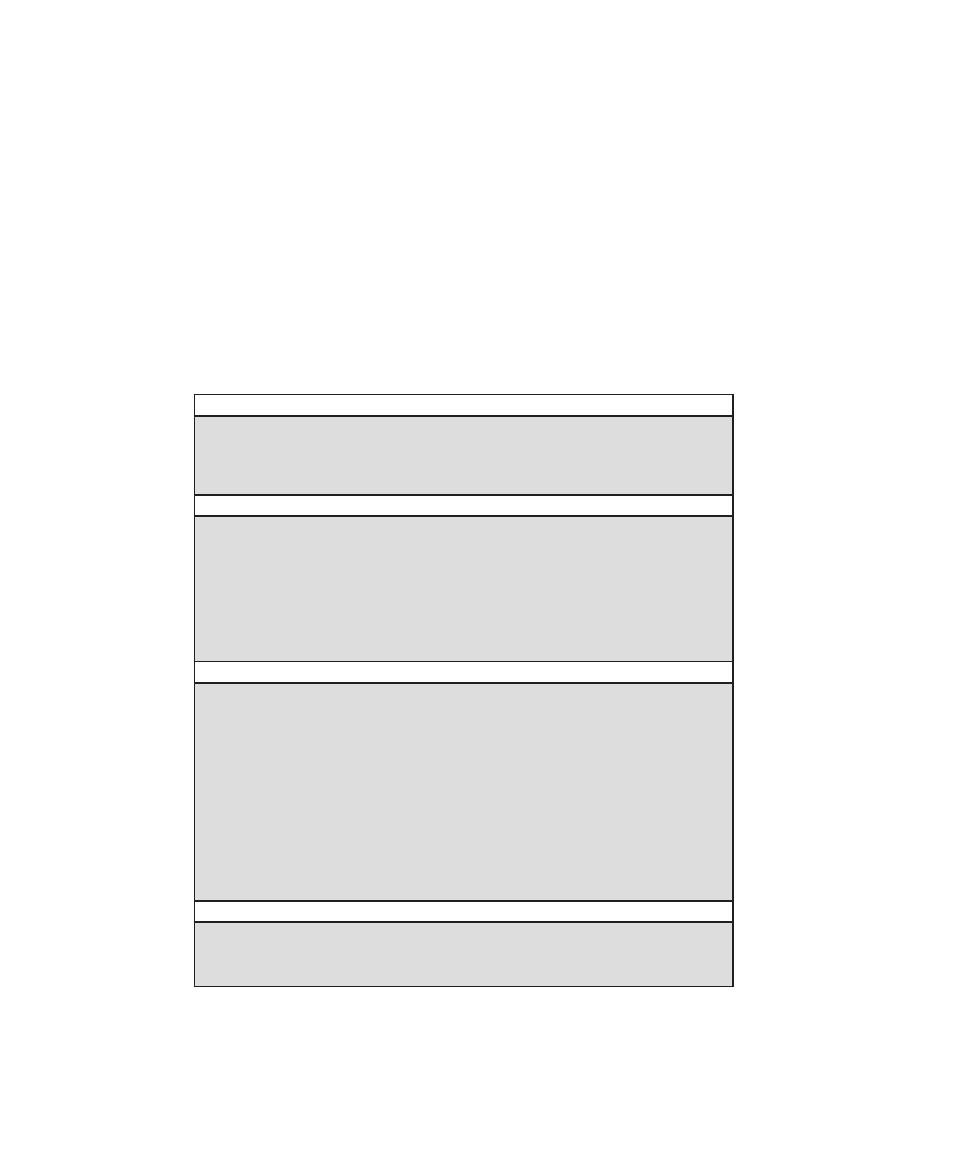

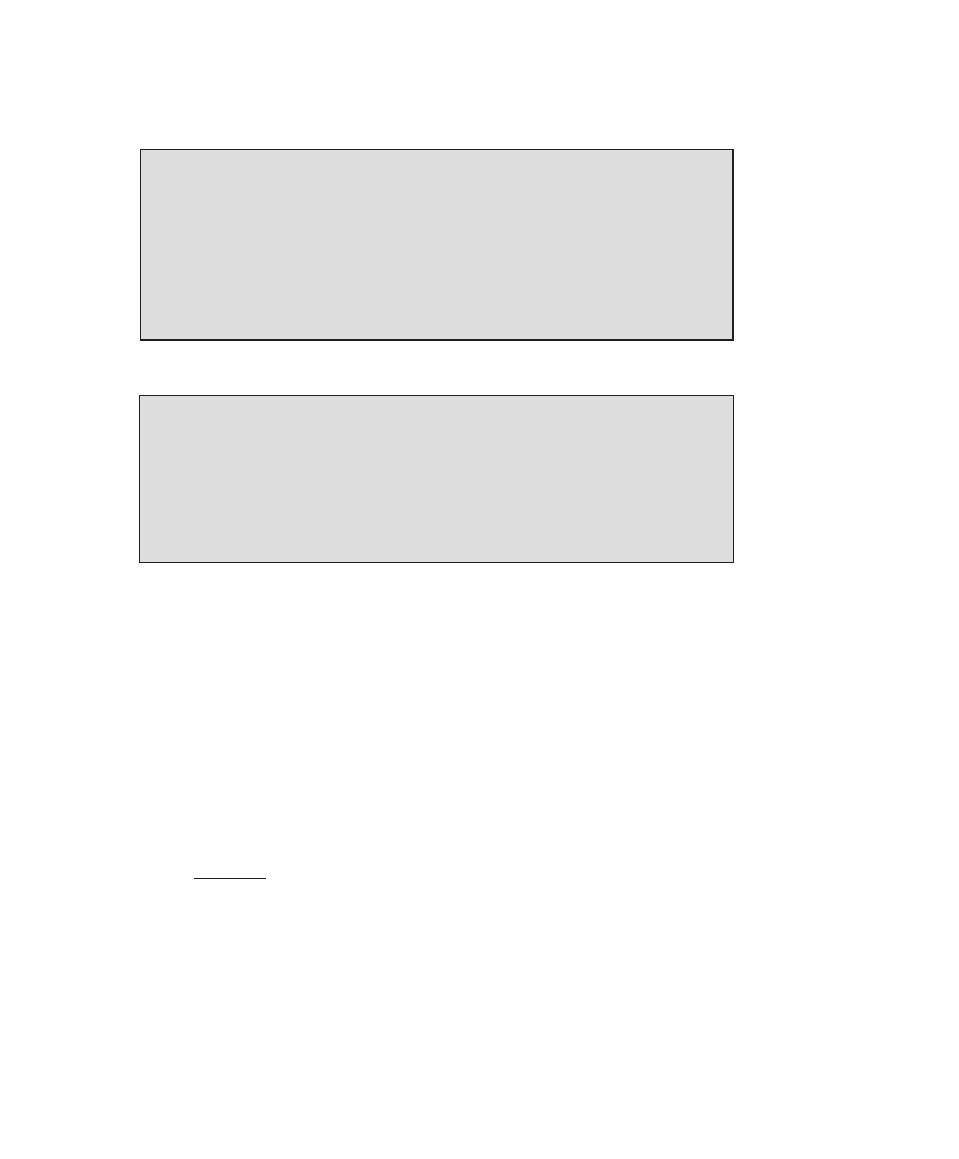

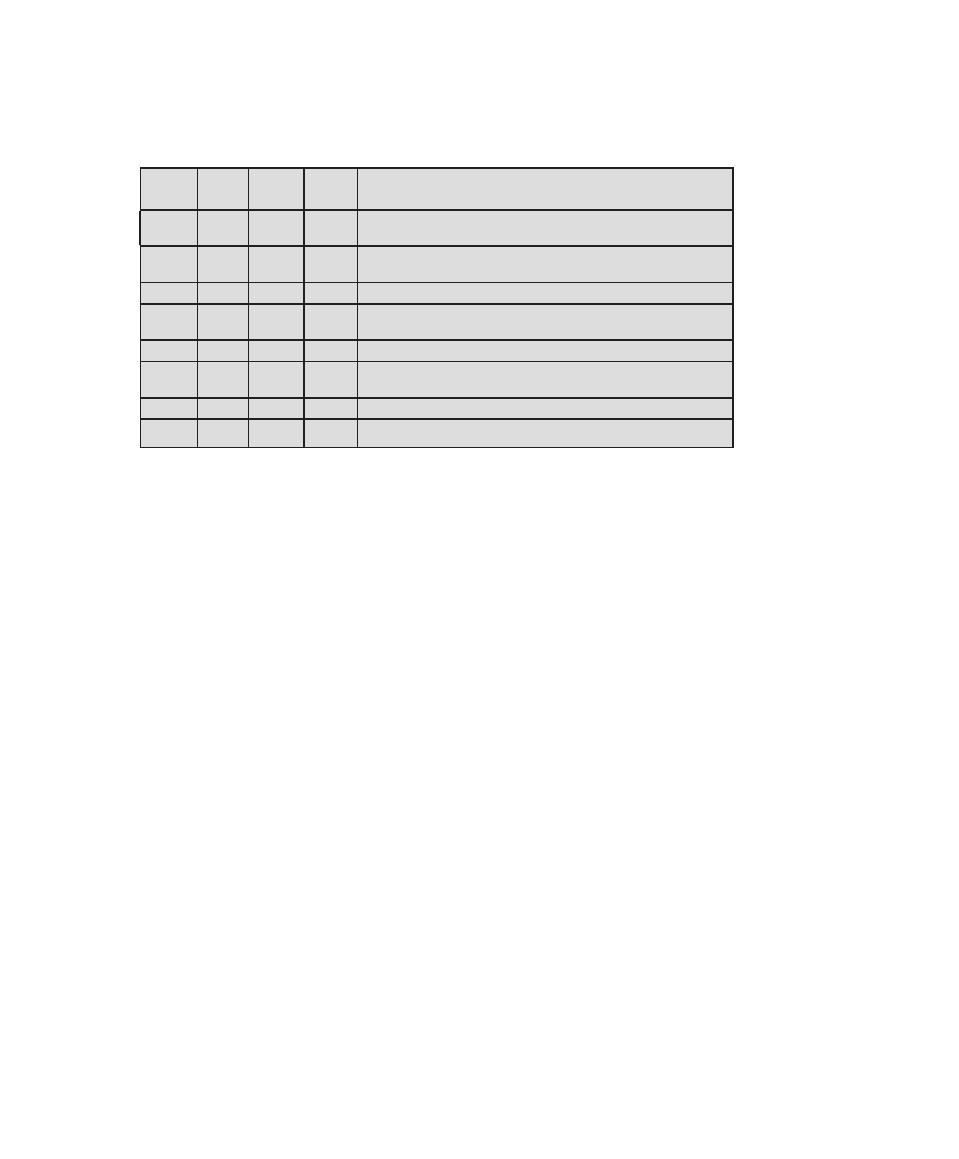

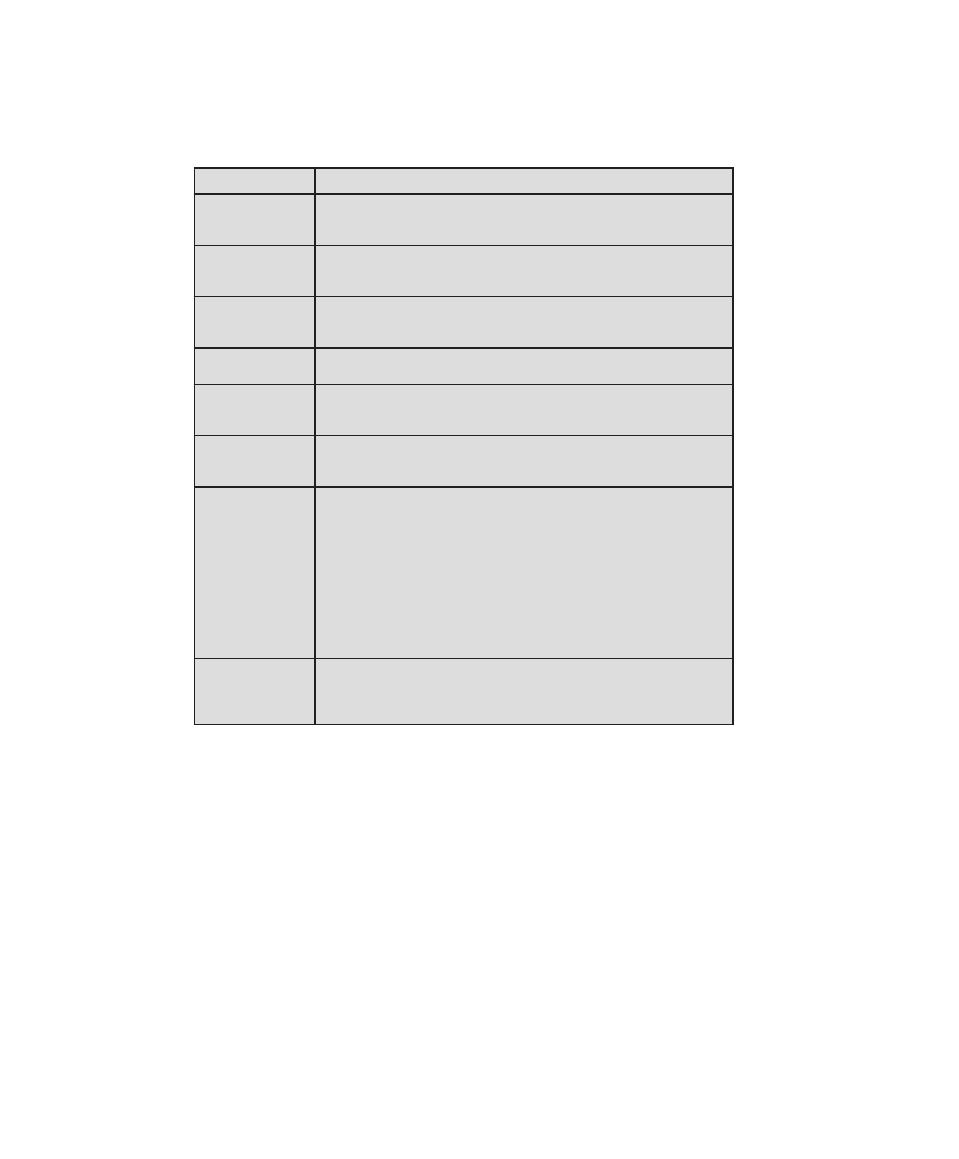

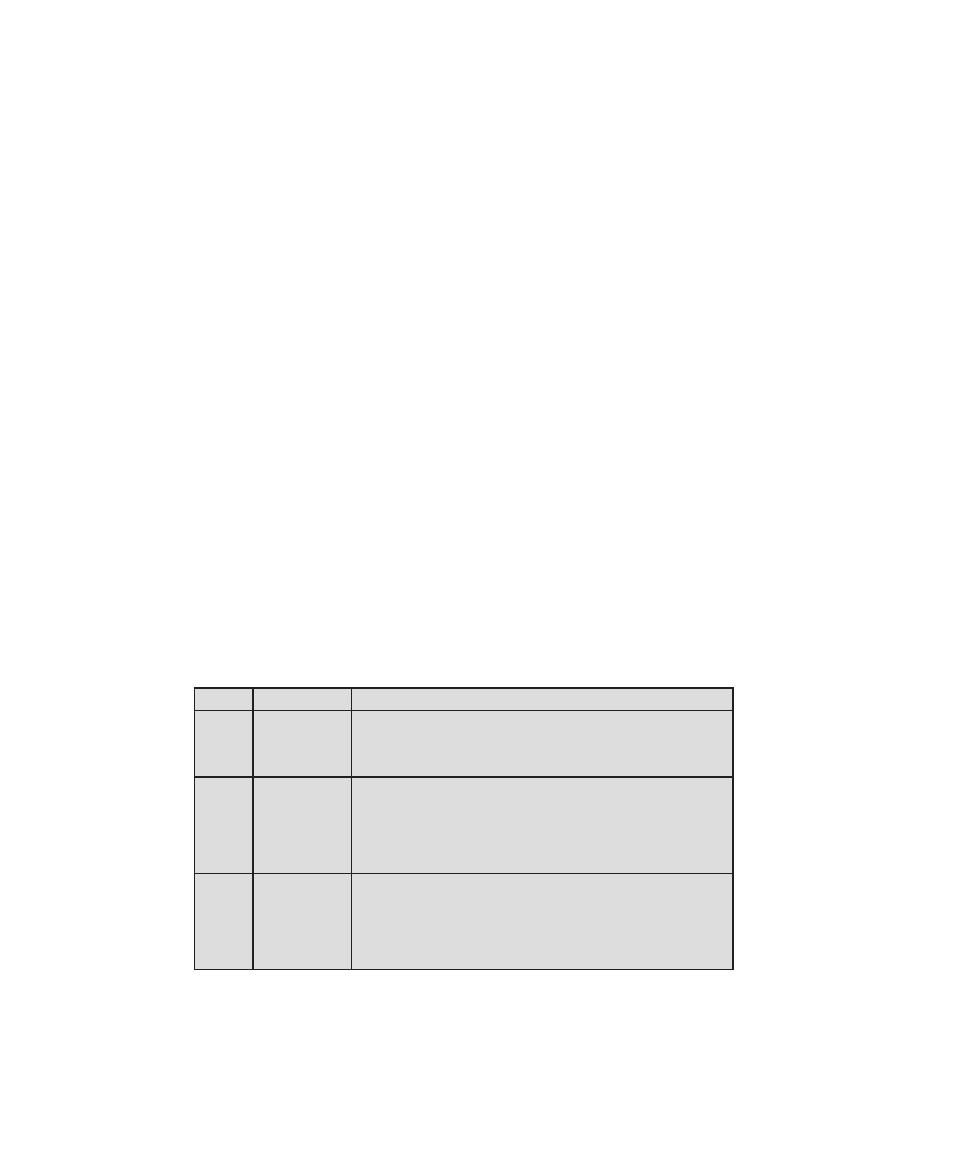

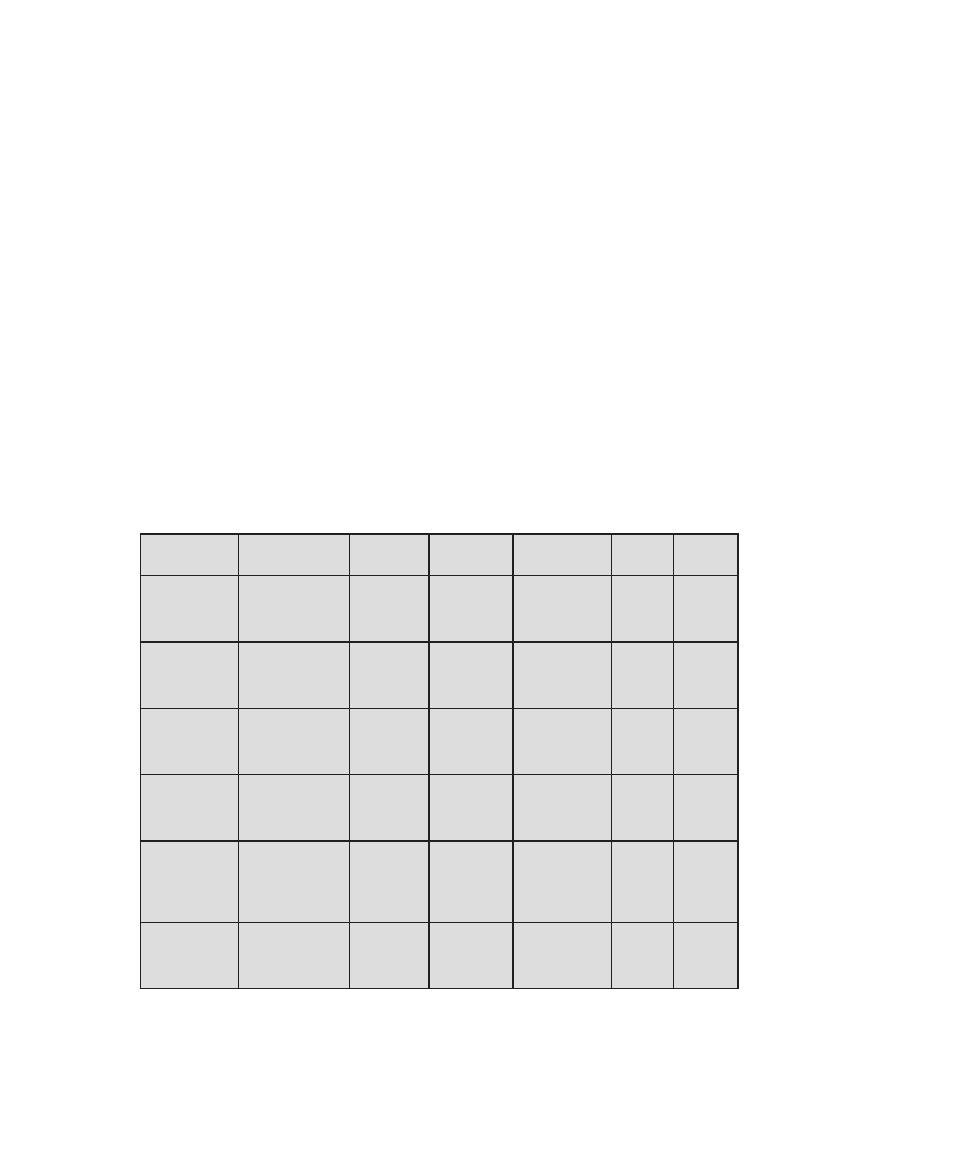

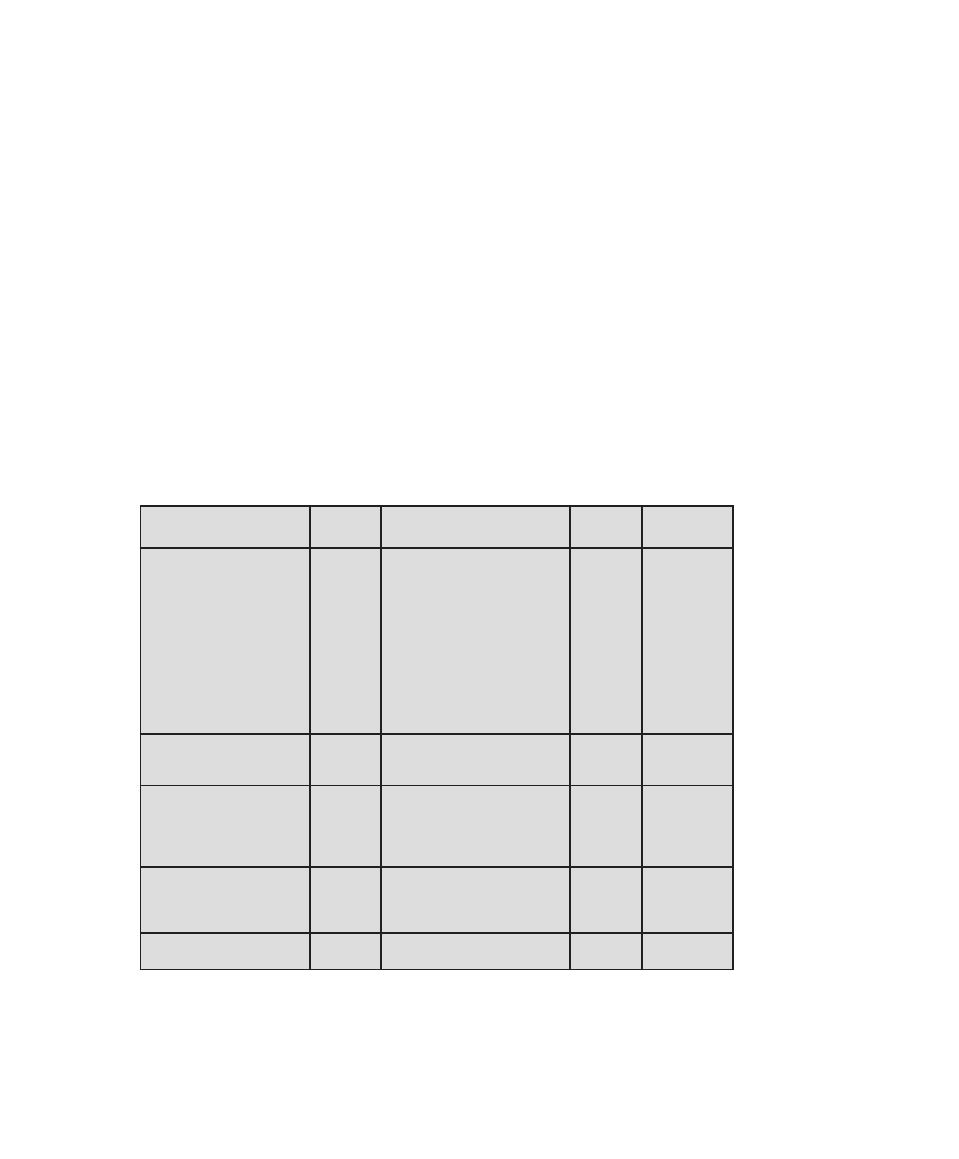

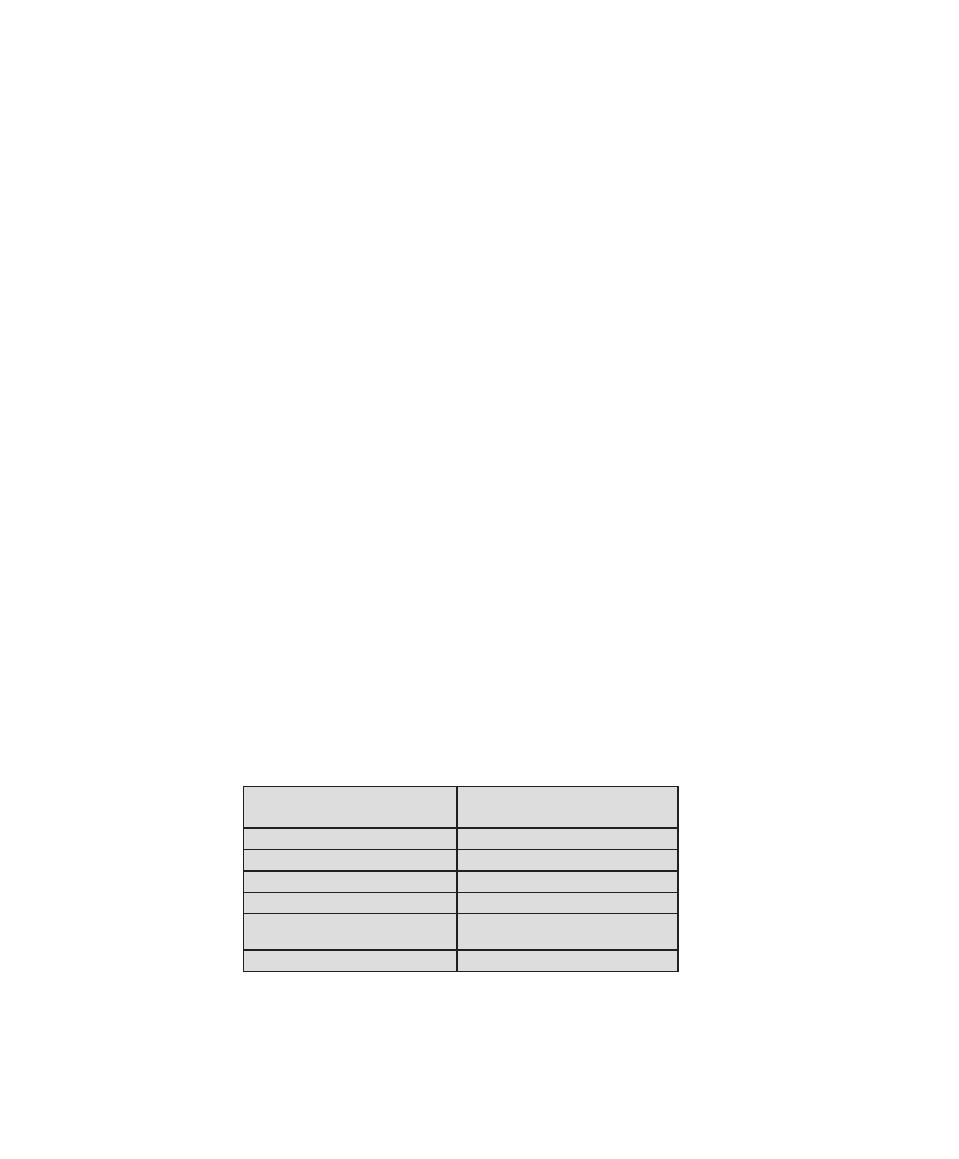

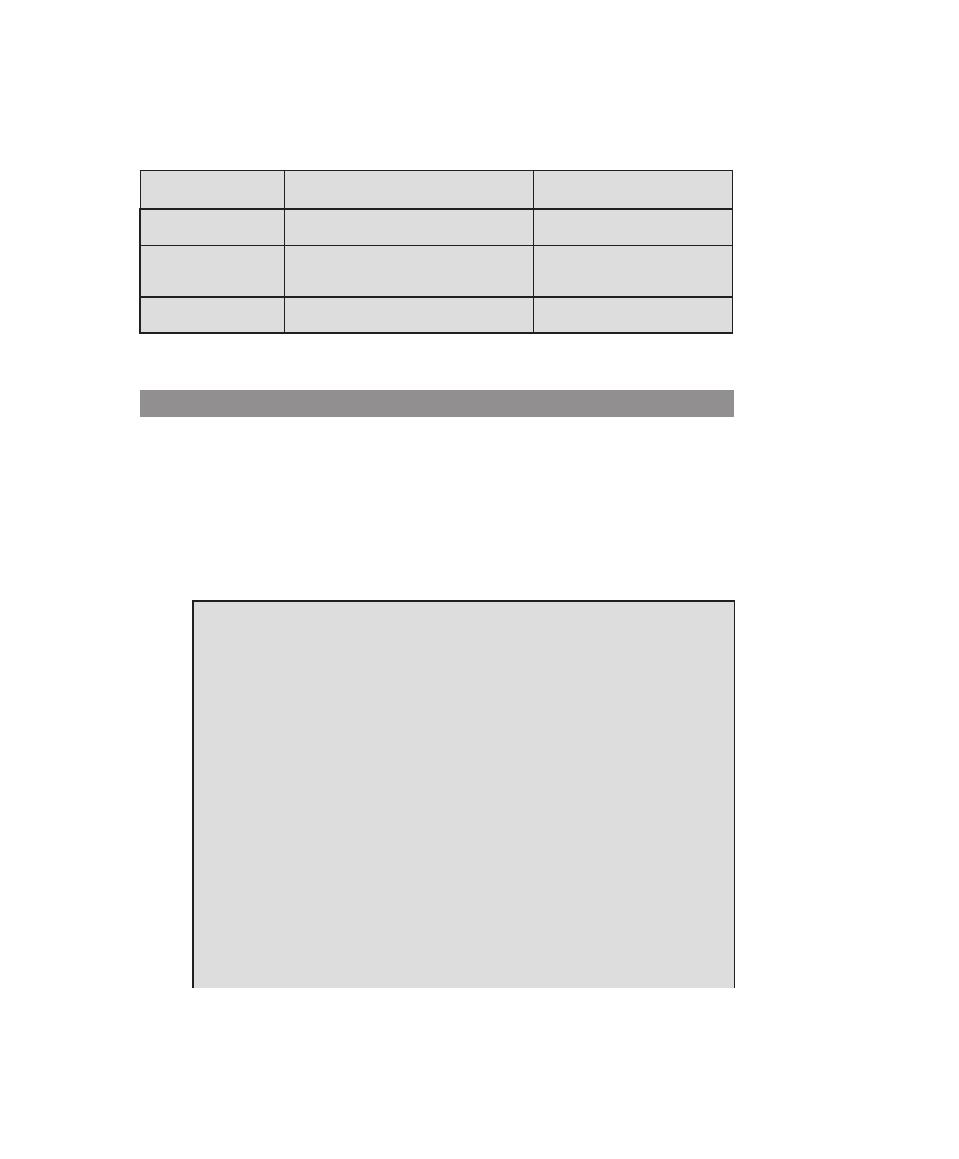

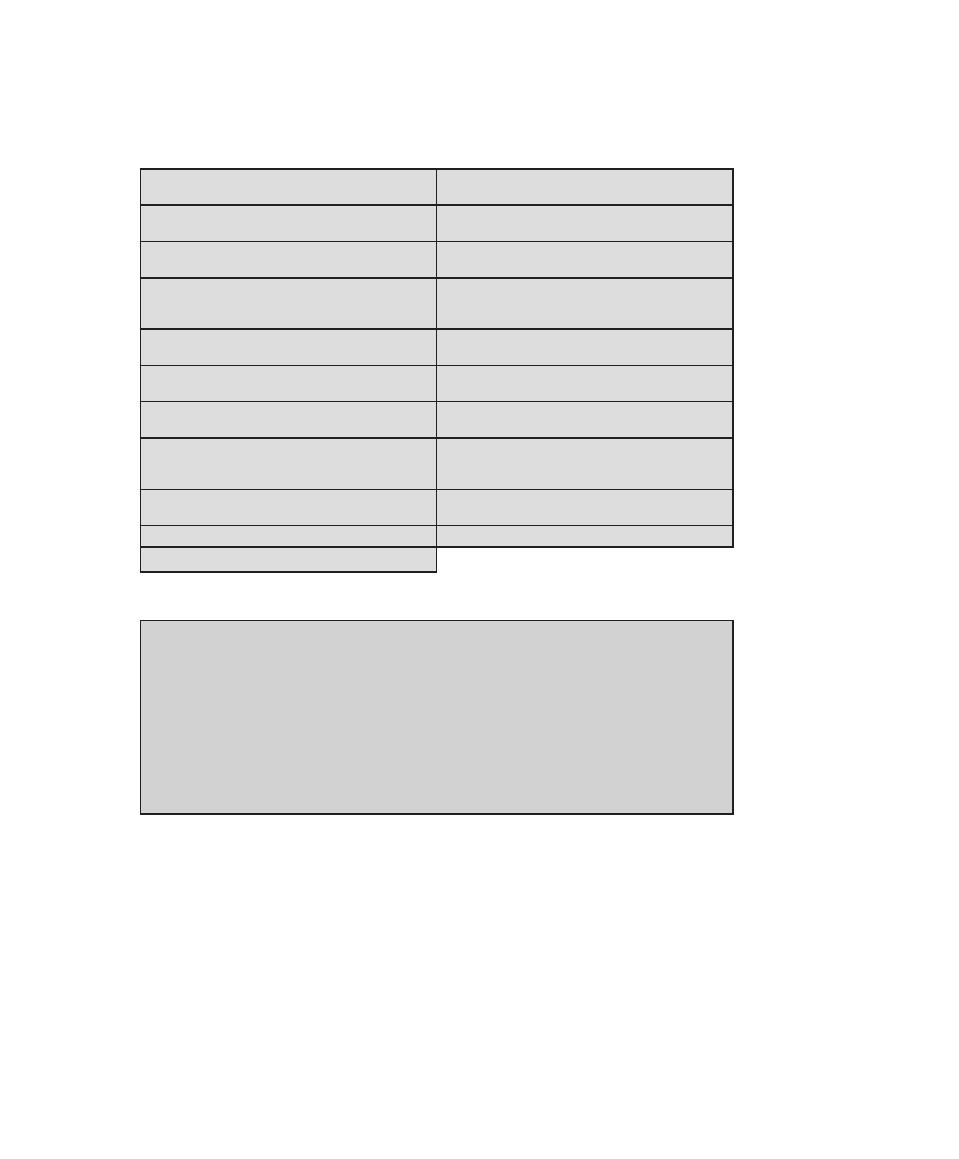

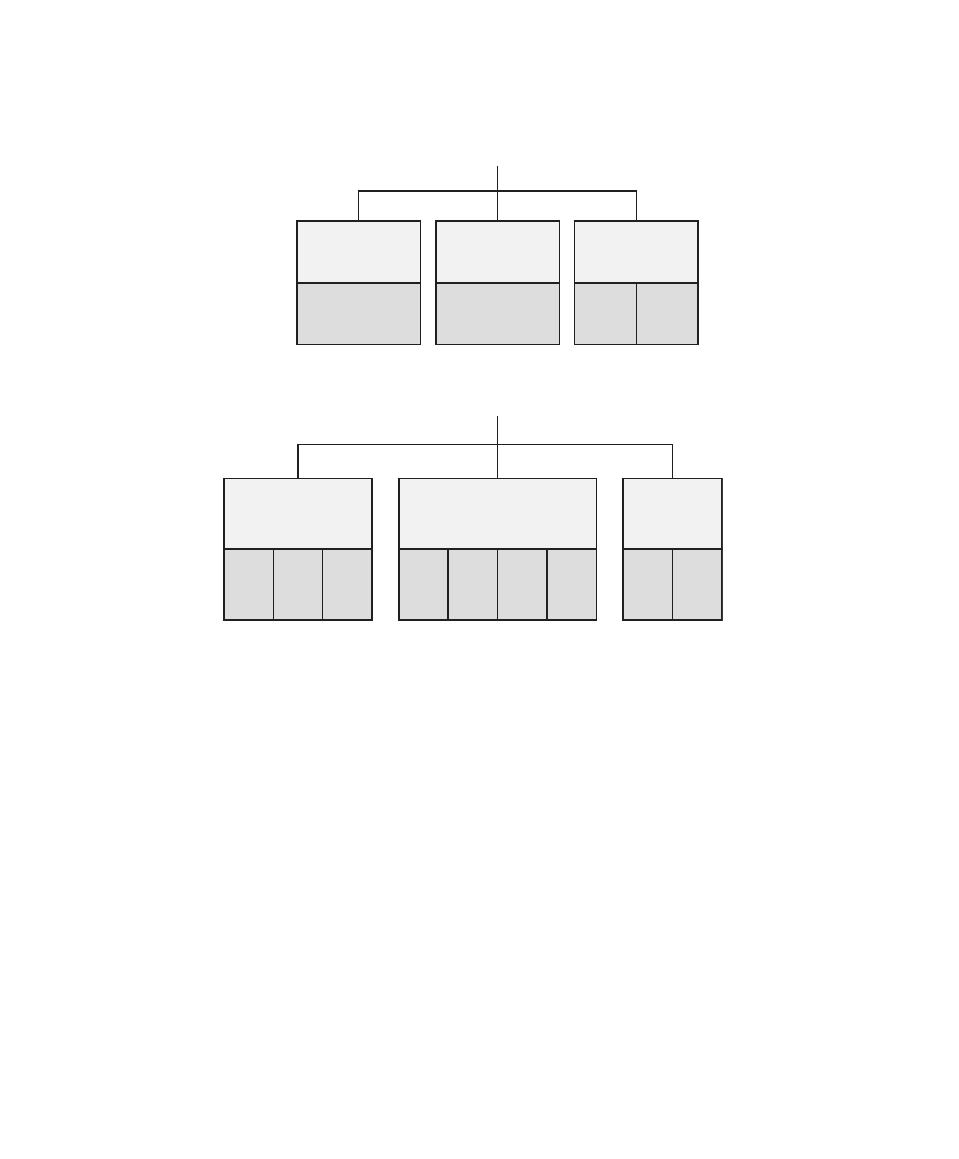

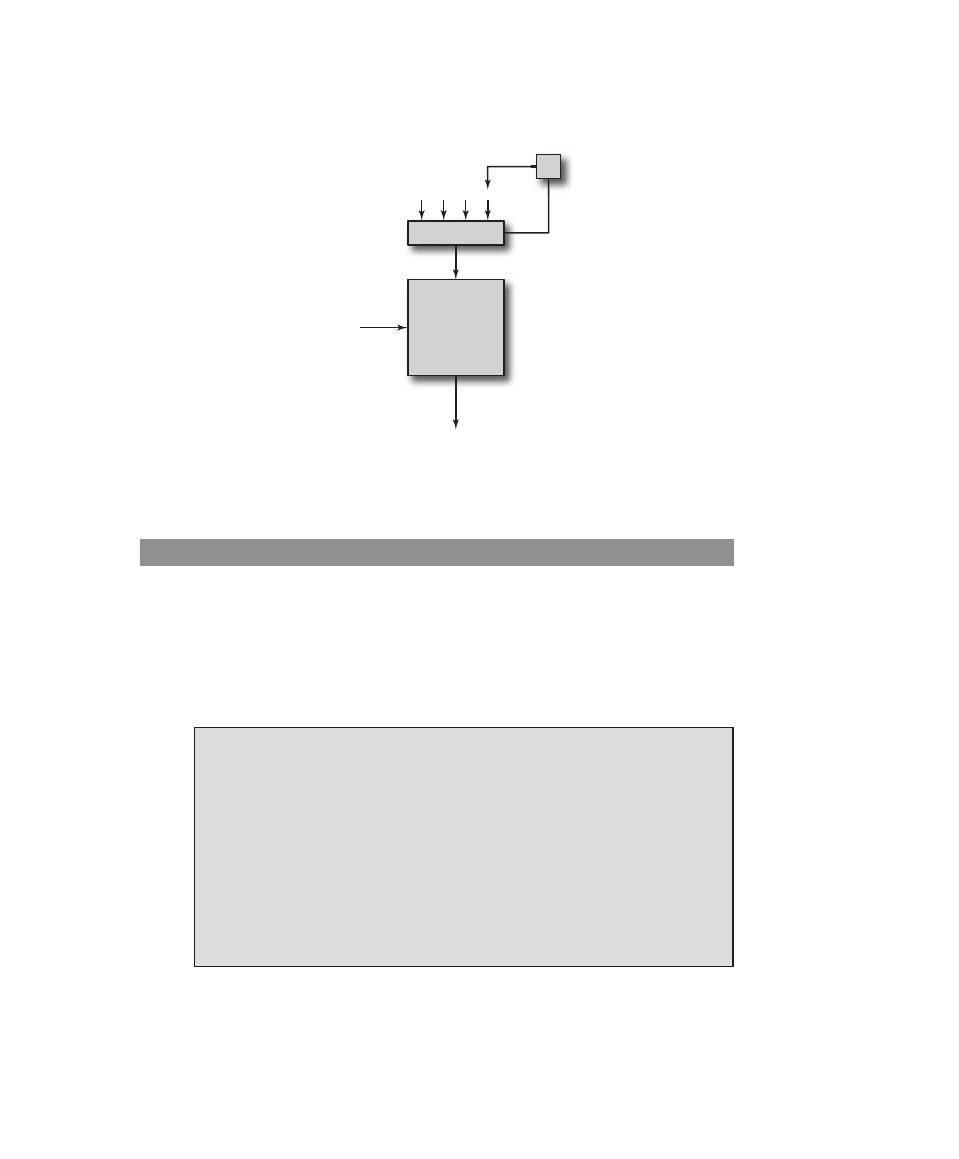

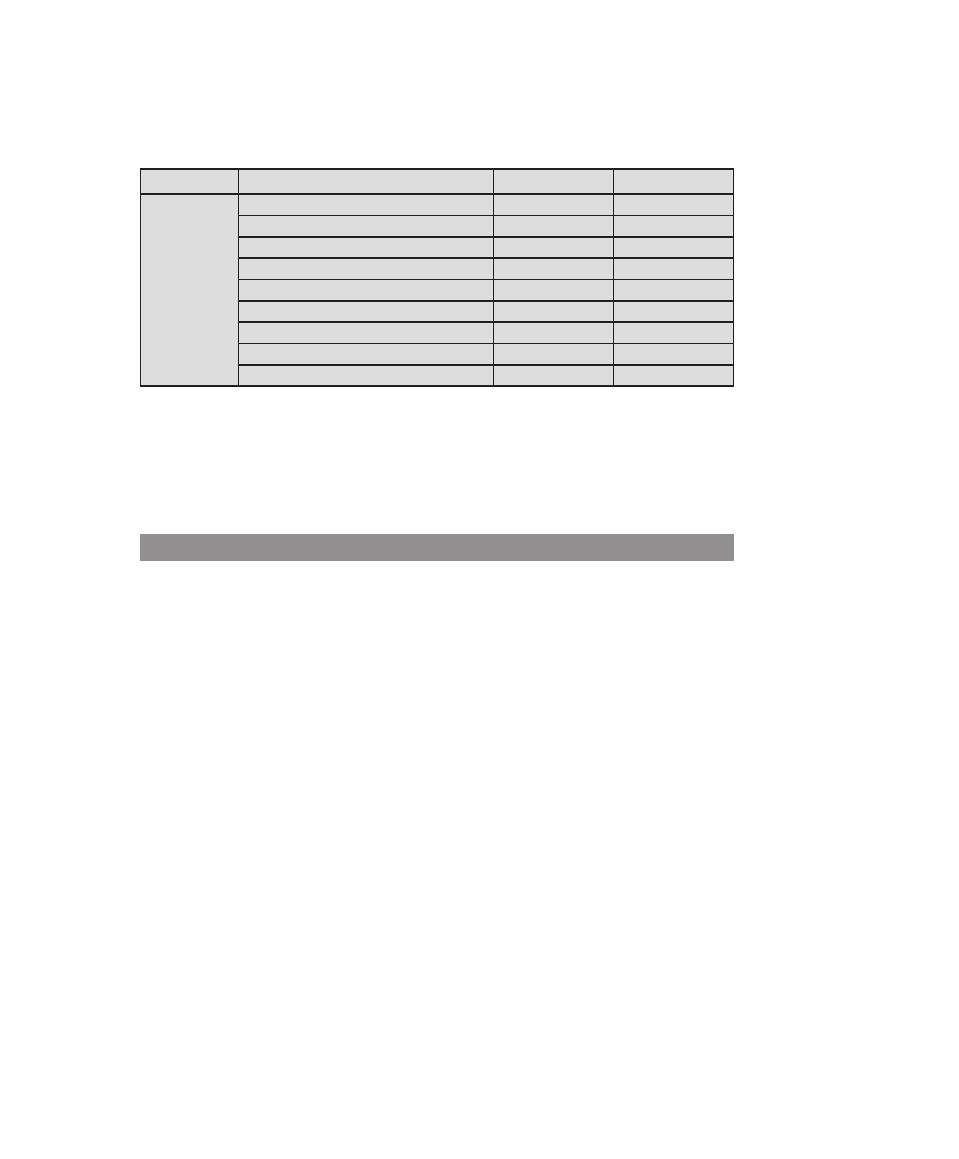

Table 0.2

Coverage of CS2013 Information Assurance and Security (IAS) Knowledge Area

IAS Knowledge

Units

Topics

Textbook Coverage

Foundational

Concepts in Security

(Tier 1)

• CIA (Confidentiality, Integrity,

Availability

• Risk, threats, vulnerabilities, and attack

vectors

• Authentication and authorization,

and access control (mandatory vs.

discretionary)

• Trust and trustworthiness

• Ethics (responsible disclosure)

1—Overview

3—User Authentication

4—Access Control

19—Legal and Ethical Aspects

principles of Secure

Design (Tier 1)

• Least privilege and isolation

• Fail-safe defaults

• Open design

• End-to-end security

• Defense in depth

• Security by design

• Tensions between security and other

design goals

1—Overview

principles of Secure

Design (Tier 2)

• Complete mediation

• Use of vetted security components

• Economy of mechanism (reducing

trusted computing base, minimize attack

surface)

• Usable security

• Security composability

• Prevention, detection, and deterrence

1—Overview

Defensive

programming (Tier 1)

• Input validation and data sanitization

• Choice of programming language and

type-safe languages

• Examples of input validation and data

sanitization errors (buffer overflows,

integer errors, SQL injection, and XSS

vulnerability)

• Race conditions

• Correct handling of exceptions and

unexpected behaviors

11—Software Security

8

Chapter 0 / reader’s and InstruCtor’s GuIde

0.6 inteRnet And WeB ResOuRces

There are a number of resources available on the Internet and the Web to support

this book and to help one keep up with developments in this field.

Web Sites for This Book

Three Web sites provide additional resources for students and instructors. We main-

tain a Companion Web site for this book at WilliamStallings.com/ComputerSecurity.

For students, this Web site includes a list of relevant links, organized by chapter,

and an errata sheet for the book. For instructors, this Web site provides links to

course pages by professors teaching from this book.

There is also an access-controlled premium Content Web site that provides

a wealth of supporting material, including additional online chapters, additional

online appendices, and a set of homework problems with solutions. See the card at

the front of this book for access information.

Finally, additional material for instructors, including a solutions manual and a

projects manual, is available at the Instructor Resource Center (IRC) for this book.

See Preface for details and access information.

Computer Science Student Resource Site

William Stallings also maintains the Computer Science Student Resource Site, at

ComputerScienceStudent.com. The purpose of this site is to provide documents,

information, and links for computer science students and professionals. Links and

documents are organized into five categories:

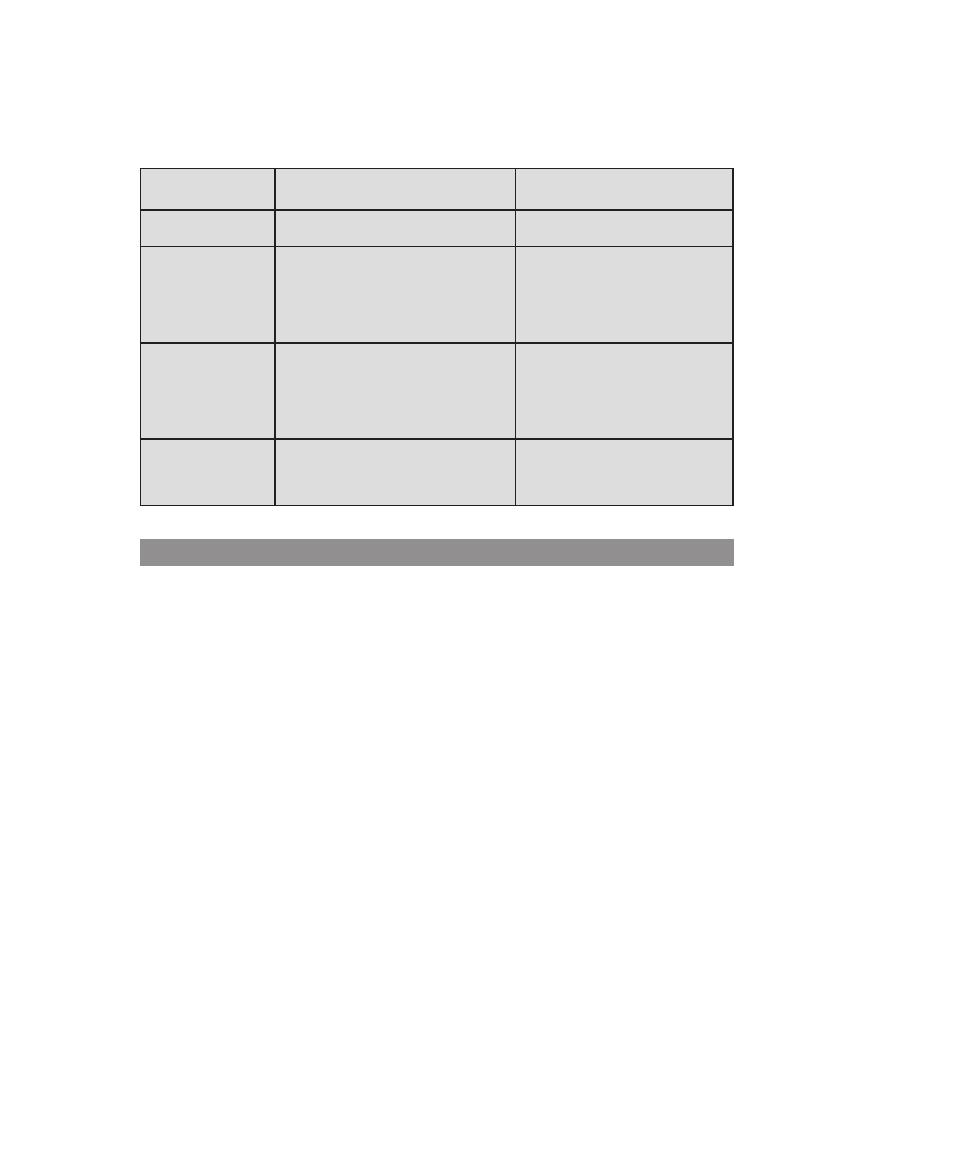

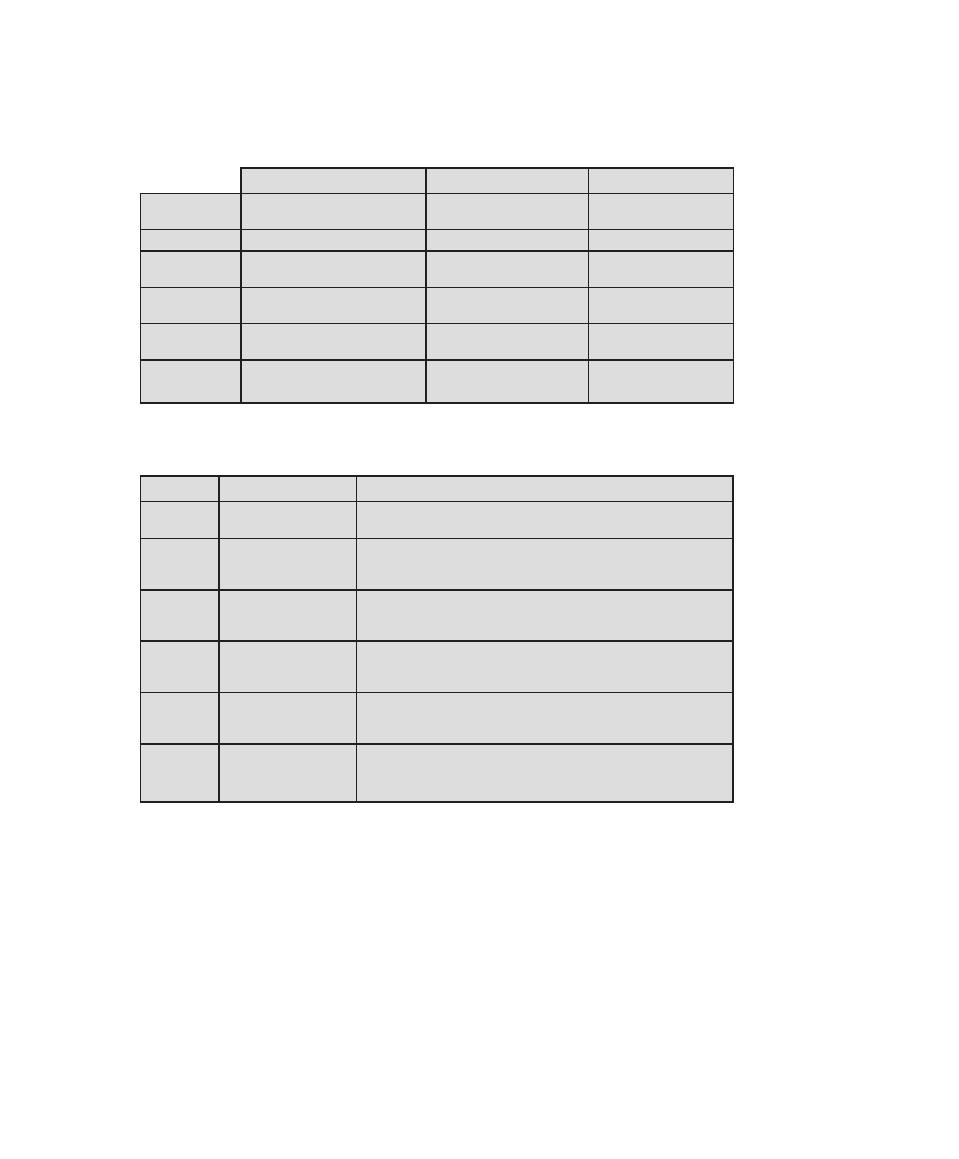

Table 0.2

(Continued)

IAS Knowledge

Units

Topics

Textbook Coverage

Defensive

programming (Tier 2)

• Correct usage of third-party components

• Effectively deploying security updates

11—Software Security

12—OS Security

Threats and Attacks

(Tier 2)

• Attacker goals, capabilities, and

motivations

• Malware

• Denial of service and Distributed

Denial of Service

• Social engineering

6—Malicious Software

7—Denial-of-Service Attacks

Network Security

(Tier 2)

• Network specific threats and attack types

• Use of cryptography for data and

network security

• Architectures for secure networks

• Defense mechanisms and countermeasures

• Security for wireless, cellular networks

8—Intrusion Detection

9—Firewalls and Intrusion Prevention

Systems

Part 5—Network Security

Cryptography (Tier 2)

• Basic cryptography terminology

• Cipher types

• Overview of mathematical preliminaries

• Public key I dnfrastructure

2—Cryptographic Tools

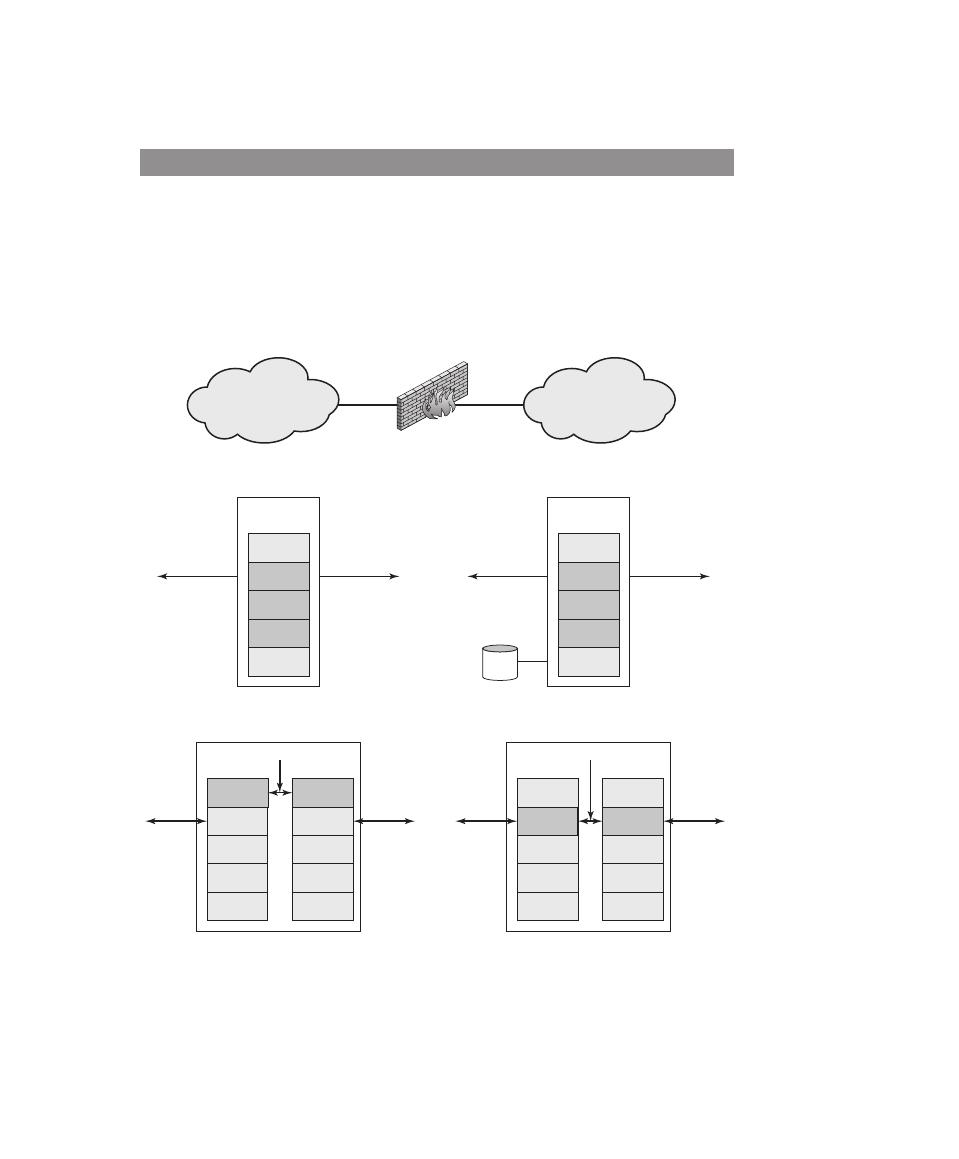

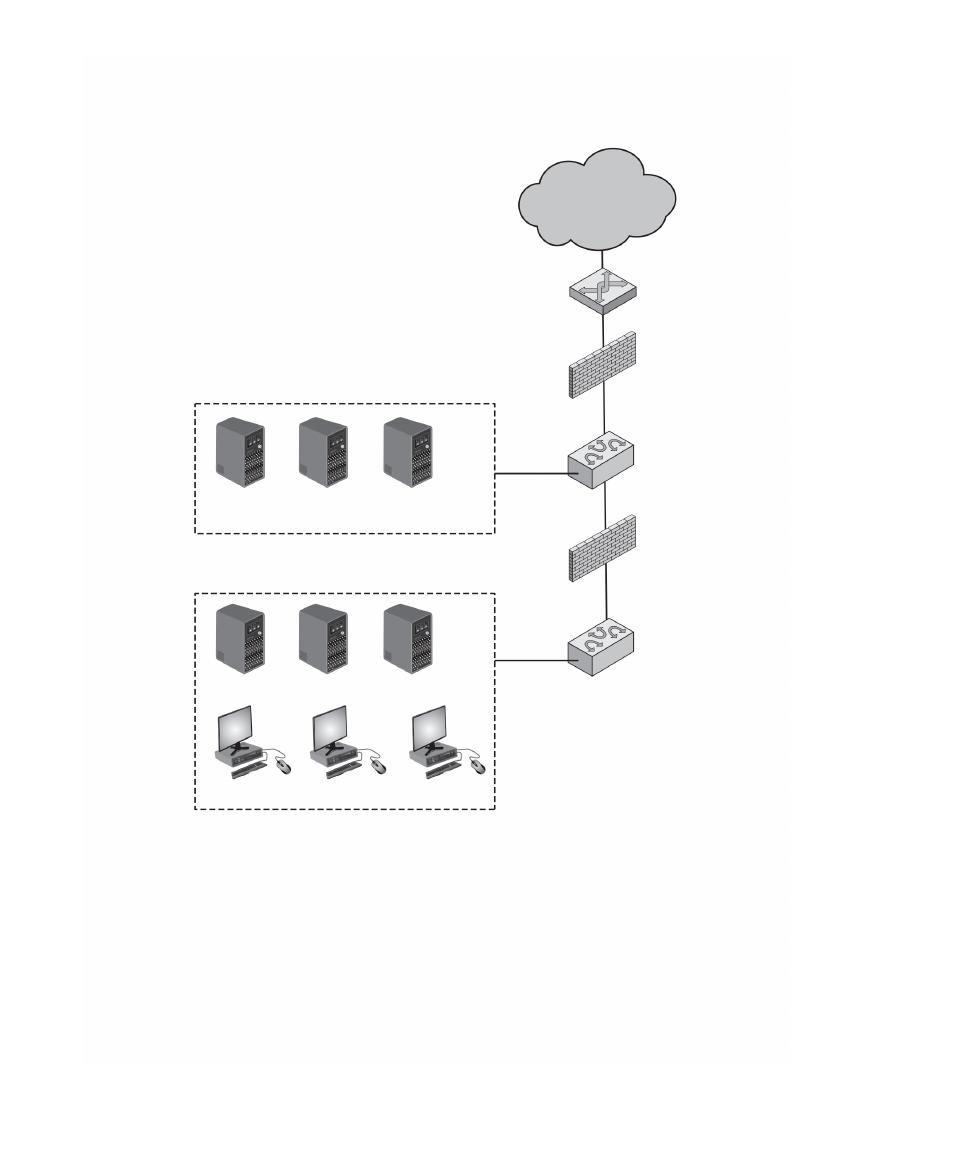

Part 4—Cryptographic Algorithms

0.7 / standards

9

•

Math: Includes a basic math refresher, a queuing analysis primer, a number

system primer, and links to numerous math sites.

•

How-to: Advice and guidance for solving homework problems, writing technical

reports, and preparing technical presentations.

•

Research resources: Links to important collections of papers, technical

reports, and bibliographies.

•

Other useful: A variety of other useful documents and links.

•

Computer science careers: Useful links and documents for those considering a

career in computer science.

Other Web Sites

Numerous Web sites provide information related to the topics of this book. The

Companion Website provides links to these sites, organized by chapter.

There are a number of worthwhile Web-based forums dealing with aspects of

computer security. The Companion Web site provides links to these.

Many of the security techniques and applications described in this book have been

specified as standards. Additionally, standards have been developed to cover man-

agement practices and the overall architecture of security mechanisms and services.

Throughout this book, we describe the most important standards in use or that are

being developed for various aspects of computer security. Various organizations

have been involved in the development or promotion of these standards. The most

important (in the current context) of these organizations are as follows:

•

National Institute of Standards and Technology: NIST is a U.S. federal agency

that deals with measurement science, standards, and technology related to

U.S. government use and to the promotion of U.S. private sector innovation.

Despite its national scope, NIST Federal Information Processing Standards

(FIPS) and Special Publications (SP) have a worldwide impact.

•

Internet Society: ISOC is a professional membership society with worldwide

organizational and individual membership. It provides leadership in address-

ing issues that confront the future of the Internet and is the organization home

for the groups responsible for Internet infrastructure standards, including the

Internet Engineering Task Force (IETF) and the Internet Architecture Board

(IAB). These organizations develop Internet standards and related specifica-

tions, all of which are published as Requests for Comments (RFCs).

•

ITU-T: The International Telecommunication Union (ITU) is an interna-

tional organization within the United Nations System in which governments

and the private sector coordinate global telecom networks and services. The

ITU Telecommunication Standardization Sector (ITU-T) is one of the three

sectors of the ITU. ITU-T’s mission is the production of standards cover-

ing all fields of telecommunications. ITU-T standards are referred to as

Recommendations.

10

Chapter 0 / reader’s and InstruCtor’s GuIde

•

ISO: The International Organization for Standardization (ISO)

1

is a world-

wide federation of national standards bodies. ISO is a nongovernmental or-

ganization that promotes the development of standardization and related

activities with a view to facilitating the international exchange of goods and

services, and to developing cooperation in the spheres of intellectual, scien-

tific, technological, and economic activity. ISO’s work results in international

agreements that are published as International Standards.

A more detailed discussion of these organizations is contained in Appendix C.

1

ISO is not an acronym (in which case it would be IOS), but a word, derived from the Greek, meaning

equal

.

11

11

1.1

Computer Security Concepts

A Definition of Computer Security

Examples

The Challenges of Computer Security

A Model for Computer Security

1.2

Threats, Attacks, and Assets

Threats and Attacks

Threats and Assets

1.3

Security Functional Requirements

1.4

Fundamental Security Design Principles

1.5

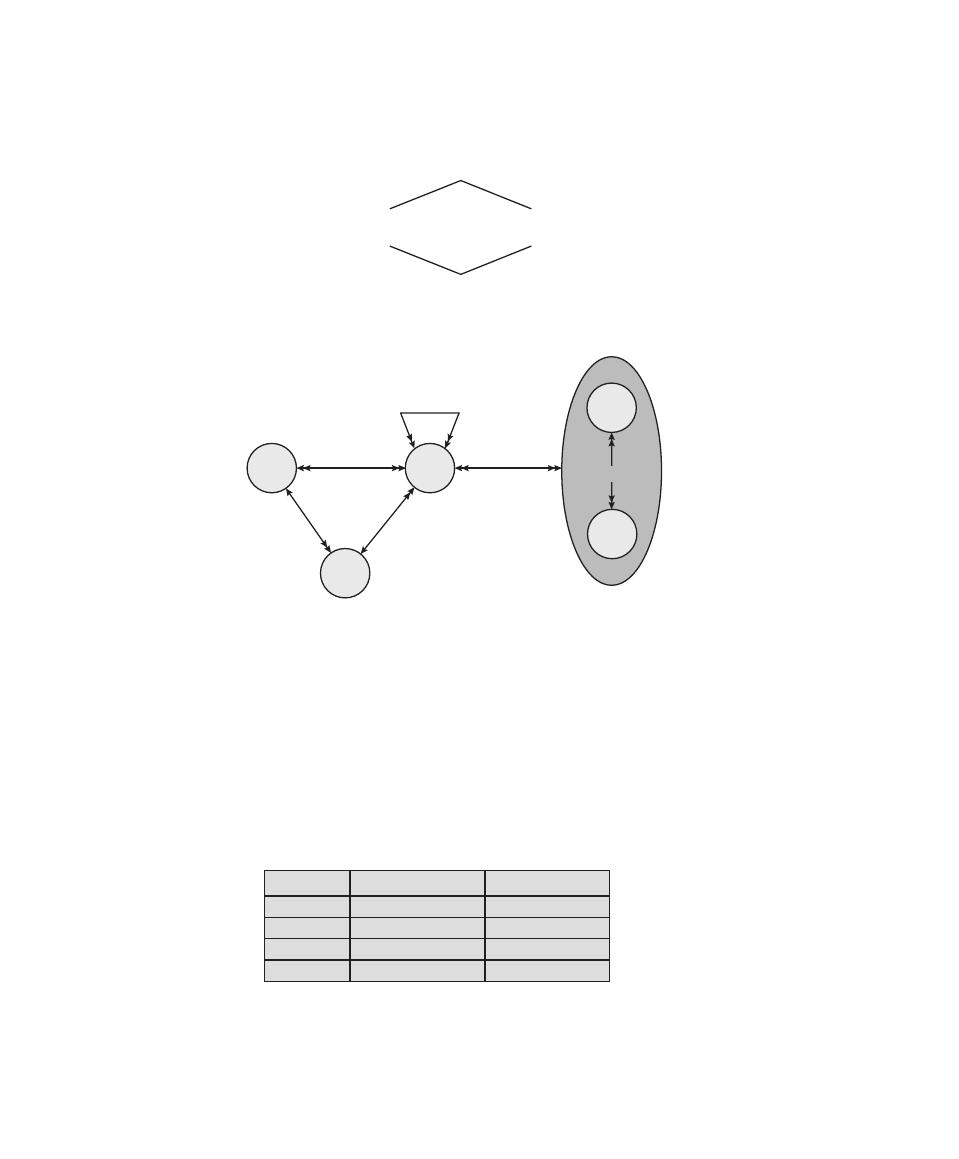

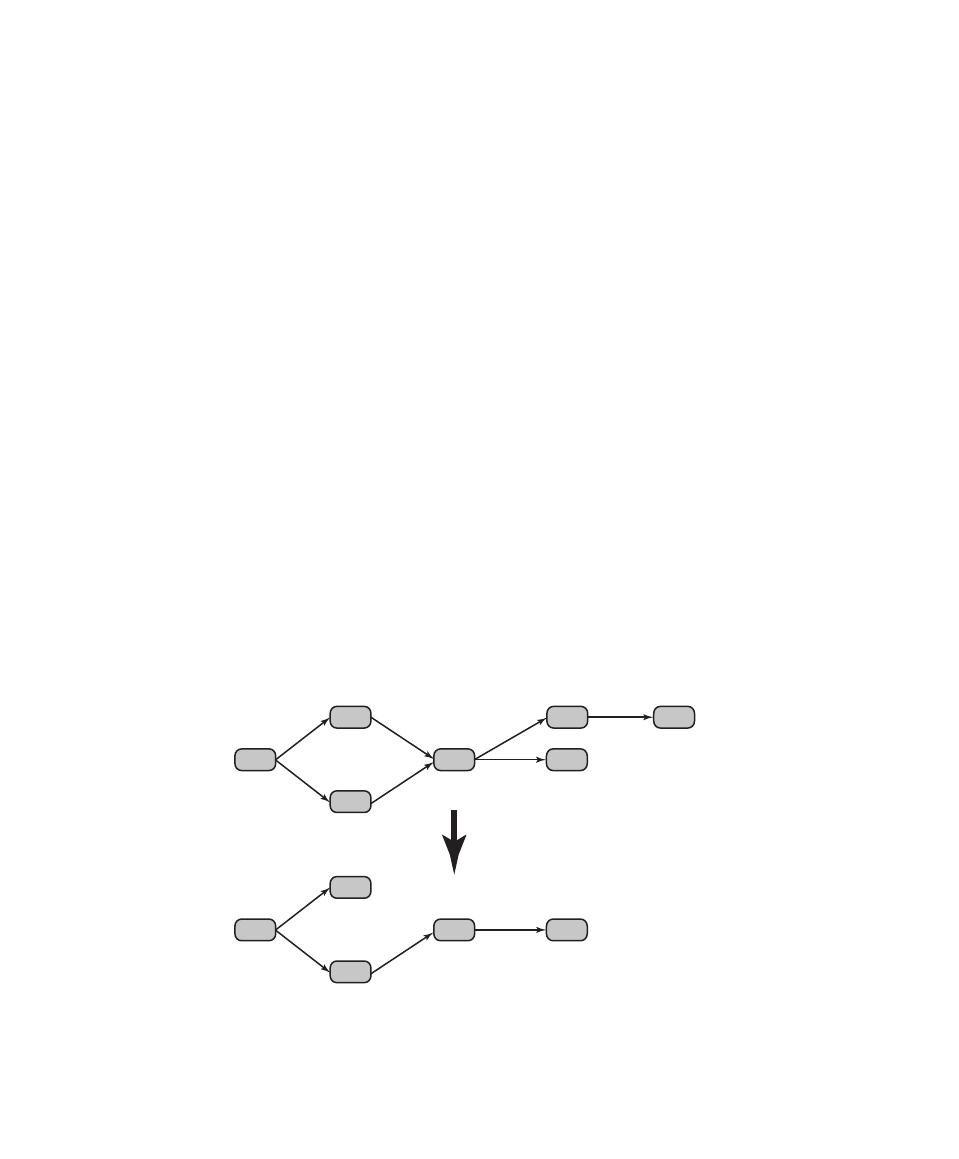

Attack Surfaces and Attack Trees

Attack Surfaces

Attack Trees

1.6

Computer Security Strategy

Security Policy

Security Implementation

Assurance and Evaluation

1.7

Recommended Reading

1.8

Key Terms, Review Questions, and Problems

12

Chapter 1 / Overview

This chapter provides an overview of computer security. We begin with a discus-

sion of what we mean by computer security. In essence, computer security deals

with computer-related assets that are subject to a variety of threats and for which

various measures are taken to protect those assets. Accordingly, the next section of

this chapter provides a brief overview of the categories of computer-related assets

that users and system managers wish to preserve and protect, and a look at the

various threats and attacks that can be made on those assets. Then, we survey the

measures that can be taken to deal with such threats and attacks. This we do from

three different viewpoints, in Sections 1.3 through 1.5. We then lay out in general

terms a computer security strategy.

The focus of this chapter, and indeed this book, is on three fundamental

questions:

1.

What assets do we need to protect?

2.

How are those assets threatened?

3.

What can we do to counter those threats?

1.1 Computer SeCurity ConCeptS

A Definition of Computer Security

The NIST Computer Security Handbook [NIST95] defines the term computer secu-

rity

as follows:

L

earning

O

bjectives

After studying this chapter, you should be able to:

◆

Describe the key security requirements of confidentiality, integrity, and

availability.

◆

Discuss the types of security threats and attacks that must be dealt with

and give examples of the types of threats and attacks that apply to different

categories of computer and network assets.

◆

Summarize the functional requirements for computer security.

◆

Explain the fundamental security design principles.

◆

Discuss the use of attack surfaces and attack trees.

◆

Understand the principle aspects of a comprehensive security strategy.

Computer Security: The protection afforded to an automated information

system in order to attain the applicable objectives of preserving the integrity,

availability, and confidentiality of information system resources (includes hard-

ware, software, firmware, information/data, and telecommunications).

1.1 / COmputer SeCurity COnCeptS

13

This definition introduces three key objectives that are at the heart of computer

security:

•

Confidentiality: This term covers two related concepts:

— Data confidentiality:

1

Assures that private or confidential information is

not made available or disclosed to unauthorized individuals.

— Privacy: Assures that individuals control or influence what information

related to them may be collected and stored and by whom and to whom

that information may be disclosed.

•

Integrity: This term covers two related concepts:

— Data integrity: Assures that information and programs are changed only

in a specified and authorized manner.

— System integrity: Assures that a system performs its intended function in

an unimpaired manner, free from deliberate or inadvertent unauthorized

manipulation of the system.

•

Availability: Assures that systems work promptly and service is not denied to

authorized users.

These three concepts form what is often referred to as the CIA triad. The three

concepts embody the fundamental security objectives for both data and for informa-

tion and computing services. For example, the NIST standard FIPS 199 (Standards

for Security Categorization of Federal Information and Information Systems

) lists

confidentiality, integrity, and availability as the three security objectives for infor-

mation and for information systems. FIPS 199 provides a useful characterization of

these three objectives in terms of requirements and the definition of a loss of secu-

rity in each category:

•

Confidentiality: Preserving authorized restrictions on information access and

disclosure, including means for protecting personal privacy and proprietary in-

formation. A loss of confidentiality is the unauthorized disclosure of information.

•

Integrity: Guarding against improper information modification or destruction,

including ensuring information nonrepudiation and authenticity. A loss of

integrity is the unauthorized modification or destruction of information.

•

Availability: Ensuring timely and reliable access to and use of information.

A loss of availability is the disruption of access to or use of information or an

information system.

Although the use of the CIA triad to define security objectives is well estab-

lished, some in the security field feel that additional concepts are needed to present

a complete picture. Two of the most commonly mentioned are as follows:

•

Authenticity: The property of being genuine and being able to be verified and

trusted; confidence in the validity of a transmission, a message, or message

1

RFC 4949 defines information as “facts and ideas, which can be represented (encoded) as various forms

of data,” and data as “information in a specific physical representation, usually a sequence of symbols

that have meaning; especially a representation of information that can be processed or produced by a

computer.” Security literature typically does not make much of a distinction; nor does this book.

14

Chapter 1 / Overview

originator. This means verifying that users are who they say they are and that

each input arriving at the system came from a trusted source.

•

Accountability: The security goal that generates the requirement for actions

of an entity to be traced uniquely to that entity. This supports nonrepudiation,

deterrence, fault isolation, intrusion detection and prevention, and after-action

recovery and legal action. Because truly secure systems are not yet an achiev-

able goal, we must be able to trace a security breach to a responsible party.

Systems must keep records of their activities to permit later forensic analysis to

trace security breaches or to aid in transaction disputes.

Note that FIPS 199 includes authenticity under integrity.

Examples

We now provide some examples of applications that illustrate the requirements just

enumerated.

2

For these examples, we use three levels of impact on organizations or

individuals should there be a breach of security (i.e., a loss of confidentiality, integrity,

or availability). These levels are defined in FIPS 199:

•

Low: The loss could be expected to have a limited adverse effect on organiza-

tional operations, organizational assets, or individuals. A limited adverse effect

means that, for example, the loss of confidentiality, integrity, or availability

might (i) cause a degradation in mission capability to an extent and duration

that the organization is able to perform its primary functions, but the effec-

tiveness of the functions is noticeably reduced; (ii) result in minor damage to

organizational assets; (iii) result in minor financial loss; or (iv) result in minor

harm to individuals.

•

Moderate: The loss could be expected to have a serious adverse effect on

organizational operations, organizational assets, or individuals. A serious

adverse effect means that, for example, the loss might (i) cause a significant

degradation in mission capability to an extent and duration that the organiza-

tion is able to perform its primary functions, but the effectiveness of the func-

tions is significantly reduced; (ii) result in significant damage to organizational

assets; (iii) result in significant financial loss; or (iv) result in significant harm

to individuals that does not involve loss of life or serious, life-threatening

injuries.

•

High: The loss could be expected to have a severe or catastrophic adverse

effect on organizational operations, organizational assets, or individuals. A

severe or catastrophic adverse effect means that, for example, the loss might

(i) cause a severe degradation in or loss of mission capability to an extent

and duration that the organization is not able to perform one or more of its

primary functions; (ii) result in major damage to organizational assets; (iii)

result in major financial loss; or (iv) result in severe or catastrophic harm to

individuals involving loss of life or serious life-threatening injuries.

2

These examples are taken from a security policy document published by the Information Technology

Security and Privacy Office at Purdue University.

1.1 / COmputer SeCurity COnCeptS

15

C

onfidentiality

Student grade information is an asset whose confidentiality is

considered to be highly important by students. In the United States, the release of

such information is regulated by the Family Educational Rights and Privacy Act

(FERPA). Grade information should only be available to students, their parents,

and employees that require the information to do their job. Student enrollment

information may have a moderate confidentiality rating. While still covered by

FERPA, this information is seen by more people on a daily basis, is less likely to be

targeted than grade information, and results in less damage if disclosed. Directory

information, such as lists of students or faculty or departmental lists, may be assigned

a low confidentiality rating or indeed no rating. This information is typically freely

available to the public and published on a school’s Web site.

i

ntegrity

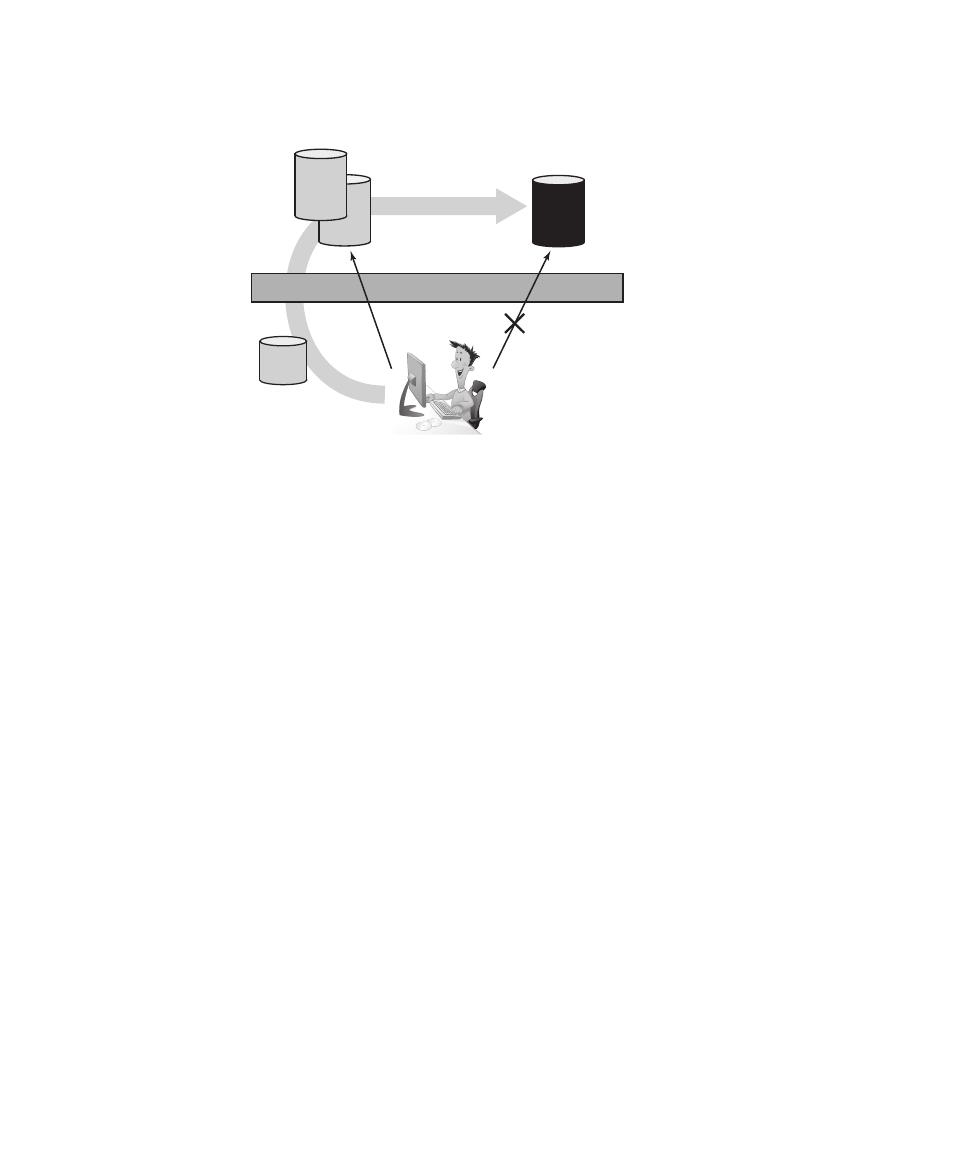

Several aspects of integrity are illustrated by the example of a hospital

patient’s allergy information stored in a database. The doctor should be able to

trust that the information is correct and current. Now suppose that an employee

(e.g., a nurse) who is authorized to view and update this information deliberately

falsifies the data to cause harm to the hospital. The database needs to be restored

to a trusted basis quickly, and it should be possible to trace the error back to the

person responsible. Patient allergy information is an example of an asset with a high

requirement for integrity. Inaccurate information could result in serious harm or

death to a patient and expose the hospital to massive liability.

An example of an asset that may be assigned a moderate level of integrity

requirement is a Web site that offers a forum to registered users to discuss some

specific topic. Either a registered user or a hacker could falsify some entries or

deface the Web site. If the forum exists only for the enjoyment of the users, brings

in little or no advertising revenue, and is not used for something important such

as research, then potential damage is not severe. The Web master may experience

some data, financial, and time loss.

An example of a low integrity requirement is an anonymous online poll. Many

Web sites, such as news organizations, offer these polls to their users with very few

safeguards. However, the inaccuracy and unscientific nature of such polls is well

understood.

a

vailability

The more critical a component or service, the higher the level of

availability required. Consider a system that provides authentication services for

critical systems, applications, and devices. An interruption of service results in

the inability for customers to access computing resources and staff to access the

resources they need to perform critical tasks. The loss of the service translates into a

large financial loss in lost employee productivity and potential customer loss.

An example of an asset that would typically be rated as having a moderate

availability requirement is a public Web site for a university; the Web site provides

information for current and prospective students and donors. Such a site is not a

critical component of the university’s information system, but its unavailability will

cause some embarrassment.

An online telephone directory lookup application would be classified as a low

availability requirement. Although the temporary loss of the application may be

16

Chapter 1 / Overview

an annoyance, there are other ways to access the information, such as a hardcopy

directory or the operator.

The Challenges of Computer Security

Computer security is both fascinating and complex. Some of the reasons follow:

1.

Computer security is not as simple as it might first appear to the novice. The

requirements seem to be straightforward; indeed, most of the major require-

ments for security services can be given self-explanatory one-word labels:

confidentiality, authentication, nonrepudiation, integrity. But the mechanisms

used to meet those requirements can be quite complex, and understanding

them may involve rather subtle reasoning.

2.

In developing a particular security mechanism or algorithm, one must always

consider potential attacks on those security features. In many cases, successful

attacks are designed by looking at the problem in a completely different way,

therefore exploiting an unexpected weakness in the mechanism.

3.

Because of point 2, the procedures used to provide particular services are

often counterintuitive. Typically, a security mechanism is complex, and it is

not obvious from the statement of a particular requirement that such elaborate

measures are needed. It is only when the various aspects of the threat are

considered that elaborate security mechanisms make sense.

4.

Having designed various security mechanisms, it is necessary to decide

where to use them. This is true both in terms of physical placement (e.g., at

what points in a network are certain security mechanisms needed) and in a

logical sense [e.g., at what layer or layers of an architecture such as TCP/IP

(Transmission Control Protocol/Internet Protocol) should mechanisms be

placed].

5.

Security mechanisms typically involve more than a particular algorithm or

protocol. They also require that participants be in possession of some secret

information (e.g., an encryption key), which raises questions about the

creation, distribution, and protection of that secret information. There may

also be a reliance on communications protocols whose behavior may com-

plicate the task of developing the security mechanism. For example, if the

proper functioning of the security mechanism requires setting time limits on

the transit time of a message from sender to receiver, then any protocol or

network that introduces variable, unpredictable delays may render such time

limits meaningless.

6.

Computer security is essentially a battle of wits between a perpetrator who

tries to find holes and the designer or administrator who tries to close them.

The great advantage that the attacker has is that he or she need only find a

single weakness while the designer must find and eliminate all weaknesses to

achieve perfect security.

7.

There is a natural tendency on the part of users and system managers to

perceive little benefit from security investment until a security failure

occurs.

1.1 / COmputer SeCurity COnCeptS

17

8.

Security requires regular, even constant, monitoring, and this is difficult in

today’s short-term, overloaded environment.

9.

Security is still too often an afterthought to be incorporated into a system

after the design is complete rather than being an integral part of the design

process.

10.

Many users and even security administrators view strong security as an imped-

iment to efficient and user-friendly operation of an information system or use

of information.

The difficulties just enumerated will be encountered in numerous ways as we

examine the various security threats and mechanisms throughout this book.

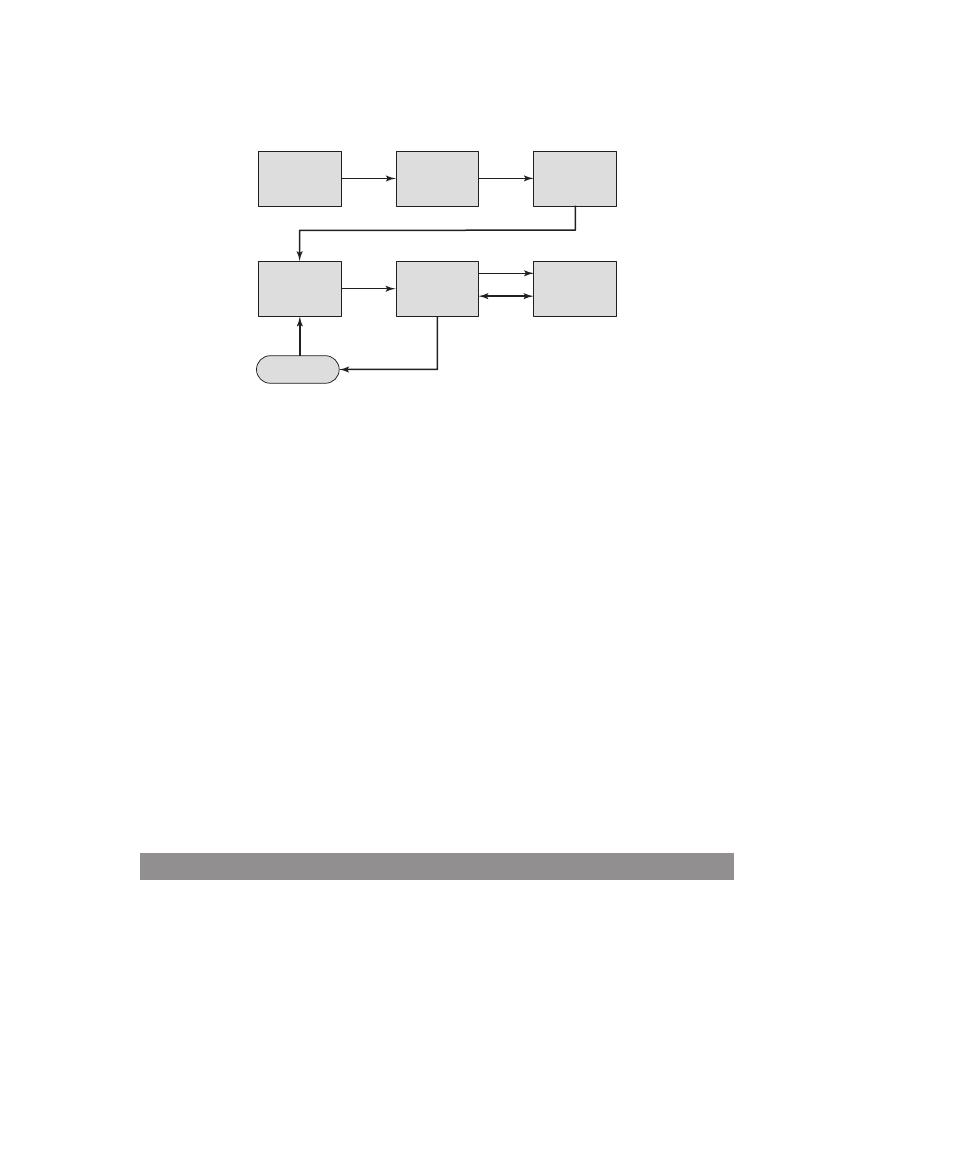

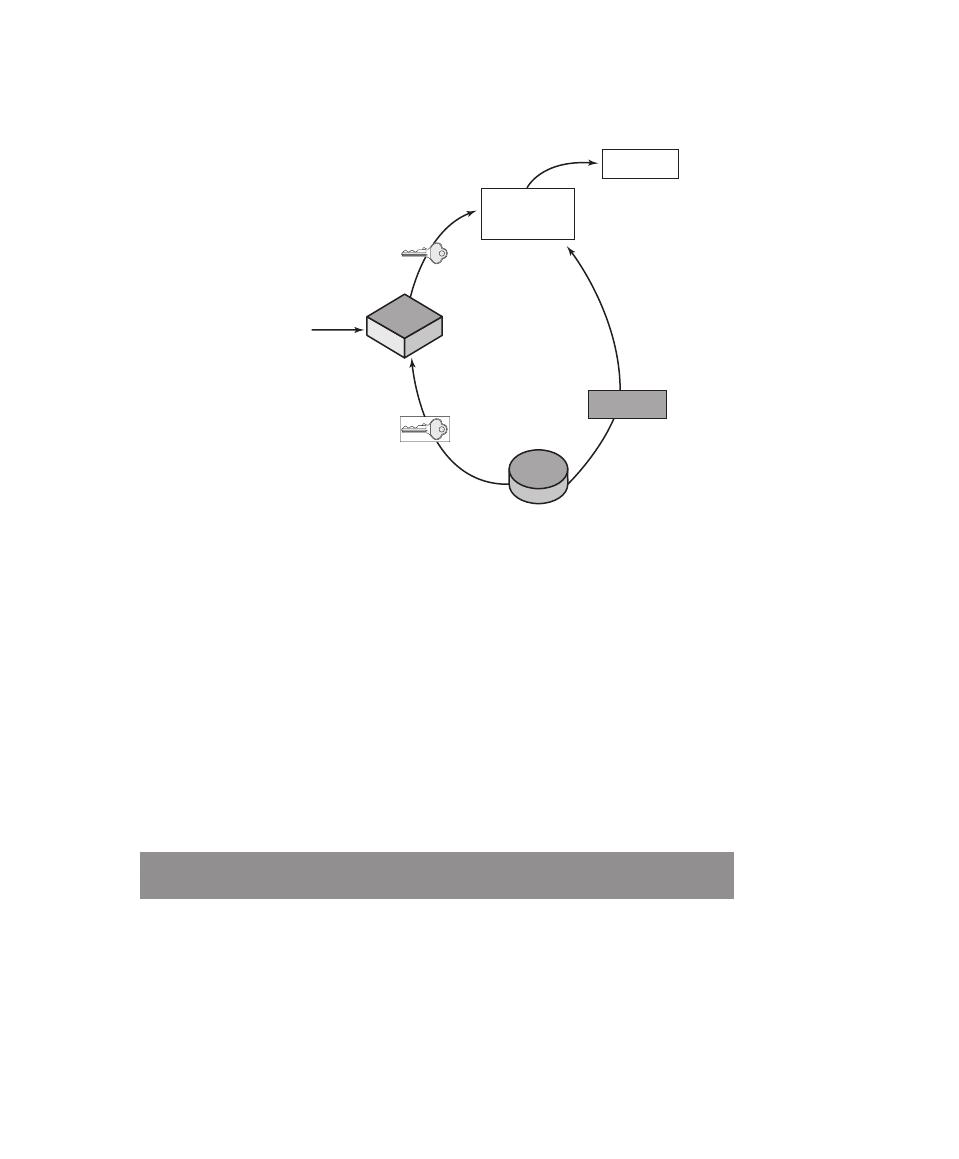

A Model for Computer Security

We now introduce some terminology that will be useful throughout the book, rely-

ing on RFC 4949, Internet Security Glossary.

3

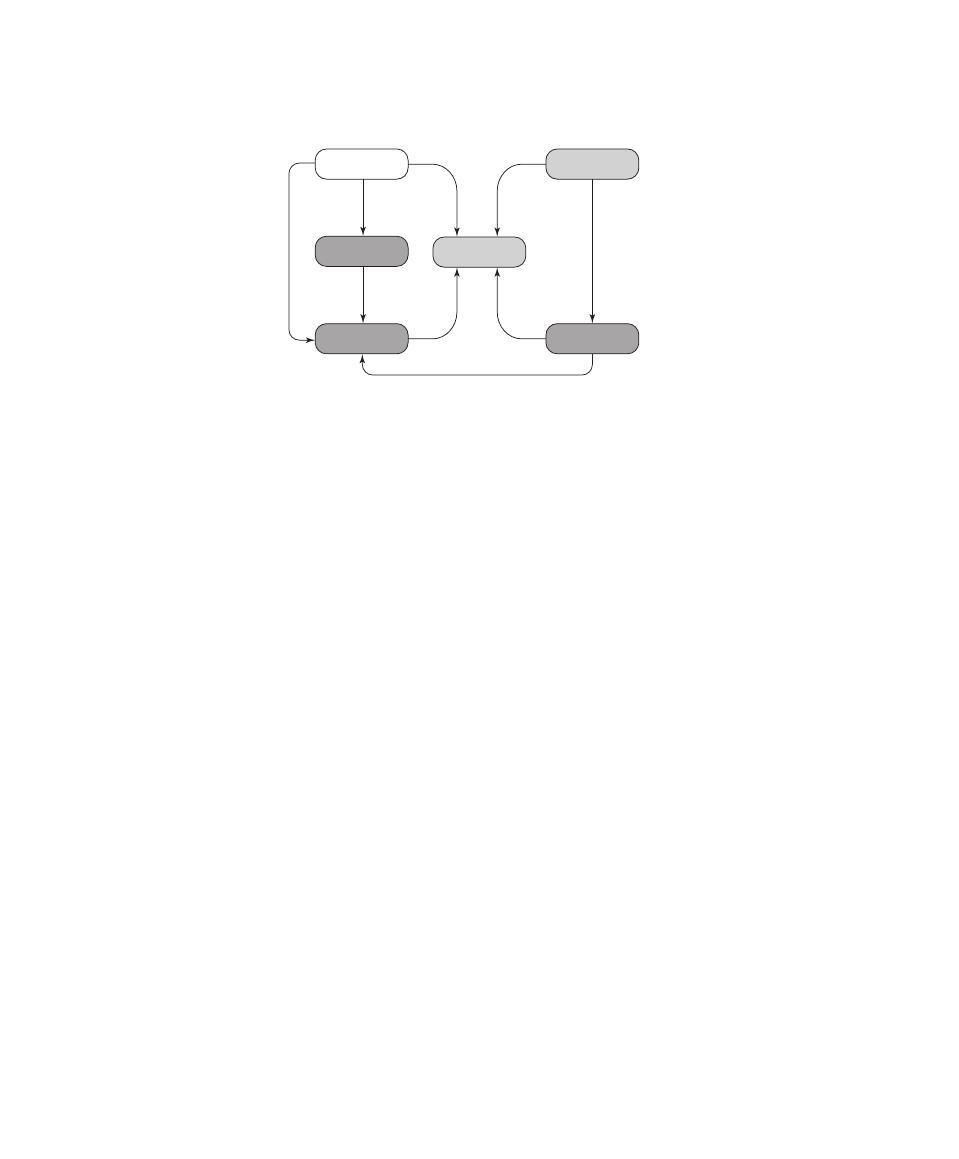

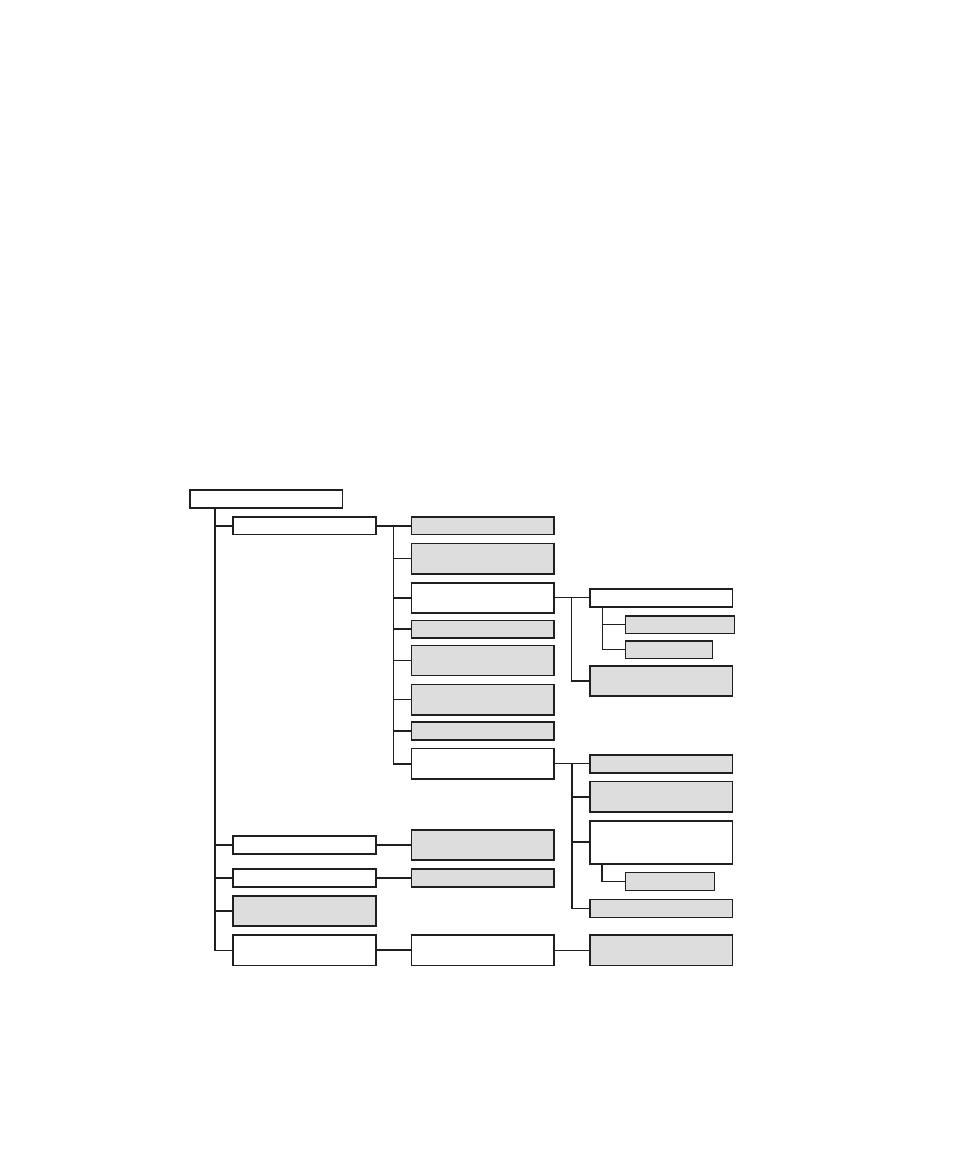

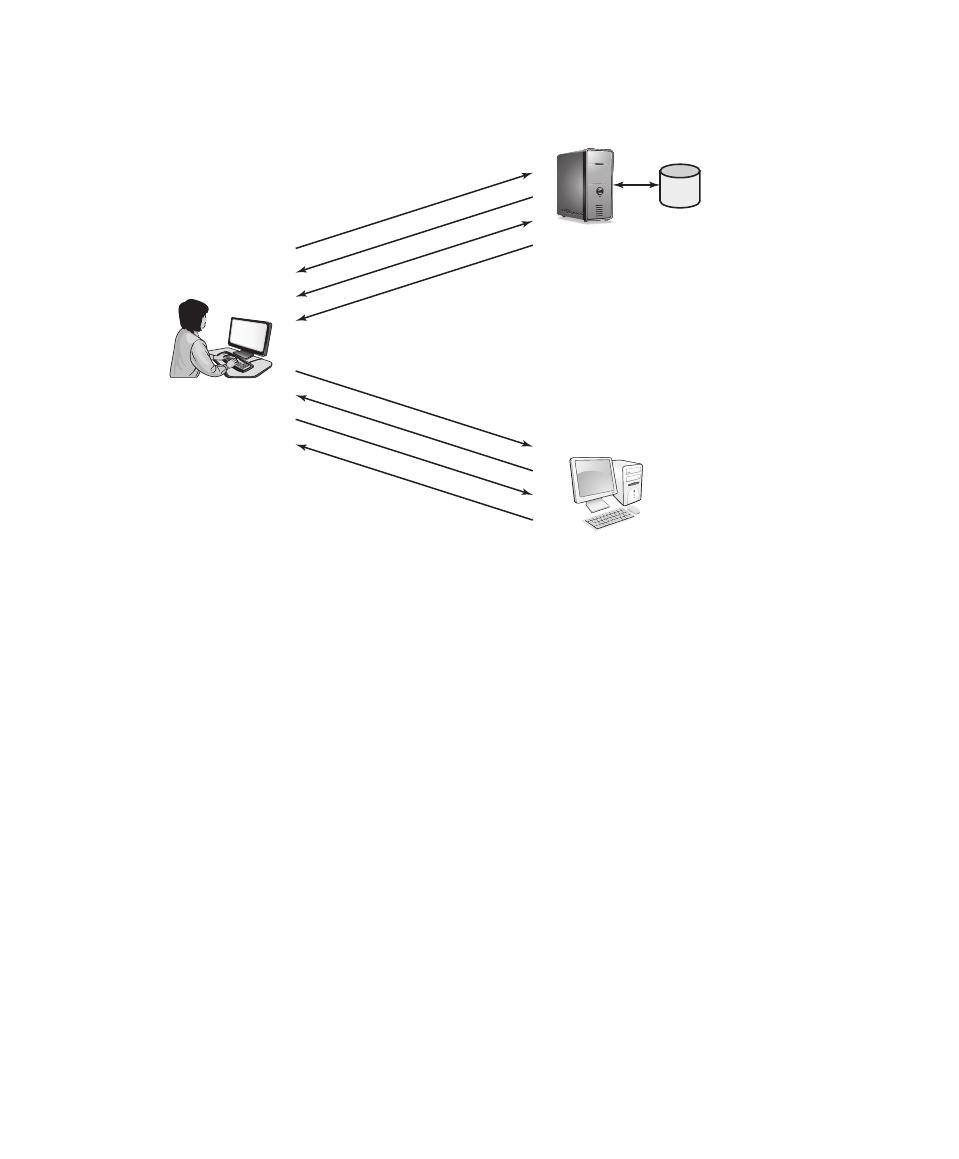

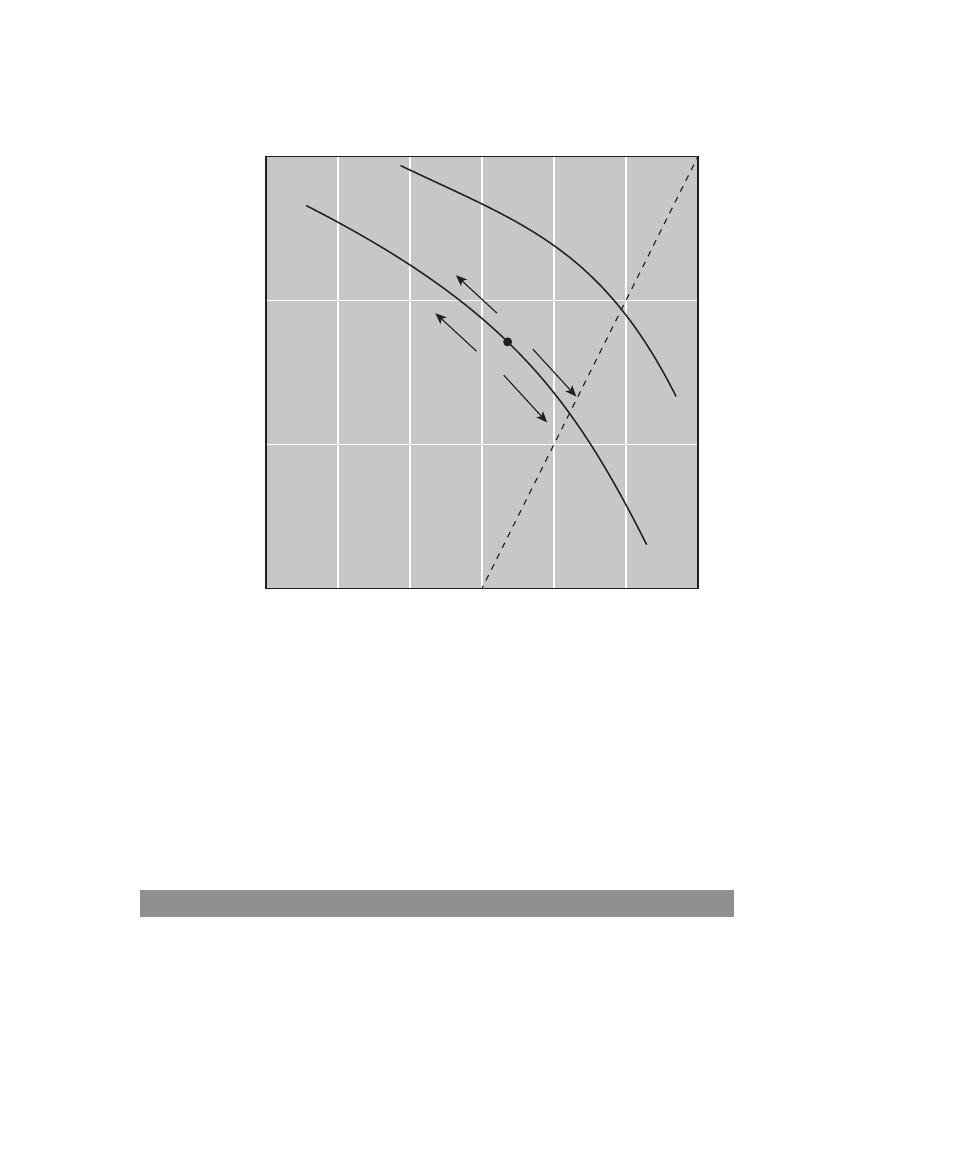

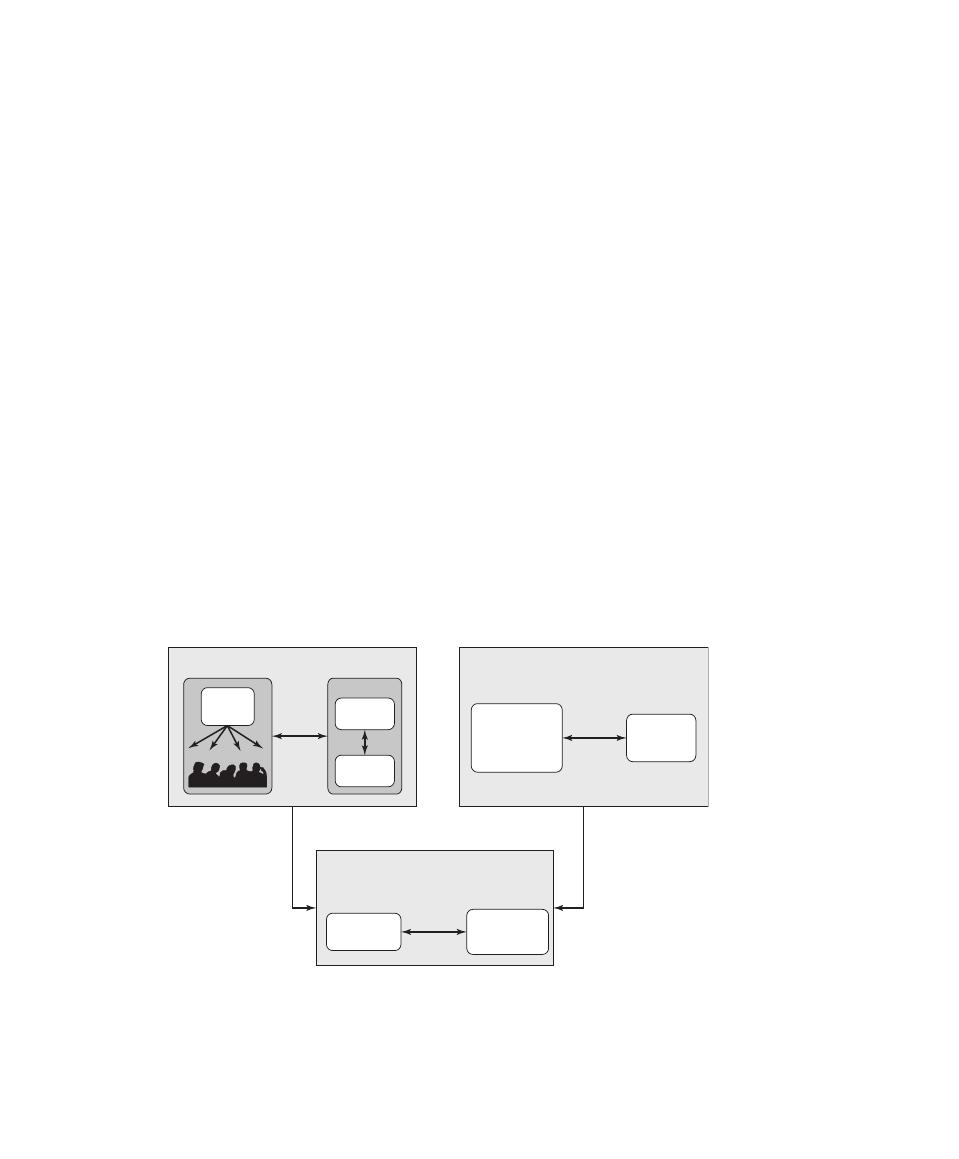

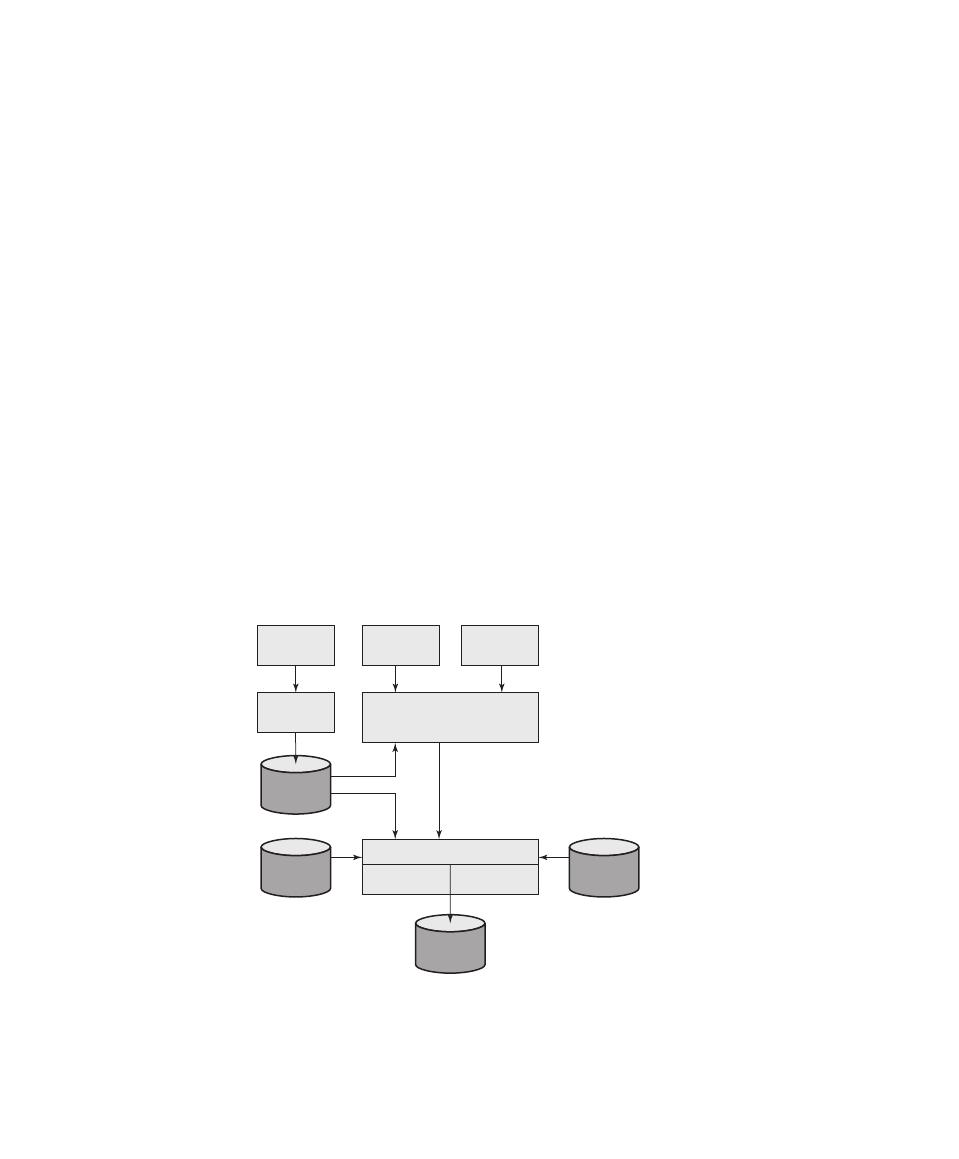

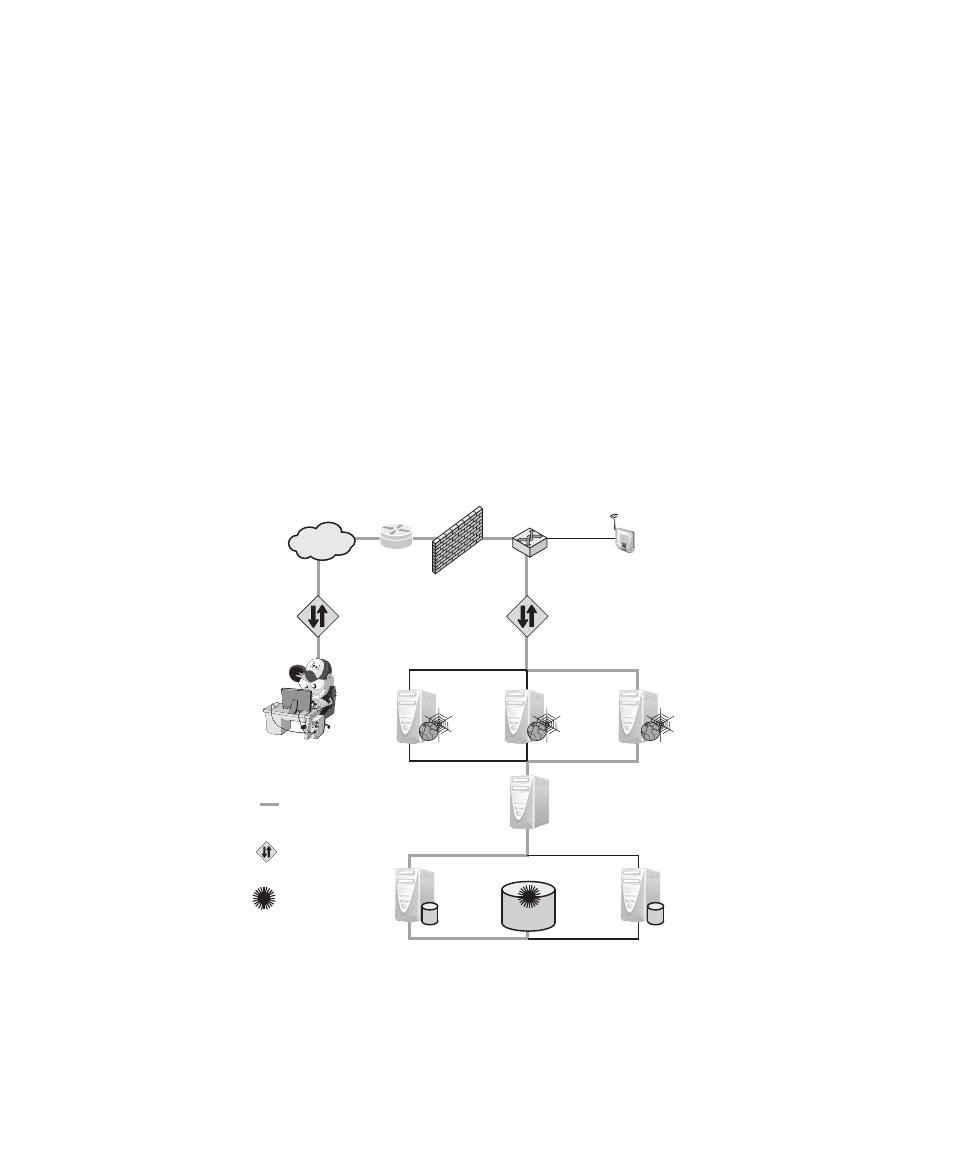

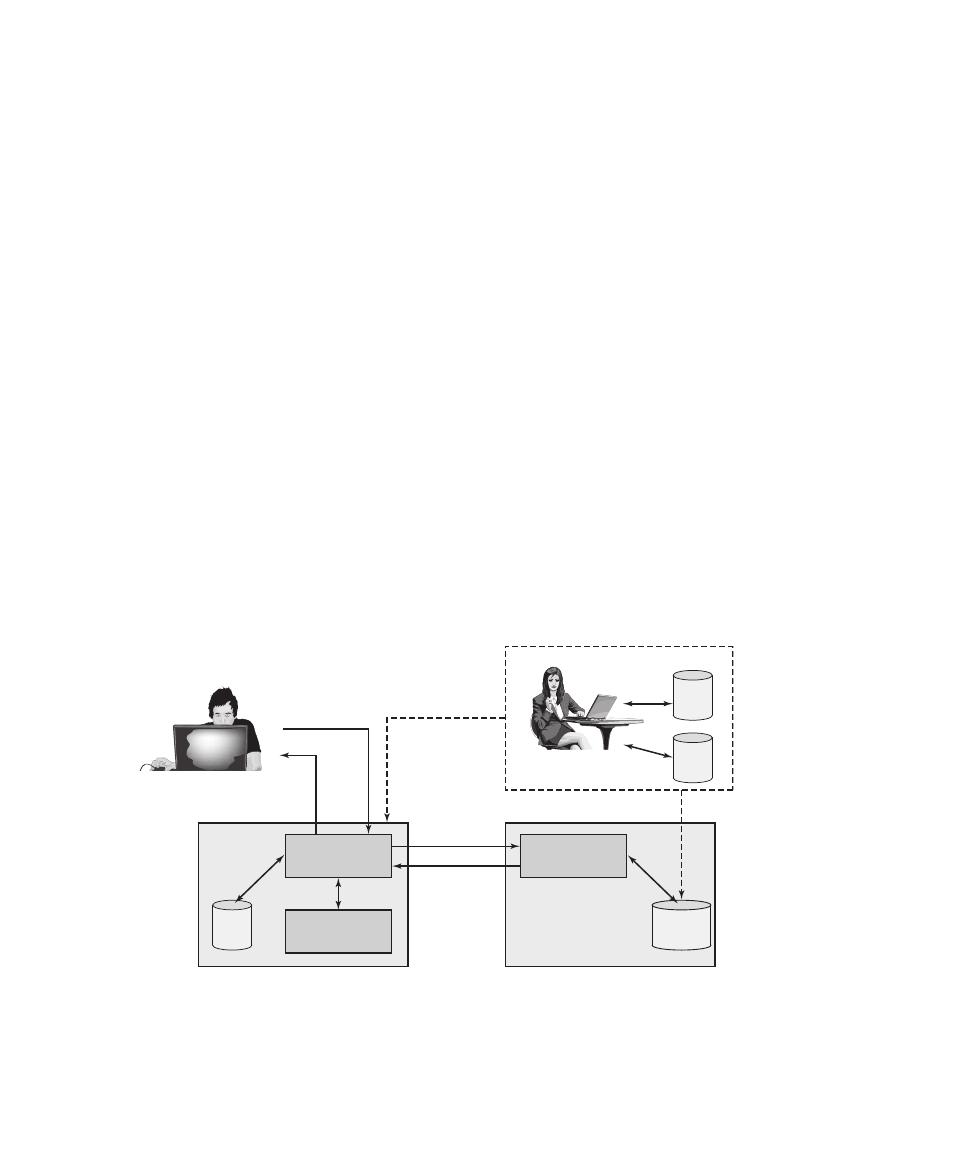

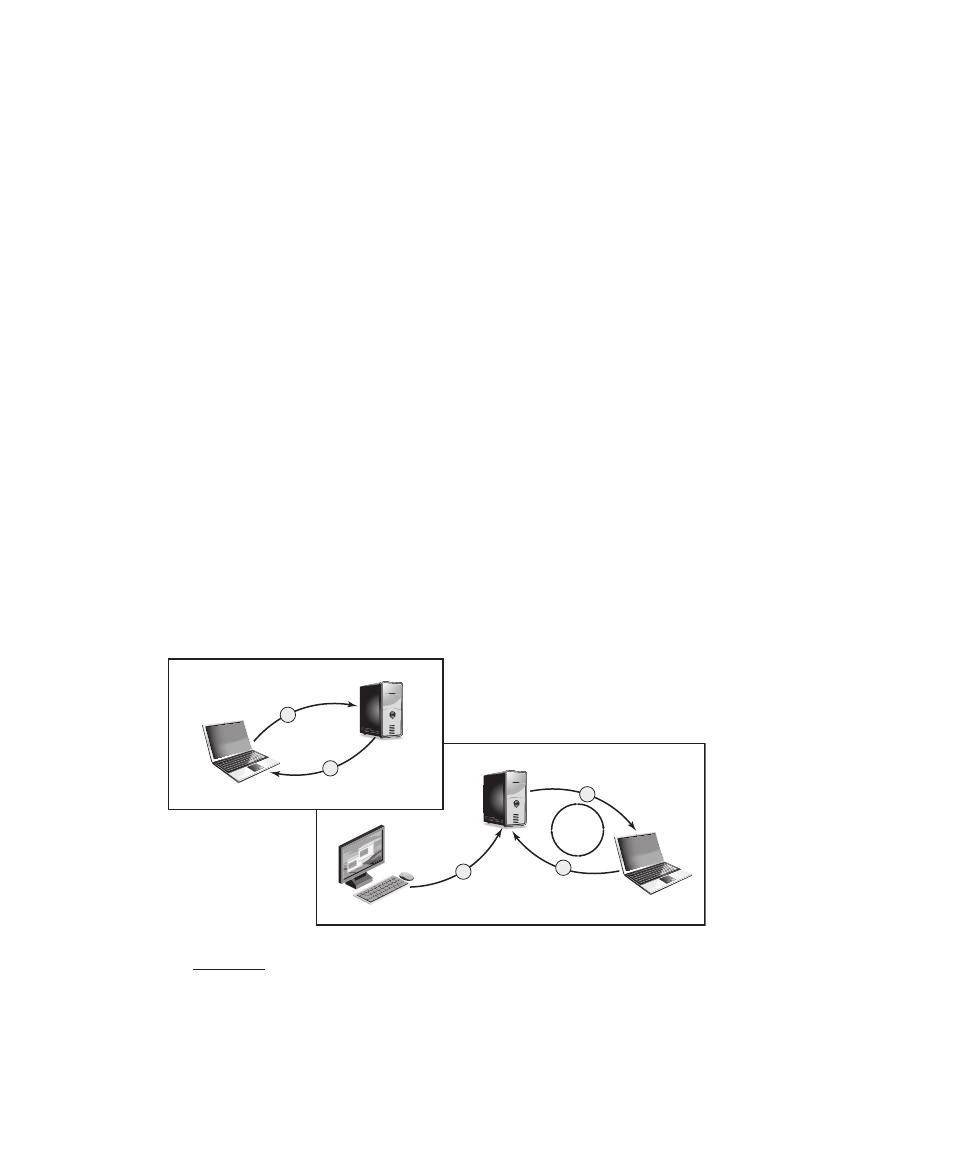

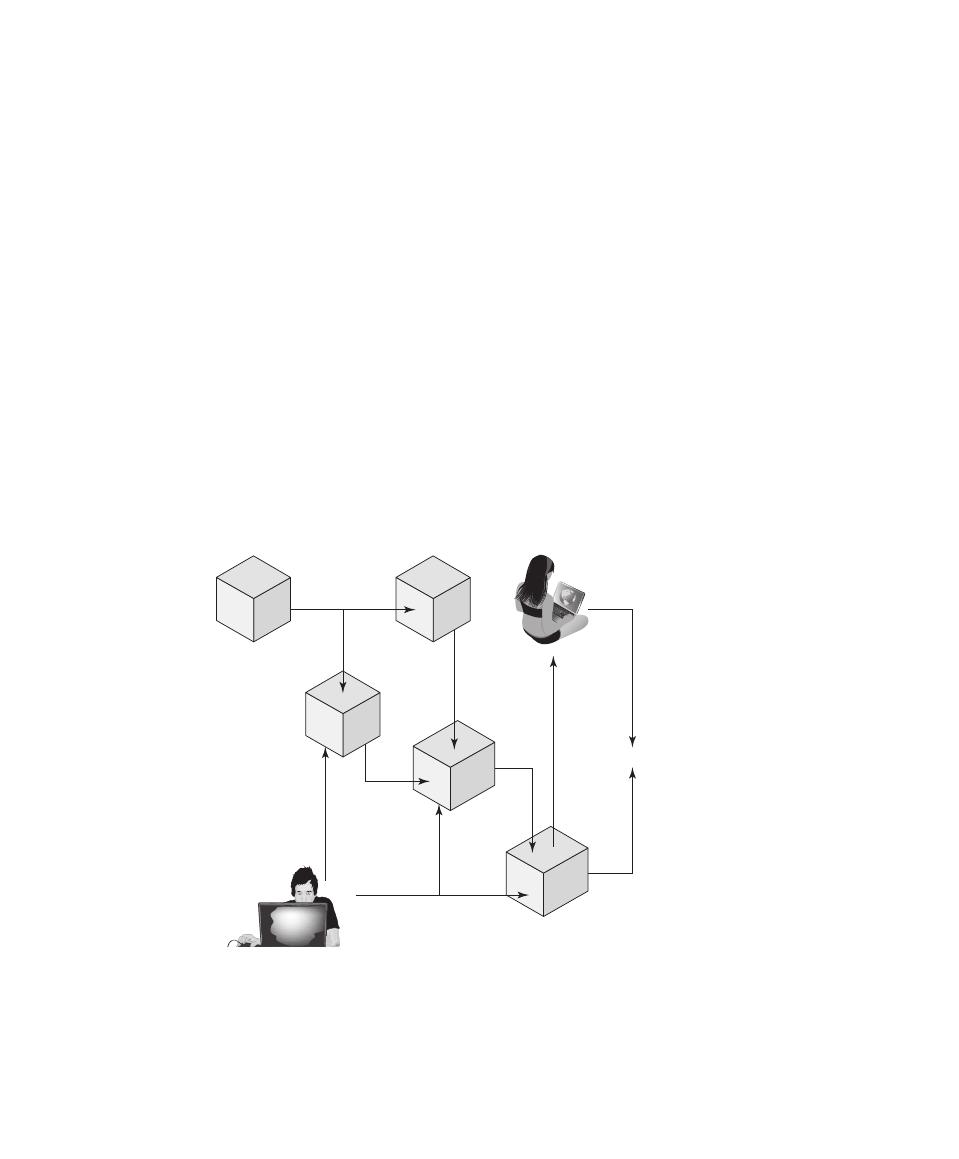

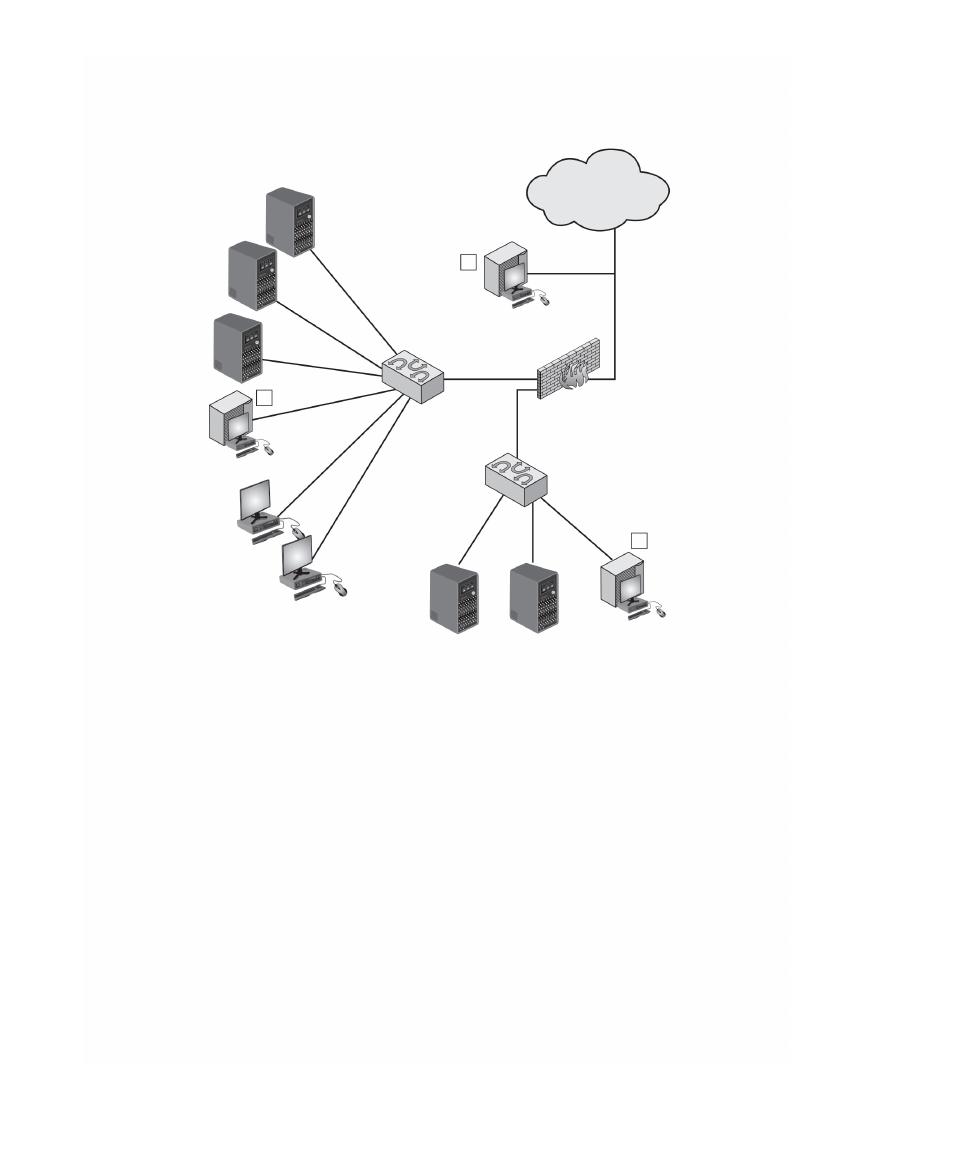

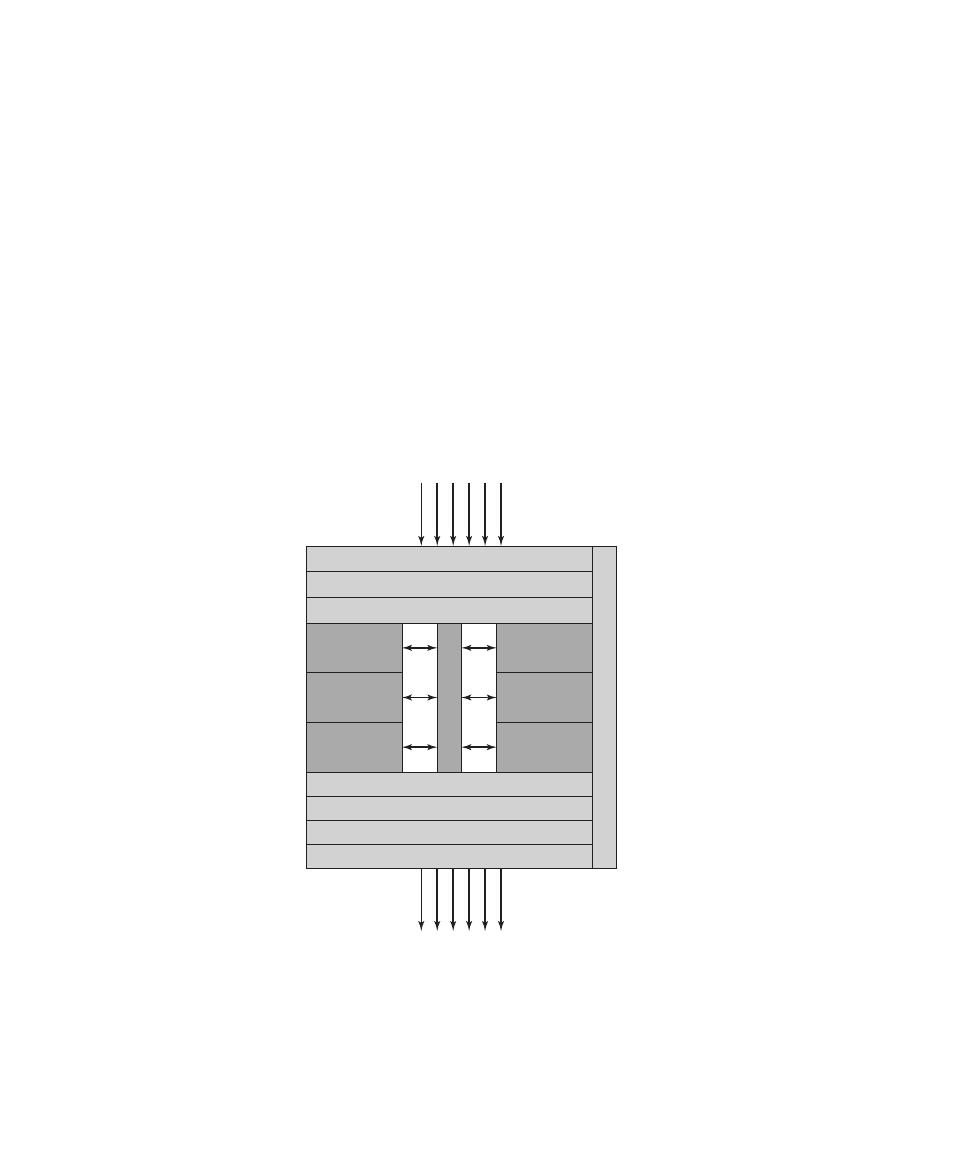

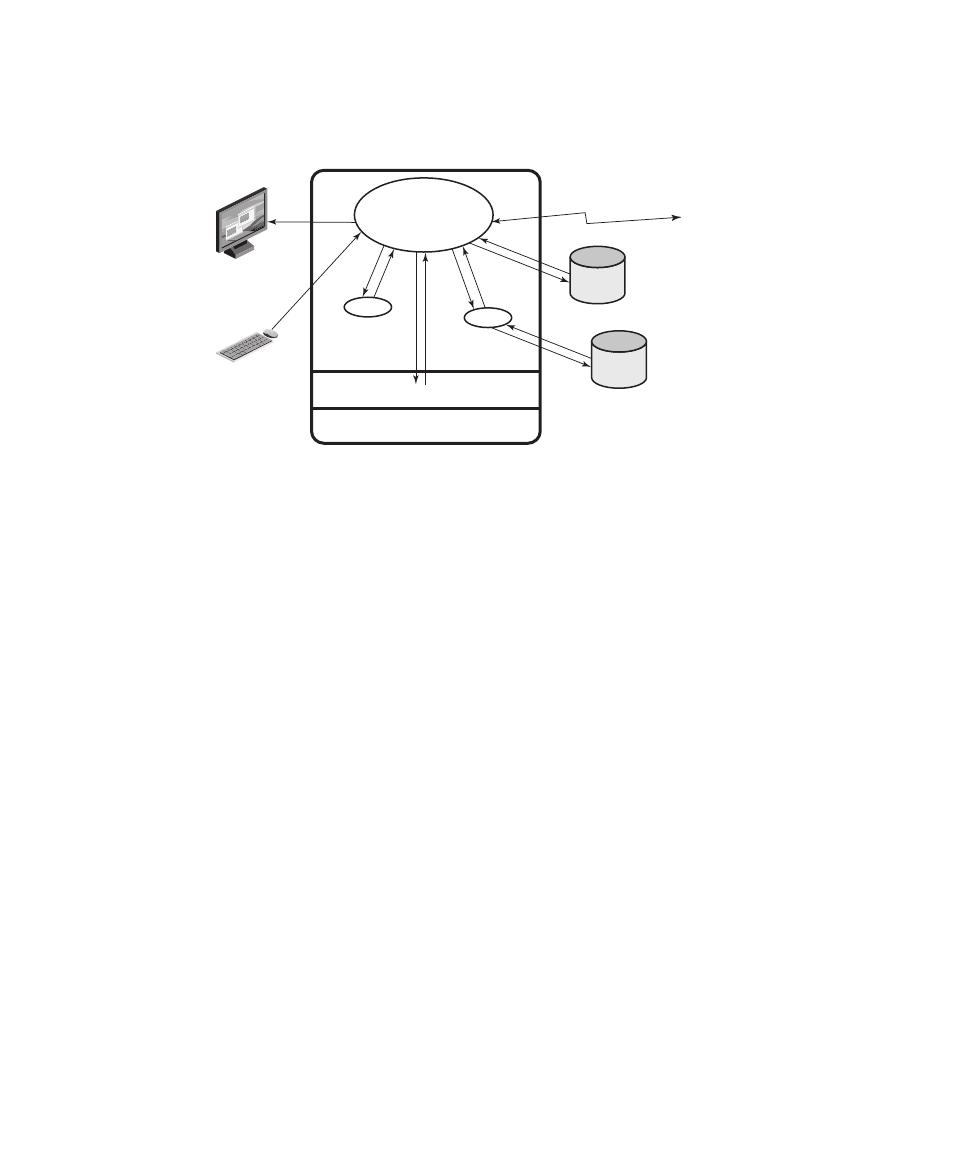

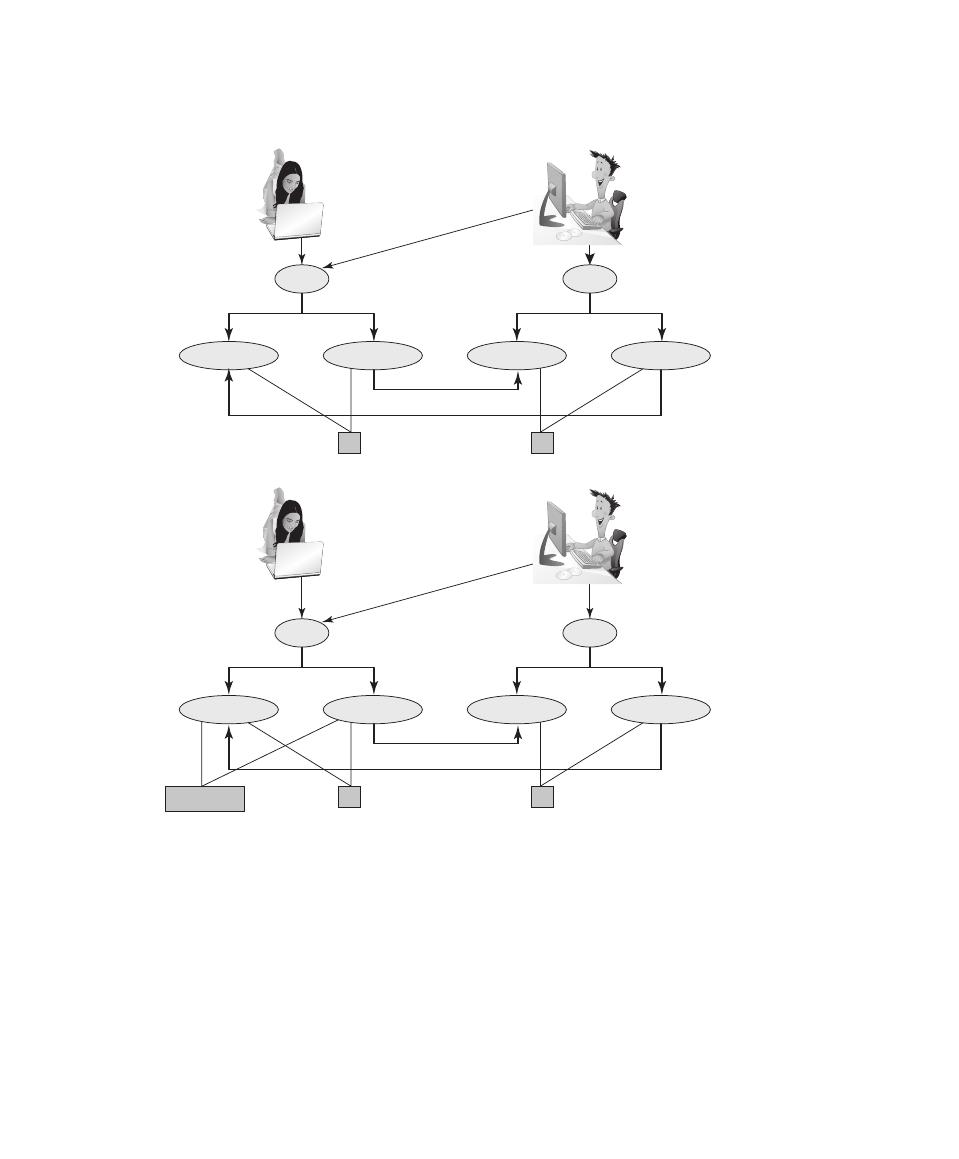

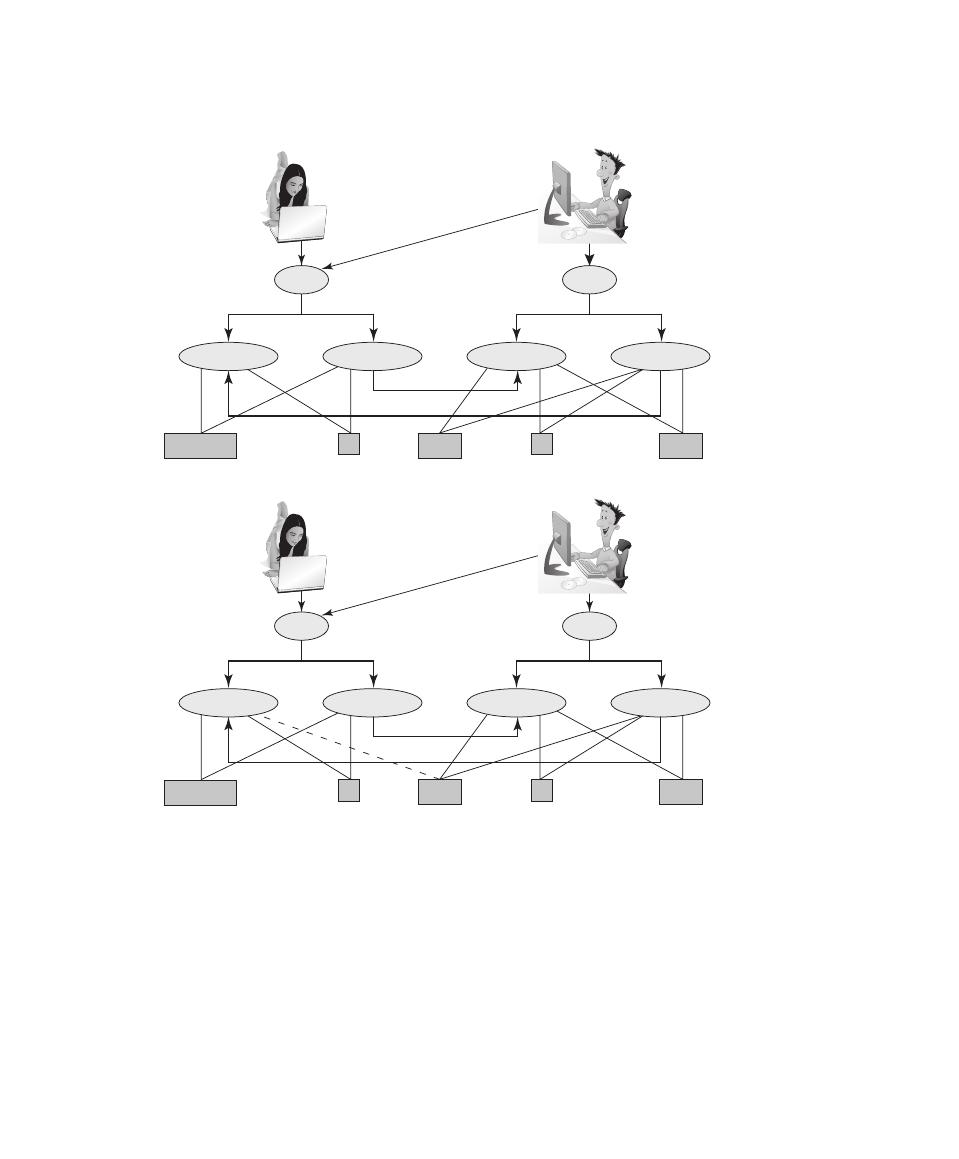

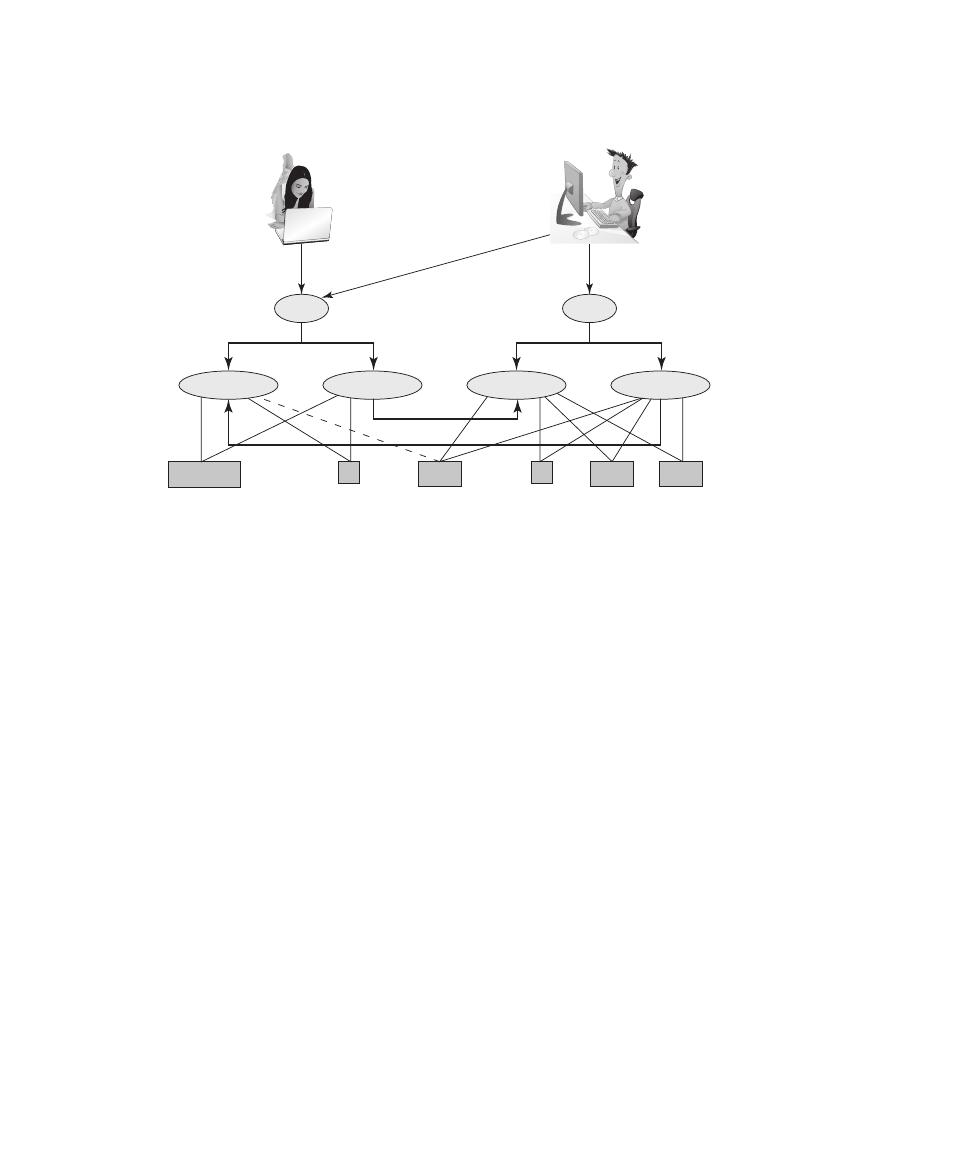

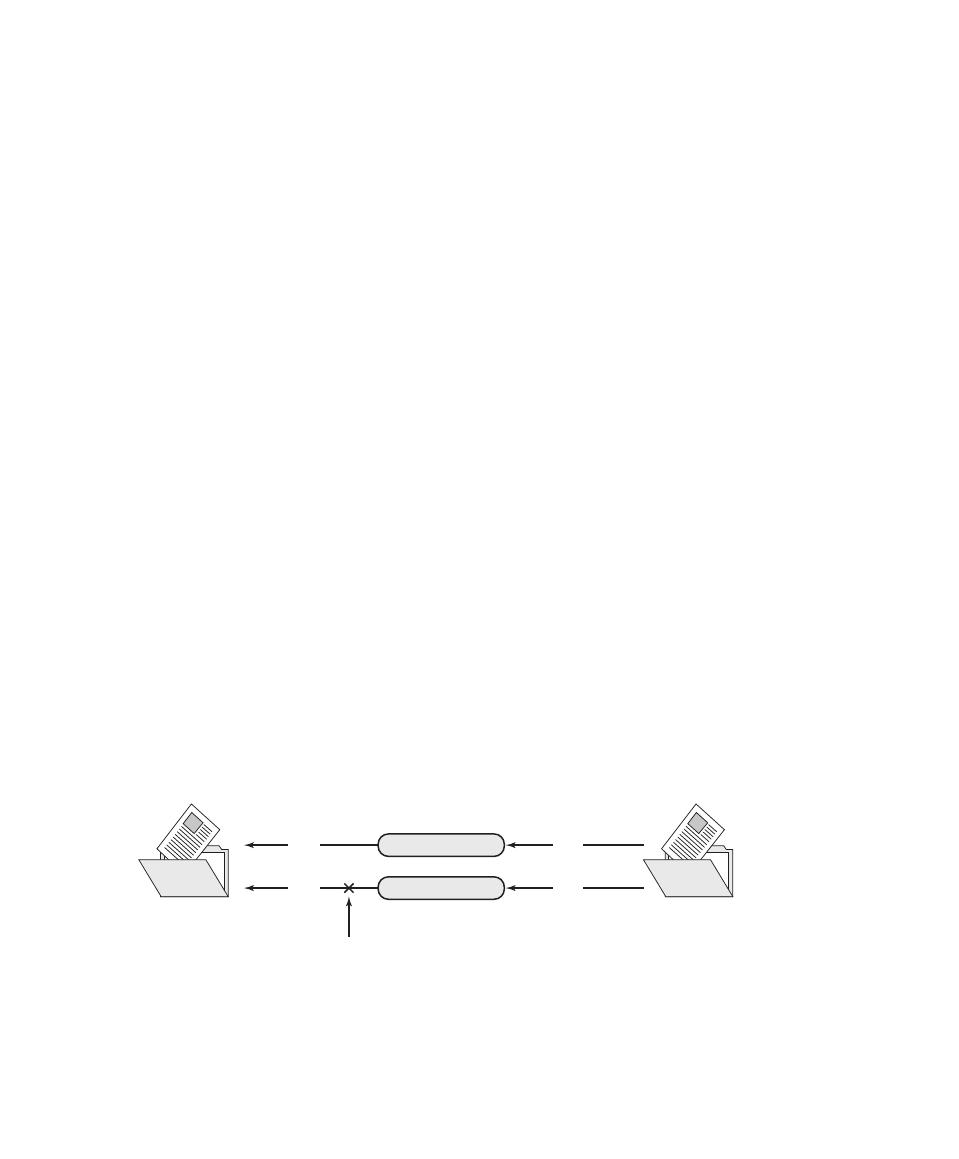

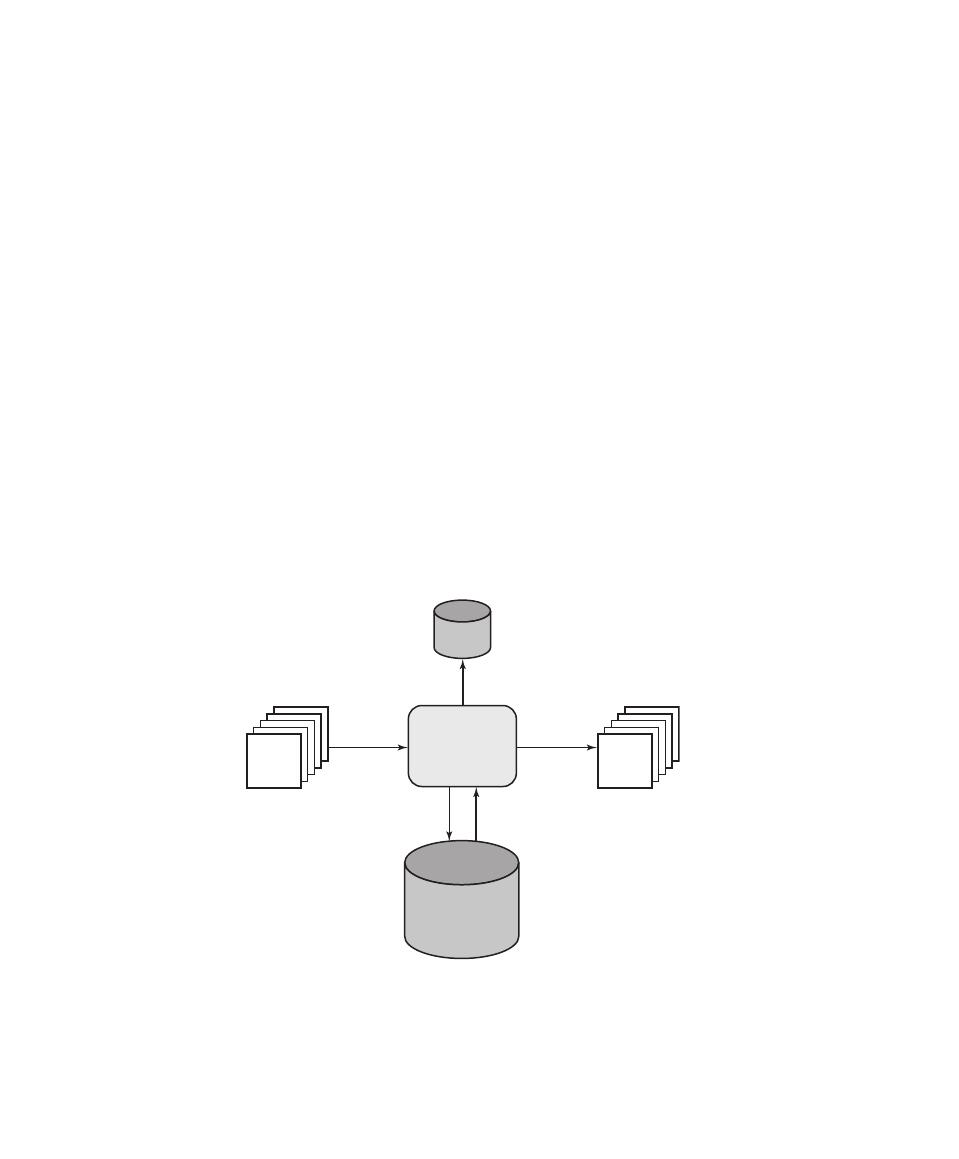

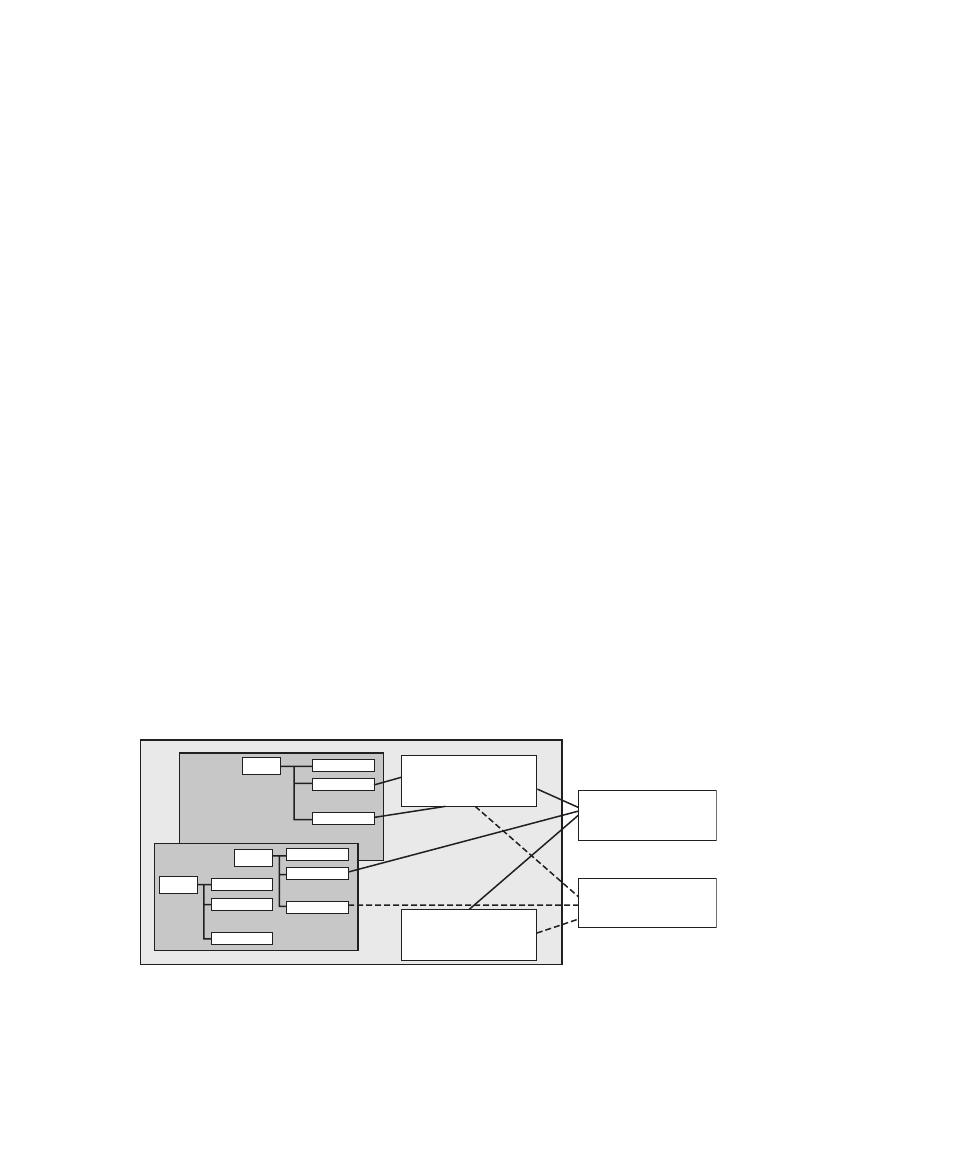

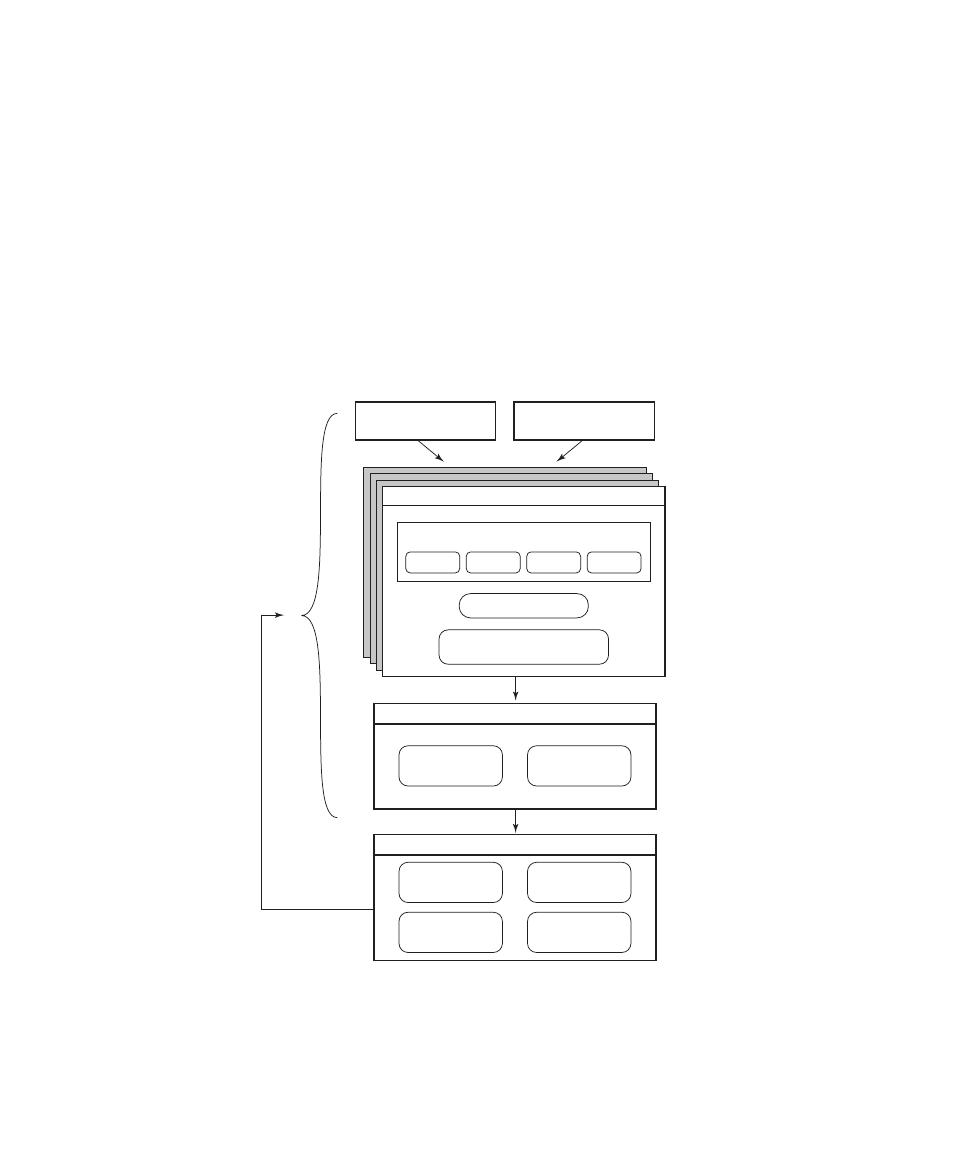

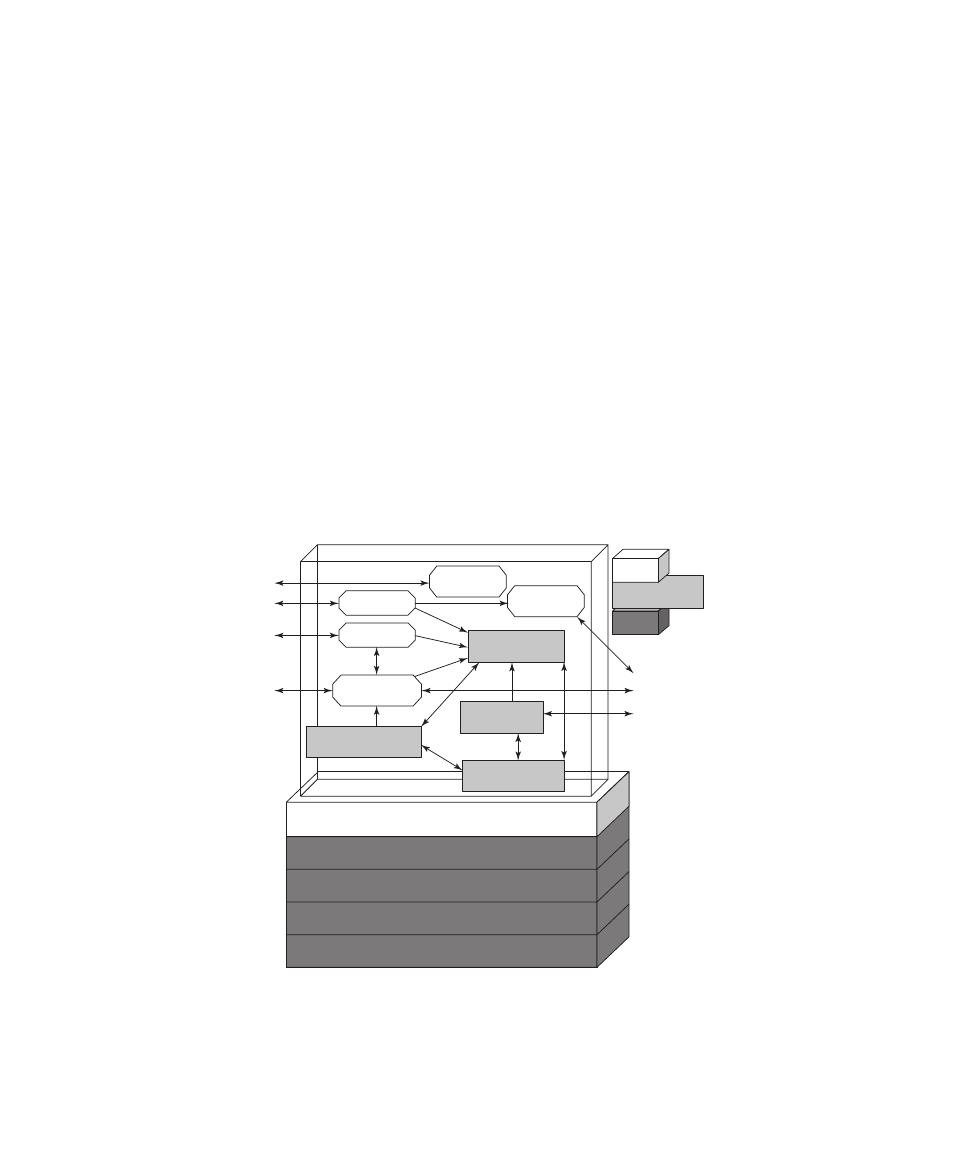

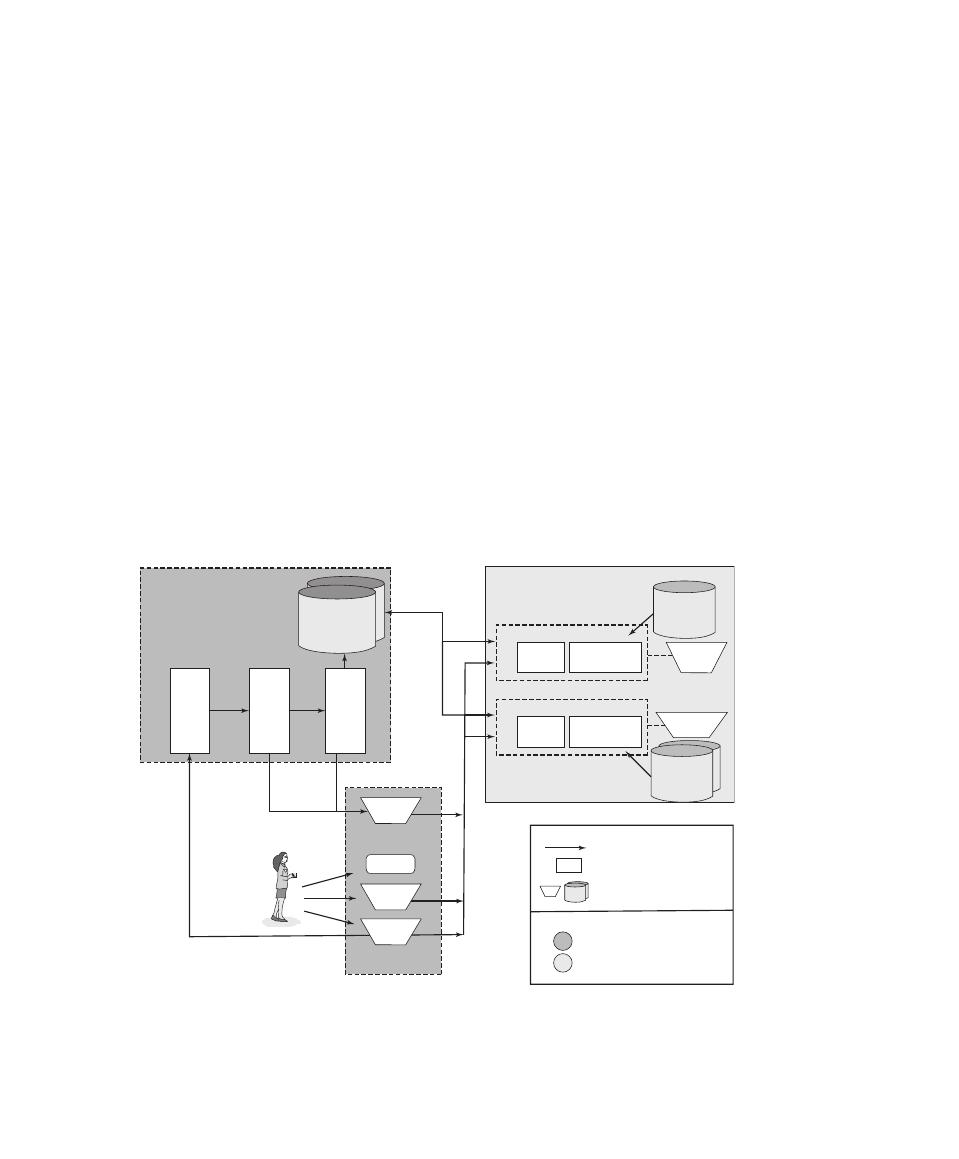

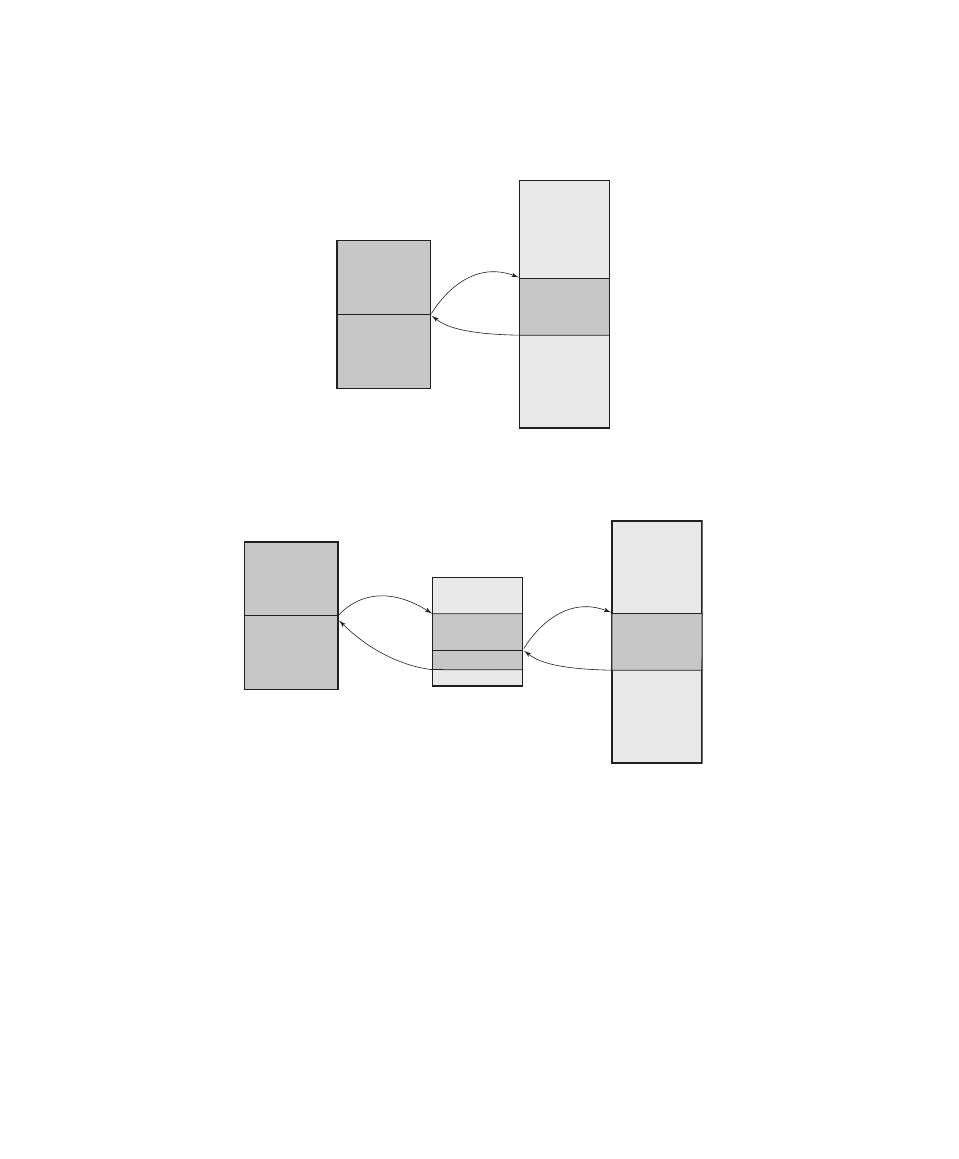

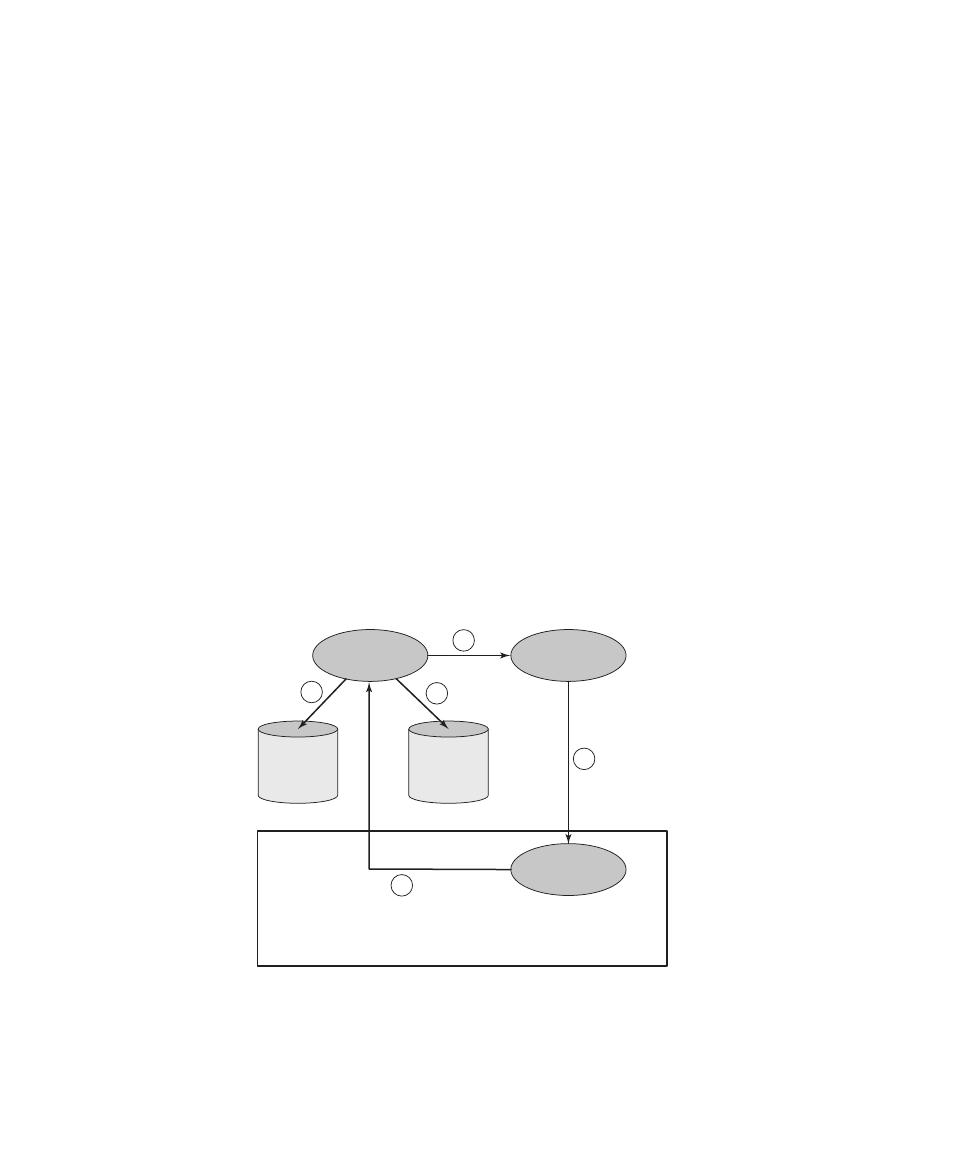

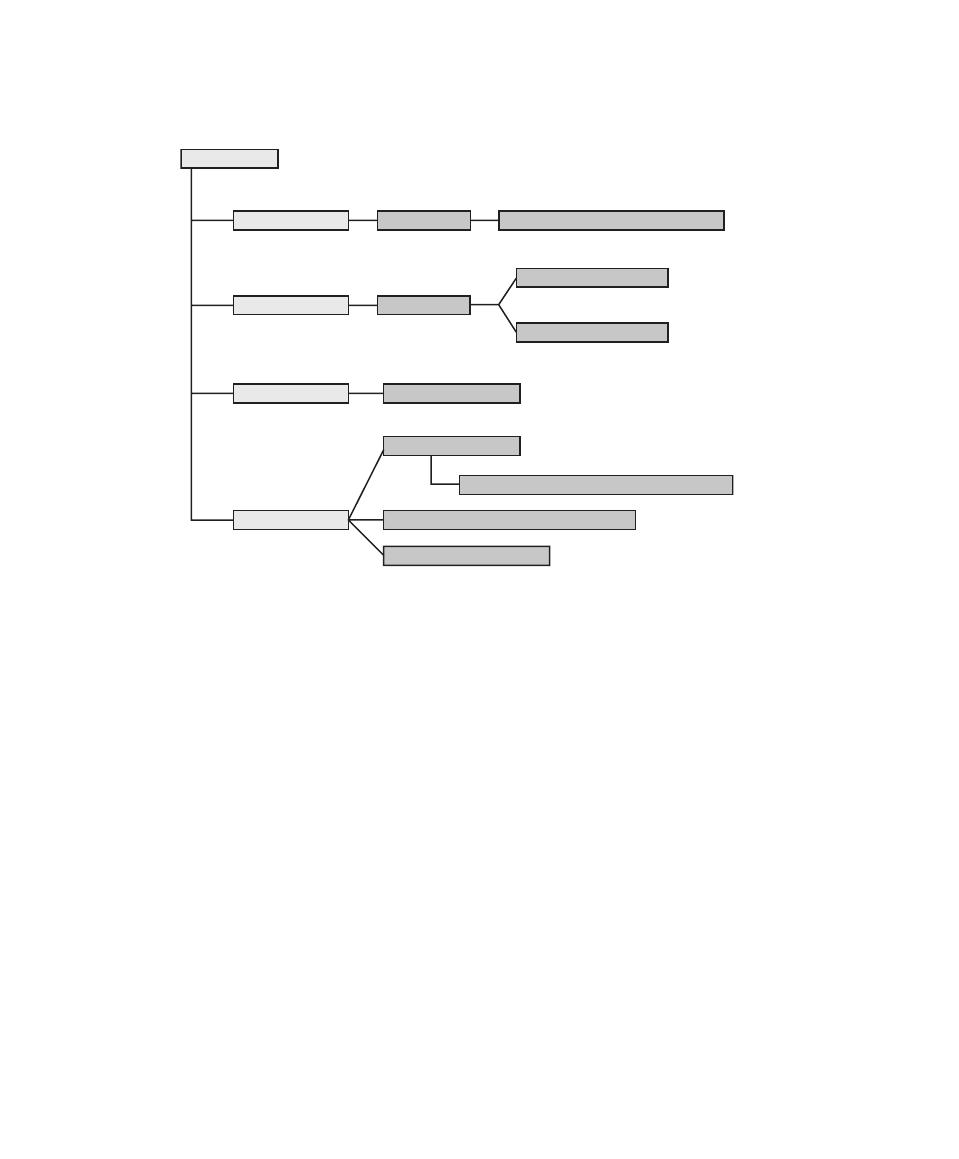

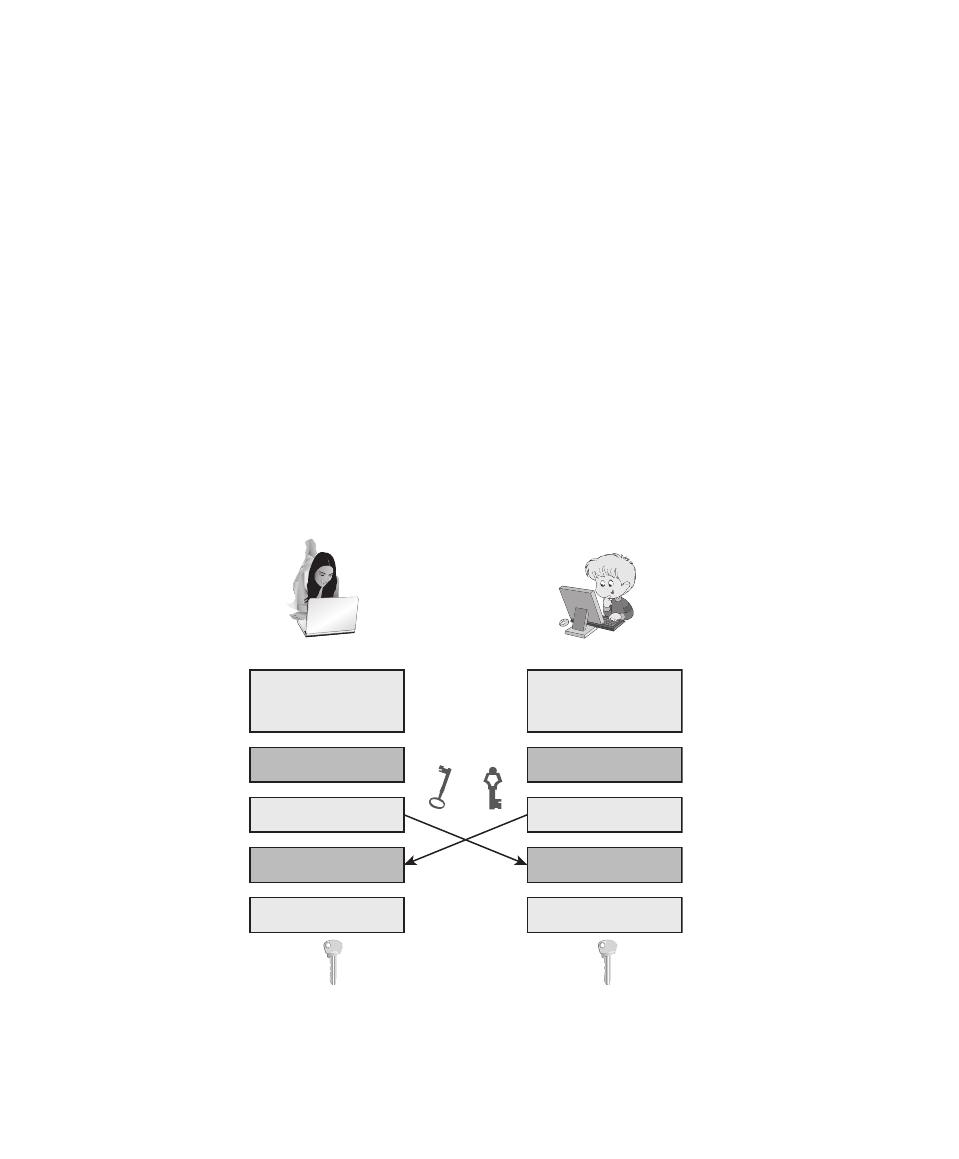

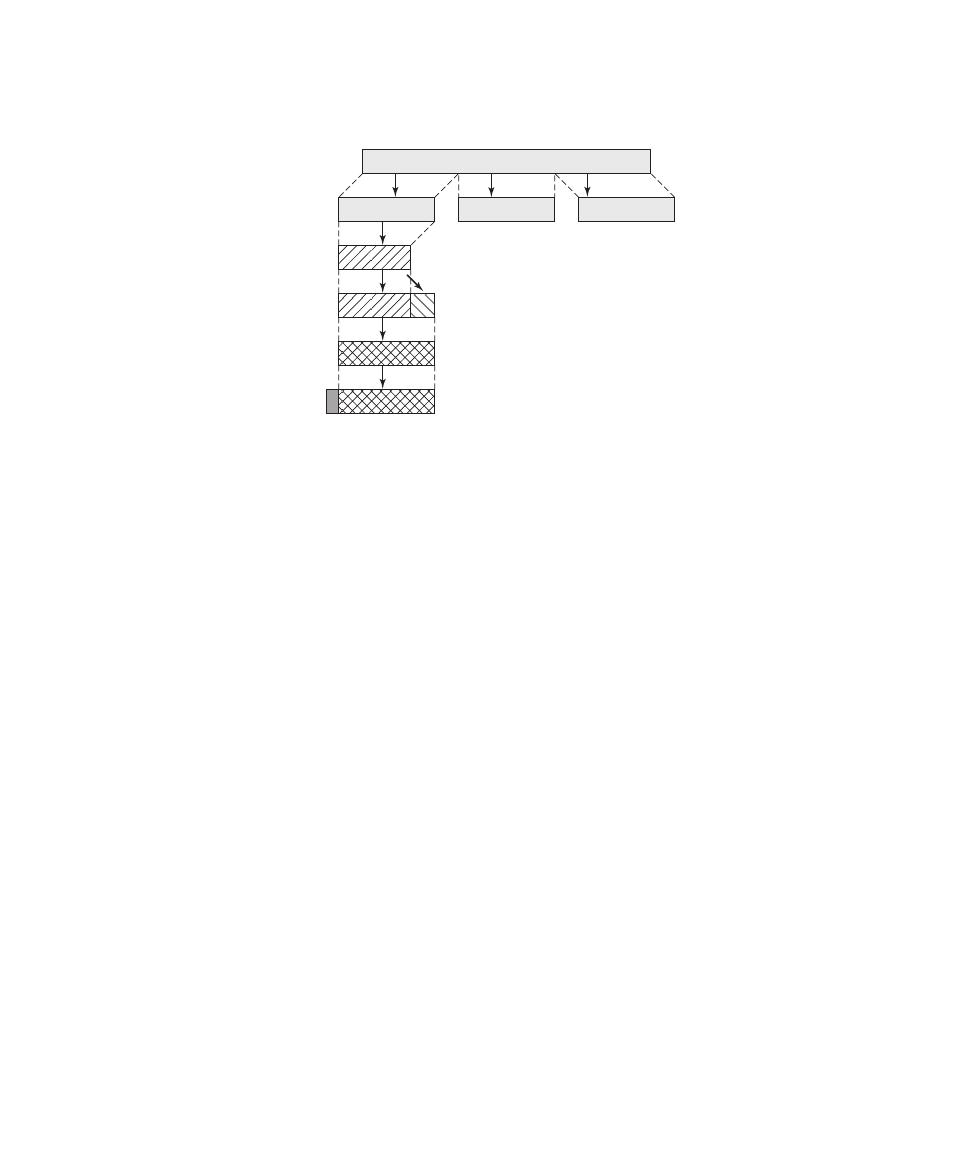

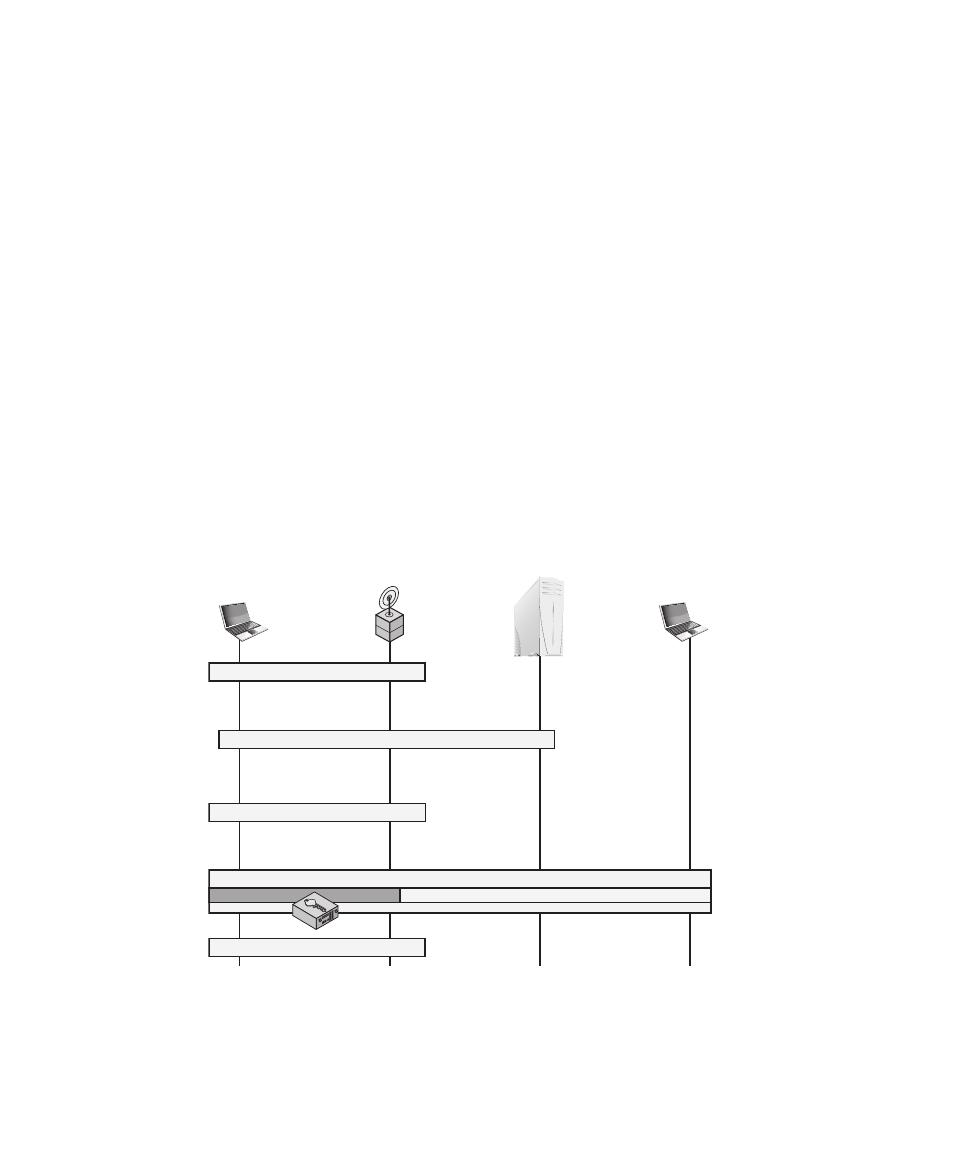

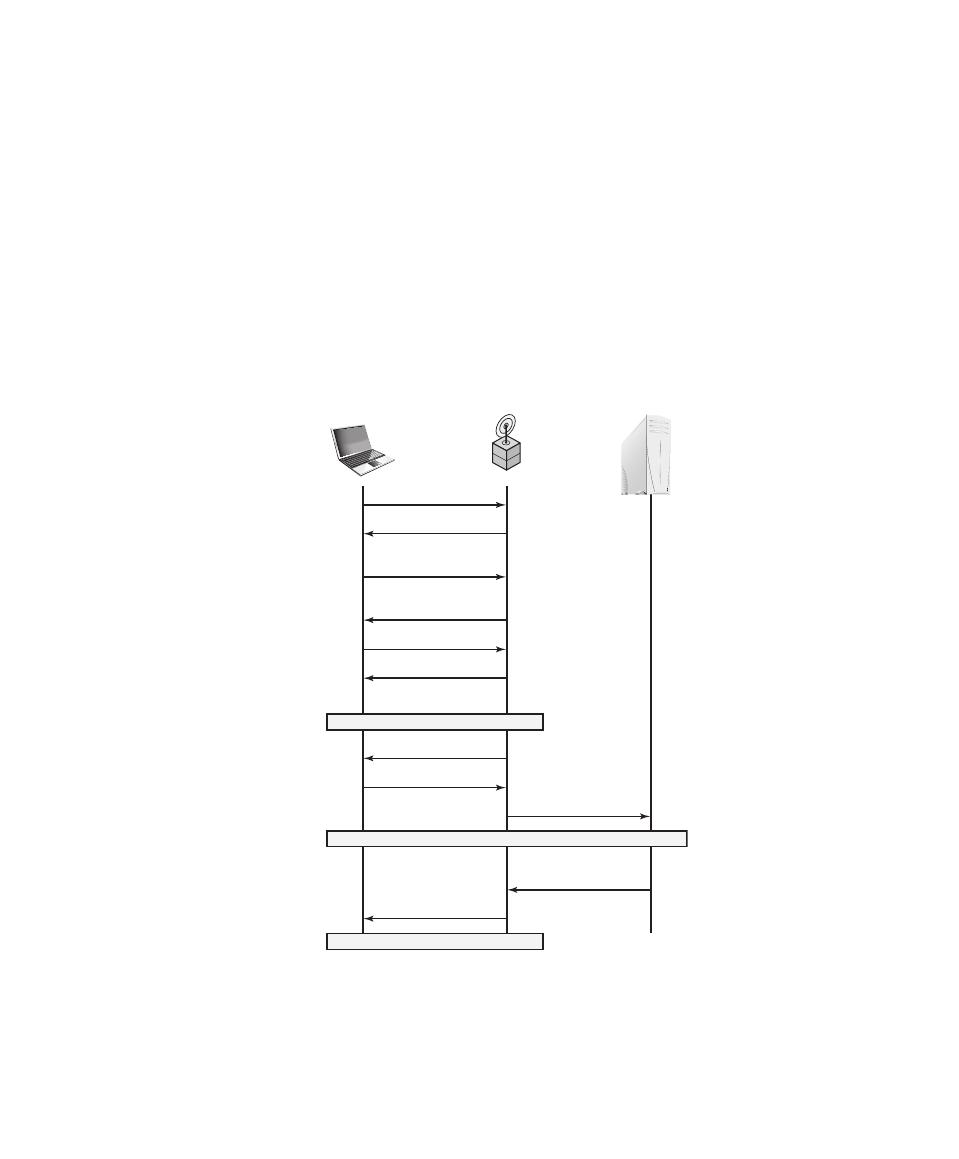

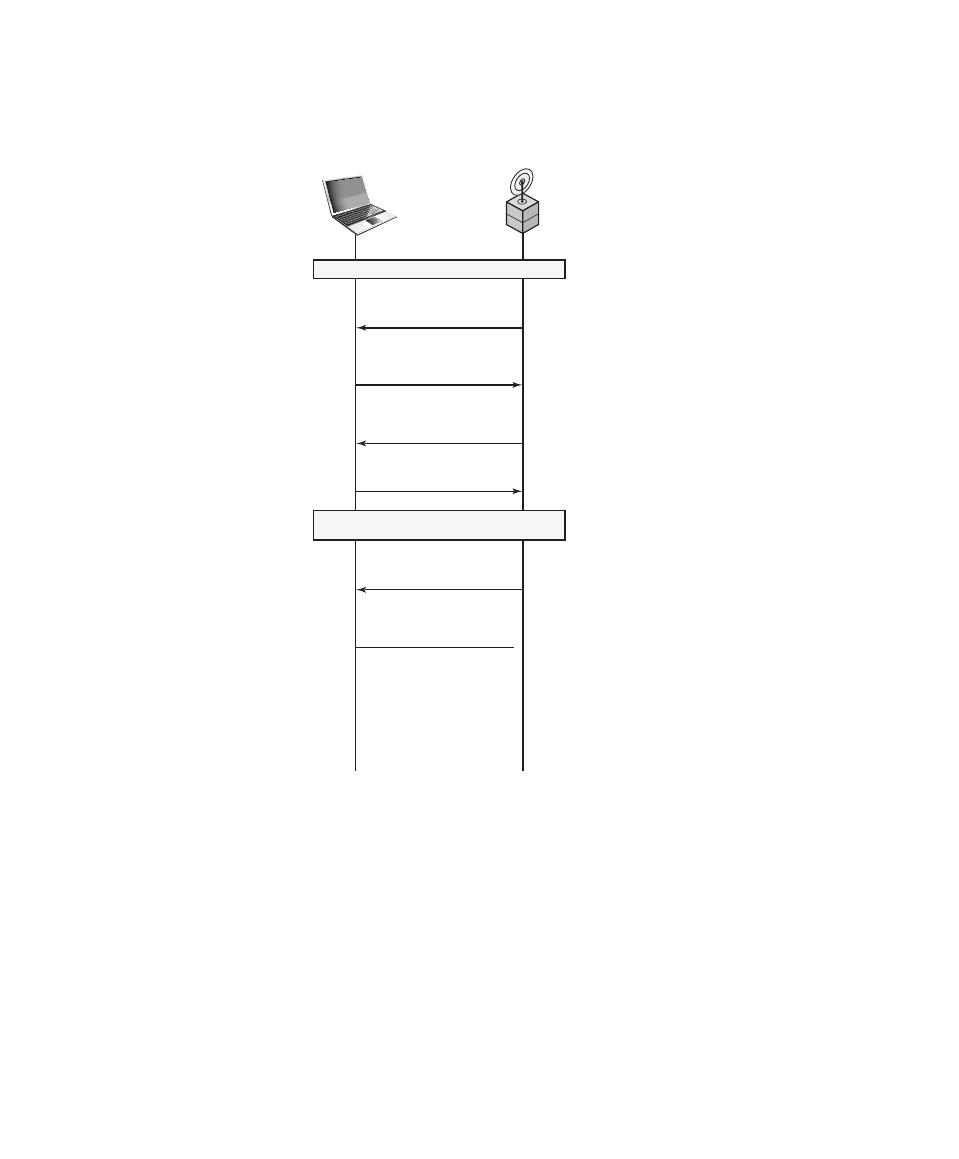

Table 1.1 defines terms and Figure 1.1,

based on [CCPS12a], shows the relationship among some of these terms. We start

3

See Chapter 0 for an explanation of RFCs.

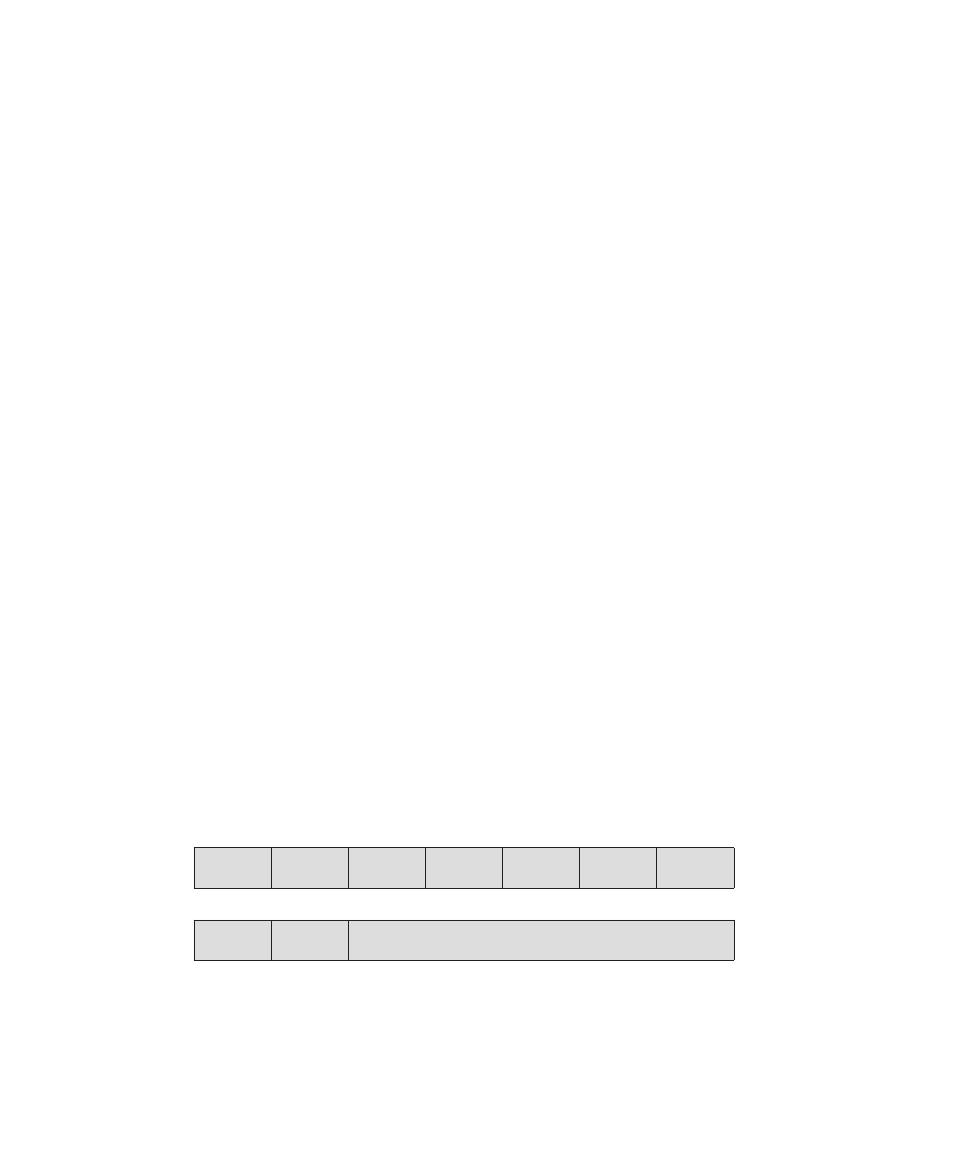

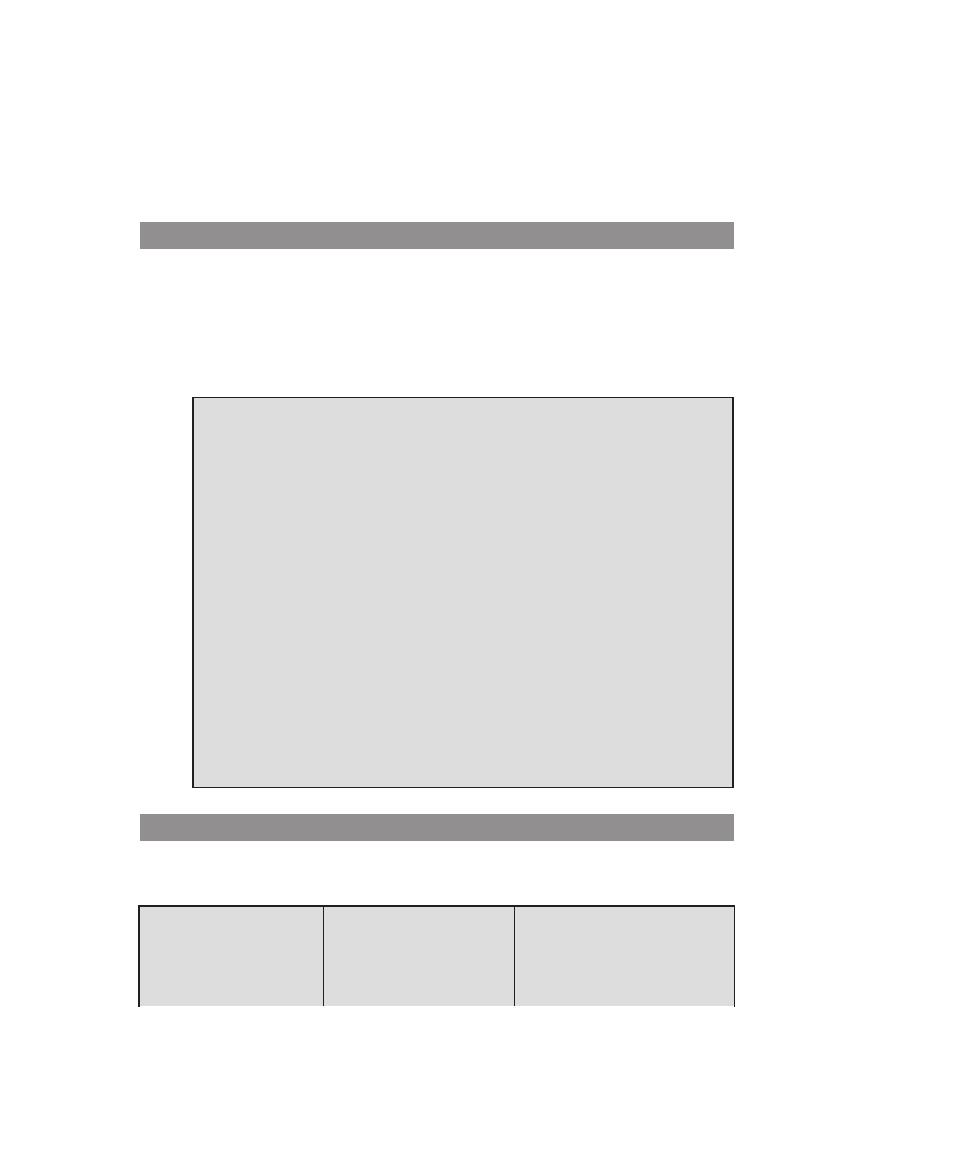

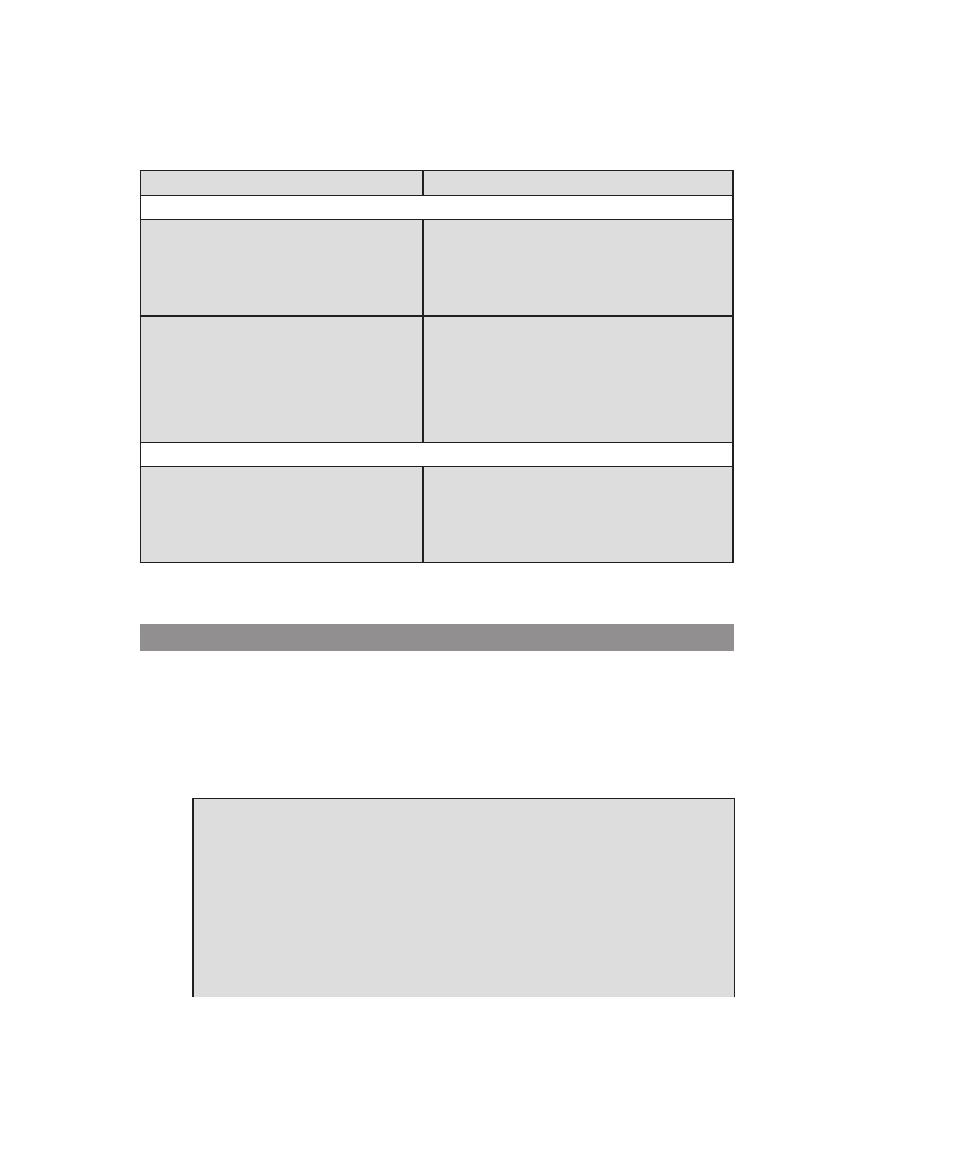

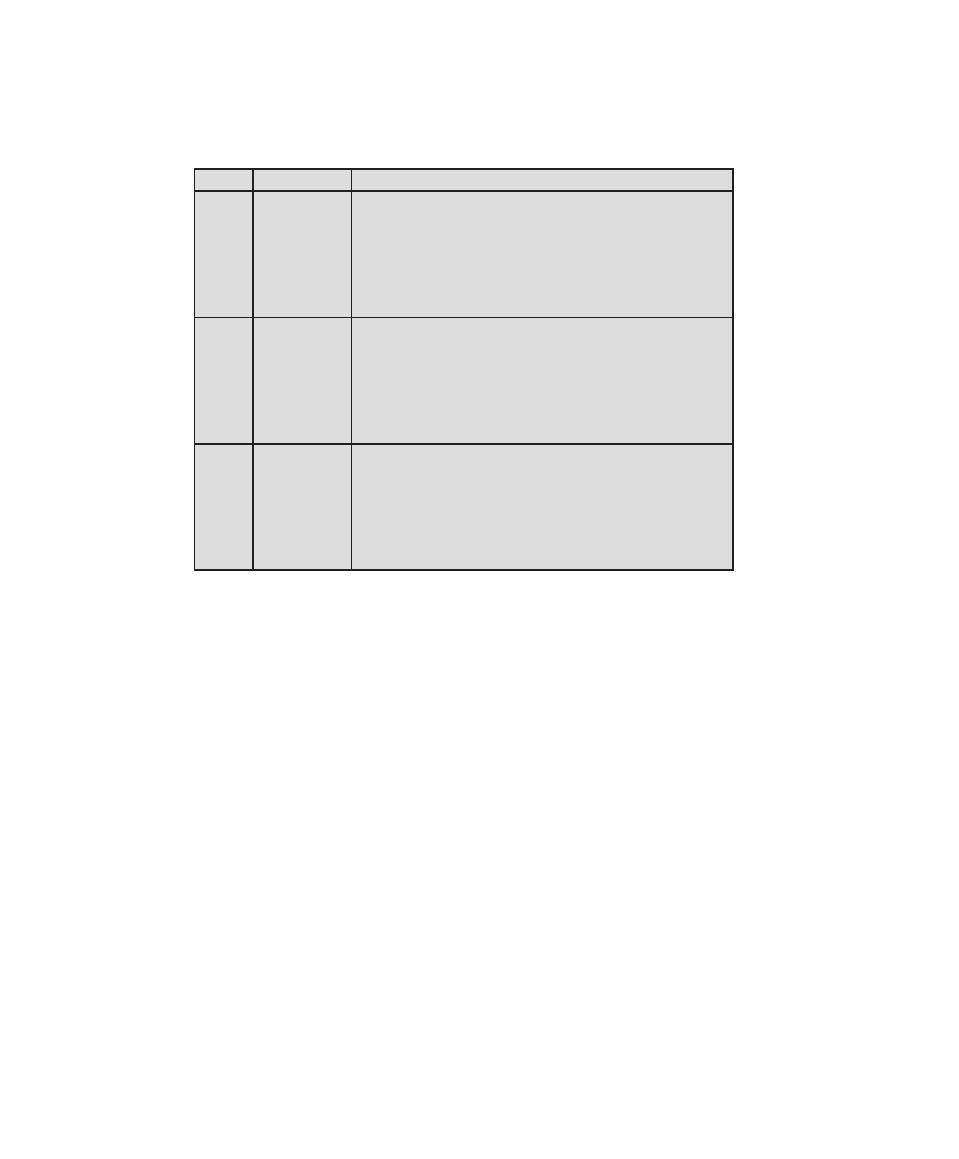

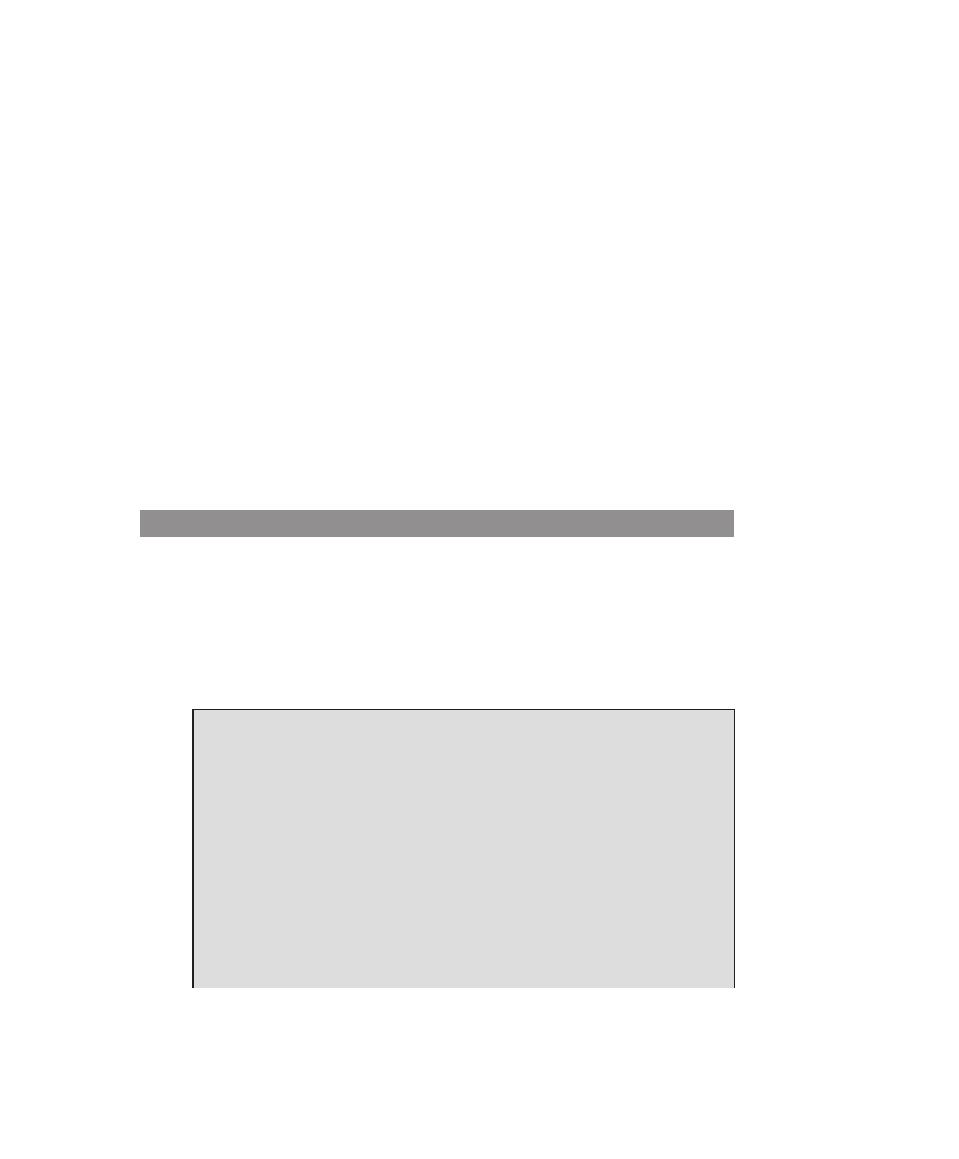

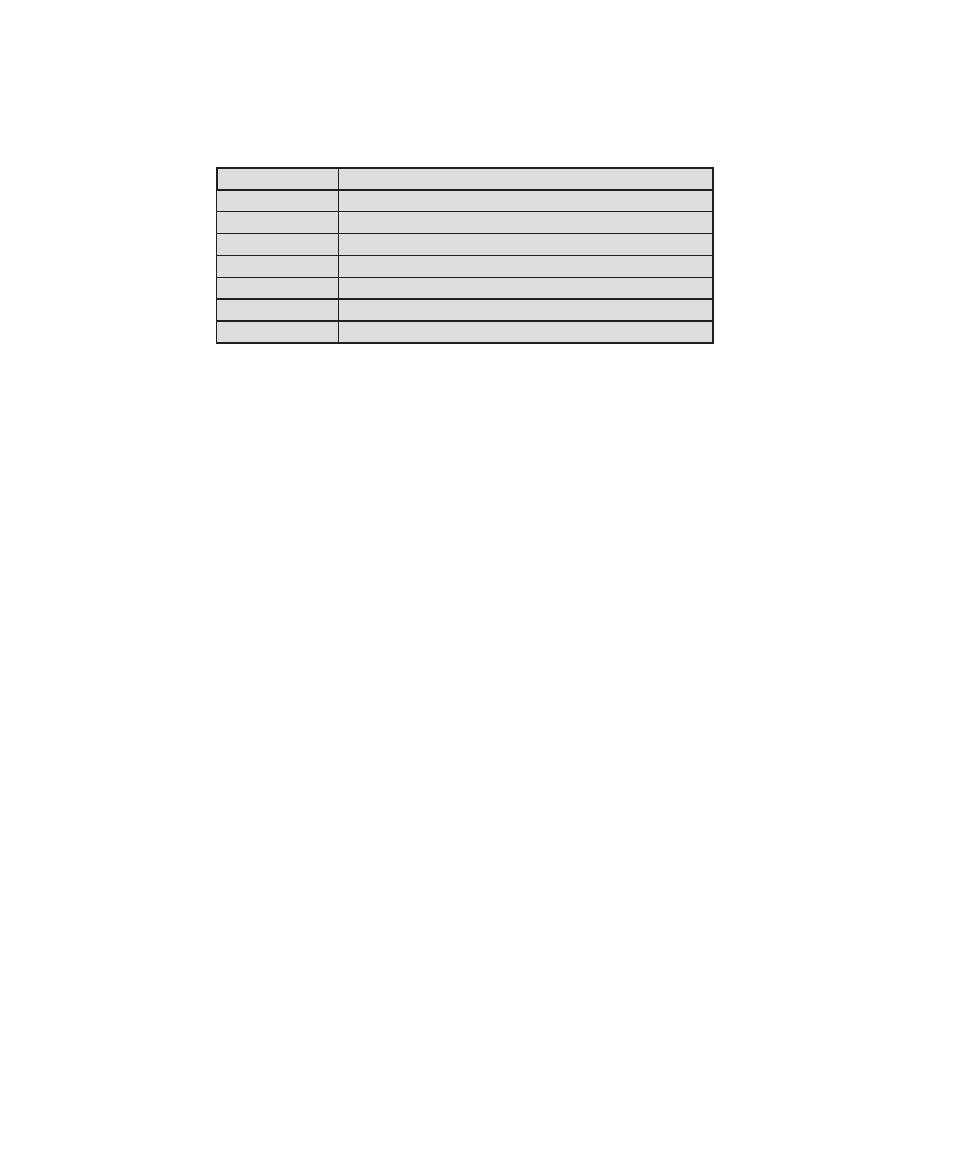

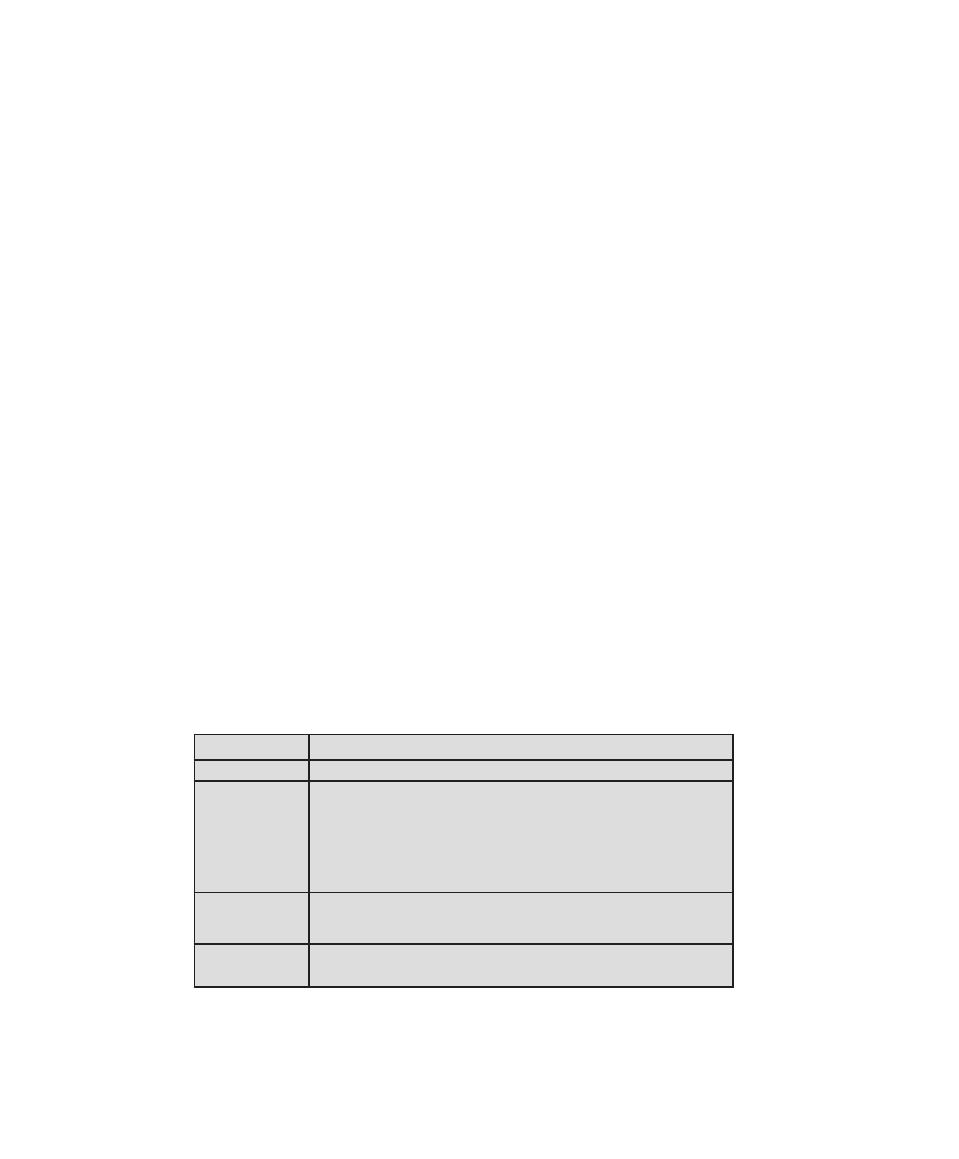

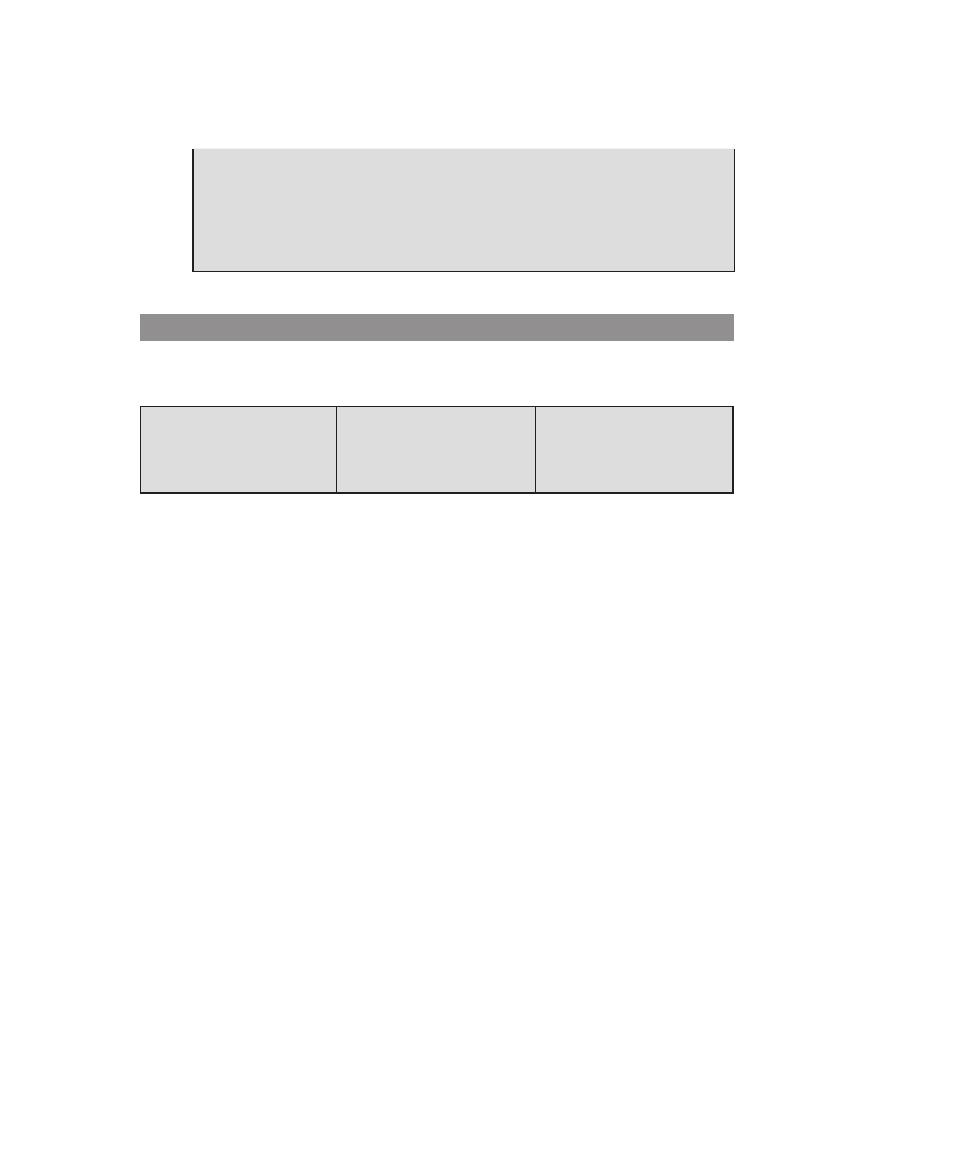

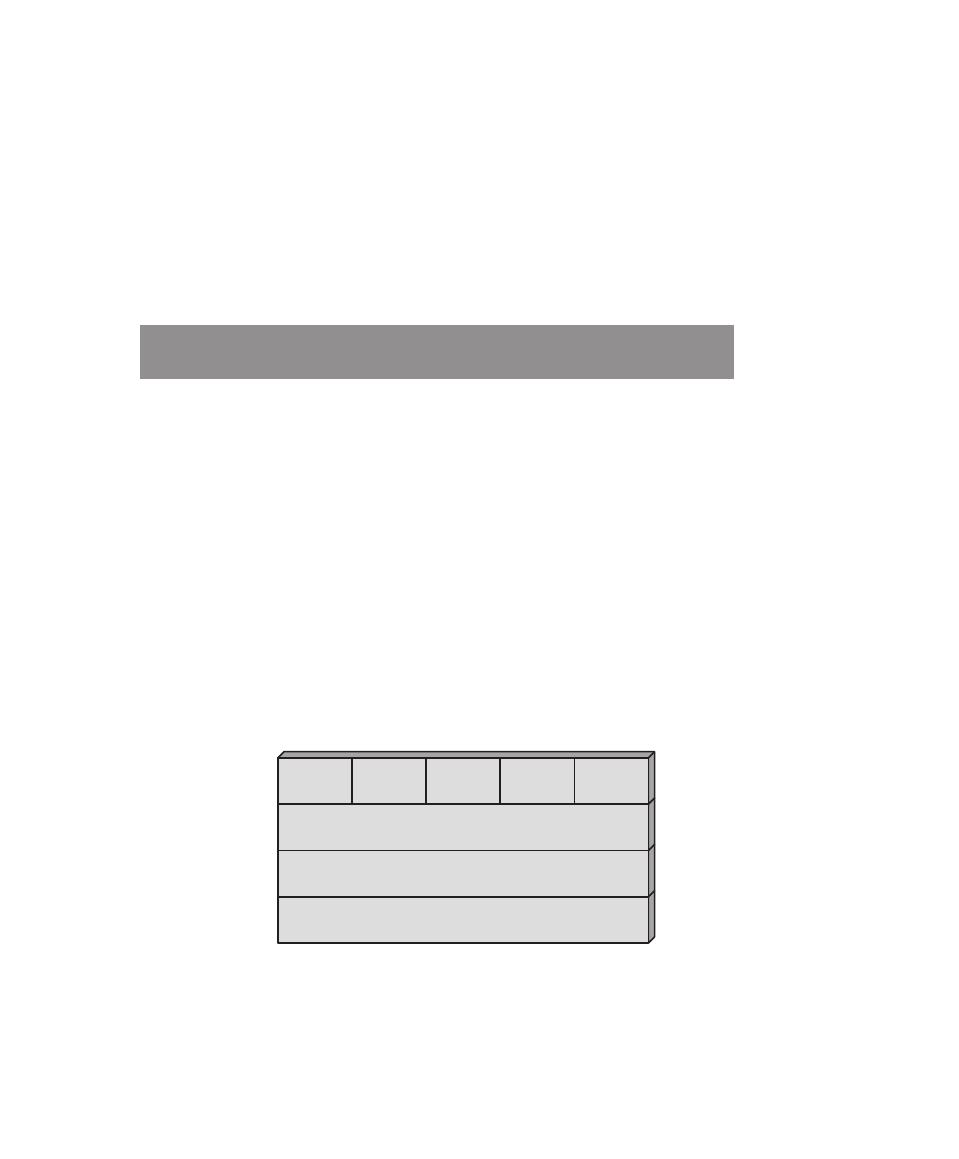

Table 1.1

Computer Security Terminology

Adversary (threat agent)

An entity that attacks, or is a threat to, a system.

Attack

An assault on system security that derives from an intelligent threat; that is, an intelligent act that is a

deliberate attempt (especially in the sense of a method or technique) to evade security services and violate

the security policy of a system.

Countermeasure

An action, device, procedure, or technique that reduces a threat, a vulnerability, or an attack by eliminating

or preventing it, by minimizing the harm it can cause, or by discovering and reporting it so that corrective

action can be taken.

Risk

An expectation of loss expressed as the probability that a particular threat will exploit a particular vulnerability

with a particular harmful result.

Security Policy

A set of rules and practices that specify or regulate how a system or organization provides security services to

protect sensitive and critical system resources.

System Resource (Asset)